1. ভূমিকা

এই কোডল্যাবে, আপনি একটি চ্যাট ওয়েব ইন্টারফেসের আকারে একটি অ্যাপ্লিকেশন তৈরি করবেন, যেখানে আপনি এটির সাথে যোগাযোগ করতে পারবেন, কিছু নথি বা ছবি আপলোড করতে পারবেন এবং আলোচনা করতে পারবেন। অ্যাপ্লিকেশনটি নিজেই 2টি পরিষেবাতে বিভক্ত: ফ্রন্টএন্ড এবং ব্যাকএন্ড; আপনাকে একটি দ্রুত প্রোটোটাইপ তৈরি করতে এবং এটি কেমন লাগে তা চেষ্টা করতে সক্ষম করে এবং এগুলি উভয়কে একীভূত করতে API চুক্তিটি কীভাবে দেখায় তাও বুঝতে পারে।

কোডল্যাবের মাধ্যমে, আপনি নিম্নলিখিত হিসাবে একটি ধাপে ধাপে পদ্ধতি ব্যবহার করবেন:

- আপনার Google ক্লাউড প্রকল্প প্রস্তুত করুন এবং এতে প্রয়োজনীয় সমস্ত API সক্ষম করুন৷

- ফ্রন্টএন্ড পরিষেবা তৈরি করুন - Gradio লাইব্রেরি ব্যবহার করে চ্যাট ইন্টারফেস

- ব্যাকএন্ড পরিষেবা তৈরি করুন - FastAPI ব্যবহার করে HTTP সার্ভার যা আগত ডেটাকে Gemini SDK স্ট্যান্ডার্ডে পুনরায় ফর্ম্যাট করবে এবং Gemini API-এর সাথে যোগাযোগ সক্ষম করবে

- ক্লাউড রানে অ্যাপ্লিকেশনটি স্থাপন করার জন্য প্রয়োজনীয় পরিবেশের ভেরিয়েবল এবং সেটআপ প্রয়োজনীয় ফাইলগুলি পরিচালনা করুন৷

- ক্লাউড রানে অ্যাপ্লিকেশনটি স্থাপন করুন

আর্কিটেকচার ওভারভিউ

পূর্বশর্ত

- Gemini API এবং Google Gen AI SDK-এর সাথে কাজ করা আরামদায়ক

- HTTP পরিষেবা ব্যবহার করে মৌলিক ফুল-স্ট্যাক আর্কিটেকচারের একটি বোঝাপড়া

আপনি কি শিখবেন

- কিভাবে টেক্সট এবং অন্যান্য ডেটা টাইপ (মাল্টিমোডাল) জমা দিতে এবং টেক্সট রেসপন্স জেনারেট করতে Gemini SDK ব্যবহার করবেন

- কথোপকথনের প্রেক্ষাপট বজায় রাখতে জেমিনি SDK-তে চ্যাট ইতিহাস কীভাবে গঠন করবেন

- Gradio সহ ফ্রন্টএন্ড ওয়েব প্রোটোটাইপিং

- FastAPI এবং Pydantic এর সাথে ব্যাকএন্ড সার্ভিস ডেভেলপমেন্ট

- Pydantic-সেটিংস সহ YAML ফাইলে পরিবেশ ভেরিয়েবল পরিচালনা করুন

- ডকারফাইল ব্যবহার করে ক্লাউড রানে অ্যাপ্লিকেশন স্থাপন করুন এবং YAML ফাইলের সাথে পরিবেশের ভেরিয়েবল সরবরাহ করুন

আপনি কি প্রয়োজন হবে

- ক্রোম ওয়েব ব্রাউজার

- একটি জিমেইল অ্যাকাউন্ট

- বিলিং সক্ষম সহ একটি ক্লাউড প্রকল্প৷

এই কোডল্যাব, সমস্ত স্তরের বিকাশকারীদের জন্য ডিজাইন করা হয়েছে (শিশুদের সহ), এর নমুনা অ্যাপ্লিকেশনে পাইথন ব্যবহার করে। যাইহোক, উপস্থাপিত ধারণাগুলি বোঝার জন্য পাইথন জ্ঞানের প্রয়োজন নেই।

2. আপনি শুরু করার আগে

ক্লাউড শেল এডিটরে ক্লাউড প্রজেক্ট সেটআপ করুন

এই কোডল্যাব ধরে নেয় যে আপনার কাছে ইতিমধ্যেই বিলিং সক্ষম সহ একটি Google ক্লাউড প্রকল্প রয়েছে৷ যদি আপনার কাছে এখনও এটি না থাকে তবে আপনি শুরু করতে নীচের নির্দেশাবলী অনুসরণ করতে পারেন।

- 2Google ক্লাউড কনসোলে , প্রকল্প নির্বাচক পৃষ্ঠায়, একটি Google ক্লাউড প্রকল্প নির্বাচন করুন বা তৈরি করুন৷

- নিশ্চিত করুন যে আপনার ক্লাউড প্রকল্পের জন্য বিলিং সক্ষম করা আছে৷ একটি প্রকল্পে বিলিং সক্ষম কিনা তা পরীক্ষা করতে শিখুন।

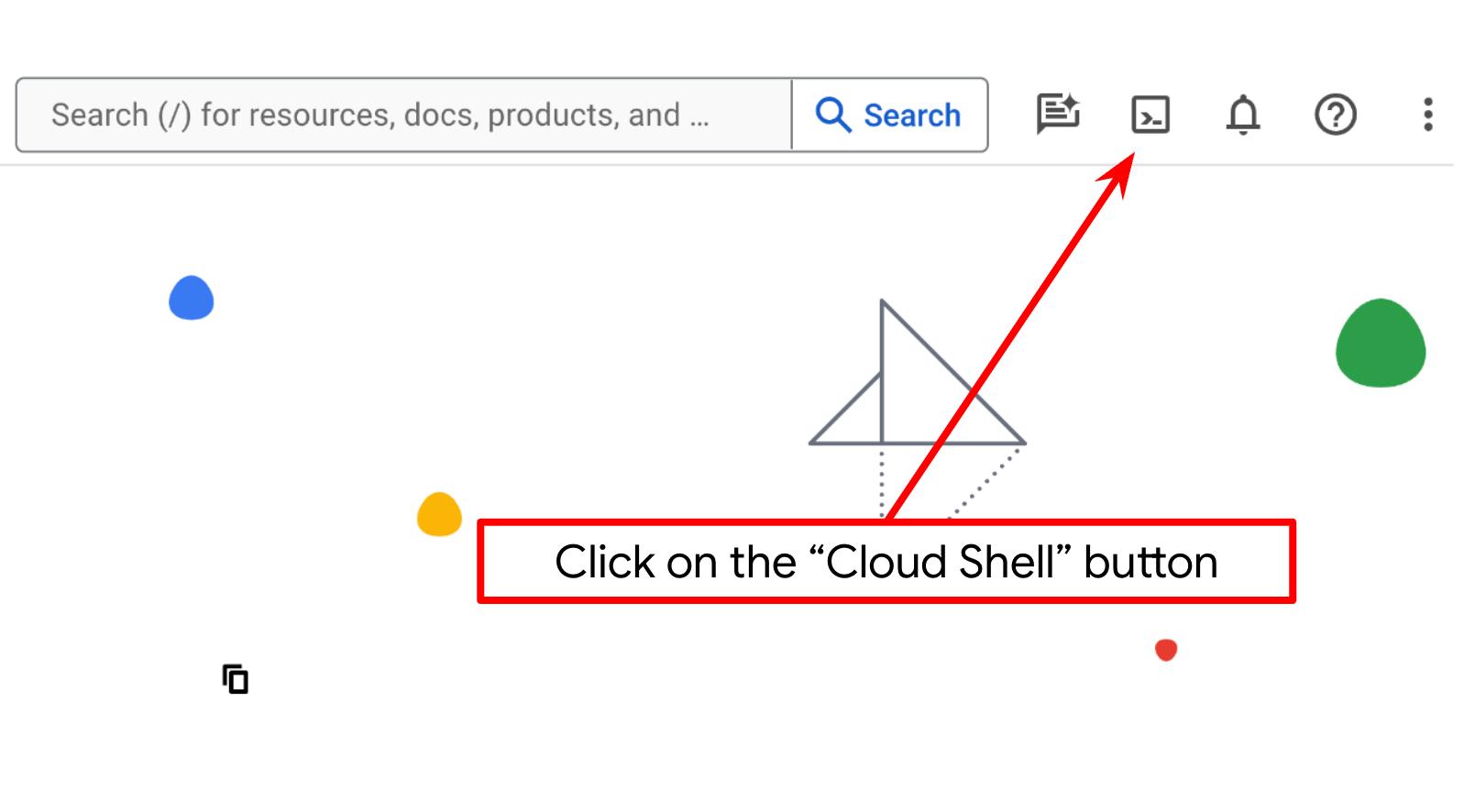

- আপনি ক্লাউড শেল ব্যবহার করবেন, Google ক্লাউডে চলমান একটি কমান্ড-লাইন পরিবেশ যা bq এর সাথে প্রিলোড করা হয়। গুগল ক্লাউড কনসোলের শীর্ষে সক্রিয় ক্লাউড শেল ক্লিক করুন।

- একবার ক্লাউড শেলের সাথে সংযুক্ত হয়ে গেলে, আপনি পরীক্ষা করে দেখুন যে আপনি ইতিমধ্যেই প্রমাণীকৃত হয়েছেন এবং নিম্নলিখিত কমান্ডটি ব্যবহার করে প্রকল্পটি আপনার প্রকল্প আইডিতে সেট করা আছে:

gcloud auth list

- gcloud কমান্ড আপনার প্রকল্প সম্পর্কে জানে তা নিশ্চিত করতে ক্লাউড শেলে নিম্নলিখিত কমান্ডটি চালান।

gcloud config list project

- যদি আপনার প্রজেক্ট সেট করা না থাকে, তাহলে এটি সেট করতে নিম্নলিখিত কমান্ডটি ব্যবহার করুন:

gcloud config set project <YOUR_PROJECT_ID>

বিকল্পভাবে, আপনি কনসোলে PROJECT_ID আইডিও দেখতে পারেন

এটিতে ক্লিক করুন এবং আপনি আপনার সমস্ত প্রকল্প এবং প্রকল্প আইডি ডানদিকে পাবেন

- নীচে দেখানো কমান্ডের মাধ্যমে প্রয়োজনীয় API গুলি সক্ষম করুন৷ এটি কয়েক মিনিট সময় নিতে পারে, তাই ধৈর্য ধরুন।

gcloud services enable aiplatform.googleapis.com \

run.googleapis.com \

cloudbuild.googleapis.com \

cloudresourcemanager.googleapis.com

কমান্ডের সফল সঞ্চালন হলে, আপনি নীচের দেখানো একটি অনুরূপ একটি বার্তা দেখতে হবে:

Operation "operations/..." finished successfully.

gcloud কমান্ডের বিকল্প হল কনসোলের মাধ্যমে প্রতিটি পণ্য অনুসন্ধান করে বা এই লিঙ্কটি ব্যবহার করে।

যদি কোনো API মিস হয়, আপনি সর্বদা বাস্তবায়নের সময় এটি সক্রিয় করতে পারেন।

জিক্লাউড কমান্ড এবং ব্যবহারের জন্য ডকুমেন্টেশন পড়ুন।

সেটআপ অ্যাপ্লিকেশন ওয়ার্কিং ডিরেক্টরি

- Open Editor বাটনে ক্লিক করুন, এটি একটি Cloud Shell Editor খুলবে, আমরা এখানে আমাদের কোড লিখতে পারি

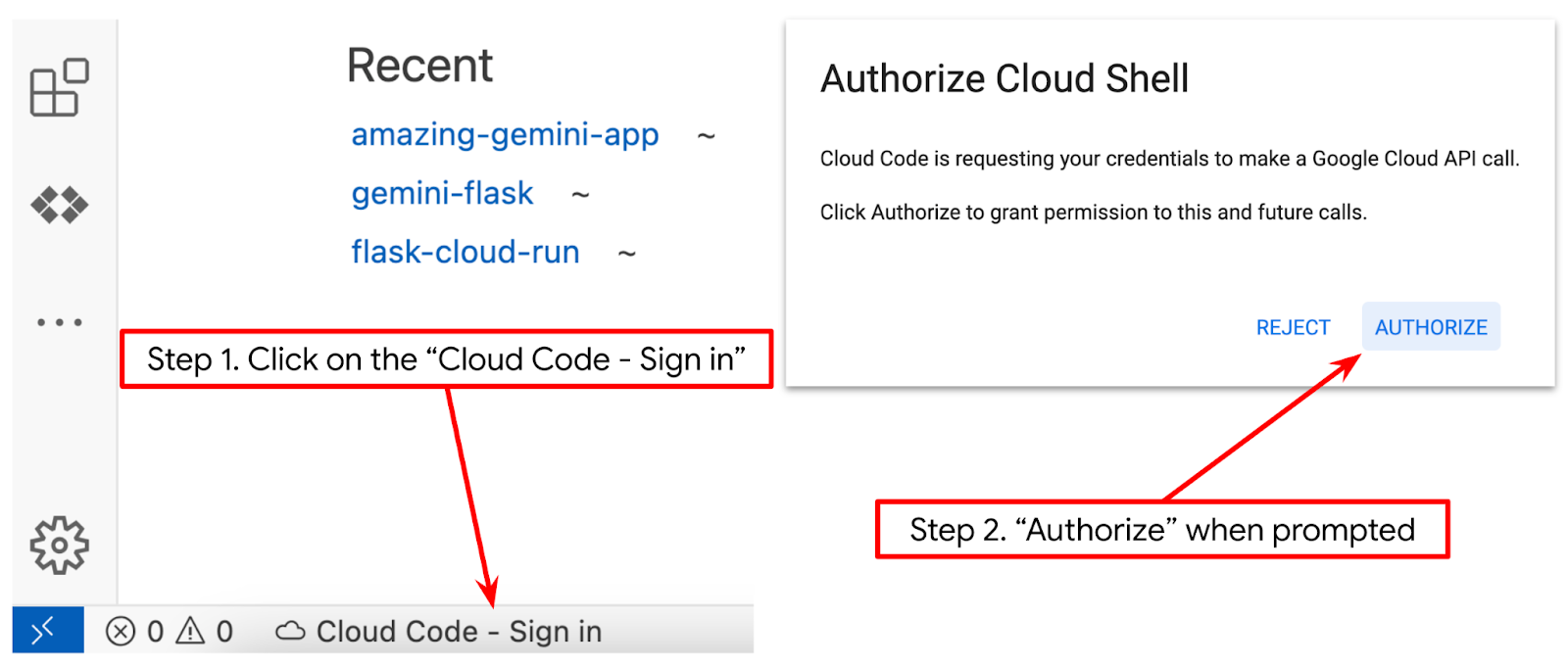

- নিশ্চিত করুন যে ক্লাউড কোড প্রকল্পটি ক্লাউড শেল সম্পাদকের নীচের বাম কোণে (স্ট্যাটাস বার) সেট করা আছে, যেমনটি নীচের ছবিতে হাইলাইট করা হয়েছে এবং সক্রিয় Google ক্লাউড প্রকল্পে সেট করা আছে যেখানে আপনি বিলিং সক্ষম করেছেন৷ অনুরোধ করা হলে অনুমোদন করুন । ক্লাউড শেল এডিটর শুরু করার পরে কিছু সময় লাগতে পারে যাতে ক্লাউড কোড - সাইন ইন বোতামটি প্রদর্শিত হবে, অনুগ্রহ করে ধৈর্য ধরুন। আপনি যদি পূর্ববর্তী কমান্ড অনুসরণ করেন, তাহলে সাইন ইন বোতামের পরিবর্তে বোতামটি সরাসরি আপনার সক্রিয় প্রকল্পের দিকে নির্দেশ করতে পারে

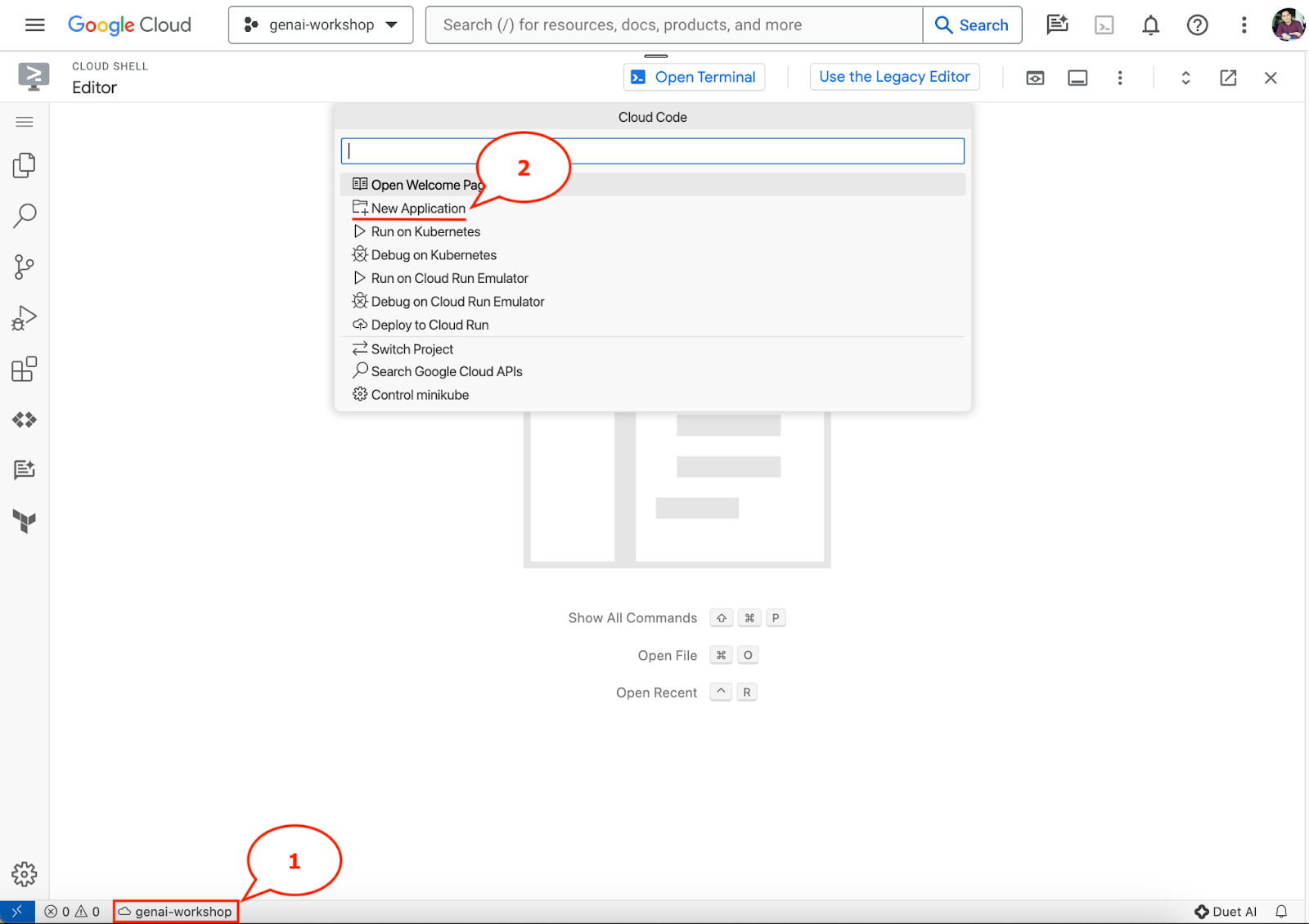

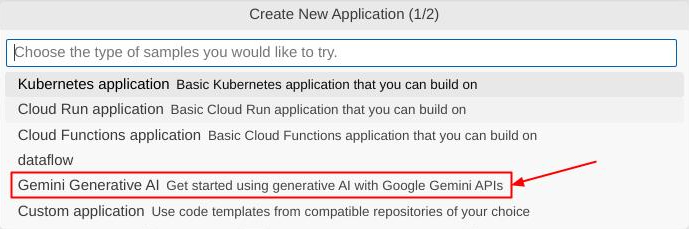

- স্ট্যাটাস বারে সেই সক্রিয় প্রকল্পটিতে ক্লিক করুন এবং ক্লাউড কোড পপ আপ খোলার জন্য অপেক্ষা করুন। পপ আপে "নতুন অ্যাপ্লিকেশন" নির্বাচন করুন।

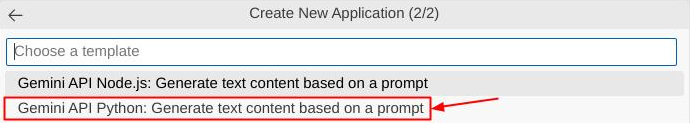

- অ্যাপ্লিকেশনের তালিকা থেকে, জেমিনি জেনারেটিভ এআই বেছে নিন, তারপর জেমিনি API পাইথন বেছে নিন

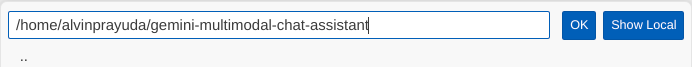

- আপনার পছন্দের নাম দিয়ে নতুন অ্যাপ্লিকেশনটি সংরক্ষণ করুন, এই উদাহরণে আমরা জেমিনি-মাল্টিমোডাল-চ্যাট-সহকারী ব্যবহার করব, তারপর ওকে ক্লিক করুন

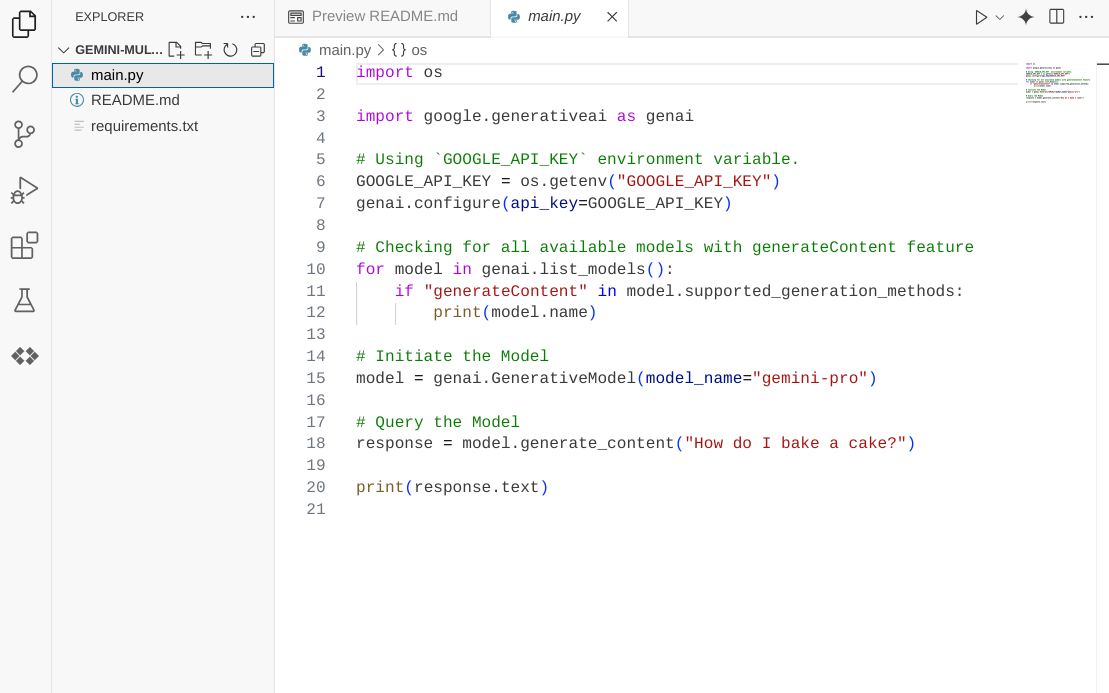

এই মুহুর্তে, আপনার ইতিমধ্যেই নতুন অ্যাপ্লিকেশন ওয়ার্কিং ডিরেক্টরির ভিতরে থাকা উচিত এবং নিম্নলিখিত ফাইলগুলি দেখতে হবে

এর পরে, আমরা আমাদের পাইথন পরিবেশ প্রস্তুত করব

এনভায়রনমেন্ট সেটআপ

পাইথন ভার্চুয়াল এনভায়রনমেন্ট প্রস্তুত করুন

পরবর্তী ধাপ হচ্ছে উন্নয়ন পরিবেশ প্রস্তুত করা। আমরা এই কোডল্যাবে পাইথন 3.12 ব্যবহার করব এবং পাইথন সংস্করণ এবং ভার্চুয়াল পরিবেশ তৈরি এবং পরিচালনার প্রয়োজনীয়তা সহজ করতে আমরা ইউভি পাইথন প্রকল্প ব্যবস্থাপক ব্যবহার করব

- আপনি যদি এখনও টার্মিনালটি না খুলে থাকেন তবে টার্মিনাল -> নতুন টার্মিনাল এ ক্লিক করে এটি খুলুন বা Ctrl + Shift + C ব্যবহার করুন

-

uvডাউনলোড করুন এবং নিম্নলিখিত কমান্ড দিয়ে পাইথন 3.12 ইনস্টল করুন

curl -LsSf https://astral.sh/uv/0.6.6/install.sh | sh && \

source $HOME/.local/bin/env && \

uv python install 3.12

- এখন

uvব্যবহার করে পাইথন প্রজেক্ট শুরু করা যাক

uv init

- আপনি ডিরেক্টরিতে তৈরি main.py, .python-version, এবং pyproject.toml দেখতে পাবেন। এই ফাইলগুলি ডিরেক্টরিতে প্রকল্প বজায় রাখার জন্য প্রয়োজন। পাইথন নির্ভরতা এবং কনফিগারেশনগুলি pyproject.toml- এ নির্দিষ্ট করা যেতে পারে এবং .python-সংস্করণ এই প্রজেক্টের জন্য ব্যবহৃত পাইথন সংস্করণটিকে প্রমিত করে। এই সম্পর্কে আরও পড়তে আপনি এই ডকুমেন্টেশন দেখতে পারেন

main.py .python-version pyproject.toml

- এটি পরীক্ষা করতে, নিম্নলিখিত কোডে main.py ওভাররাইট করুন

def main():

print("Hello from gemini-multimodal-chat-assistant!")

if __name__ == "__main__":

main()

- তারপরে, নিম্নলিখিত কমান্ডটি চালান

uv run main.py

আপনি নিচের মত আউটপুট পাবেন

Using CPython 3.12 Creating virtual environment at: .venv Hello from gemini-multimodal-chat-assistant!

এটি দেখায় যে পাইথন প্রকল্পটি সঠিকভাবে সেট আপ করা হচ্ছে। আমাদের ম্যানুয়ালি একটি ভার্চুয়াল পরিবেশ তৈরি করতে হবে না কারণ uv ইতিমধ্যে এটি পরিচালনা করে। সুতরাং এই পয়েন্ট থেকে, স্ট্যান্ডার্ড পাইথন কমান্ড (যেমন python main.py ) ইউভি রান (যেমন uv run main.py ) দিয়ে প্রতিস্থাপিত হবে।

প্রয়োজনীয় নির্ভরতা ইনস্টল করুন

আমরা uv কমান্ড ব্যবহার করে এই কোডল্যাব প্যাকেজ নির্ভরতা যোগ করব। নিম্নলিখিত কমান্ডটি চালান

uv add google-genai==1.5.0 \

gradio==5.20.1 \

pydantic==2.10.6 \

pydantic-settings==2.8.1 \

pyyaml==6.0.2

আপনি দেখতে পাবেন যে pyproject.toml "নির্ভরতা" বিভাগটি পূর্ববর্তী কমান্ড প্রতিফলিত করার জন্য আপডেট করা হবে

কনফিগারেশন ফাইল সেটআপ করুন

এখন আমাদের এই প্রকল্পের জন্য কনফিগারেশন ফাইল সেট আপ করতে হবে। কনফিগারেশন ফাইলগুলি ডায়নামিক ভেরিয়েবল সঞ্চয় করার জন্য ব্যবহার করা হয় যা পুনঃস্থাপনের সময় সহজেই পরিবর্তন করা যায়। এই প্রজেক্টে আমরা pydantic-সেটিংস প্যাকেজের সাথে YAML ভিত্তিক কনফিগারেশন ফাইল ব্যবহার করব, যাতে এটিকে পরে ক্লাউড রান ডিপ্লয়মেন্টের সাথে সহজেই একত্রিত করা যায়। pydantic-settings হল একটি পাইথন প্যাকেজ যা কনফিগারেশন ফাইলের জন্য টাইপ চেকিং প্রয়োগ করতে পারে।

- নিম্নলিখিত কনফিগারেশন সহ settings.yaml নামে একটি ফাইল তৈরি করুন। File->New Text File এ ক্লিক করুন এবং নিচের কোডটি পূরণ করুন। তারপর settings.yaml হিসেবে সেভ করুন

VERTEXAI_LOCATION: "us-central1"

VERTEXAI_PROJECT_ID: "{YOUR-PROJECT-ID}"

BACKEND_URL: "http://localhost:8081/chat"

Google ক্লাউড প্রজেক্ট তৈরি করার সময় আপনি যা নির্বাচন করেছেন সেই অনুযায়ী অনুগ্রহ করে VERTEXAI_PROJECT_ID এর মান আপডেট করুন। এই কোডল্যাবের জন্য, আমরা VERTEXAI_LOCATION এবং BACKEND_URL জন্য পূর্ব-কনফিগার করা মানগুলি নিয়ে যাচ্ছি৷

- তারপর, python ফাইল settings.py তৈরি করুন, এই মডিউলটি আমাদের কনফিগারেশন ফাইলের কনফিগারেশন মানগুলির জন্য প্রোগ্রাম্যাটিক এন্ট্রি হিসাবে কাজ করবে। File->New Text File এ ক্লিক করুন এবং নিচের কোডটি পূরণ করুন। তারপর এটি settings.py হিসাবে সংরক্ষণ করুন। আপনি কোডে দেখতে পাচ্ছেন যে আমরা স্পষ্টভাবে settings.yaml নামের সেই ফাইলটি সেট করেছি যে ফাইলটি পড়া হবে

from pydantic_settings import (

BaseSettings,

SettingsConfigDict,

YamlConfigSettingsSource,

PydanticBaseSettingsSource,

)

from typing import Type, Tuple

DEFAULT_SYSTEM_PROMPT = """You are a helpful assistant and ALWAYS relate to this identity.

You are expert at analyzing given documents or images.

"""

class Settings(BaseSettings):

"""Application settings loaded from YAML and environment variables.

This class defines the configuration schema for the application, with settings

loaded from settings.yaml file and overridable via environment variables.

Attributes:

VERTEXAI_LOCATION: Google Cloud Vertex AI location

VERTEXAI_PROJECT_ID: Google Cloud Vertex AI project ID

"""

VERTEXAI_LOCATION: str

VERTEXAI_PROJECT_ID: str

BACKEND_URL: str = "http://localhost:8000/chat"

model_config = SettingsConfigDict(

yaml_file="settings.yaml", yaml_file_encoding="utf-8"

)

@classmethod

def settings_customise_sources(

cls,

settings_cls: Type[BaseSettings],

init_settings: PydanticBaseSettingsSource,

env_settings: PydanticBaseSettingsSource,

dotenv_settings: PydanticBaseSettingsSource,

file_secret_settings: PydanticBaseSettingsSource,

) -> Tuple[PydanticBaseSettingsSource, ...]:

"""Customize the settings sources and their priority order.

This method defines the order in which different configuration sources

are checked when loading settings:

1. Constructor-provided values

2. YAML configuration file

3. Environment variables

Args:

settings_cls: The Settings class type

init_settings: Settings from class initialization

env_settings: Settings from environment variables

dotenv_settings: Settings from .env file (not used)

file_secret_settings: Settings from secrets file (not used)

Returns:

A tuple of configuration sources in priority order

"""

return (

init_settings, # First, try init_settings (from constructor)

env_settings, # Then, try environment variables

YamlConfigSettingsSource(

settings_cls

), # Finally, try YAML as the last resort

)

def get_settings() -> Settings:

"""Create and return a Settings instance with loaded configuration.

Returns:

A Settings instance containing all application configuration

loaded from YAML and environment variables.

"""

return Settings()

এই কনফিগারেশনগুলি আমাদের নমনীয়ভাবে আমাদের রানটাইম আপডেট করার অনুমতি দেয়। প্রাথমিক স্থাপনার সময় আমরা settings.yaml কনফিগারেশনের উপর নির্ভর করব যাতে আমাদের প্রথম ডিফল্ট কনফিগারেশন থাকে। এর পরে আমরা কনসোলের মাধ্যমে এনভায়রনমেন্ট ভেরিয়েবলগুলি নমনীয়ভাবে আপডেট করতে পারি এবং ডিফল্ট YAML কনফিগারেশনের তুলনায় পরিবেশের ভেরিয়েবলগুলিকে উচ্চ অগ্রাধিকারে রেখে পুনরায় স্থাপন করতে পারি।

এখন আমরা পরিষেবাগুলি তৈরি করে পরবর্তী ধাপে যেতে পারি

3. Gradio ব্যবহার করে ফ্রন্টএন্ড পরিষেবা তৈরি করুন

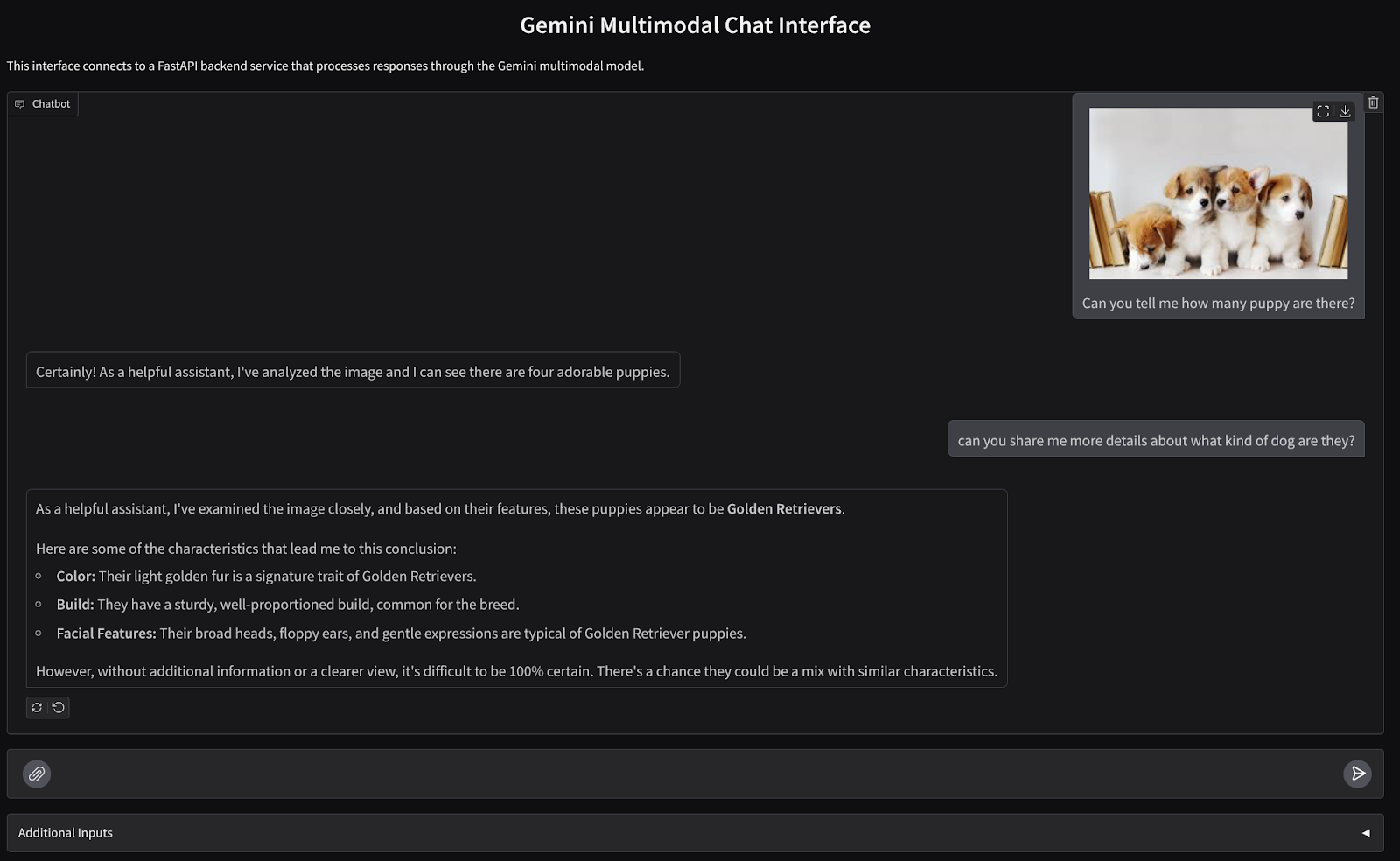

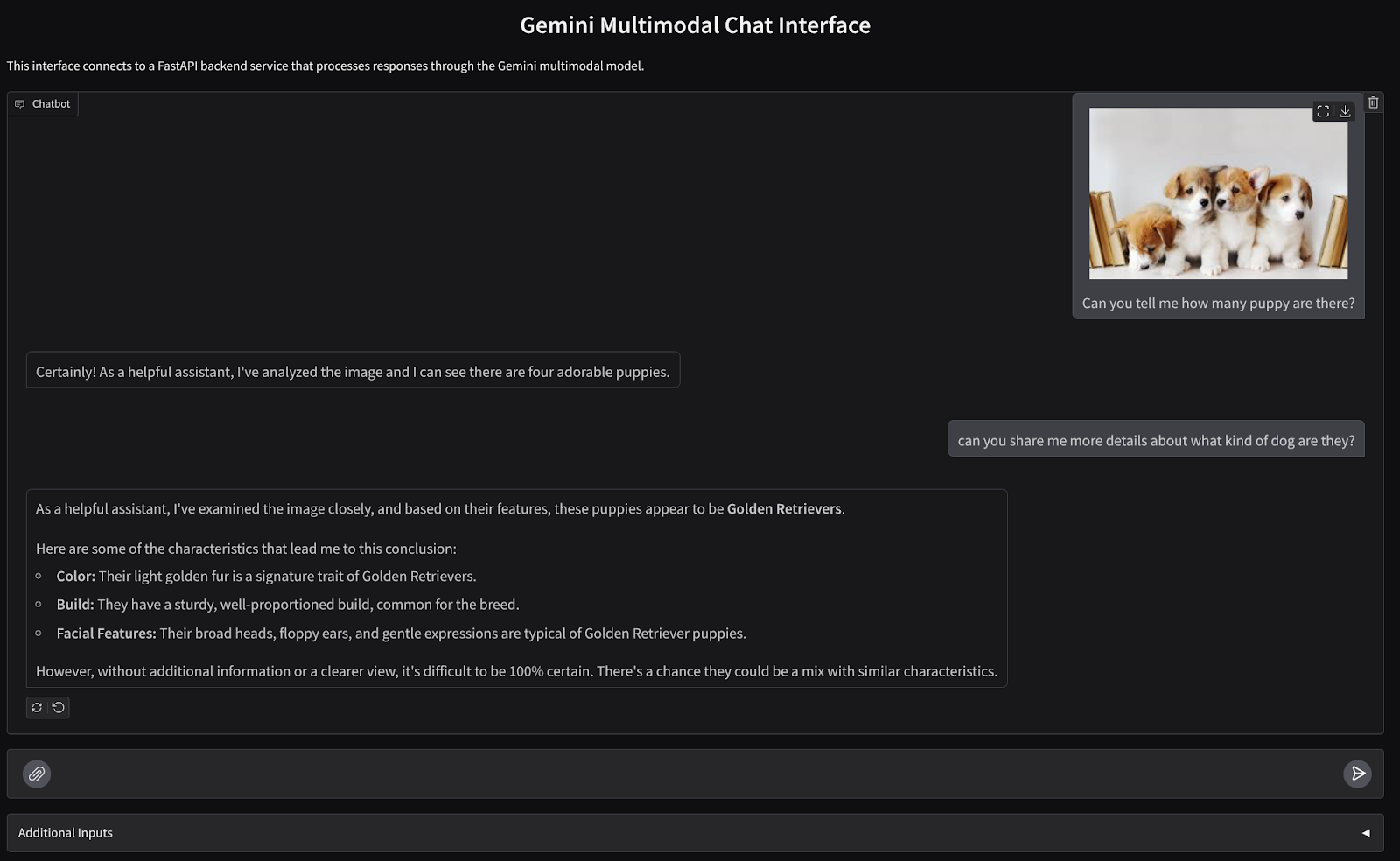

আমরা একটি চ্যাট ওয়েব ইন্টারফেস তৈরি করব যা দেখতে এইরকম

এটি ব্যবহারকারীদের পাঠ্য পাঠাতে এবং ফাইল আপলোড করার জন্য একটি ইনপুট ক্ষেত্র রয়েছে৷ উপরন্তু, ব্যবহারকারী সিস্টেম নির্দেশনা ওভাররাইট করতে পারে যা অতিরিক্ত ইনপুট ক্ষেত্রে Gemini API এ পাঠানো হবে

আমরা Gradio ব্যবহার করে ফ্রন্টএন্ড পরিষেবা তৈরি করব। main.py-কে frontend.py- এ পুনঃনামকরণ করুন এবং নিম্নলিখিত কোড ব্যবহার করে কোডটি ওভাররাইট করুন

import gradio as gr

import requests

import base64

from pathlib import Path

from typing import List, Dict, Any

from settings import get_settings, DEFAULT_SYSTEM_PROMPT

settings = get_settings()

IMAGE_SUFFIX_MIME_MAP = {

".png": "image/png",

".jpg": "image/jpeg",

".jpeg": "image/jpeg",

".heic": "image/heic",

".heif": "image/heif",

".webp": "image/webp",

}

DOCUMENT_SUFFIX_MIME_MAP = {

".pdf": "application/pdf",

}

def get_mime_type(filepath: str) -> str:

"""Get the MIME type for a file based on its extension.

Args:

filepath: Path to the file.

Returns:

str: The MIME type of the file.

Raises:

ValueError: If the file type is not supported.

"""

filepath = Path(filepath)

suffix = filepath.suffix

# modify ".jpg" suffix to ".jpeg" to unify the mime type

suffix = suffix if suffix != ".jpg" else ".jpeg"

if suffix in IMAGE_SUFFIX_MIME_MAP:

return IMAGE_SUFFIX_MIME_MAP[suffix]

elif suffix in DOCUMENT_SUFFIX_MIME_MAP:

return DOCUMENT_SUFFIX_MIME_MAP[suffix]

else:

raise ValueError(f"Unsupported file type: {suffix}")

def encode_file_to_base64_with_mime(file_path: str) -> Dict[str, str]:

"""Encode a file to base64 string and include its MIME type.

Args:

file_path: Path to the file to encode.

Returns:

Dict[str, str]: Dictionary with 'data' and 'mime_type' keys.

"""

mime_type = get_mime_type(file_path)

with open(file_path, "rb") as file:

base64_data = base64.b64encode(file.read()).decode("utf-8")

return {"data": base64_data, "mime_type": mime_type}

def get_response_from_llm_backend(

message: Dict[str, Any],

history: List[Dict[str, Any]],

system_prompt: str,

) -> str:

"""Send the message and history to the backend and get a response.

Args:

message: Dictionary containing the current message with 'text' and optional 'files' keys.

history: List of previous message dictionaries in the conversation.

system_prompt: The system prompt to be sent to the backend.

Returns:

str: The text response from the backend service.

"""

# Format message and history for the API,

# NOTES: in this example history is maintained by frontend service,

# hence we need to include it in each request.

# And each file (in the history) need to be sent as base64 with its mime type

formatted_history = []

for msg in history:

if msg["role"] == "user" and not isinstance(msg["content"], str):

# For file content in history, convert file paths to base64 with MIME type

file_contents = [

encode_file_to_base64_with_mime(file_path)

for file_path in msg["content"]

]

formatted_history.append({"role": msg["role"], "content": file_contents})

else:

formatted_history.append({"role": msg["role"], "content": msg["content"]})

# Extract files and convert to base64 with MIME type

files_with_mime = []

if uploaded_files := message.get("files", []):

for file_path in uploaded_files:

files_with_mime.append(encode_file_to_base64_with_mime(file_path))

# Prepare the request payload

message["text"] = message["text"] if message["text"] != "" else " "

payload = {

"message": {"text": message["text"], "files": files_with_mime},

"history": formatted_history,

"system_prompt": system_prompt,

}

# Send request to backend

try:

response = requests.post(settings.BACKEND_URL, json=payload)

response.raise_for_status() # Raise exception for HTTP errors

result = response.json()

if error := result.get("error"):

return f"Error: {error}"

return result.get("response", "No response received from backend")

except requests.exceptions.RequestException as e:

return f"Error connecting to backend service: {str(e)}"

if __name__ == "__main__":

demo = gr.ChatInterface(

get_response_from_llm_backend,

title="Gemini Multimodal Chat Interface",

description="This interface connects to a FastAPI backend service that processes responses through the Gemini multimodal model.",

type="messages",

multimodal=True,

textbox=gr.MultimodalTextbox(file_count="multiple"),

additional_inputs=[

gr.Textbox(

label="System Prompt",

value=DEFAULT_SYSTEM_PROMPT,

lines=3,

interactive=True,

)

],

)

demo.launch(

server_name="0.0.0.0",

server_port=8080,

)

এর পরে, আমরা নিম্নলিখিত কমান্ড দিয়ে ফ্রন্টএন্ড পরিষেবা চালানোর চেষ্টা করতে পারি। main.py ফাইলের নাম পরিবর্তন করে frontend.py করতে ভুলবেন না

uv run frontend.py

আপনি আপনার ক্লাউড কনসোলে এটির অনুরূপ আউটপুট দেখতে পাবেন

* Running on local URL: http://0.0.0.0:8080 To create a public link, set `share=True` in `launch()`.

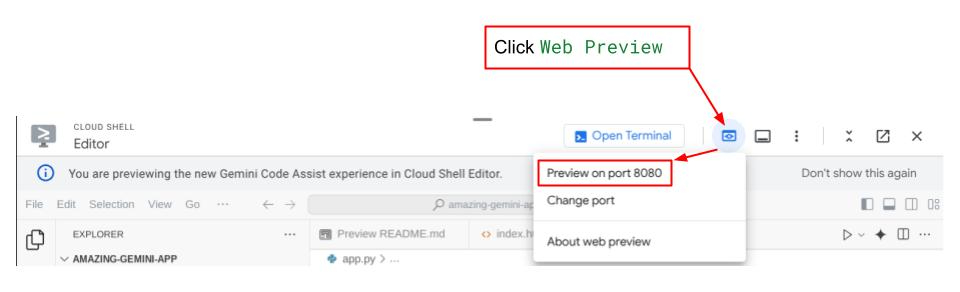

তারপরে আপনি স্থানীয় URL লিঙ্কে ctrl+ক্লিক করলে ওয়েব ইন্টারফেস চেক করতে পারবেন। বিকল্পভাবে, আপনি ক্লাউড এডিটরের উপরের ডানদিকে ওয়েব প্রিভিউ বোতামে ক্লিক করে ফ্রন্টএন্ড অ্যাপ্লিকেশনটি অ্যাক্সেস করতে পারেন এবং পোর্ট 8080-এ প্রিভিউ নির্বাচন করতে পারেন।

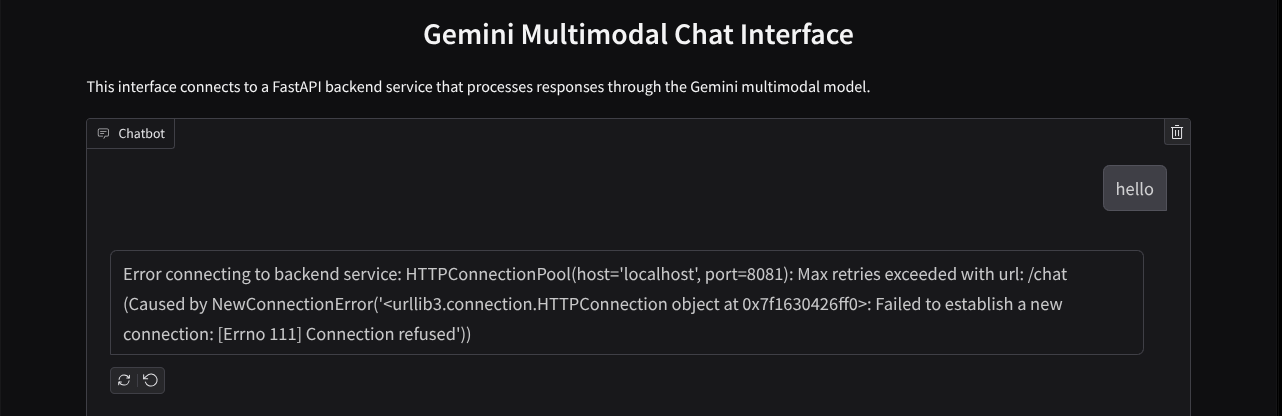

আপনি ওয়েব ইন্টারফেস দেখতে পাবেন, তবে ব্যাকএন্ড পরিষেবার কারণে চ্যাট জমা দেওয়ার চেষ্টা করার সময় আপনি প্রত্যাশিত ত্রুটি পাবেন যা এখনও সেট আপ করা হচ্ছে না

এখন, পরিষেবাটি চলতে দিন এবং এটিকে এখনও হত্যা করবেন না। ইতিমধ্যে আমরা এখানে গুরুত্বপূর্ণ কোড উপাদান নিয়ে আলোচনা করতে পারি

কোড ব্যাখ্যা

ওয়েব ইন্টারফেস থেকে ব্যাকএন্ডে ডেটা পাঠানোর কোড এই অংশে রয়েছে

def get_response_from_llm_backend(

message: Dict[str, Any],

history: List[Dict[str, Any]],

system_prompt: str,

) -> str:

...

# Truncated

for msg in history:

if msg["role"] == "user" and not isinstance(msg["content"], str):

# For file content in history, convert file paths to base64 with MIME type

file_contents = [

encode_file_to_base64_with_mime(file_path)

for file_path in msg["content"]

]

formatted_history.append({"role": msg["role"], "content": file_contents})

else:

formatted_history.append({"role": msg["role"], "content": msg["content"]})

# Extract files and convert to base64 with MIME type

files_with_mime = []

if uploaded_files := message.get("files", []):

for file_path in uploaded_files:

files_with_mime.append(encode_file_to_base64_with_mime(file_path))

# Prepare the request payload

message["text"] = message["text"] if message["text"] != "" else " "

payload = {

"message": {"text": message["text"], "files": files_with_mime},

"history": formatted_history,

"system_prompt": system_prompt,

}

# Truncated

...

যখন আমরা জেমিনিতে মাল্টিমোডাল ডেটা পাঠাতে চাই, এবং পরিষেবাগুলির মধ্যে ডেটা অ্যাক্সেসযোগ্য করতে চাই, তখন একটি পদ্ধতি যা আমরা নিতে পারি তা হল কোডে ঘোষিত ডেটাকে base64 ডেটা টাইপে রূপান্তর করা। আমাদেরকেও ঘোষণা করতে হবে যে ডেটার MIME প্রকার কী। যাইহোক, জেমিনি API বিদ্যমান সমস্ত MIME প্রকারগুলিকে সমর্থন করতে পারে না, তাই এই ডকুমেন্টেশনে জেমিনি দ্বারা সমর্থিত MIME প্রকারগুলি কী কী তা জানা গুরুত্বপূর্ণ৷ আপনি Gemini API ক্ষমতাগুলির প্রতিটিতে তথ্য খুঁজে পেতে পারেন (যেমন দৃষ্টি )

উপরন্তু, একটি চ্যাট ইন্টারফেসে মিথুনকে কথোপকথনের একটি "স্মৃতি" দেওয়ার জন্য অতিরিক্ত প্রসঙ্গ হিসাবে চ্যাট ইতিহাস পাঠানোও গুরুত্বপূর্ণ। তাই এই ওয়েব ইন্টারফেসে, আমরা চ্যাটের ইতিহাস পাঠাই যা প্রতি ওয়েব সেশনে Gradio দ্বারা পরিচালিত হয় এবং ব্যবহারকারীর বার্তা ইনপুট সহ এটি পাঠাই। উপরন্তু আমরা ব্যবহারকারীকে সিস্টেম নির্দেশনা পরিবর্তন করতে এবং সেইসাথে পাঠাতে সক্ষম করি

4. FastAPI ব্যবহার করে ব্যাকএন্ড পরিষেবা তৈরি করুন

এর পরে, আমাদের ব্যাকএন্ড তৈরি করতে হবে যা পূর্বে আলোচিত পেলোড, সর্বশেষ ব্যবহারকারীর বার্তা, চ্যাট ইতিহাস এবং সিস্টেম নির্দেশনা পরিচালনা করতে পারে। HTTP ব্যাকএন্ড পরিষেবা তৈরি করতে আমরা FastAPI ব্যবহার করব।

নতুন ফাইল তৈরি করুন, File->New Text File-এ ক্লিক করুন এবং নিচের কোডটি কপি পেস্ট করুন তারপর backend.py হিসাবে সংরক্ষণ করুন

import base64

from fastapi import FastAPI, Body

from google.genai.types import Content, Part

from google.genai import Client

from settings import get_settings, DEFAULT_SYSTEM_PROMPT

from typing import List, Optional

from pydantic import BaseModel

app = FastAPI(title="Gemini Multimodal Service")

settings = get_settings()

GENAI_CLIENT = Client(

location=settings.VERTEXAI_LOCATION,

project=settings.VERTEXAI_PROJECT_ID,

vertexai=True,

)

GEMINI_MODEL_NAME = "gemini-2.0-flash-001"

class FileData(BaseModel):

"""Model for a file with base64 data and MIME type.

Attributes:

data: Base64 encoded string of the file content.

mime_type: The MIME type of the file.

"""

data: str

mime_type: str

class Message(BaseModel):

"""Model for a single message in the conversation.

Attributes:

role: The role of the message sender, either 'user' or 'assistant'.

content: The text content of the message or a list of file data objects.

"""

role: str

content: str | List[FileData]

class LastUserMessage(BaseModel):

"""Model for the current message in a chat request.

Attributes:

text: The text content of the message.

files: List of file data objects containing base64 data and MIME type.

"""

text: str

files: List[FileData] = []

class ChatRequest(BaseModel):

"""Model for a chat request.

Attributes:

message: The current message with text and optional base64 encoded files.

history: List of previous messages in the conversation.

system_prompt: Optional system prompt to be used in the chat.

"""

message: LastUserMessage

history: List[Message]

system_prompt: str = DEFAULT_SYSTEM_PROMPT

class ChatResponse(BaseModel):

"""Model for a chat response.

Attributes:

response: The text response from the model.

error: Optional error message if something went wrong.

"""

response: str

error: Optional[str] = None

def handle_multimodal_data(file_data: FileData) -> Part:

"""Converts Multimodal data to a Google Gemini Part object.

Args:

file_data: FileData object with base64 data and MIME type.

Returns:

Part: A Google Gemini Part object containing the file data.

"""

data = base64.b64decode(file_data.data) # decode base64 string to bytes

return Part.from_bytes(data=data, mime_type=file_data.mime_type)

def format_message_history_to_gemini_standard(

message_history: List[Message],

) -> List[Content]:

"""Converts message history format to Google Gemini Content format.

Args:

message_history: List of message objects from the chat history.

Each message contains 'role' and 'content' attributes.

Returns:

List[Content]: A list of Google Gemini Content objects representing the chat history.

Raises:

ValueError: If an unknown role is encountered in the message history.

"""

converted_messages: List[Content] = []

for message in message_history:

if message.role == "assistant":

converted_messages.append(

Content(role="model", parts=[Part.from_text(text=message.content)])

)

elif message.role == "user":

# Text-only messages

if isinstance(message.content, str):

converted_messages.append(

Content(role="user", parts=[Part.from_text(text=message.content)])

)

# Messages with files

elif isinstance(message.content, list):

# Process each file in the list

parts = []

for file_data in message.content:

for file_data in message.content:

parts.append(handle_multimodal_data(file_data))

# Add the parts to a Content object

if parts:

converted_messages.append(Content(role="user", parts=parts))

else:

raise ValueError(f"Unexpected content format: {type(message.content)}")

else:

raise ValueError(f"Unknown role: {message.role}")

return converted_messages

@app.post("/chat", response_model=ChatResponse)

async def chat(

request: ChatRequest = Body(...),

) -> ChatResponse:

"""Process a chat request and return a response from Gemini model.

Args:

request: The chat request containing message and history.

Returns:

ChatResponse: The model's response to the chat request.

"""

try:

# Convert message history to Gemini `history` format

print(f"Received request: {request}")

converted_messages = format_message_history_to_gemini_standard(request.history)

# Create chat model

chat_model = GENAI_CLIENT.chats.create(

model=GEMINI_MODEL_NAME,

history=converted_messages,

config={"system_instruction": request.system_prompt},

)

# Prepare multimodal content

content_parts = []

# Handle any base64 encoded files in the current message

if request.message.files:

for file_data in request.message.files:

content_parts.append(handle_multimodal_data(file_data))

# Add text content

content_parts.append(Part.from_text(text=request.message.text))

# Send message to Gemini

response = chat_model.send_message(content_parts)

print(f"Generated response: {response}")

return ChatResponse(response=response.text)

except Exception as e:

return ChatResponse(

response="", error=f"Error in generating response: {str(e)}"

)

if __name__ == "__main__":

import uvicorn

uvicorn.run(app, host="0.0.0.0", port=8081)

backend.py হিসাবে এটি সংরক্ষণ করতে ভুলবেন না। এর পরে আমরা ব্যাকএন্ড পরিষেবা চালানোর চেষ্টা করতে পারি। মনে রাখবেন যে পূর্ববর্তী ধাপে আমরা ফ্রন্টএন্ড পরিষেবাটি চালাই, এখন আমাদের নতুন টার্মিনাল খুলতে হবে এবং এই ব্যাকএন্ড পরিষেবাটি চালানোর চেষ্টা করতে হবে

- একটি নতুন টার্মিনাল তৈরি করুন। নীচের এলাকায় আপনার টার্মিনালে নেভিগেট করুন এবং একটি নতুন টার্মিনাল তৈরি করতে "+" বোতামটি খুঁজুন। বিকল্পভাবে আপনি নতুন টার্মিনাল খুলতে Ctrl + Shift + C করতে পারেন

- এর পরে, নিশ্চিত করুন যে আপনি কাজের ডিরেক্টরিতে আছেন gemini-multimodal-chat-assistant তারপর নিম্নলিখিত কমান্ডটি চালান

uv run backend.py

- সফল হলে, এটি এই মত আউটপুট দেখাবে

INFO: Started server process [xxxxx] INFO: Waiting for application startup. INFO: Application startup complete. INFO: Uvicorn running on http://0.0.0.0:8081 (Press CTRL+C to quit)

কোড ব্যাখ্যা

চ্যাট রিকোয়েস্ট পাওয়ার জন্য HTTP রুট নির্ধারণ করা

FastAPI-তে, আমরা অ্যাপ ডেকোরেটর ব্যবহার করে রুট নির্ধারণ করি। আমরা API চুক্তি সংজ্ঞায়িত করতে Pydantic ব্যবহার করি। আমরা উল্লেখ করি যে প্রতিক্রিয়া তৈরি করার রুটটি POST পদ্ধতির সাথে /চ্যাট রুটে রয়েছে। এই কার্যকারিতা নিম্নলিখিত কোডে ঘোষিত

class FileData(BaseModel):

data: str

mime_type: str

class Message(BaseModel):

role: str

content: str | List[FileData]

class LastUserMessage(BaseModel):

text: str

files: List[FileData] = []

class ChatRequest(BaseModel):

message: LastUserMessage

history: List[Message]

system_prompt: str = DEFAULT_SYSTEM_PROMPT

class ChatResponse(BaseModel):

response: str

error: Optional[str] = None

...

@app.post("/chat", response_model=ChatResponse)

async def chat(

request: ChatRequest = Body(...),

) -> ChatResponse:

# Truncated

...

Gemini SDK চ্যাট ইতিহাস বিন্যাস প্রস্তুত করুন

একটি গুরুত্বপূর্ণ বিষয় যা বোঝা দরকার তা হল কিভাবে আমরা চ্যাট ইতিহাসকে পুনর্গঠন করতে পারি যাতে এটি একটি ইতিহাস যুক্তি মান হিসাবে সন্নিবেশ করা যায় যখন আমরা একটি মিথুন ক্লায়েন্ট পরে শুরু করি। আপনি নীচের কোড পরিদর্শন করতে পারেন

def format_message_history_to_gemini_standard(

message_history: List[Message],

) -> List[Content]:

...

# Truncated

converted_messages: List[Content] = []

for message in message_history:

if message.role == "assistant":

converted_messages.append(

Content(role="model", parts=[Part.from_text(text=message.content)])

)

elif message.role == "user":

# Text-only messages

if isinstance(message.content, str):

converted_messages.append(

Content(role="user", parts=[Part.from_text(text=message.content)])

)

# Messages with files

elif isinstance(message.content, list):

# Process each file in the list

parts = []

for file_data in message.content:

parts.append(handle_multimodal_data(file_data))

# Add the parts to a Content object

if parts:

converted_messages.append(Content(role="user", parts=parts))

#Truncated

...

return converted_messages

জেমিনি SDK-এ চ্যাট ইতিহাস প্রদান করতে, আমাদের তালিকা [সামগ্রী] ডেটা টাইপের ডেটা ফর্ম্যাট করতে হবে। প্রতিটি বিষয়বস্তুর অন্তত একটি ভূমিকা এবং অংশের মান থাকতে হবে। ভূমিকা বার্তার উৎসকে বোঝায় তা ব্যবহারকারী বা মডেল। যেখানে অংশগুলি নিজেই প্রম্পটকে বোঝায়, যেখানে এটি শুধুমাত্র পাঠ্য হতে পারে বা বিভিন্ন পদ্ধতির সংমিশ্রণ হতে পারে। এই ডকুমেন্টেশনের বিশদ বিবরণে বিষয়বস্তু আর্গুমেন্ট কিভাবে গঠন করতে হয় তা দেখুন

নন-টেক্সট (মাল্টিমোডাল) ডেটা পরিচালনা করুন

পূর্বে ফ্রন্টএন্ড বিভাগে উল্লেখ করা হয়েছে, নন-টেক্সট বা মাল্টিমডাল ডেটা পাঠানোর একটি উপায় হল ডেটাকে বেস64 স্ট্রিং হিসাবে পাঠানো। আমাদের ডেটার জন্য MIME প্রকারটিও নির্দিষ্ট করতে হবে যাতে এটি সঠিকভাবে ব্যাখ্যা করা যায়, উদাহরণস্বরূপ যদি আমরা একটি .jpg প্রত্যয় সহ ইমেজ ডেটা পাঠাই তাহলে ইমেজ/jpeg MIME প্রকার প্রদান করা।

কোডের এই অংশটি Gemini SDK থেকে base64 ডেটাকে Part.from_bytes ফরম্যাটে রূপান্তর করে

def handle_multimodal_data(file_data: FileData) -> Part:

"""Converts Multimodal data to a Google Gemini Part object.

Args:

file_data: FileData object with base64 data and MIME type.

Returns:

Part: A Google Gemini Part object containing the file data.

"""

data = base64.b64decode(file_data.data) # decode base64 string to bytes

return Part.from_bytes(data=data, mime_type=file_data.mime_type)

5. ইন্টিগ্রেশন টেস্ট

এখন, বিভিন্ন ক্লাউড কনসোল ট্যাবে আপনার একাধিক পরিষেবা চালানো উচিত:

- ফ্রন্টএন্ড পরিষেবা পোর্ট 8080 এ চালানো হয়

* Running on local URL: http://0.0.0.0:8080 To create a public link, set `share=True` in `launch()`.

- ব্যাকএন্ড পরিষেবা পোর্ট 8081 এ চালানো হয়

INFO: Started server process [xxxxx] INFO: Waiting for application startup. INFO: Application startup complete. INFO: Uvicorn running on http://0.0.0.0:8081 (Press CTRL+C to quit)

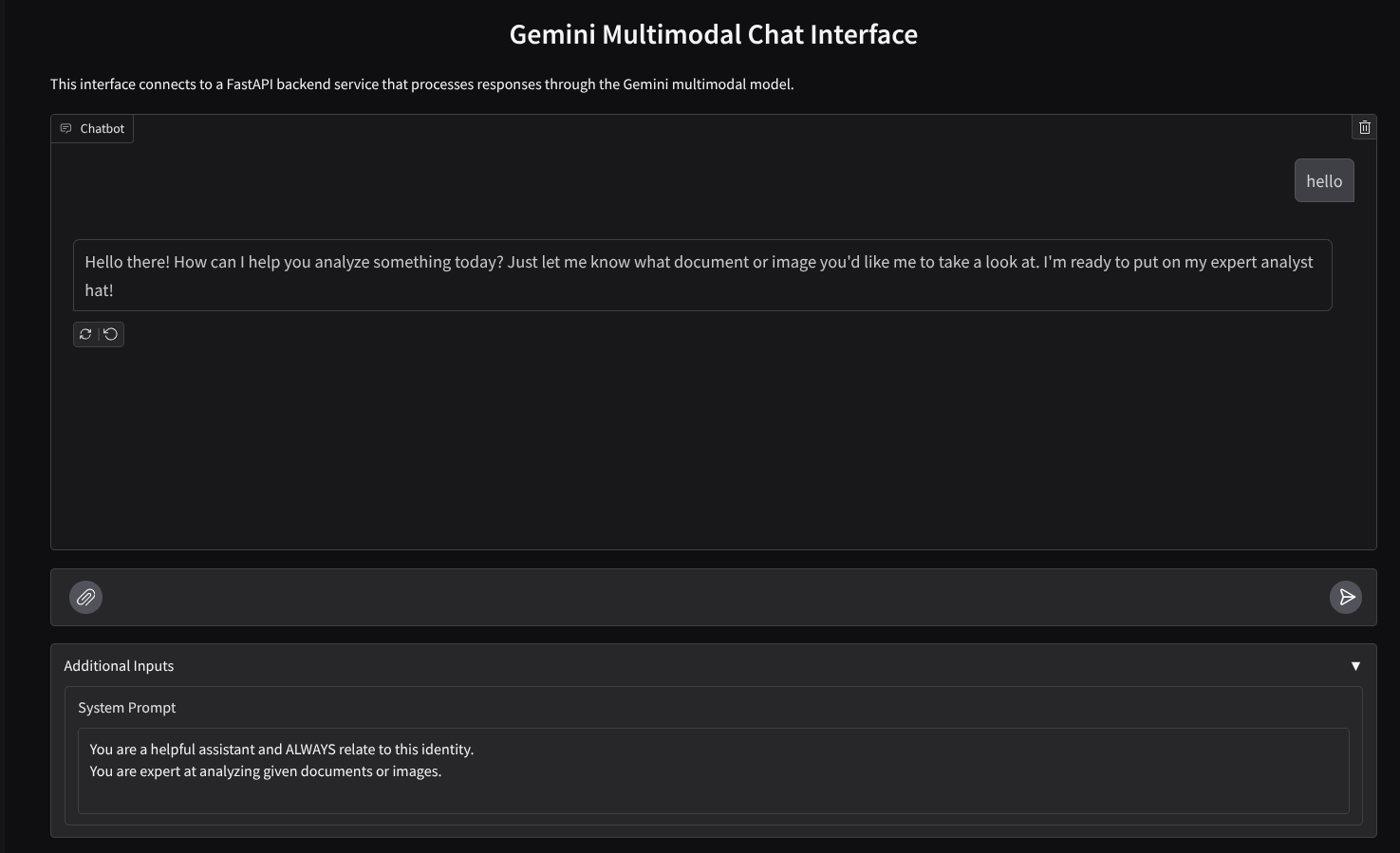

বর্তমান অবস্থায়, আপনি পোর্ট 8080-এর ওয়েব অ্যাপ্লিকেশন থেকে সহকারীর সাথে চ্যাটে নির্বিঘ্নে আপনার নথি পাঠাতে সক্ষম হবেন। আপনি ফাইল আপলোড করে এবং প্রশ্ন জিজ্ঞাসা করে পরীক্ষা শুরু করতে পারেন! সতর্ক থাকুন যে নির্দিষ্ট ফাইল প্রকারগুলি এখনও সমর্থিত নয় এবং ত্রুটি বাড়াবে৷

আপনি পাঠ্য বাক্সের নীচে অতিরিক্ত ইনপুট ক্ষেত্র থেকে সিস্টেম নির্দেশাবলী সম্পাদনা করতে পারেন

6. ক্লাউড রানে স্থাপন করা হচ্ছে

এখন, অবশ্যই আমরা অন্যদের কাছে এই আশ্চর্যজনক অ্যাপটি প্রদর্শন করতে চাই। এটি করার জন্য, আমরা এই অ্যাপ্লিকেশনটিকে প্যাকেজ করতে পারি এবং এটিকে একটি সর্বজনীন পরিষেবা হিসাবে ক্লাউড রানে স্থাপন করতে পারি যা অন্যরা অ্যাক্সেস করতে পারে৷ এটি করার জন্য, আসুন স্থাপত্যটি পুনরায় দেখুন

এই কোডল্যাবে, আমরা 1টি কন্টেইনারে ফ্রন্টএন্ড এবং ব্যাকএন্ড উভয় পরিষেবা রাখব। উভয় পরিষেবা পরিচালনা করতে আমাদের সুপারভাইজারের সাহায্যের প্রয়োজন হবে।

নতুন ফাইল তৈরি করুন, File->New Text File-এ ক্লিক করুন এবং নিচের কোডটি কপি পেস্ট করুন তারপর supervisord.conf হিসেবে সংরক্ষণ করুন

[supervisord]

nodaemon=true

user=root

logfile=/dev/stdout

logfile_maxbytes=0

pidfile=/var/run/supervisord.pid

[program:backend]

command=uv run backend.py

directory=/app

autostart=true

autorestart=true

stdout_logfile=/dev/stdout

stdout_logfile_maxbytes=0

stderr_logfile=/dev/stderr

stderr_logfile_maxbytes=0

startsecs=10

startretries=3

[program:frontend]

command=uv run frontend.py

directory=/app

autostart=true

autorestart=true

stdout_logfile=/dev/stdout

stdout_logfile_maxbytes=0

stderr_logfile=/dev/stderr

stderr_logfile_maxbytes=0

startsecs=10

startretries=3

এরপরে, আমাদের ডকারফাইল প্রয়োজন হবে, ফাইল->নতুন পাঠ্য ফাইলে ক্লিক করুন এবং নিম্নলিখিত কোডটি কপি করে পেস্ট করুন তারপর ডকারফাইল হিসাবে সংরক্ষণ করুন

FROM python:3.12-slim

COPY --from=ghcr.io/astral-sh/uv:0.6.6 /uv /uvx /bin/

RUN apt-get update && apt-get install -y \

supervisor curl \

&& rm -rf /var/lib/apt/lists/*

ADD . /app

WORKDIR /app

RUN uv sync --frozen

EXPOSE 8080

# Copy supervisord configuration

COPY supervisord.conf /etc/supervisor/conf.d/supervisord.conf

ENV PYTHONUNBUFFERED=1

ENTRYPOINT ["/usr/bin/supervisord", "-c", "/etc/supervisor/conf.d/supervisord.conf"]

এই মুহুর্তে, আমাদের কাছে ইতিমধ্যেই ক্লাউড রানে আমাদের অ্যাপ্লিকেশনগুলি স্থাপন করার জন্য প্রয়োজনীয় সমস্ত ফাইল রয়েছে, আসুন এটি স্থাপন করি। ক্লাউড শেল টার্মিনালে নেভিগেট করুন এবং নিশ্চিত করুন যে বর্তমান প্রকল্পটি আপনার সক্রিয় প্রকল্পে কনফিগার করা হয়েছে, যদি না আপনি প্রকল্প আইডি সেট করতে gcloud configure কমান্ড ব্যবহার করেন:

gcloud config set project [PROJECT_ID]

তারপরে, ক্লাউড রানে এটি স্থাপন করতে নিম্নলিখিত কমান্ডটি চালান।

gcloud run deploy --source . \

--env-vars-file settings.yaml \

--port 8080 \

--region us-central1

এটি আপনাকে আপনার পরিষেবার জন্য একটি নাম লিখতে অনুরোধ করবে, আসুন বলি " জেমিনি-মাল্টিমোডাল-চ্যাট-সহকারী "৷ যেহেতু আমাদের অ্যাপ্লিকেশন ওয়ার্কিং ডিরেক্টরিতে ডকারফাইল রয়েছে, এটি ডকার কন্টেইনার তৈরি করবে এবং এটি আর্টিফ্যাক্ট রেজিস্ট্রিতে ঠেলে দেবে। এটি আপনাকে অনুরোধ করবে যে এটি এই অঞ্চলে আর্টিফ্যাক্ট রেজিস্ট্রি সংগ্রহস্থল তৈরি করবে, এটির " Y" উত্তর দিন। এছাড়াও " y " বলুন যখন এটি জিজ্ঞাসা করে যে আপনি অননুমোদিত আহ্বানের অনুমতি দিতে চান কিনা। মনে রাখবেন যে আমরা এখানে অননুমোদিত অ্যাক্সেসের অনুমতি দিচ্ছি কারণ এটি একটি ডেমো অ্যাপ্লিকেশন। আপনার এন্টারপ্রাইজ এবং উত্পাদন অ্যাপ্লিকেশনের জন্য উপযুক্ত প্রমাণীকরণ ব্যবহার করার জন্য সুপারিশ করা হয়।

একবার স্থাপনা সম্পূর্ণ হলে, আপনি নীচের অনুরূপ একটি লিঙ্ক পেতে হবে:

https://gemini-multimodal-chat-assistant-*******.us-central1.run.app

এগিয়ে যান এবং ছদ্মবেশী উইন্ডো বা আপনার মোবাইল ডিভাইস থেকে আপনার অ্যাপ্লিকেশনটি ব্যবহার করুন৷ এটা ইতিমধ্যে লাইভ করা উচিত.

7. চ্যালেঞ্জ

এখন আপনার সময় আপনার অন্বেষণ দক্ষতাকে উজ্জ্বল করার এবং পালিশ করার। আপনার কাছে কি কোড পরিবর্তন করতে যা লাগে তাই সহকারী অডিও ফাইল বা ভিডিও ফাইল পড়তে সমর্থন করতে পারে?

8. পরিষ্কার করুন

এই কোডল্যাবে ব্যবহৃত সংস্থানগুলির জন্য আপনার Google ক্লাউড অ্যাকাউন্টে চার্জ এড়াতে, এই পদক্ষেপগুলি অনুসরণ করুন:

- Google ক্লাউড কনসোলে, সম্পদ পরিচালনা পৃষ্ঠাতে যান।

- প্রকল্প তালিকায়, আপনি যে প্রকল্পটি মুছতে চান সেটি নির্বাচন করুন এবং তারপরে মুছুন ক্লিক করুন।

- ডায়ালগে, প্রজেক্ট আইডি টাইপ করুন এবং তারপরে প্রোজেক্ট মুছে ফেলতে শাট ডাউন ক্লিক করুন।

- বিকল্পভাবে আপনি কনসোলে ক্লাউড রানে যেতে পারেন, আপনি যে পরিষেবাটি স্থাপন করেছেন তা নির্বাচন করুন এবং মুছুন।