1. Tổng quan

Trong phòng thí nghiệm này, bạn sẽ tìm hiểu cách sử dụng Vertex AI – nền tảng học máy được quản lý mới được Google Cloud công bố – để xây dựng quy trình công nghệ học máy toàn diện. Bạn sẽ tìm hiểu cách chuyển từ dữ liệu thô sang mô hình được triển khai, đồng thời sẽ chuẩn bị sẵn sàng cho hội thảo này để phát triển và sản xuất các dự án học máy của riêng bạn bằng Vertex AI. Trong phòng thí nghiệm này, chúng tôi sử dụng Cloud Shell để tạo hình ảnh Docker tuỳ chỉnh nhằm minh hoạ các vùng chứa tuỳ chỉnh dùng để huấn luyện bằng Vertex AI.

Mặc dù chúng ta đang sử dụng TensorFlow cho mã mô hình ở đây, bạn có thể dễ dàng thay thế mã đó bằng một khung khác.

Kiến thức bạn sẽ học được

Bạn sẽ tìm hiểu cách:

- Xây dựng và chứa mã huấn luyện mô hình bằng Cloud Shell

- Gửi công việc huấn luyện mô hình tuỳ chỉnh cho Vertex AI

- Triển khai mô hình đã huấn luyện cho một điểm cuối và sử dụng điểm cuối đó để nhận thông tin dự đoán

Tổng chi phí để chạy phòng thí nghiệm này trên Google Cloud là khoảng 2 USD.

2. Giới thiệu về Vertex AI

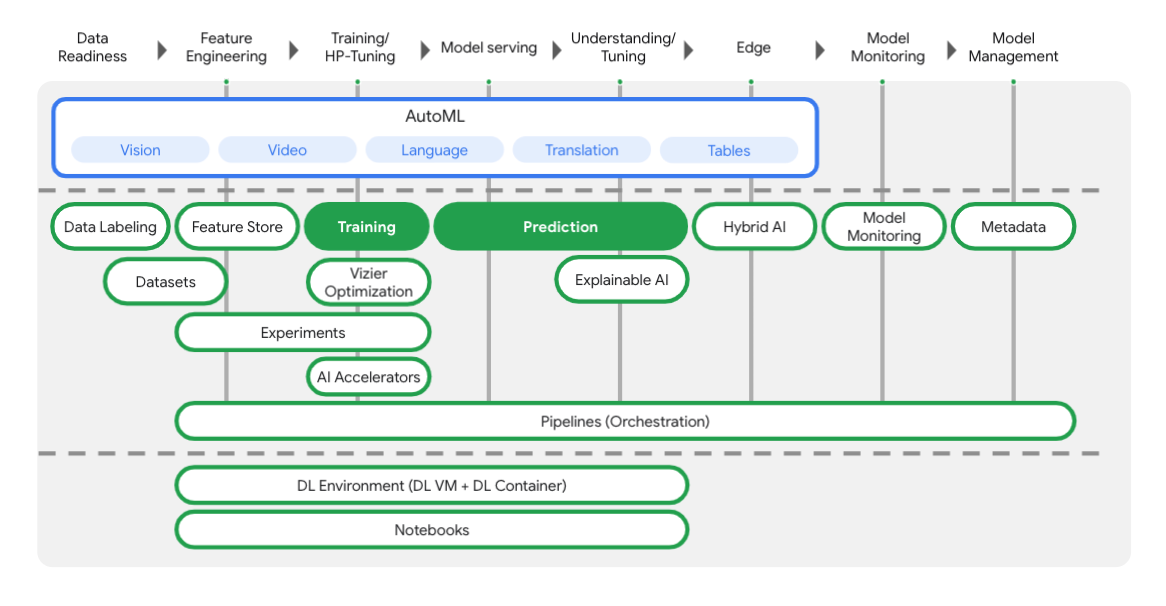

Phòng thí nghiệm này sử dụng sản phẩm AI mới nhất có trên Google Cloud. Vertex AI tích hợp các giải pháp học máy trên Google Cloud vào một trải nghiệm phát triển liền mạch. Trước đây, các mô hình được huấn luyện bằng AutoML và mô hình tuỳ chỉnh có thể truy cập được thông qua các dịch vụ riêng biệt. Dịch vụ mới kết hợp cả hai thành một API duy nhất, cùng với các sản phẩm mới khác. Bạn cũng có thể di chuyển các dự án hiện có sang Vertex AI. Nếu bạn có ý kiến phản hồi, vui lòng xem trang hỗ trợ.

Vertex có nhiều công cụ hỗ trợ bạn ở từng giai đoạn của quy trình công nghệ học máy, như bạn có thể thấy trong sơ đồ dưới đây. Chúng ta sẽ tập trung vào việc sử dụng các tính năng Đào tạo và Dự đoán của Vertex, được trình bày nổi bật ở bên dưới.

3. Thiết lập môi trường

Thiết lập môi trường theo tiến độ riêng

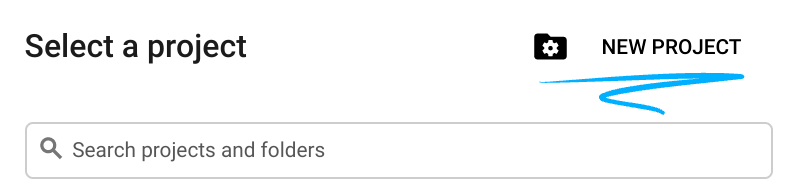

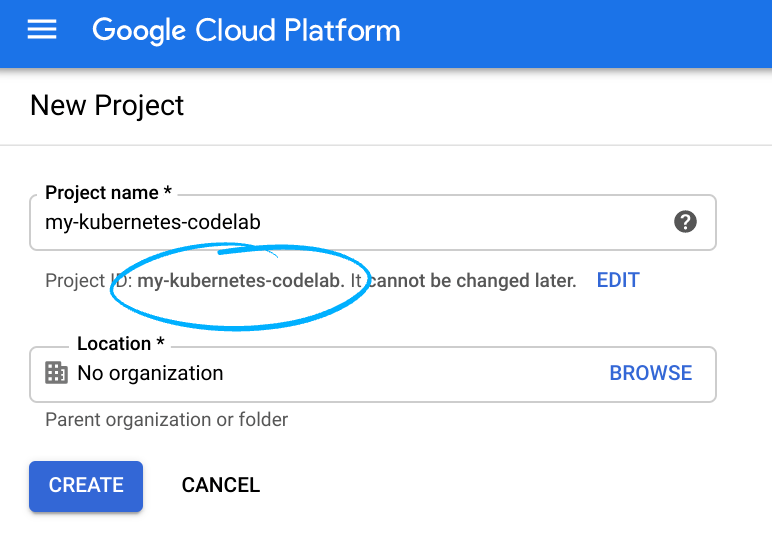

Đăng nhập vào Cloud Console rồi tạo dự án mới hoặc sử dụng lại dự án hiện có. (Nếu chưa có tài khoản Gmail hoặc Google Workspace, bạn phải tạo một tài khoản.)

Xin lưu ý rằng mã dự án là một tên riêng biệt trong tất cả dự án Google Cloud (tên ở trên đã được sử dụng nên sẽ không phù hợp với bạn!).

Tiếp theo, bạn sẽ cần bật tính năng thanh toán trong Cloud Console để sử dụng tài nguyên của Google Cloud.

Việc chạy qua lớp học lập trình này sẽ không tốn nhiều chi phí. Hãy nhớ làm theo mọi hướng dẫn trong phần "Dọn dẹp" sẽ tư vấn cho bạn cách tắt tài nguyên để bạn không phải chịu thanh toán ngoài hướng dẫn này. Người dùng mới của Google Cloud đủ điều kiện tham gia chương trình Dùng thử miễn phí 300 USD.

Bước 1: Khởi động Cloud Shell

Trong phòng thí nghiệm này, bạn sẽ thực hiện phiên Cloud Shell, đây là phiên dịch lệnh được lưu trữ bởi một máy ảo chạy trên đám mây của Google. Dù bạn có thể dễ dàng chạy phần này trên máy tính của mình, nhưng việc sử dụng Cloud Shell sẽ giúp mọi người có thể tiếp cận trải nghiệm có thể tái tạo trong một môi trường nhất quán. Sau phòng thí nghiệm này, bạn có thể thử lại phần này trên máy tính của mình.

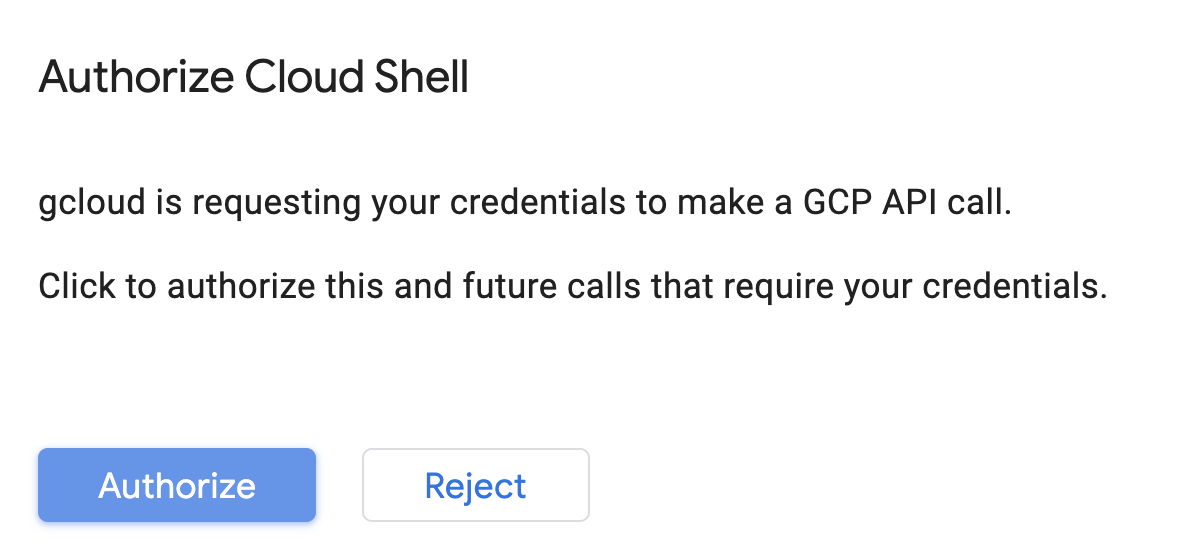

Kích hoạt Cloud Shell

Ở góc trên cùng bên phải của Cloud Console, hãy nhấp vào nút bên dưới để Kích hoạt Cloud Shell:

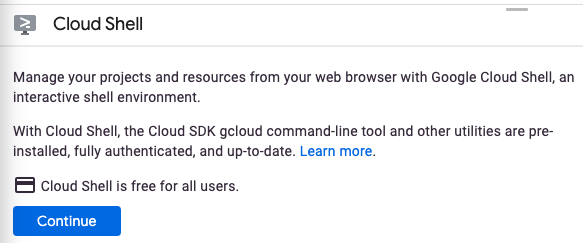

Nếu trước đây bạn chưa từng khởi động Cloud Shell, thì bạn sẽ thấy một màn hình trung gian (dưới màn hình đầu tiên) mô tả về ứng dụng này. Nếu trường hợp đó xảy ra, hãy nhấp vào Tiếp tục (và bạn sẽ không thấy thông báo đó nữa). Màn hình một lần đó sẽ có dạng như sau:

Quá trình cấp phép và kết nối với Cloud Shell chỉ mất vài phút.

Máy ảo này chứa tất cả các công cụ phát triển mà bạn cần. Dịch vụ này cung cấp thư mục gốc 5 GB ổn định và chạy trong Google Cloud, giúp nâng cao đáng kể hiệu suất và khả năng xác thực của mạng. Trong lớp học lập trình này, đa số mọi người đều có thể thực hiện chỉ bằng một trình duyệt hoặc Chromebook.

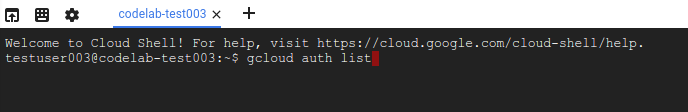

Sau khi kết nối với Cloud Shell, bạn sẽ thấy mình đã được xác thực và dự án đã được đặt thành mã dự án.

Chạy lệnh sau trong Cloud Shell để xác nhận rằng bạn đã được xác thực:

gcloud auth list

Kết quả lệnh

Credentialed Accounts

ACTIVE ACCOUNT

* <my_account>@<my_domain.com>

To set the active account, run:

$ gcloud config set account `ACCOUNT`

Chạy lệnh sau trong Cloud Shell để xác nhận rằng lệnh gcloud biết về dự án của bạn:

gcloud config list project

Kết quả lệnh

[core] project = <PROJECT_ID>

Nếu chưa, bạn có thể thiết lập chế độ này bằng lệnh sau:

gcloud config set project <PROJECT_ID>

Kết quả lệnh

Updated property [core/project].

Cloud Shell có một số biến môi trường, trong đó có GOOGLE_CLOUD_PROJECT chứa tên của dự án Cloud hiện tại của chúng tôi. Chúng tôi sẽ dùng dữ liệu này ở nhiều vị trí trong phòng thí nghiệm này. Bạn có thể xem chỉ số này bằng cách chạy:

echo $GOOGLE_CLOUD_PROJECT

Bước 2: Bật API

Trong các bước sau, bạn sẽ biết những dịch vụ này cần thiết ở đâu (và vì sao). Tuy nhiên, bây giờ, hãy chạy lệnh này để cấp cho dự án của bạn quyền truy cập vào các dịch vụ Compute Engine, Container Registry và Vertex AI:

gcloud services enable compute.googleapis.com \

containerregistry.googleapis.com \

aiplatform.googleapis.com

Thao tác này sẽ tạo ra một thông báo thành công tương tự như thông báo sau:

Operation "operations/acf.cc11852d-40af-47ad-9d59-477a12847c9e" finished successfully.

Bước 3: Tạo một bộ chứa trong Cloud Storage

Để chạy công việc huấn luyện trên Vertex AI, chúng tôi cần có một bộ chứa lưu trữ để lưu trữ những thành phần mô hình đã lưu. Chạy các lệnh sau trong thiết bị đầu cuối Cloud Shell của bạn để tạo một bộ chứa:

BUCKET_NAME=gs://$GOOGLE_CLOUD_PROJECT-bucket

gsutil mb -l us-central1 $BUCKET_NAME

Bước 4: Bí danh Python 3

Mã nguồn trong phòng thí nghiệm này sử dụng Python 3. Để đảm bảo bạn sử dụng Python 3 khi chạy các tập lệnh mà bạn sẽ tạo trong phòng thí nghiệm này, hãy tạo một biệt hiệu bằng cách chạy lệnh sau trong Cloud Shell:

alias python=python3

Mô hình mà chúng tôi sẽ huấn luyện và phân phát trong phòng thí nghiệm này được xây dựng dựa trên hướng dẫn này từ các tài liệu TensorFlow. Phần hướng dẫn này sử dụng tập dữ liệu Auto MPG của Kaggle để dự đoán mức tiết kiệm nhiên liệu của xe.

4. Vùng chứa mã huấn luyện

Chúng tôi sẽ gửi công việc đào tạo này cho Vertex bằng cách đặt mã huấn luyện vào vùng chứa Docker và đẩy vùng chứa này vào Google Container Registry. Khi sử dụng phương pháp này, chúng ta có thể huấn luyện một mô hình xây dựng bằng bất kỳ khung nào.

Bước 1: Thiết lập tệp

Để bắt đầu, trên cửa sổ dòng lệnh trong Cloud Shell, hãy chạy các lệnh sau để tạo các tệp cần thiết cho Vùng chứa Docker:

mkdir mpg

cd mpg

touch Dockerfile

mkdir trainer

touch trainer/train.py

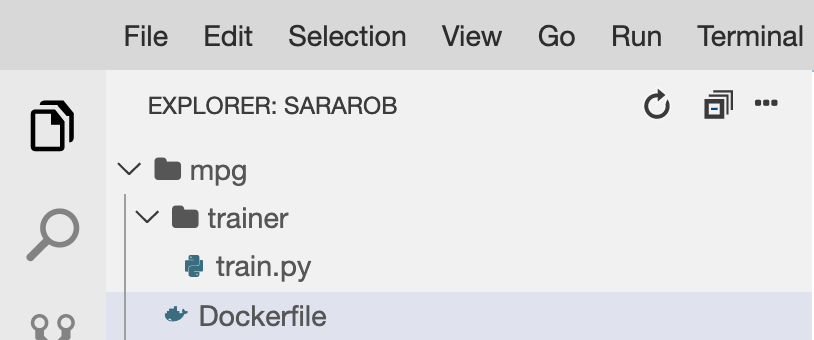

Bây giờ, bạn sẽ có một thư mục mpg/ như sau:

+ Dockerfile

+ trainer/

+ train.py

Để xem và chỉnh sửa các tệp này, chúng ta sẽ sử dụng trình soạn thảo mã tích hợp sẵn của Cloud Shell. Bạn có thể chuyển đổi qua lại giữa trình chỉnh sửa và thiết bị đầu cuối bằng cách nhấp vào nút ở thanh trình đơn trên cùng bên phải trong Cloud Shell:

Bước 2: Tạo một Dockerfile

Để chứa mã của mình, trước tiên, chúng ta sẽ tạo một Dockerfile. Trong Dockerfile, chúng ta sẽ thêm tất cả các lệnh cần thiết để chạy hình ảnh. Thao tác này sẽ cài đặt tất cả các thư viện mà chúng ta đang sử dụng và thiết lập điểm truy cập cho mã huấn luyện của chúng ta.

Trong trình chỉnh sửa tệp Cloud Shell, hãy mở thư mục mpg/ rồi nhấp đúp để mở Dockerfile:

Sau đó, sao chép các nội dung sau đây vào tệp này:

FROM gcr.io/deeplearning-platform-release/tf2-cpu.2-3

WORKDIR /

# Copies the trainer code to the docker image.

COPY trainer /trainer

# Sets up the entry point to invoke the trainer.

ENTRYPOINT ["python", "-m", "trainer.train"]

Dockerfile này sử dụng hình ảnh Docker của Deep Learning Container TensorFlow Enterprise 2.3. Các vùng chứa học sâu trên Google Cloud được cài đặt sẵn nhiều khung phổ biến của công nghệ học máy và khoa học dữ liệu. Phiên bản chúng tôi đang sử dụng gồm có TF Enterprise 2.3, Gấu trúc, Scikit-learn và các phiên bản khác. Sau khi tải hình ảnh đó xuống, Dockerfile này sẽ thiết lập điểm nhập cho mã huấn luyện mà chúng ta sẽ thêm trong bước tiếp theo.

Bước 3: Thêm mã huấn luyện mô hình

Trong trình chỉnh sửa Cloud Shell, tiếp theo, hãy mở tệp train.py rồi sao chép mã bên dưới (mã này được điều chỉnh từ hướng dẫn trong các tài liệu về TensorFlow).

# This will be replaced with your bucket name after running the `sed` command in the tutorial

BUCKET = "BUCKET_NAME"

import numpy as np

import pandas as pd

import pathlib

import tensorflow as tf

from tensorflow import keras

from tensorflow.keras import layers

print(tf.__version__)

"""## The Auto MPG dataset

The dataset is available from the [UCI Machine Learning Repository](https://archive.ics.uci.edu/ml/).

### Get the data

First download the dataset.

"""

"""Import it using pandas"""

dataset_path = "https://storage.googleapis.com/io-vertex-codelab/auto-mpg.csv"

dataset = pd.read_csv(dataset_path, na_values = "?")

dataset.tail()

"""### Clean the data

The dataset contains a few unknown values.

"""

dataset.isna().sum()

"""To keep this initial tutorial simple drop those rows."""

dataset = dataset.dropna()

"""The `"origin"` column is really categorical, not numeric. So convert that to a one-hot:"""

dataset['origin'] = dataset['origin'].map({1: 'USA', 2: 'Europe', 3: 'Japan'})

dataset = pd.get_dummies(dataset, prefix='', prefix_sep='')

dataset.tail()

"""### Split the data into train and test

Now split the dataset into a training set and a test set.

We will use the test set in the final evaluation of our model.

"""

train_dataset = dataset.sample(frac=0.8,random_state=0)

test_dataset = dataset.drop(train_dataset.index)

"""### Inspect the data

Have a quick look at the joint distribution of a few pairs of columns from the training set.

Also look at the overall statistics:

"""

train_stats = train_dataset.describe()

train_stats.pop("mpg")

train_stats = train_stats.transpose()

train_stats

"""### Split features from labels

Separate the target value, or "label", from the features. This label is the value that you will train the model to predict.

"""

train_labels = train_dataset.pop('mpg')

test_labels = test_dataset.pop('mpg')

"""### Normalize the data

Look again at the `train_stats` block above and note how different the ranges of each feature are.

It is good practice to normalize features that use different scales and ranges. Although the model *might* converge without feature normalization, it makes training more difficult, and it makes the resulting model dependent on the choice of units used in the input.

Note: Although we intentionally generate these statistics from only the training dataset, these statistics will also be used to normalize the test dataset. We need to do that to project the test dataset into the same distribution that the model has been trained on.

"""

def norm(x):

return (x - train_stats['mean']) / train_stats['std']

normed_train_data = norm(train_dataset)

normed_test_data = norm(test_dataset)

"""This normalized data is what we will use to train the model.

Caution: The statistics used to normalize the inputs here (mean and standard deviation) need to be applied to any other data that is fed to the model, along with the one-hot encoding that we did earlier. That includes the test set as well as live data when the model is used in production.

## The model

### Build the model

Let's build our model. Here, we'll use a `Sequential` model with two densely connected hidden layers, and an output layer that returns a single, continuous value. The model building steps are wrapped in a function, `build_model`, since we'll create a second model, later on.

"""

def build_model():

model = keras.Sequential([

layers.Dense(64, activation='relu', input_shape=[len(train_dataset.keys())]),

layers.Dense(64, activation='relu'),

layers.Dense(1)

])

optimizer = tf.keras.optimizers.RMSprop(0.001)

model.compile(loss='mse',

optimizer=optimizer,

metrics=['mae', 'mse'])

return model

model = build_model()

"""### Inspect the model

Use the `.summary` method to print a simple description of the model

"""

model.summary()

"""Now try out the model. Take a batch of `10` examples from the training data and call `model.predict` on it.

It seems to be working, and it produces a result of the expected shape and type.

### Train the model

Train the model for 1000 epochs, and record the training and validation accuracy in the `history` object.

Visualize the model's training progress using the stats stored in the `history` object.

This graph shows little improvement, or even degradation in the validation error after about 100 epochs. Let's update the `model.fit` call to automatically stop training when the validation score doesn't improve. We'll use an *EarlyStopping callback* that tests a training condition for every epoch. If a set amount of epochs elapses without showing improvement, then automatically stop the training.

You can learn more about this callback [here](https://www.tensorflow.org/api_docs/python/tf/keras/callbacks/EarlyStopping).

"""

model = build_model()

EPOCHS = 1000

# The patience parameter is the amount of epochs to check for improvement

early_stop = keras.callbacks.EarlyStopping(monitor='val_loss', patience=10)

early_history = model.fit(normed_train_data, train_labels,

epochs=EPOCHS, validation_split = 0.2,

callbacks=[early_stop])

# Export model and save to GCS

model.save(BUCKET + '/mpg/model')

Sau khi bạn sao chép mã ở trên vào tệp mpg/trainer/train.py, hãy quay lại cửa sổ dòng lệnh trong Cloud Shell và chạy lệnh sau để thêm tên bộ chứa của riêng bạn vào tệp:

sed -i "s|BUCKET_NAME|$BUCKET_NAME|g" trainer/train.py

Bước 4: Tạo và kiểm thử cục bộ vùng chứa

Từ cửa sổ dòng lệnh, hãy chạy lệnh sau để xác định một biến bằng URI của hình ảnh vùng chứa của bạn trong Google Container Registry:

IMAGE_URI="gcr.io/$GOOGLE_CLOUD_PROJECT/mpg:v1"

Sau đó, hãy tạo vùng chứa bằng cách chạy lệnh sau từ gốc của thư mục mpg:

docker build ./ -t $IMAGE_URI

Sau khi bạn tạo xong vùng chứa, hãy đẩy vùng chứa đó vào Google Container Registry:

docker push $IMAGE_URI

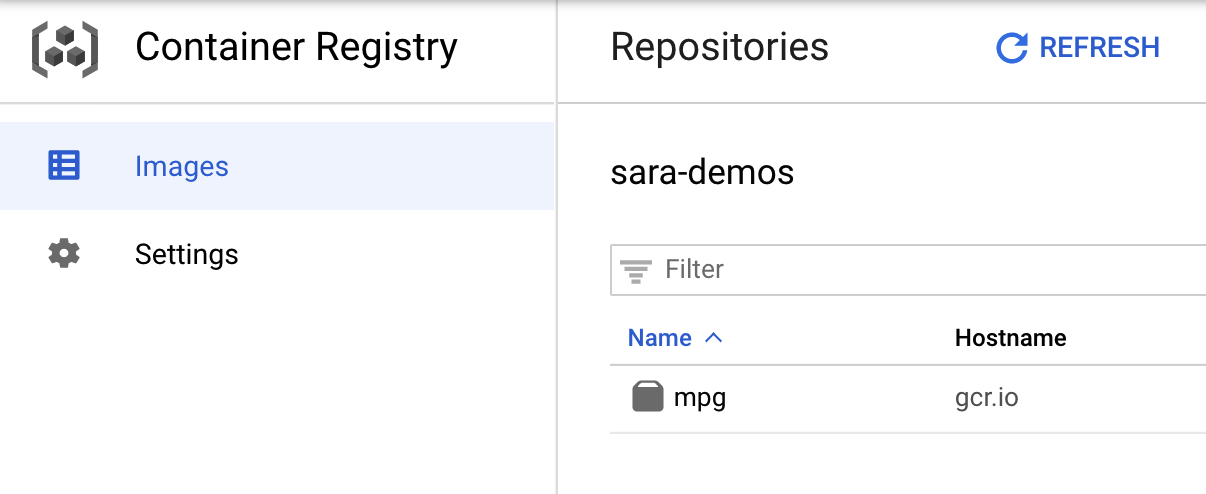

Để xác minh rằng hình ảnh của bạn đã được đẩy vào Container Registry, bạn sẽ thấy nội dung tương tự như sau khi chuyển đến mục Đăng ký vùng chứa trong bảng điều khiển của mình:

Với vùng chứa của chúng tôi được đẩy vào Container Registry, giờ đây chúng tôi đã sẵn sàng bắt đầu công việc huấn luyện mô hình tuỳ chỉnh.

5. Chạy công việc huấn luyện trên Vertex AI

Vertex cung cấp cho bạn 2 lựa chọn về các mô hình huấn luyện:

- AutoML: Đào tạo các mô hình chất lượng cao mà không cần nhiều công sức và kiến thức chuyên môn về máy học.

- Đào tạo tuỳ chỉnh: Chạy các ứng dụng huấn luyện tuỳ chỉnh trên đám mây bằng một trong các vùng chứa tích hợp sẵn của Google Cloud hoặc sử dụng vùng chứa của riêng bạn.

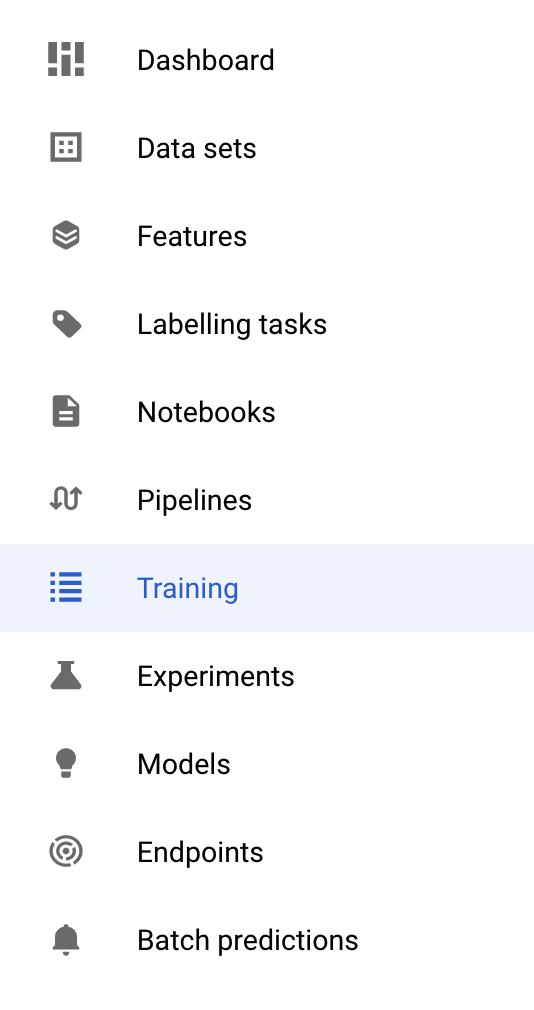

Trong phòng thí nghiệm này, chúng tôi đang sử dụng chương trình đào tạo tuỳ chỉnh thông qua vùng chứa tuỳ chỉnh của riêng mình trên Google Container Registry. Để bắt đầu, hãy chuyển đến phần Đào tạo trong phần Vertex của Cloud Console:

Bước 1: Bắt đầu công việc đào tạo

Nhấp vào Tạo để nhập các thông số cho công việc huấn luyện và mô hình đã triển khai:

- Trong mục Tập dữ liệu, hãy chọn Không có tập dữ liệu được quản lý

- Sau đó, hãy chọn Đào tạo tuỳ chỉnh (nâng cao) làm phương pháp đào tạo của bạn rồi nhấp vào Tiếp tục.

- Nhập

mpg(hoặc bất kỳ tên nào mà bạn muốn gọi cho mô hình của mình) cho Tên mô hình - Nhấp vào Tiếp tục

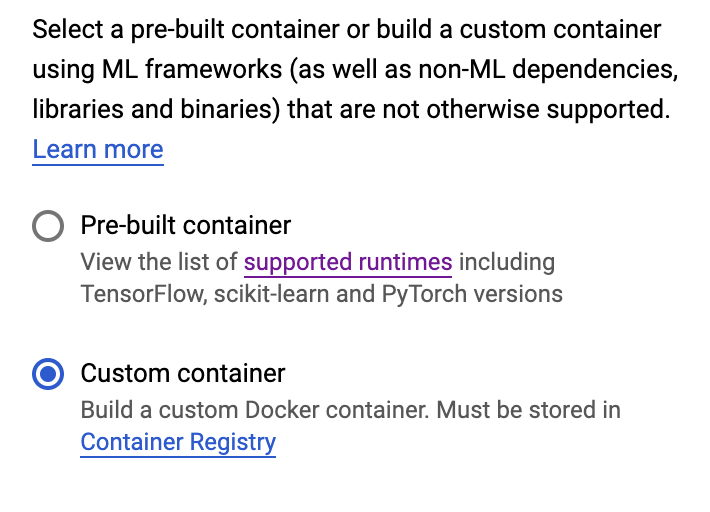

Trong bước Cài đặt vùng chứa, hãy chọn Vùng chứa tuỳ chỉnh:

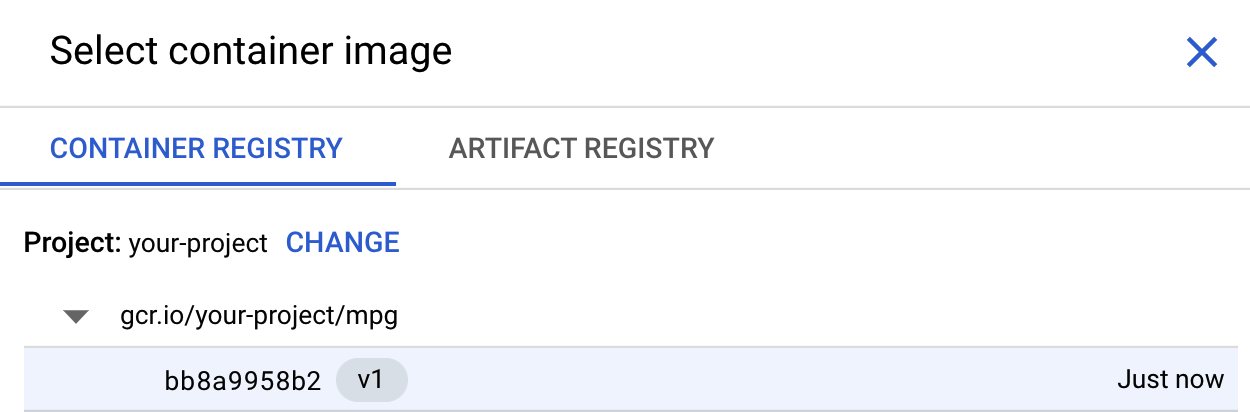

Trong hộp đầu tiên (Hình ảnh vùng chứa), hãy nhấp vào Duyệt qua và tìm vùng chứa mà bạn vừa đẩy vào Đăng ký vùng chứa. Hàm này có dạng như sau:

Để trống các trường còn lại, rồi nhấp vào Tiếp tục.

Chúng tôi sẽ không sử dụng tính năng tinh chỉnh siêu tham số trong hướng dẫn này, do đó, hãy bỏ chọn hộp Bật tính năng điều chỉnh siêu tham số và nhấp vào Tiếp tục.

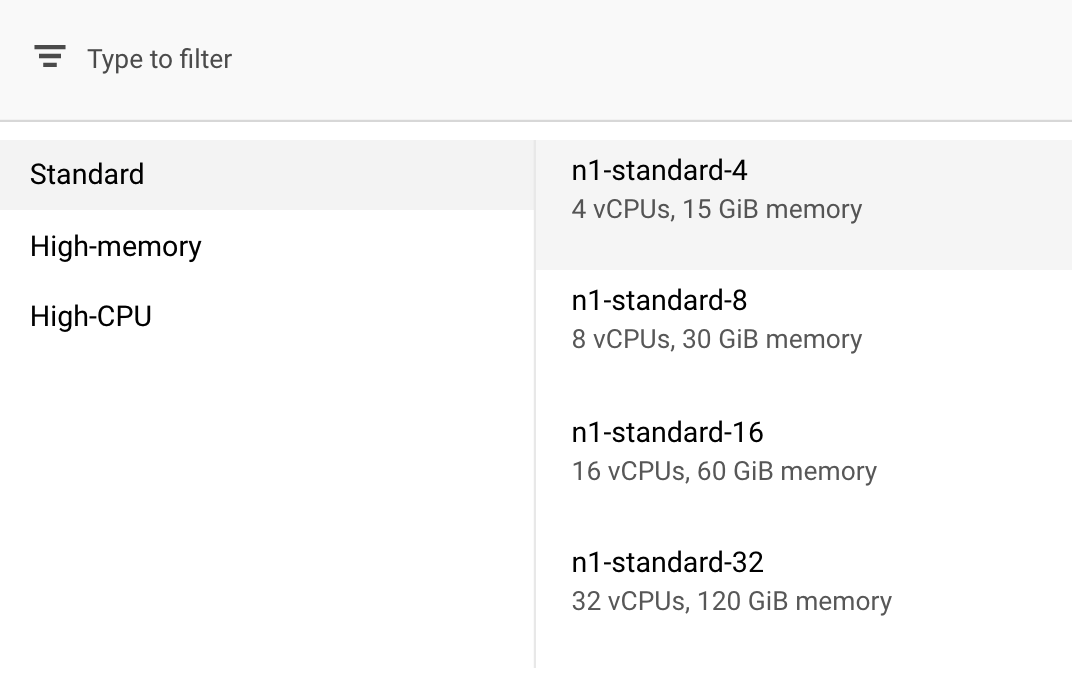

Trong phần Điện toán và định giá, hãy giữ nguyên khu vực đã chọn rồi chọn n1-standard-4 làm loại máy của bạn:

Vì mô hình trong bản minh hoạ này huấn luyện nhanh nên chúng ta sẽ sử dụng một loại máy nhỏ hơn.

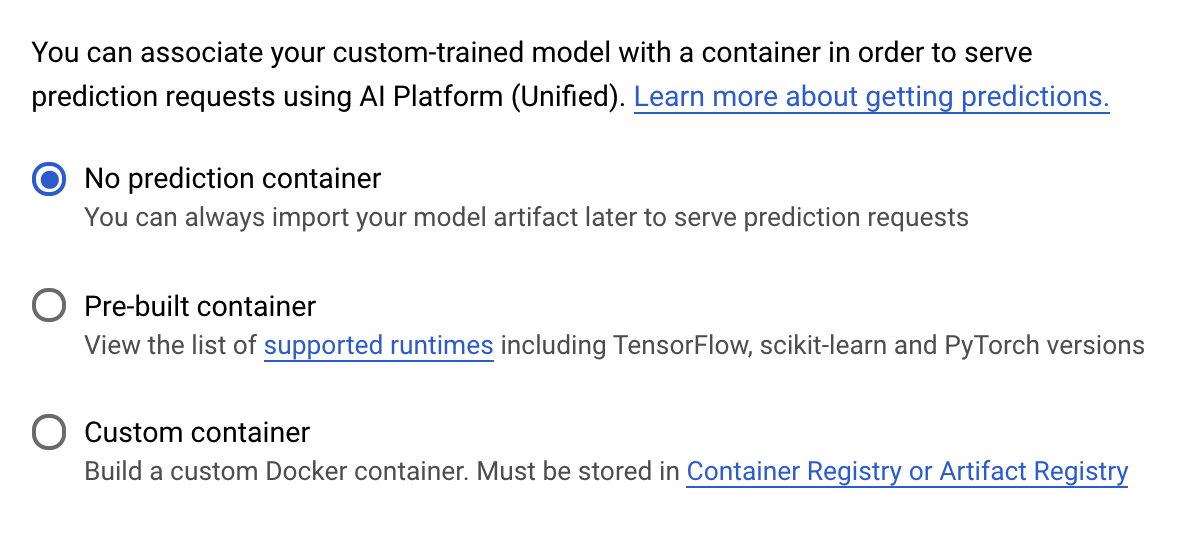

Trong bước Vùng chứa dự đoán, hãy chọn Không có vùng chứa dự đoán:

6. Triển khai điểm cuối của mô hình

Ở bước này, chúng ta sẽ tạo một điểm cuối cho mô hình đã huấn luyện. Chúng ta có thể dùng nền tảng này để nhận thông tin dự đoán về mô hình của mình thông qua Vertex AI API. Để làm việc này, chúng tôi đã tạo phiên bản thành phần mô hình đã huấn luyện đã xuất trong một bộ chứa công khai của GCS.

Trong một tổ chức, thông thường sẽ có một nhóm hoặc cá nhân phụ trách xây dựng mô hình và một nhóm khác phụ trách việc triển khai mô hình đó. Các bước chúng tôi sẽ trình bày ở đây sẽ hướng dẫn bạn cách lấy một mô hình đã được huấn luyện và triển khai mô hình đó để dự đoán.

Ở đây, chúng ta sẽ sử dụng Vertex AI SDK để tạo mô hình, triển khai mô hình đó cho một điểm cuối và nhận thông tin dự đoán.

Bước 1: Cài đặt Vertex SDK

Trên thiết bị đầu cuối Cloud Shell, hãy chạy các bước sau để cài đặt Vertex AI SDK:

pip3 install google-cloud-aiplatform --upgrade --user

Chúng ta có thể dùng SDK này để tương tác với nhiều phần của Vertex.

Bước 2: Tạo mô hình và triển khai điểm cuối

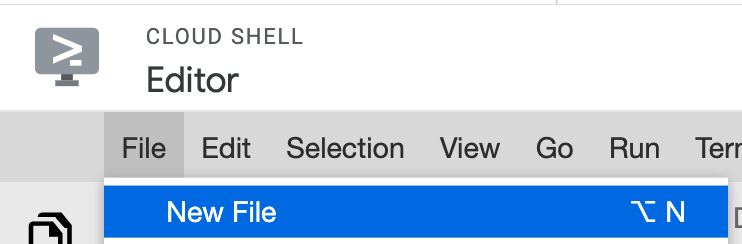

Tiếp theo, chúng ta sẽ tạo một tệp Python và sử dụng SDK để tạo tài nguyên mô hình và triển khai tài nguyên đó đến điểm cuối. Từ trình chỉnh sửa tệp trong Cloud Shell, hãy chọn File (Tệp) rồi chọn New File (Tệp mới):

Đặt tên deploy.py cho tệp. Mở tệp này trong trình chỉnh sửa và sao chép mã sau:

from google.cloud import aiplatform

# Create a model resource from public model assets

model = aiplatform.Model.upload(

display_name="mpg-imported",

artifact_uri="gs://io-vertex-codelab/mpg-model/",

serving_container_image_uri="gcr.io/cloud-aiplatform/prediction/tf2-cpu.2-3:latest"

)

# Deploy the above model to an endpoint

endpoint = model.deploy(

machine_type="n1-standard-4"

)

Tiếp theo, hãy quay lại Terminal trong Cloud Shell, cd quay lại thư mục gốc rồi chạy tập lệnh Python bạn vừa tạo:

cd ..

python3 deploy.py | tee deploy-output.txt

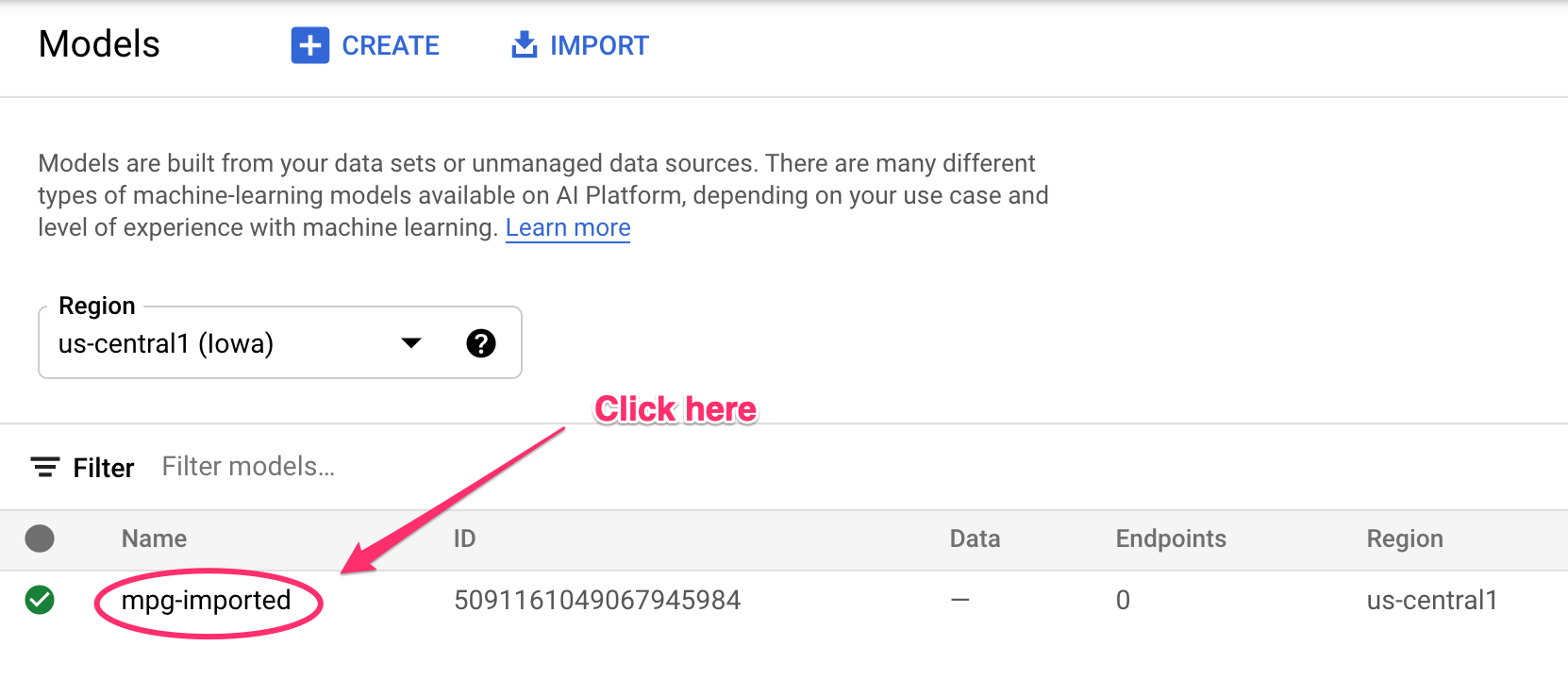

Bạn sẽ thấy các thông tin cập nhật được ghi lại vào thiết bị đầu cuối khi các tài nguyên đang được tạo. Sẽ mất 10-15 phút để chạy. Để đảm bảo bảng điều khiển hoạt động bình thường, hãy chuyển đến phần Mô hình trên bảng điều khiển của bạn trong Vertex AI:

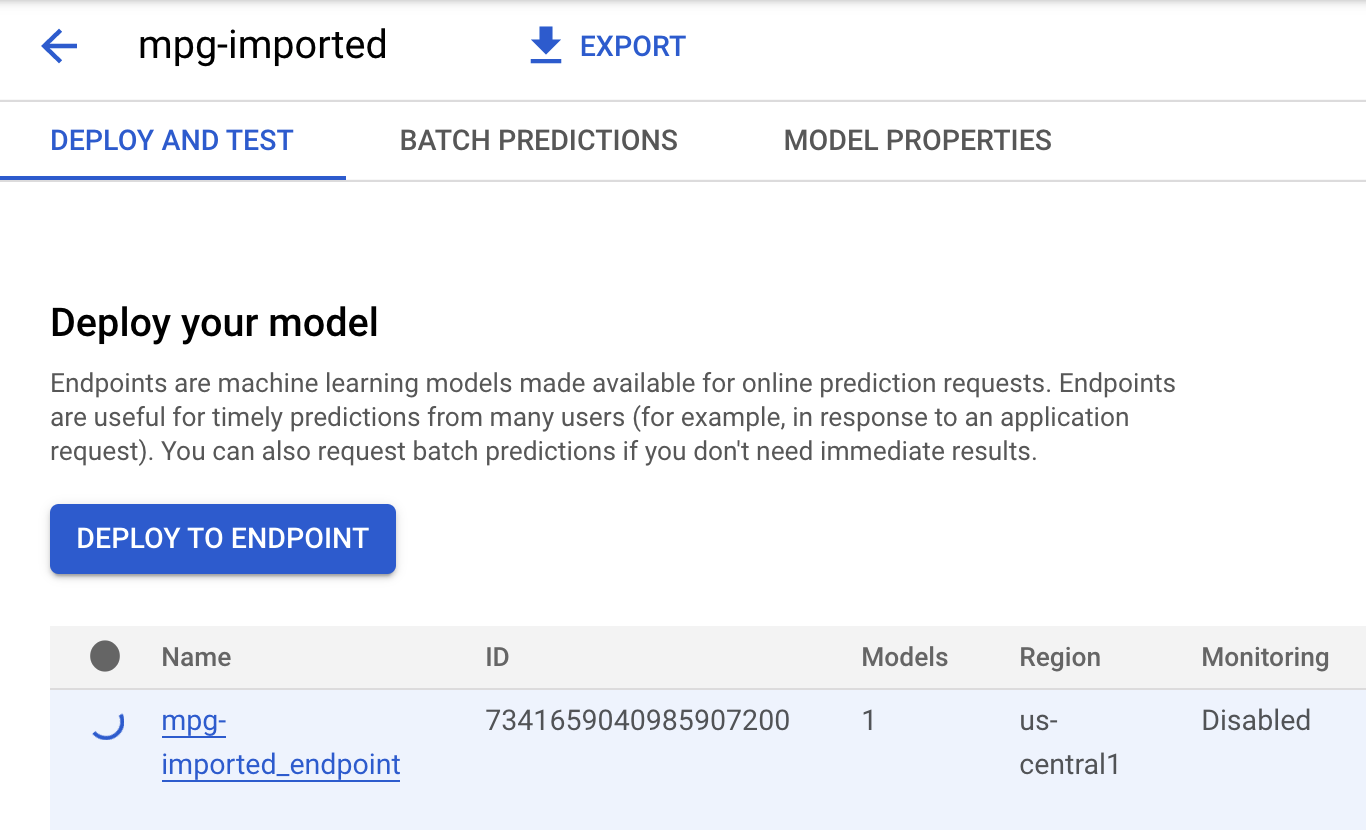

Nhấp vào mgp-imported và bạn sẽ thấy điểm cuối cho mô hình đó đang được tạo:

Trong Cloud Shell Terminal, bạn sẽ thấy nội dung tương tự như nhật ký sau đây khi quá trình triển khai điểm cuối hoàn tất:

Endpoint model deployed. Resource name: projects/your-project-id/locations/us-central1/endpoints/your-endpoint-id

Bạn sẽ dùng tính năng này trong bước tiếp theo để nhận thông tin dự đoán về nội dung bạn đã triển khai.

Bước 3: Nhận thông tin dự đoán về điểm cuối đã triển khai

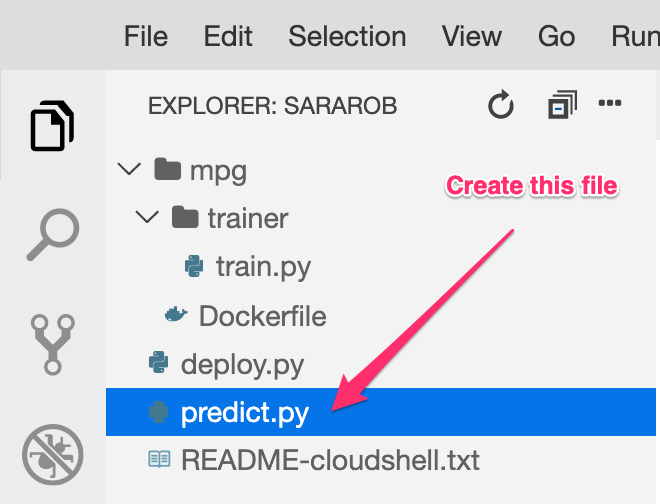

Trong trình chỉnh sửa Cloud Shell, hãy tạo một tệp mới có tên là predict.py:

Mở predict.py rồi dán mã sau vào đó:

from google.cloud import aiplatform

endpoint = aiplatform.Endpoint(

endpoint_name="ENDPOINT_STRING"

)

# A test example we'll send to our model for prediction

test_mpg = [1.4838871833555929,

1.8659883497083019,

2.234620276849616,

1.0187816540094903,

-2.530890710602246,

-1.6046416850441676,

-0.4651483719733302,

-0.4952254087173721,

0.7746763768735953]

response = endpoint.predict([test_mpg])

print('API response: ', response)

print('Predicted MPG: ', response.predictions[0][0])

Tiếp theo, hãy quay lại Terminal và nhập nội dung sau để thay thế ENDPOINT_STRING trong tệp dự đoán bằng điểm cuối của riêng bạn:

ENDPOINT=$(cat deploy-output.txt | sed -nre 's:.*Resource name\: (.*):\1:p' | tail -1)

sed -i "s|ENDPOINT_STRING|$ENDPOINT|g" predict.py

Đã đến lúc chạy tệp predict.py để nhận thông tin dự đoán từ điểm cuối của mô hình đã triển khai:

python3 predict.py

Bạn sẽ thấy phản hồi của API được ghi lại, cùng với hiệu suất nhiên liệu dự đoán cho thông tin dự đoán về thử nghiệm của chúng tôi.

🎉 Xin chúc mừng! 🎉

Bạn đã tìm hiểu cách sử dụng Vertex AI để:

- Huấn luyện mô hình bằng cách cung cấp mã huấn luyện trong vùng chứa tuỳ chỉnh. Bạn đã sử dụng một mô hình TensorFlow trong ví dụ này, nhưng bạn có thể huấn luyện một mô hình được xây dựng với bất kỳ khung nào bằng cách sử dụng các vùng chứa tuỳ chỉnh.

- Triển khai mô hình TensorFlow bằng vùng chứa tạo sẵn trong quy trình công việc mà bạn dùng để huấn luyện.

- Tạo điểm cuối của mô hình và tạo thông tin dự đoán.

Để tìm hiểu thêm về các phần khác nhau của Vertex AI, hãy xem tài liệu này. Nếu muốn xem kết quả của công việc đào tạo mà bạn đã bắt đầu ở Bước 5, hãy chuyển đến phần huấn luyện trên bảng điều khiển Vertex.

7. Dọn dẹp

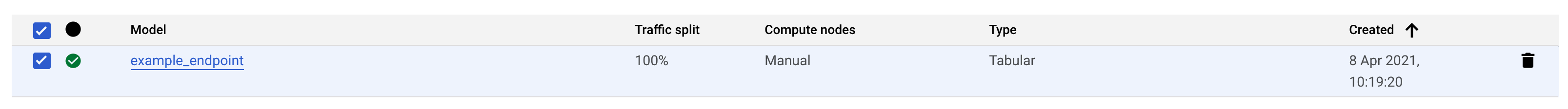

Để xoá điểm cuối bạn đã triển khai, hãy chuyển đến phần Điểm cuối trong bảng điều khiển Vertex rồi nhấp vào biểu tượng xoá:

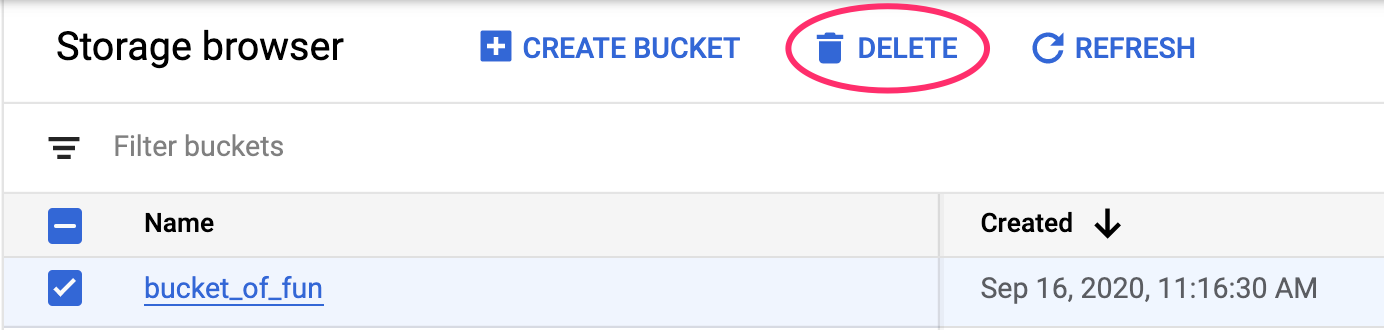

Để xoá Bộ chứa Storage, hãy sử dụng trình đơn Điều hướng trong Cloud Console, duyệt đến Bộ nhớ, chọn bộ chứa rồi nhấp vào Xoá: