1. Introdução

Observação: este codelab requer um dispositivo físico para testar.

O TensorFlow é um framework de machine learning de várias finalidades. É possível usá-lo de várias formas, incluindo para treinar modelos grandes em clusters do Cloud e executar modelos localmente em um sistema incorporado, como seu smartphone.

Este codelab usa o TensorFlow Lite para executar um modelo de reconhecimento de imagem em um dispositivo Android.

Instalar o Android Studio 4.1 ou mais recente

Se você ainda não tiver o Android Studio instalado, faça o download e instale o Android Studio 4.1 ou mais recente enquanto treina o modelo do TensorFlow Lite.

O que você vai aprender

- Como treinar seu próprio classificador de imagens personalizado usando o TensorFlow Lite Model Maker.

- Como usar o Android Studio para importar o modelo do TensorFlow Lite e integrar o modelo personalizado em um app Android usando o CameraX.

- Como usar a GPU no smartphone para acelerar o modelo.

O que você criará

Um app de câmera simples que executa um programa de reconhecimento de imagens do TensorFlow para identificar flores.

Licença: Uso sem custo financeiro

2. Treinar um reconhecedor de flores usando o Colab

Antes de iniciar o treinamento do modelo, comece a fazer o download e a instalação do Android Studio 4.1 ou mais recente.

Abra o Colab, que mostra como treinar um classificador com Keras para reconhecer flores usando o aprendizado de transferência do TensorFlow Lite.

3. Configurar o diretório de trabalho

Clonar o repositório Git

O comando abaixo clona o repositório do Git que contém os arquivos necessários para este codelab:

git clone https://github.com/hoitab/TFLClassify.git

Em seguida, acesse o diretório em que você clonou o repositório. É aqui que você vai trabalhar pelo resto deste codelab:

cd TFLClassify

4. Configurar o app de esqueleto Android

Instalar o Android Studio 4.1 ou mais recente

Se você ainda não tiver o Android Studio, instale o Android Studio 4.1 ou mais recente.

Abrir o projeto com o Android Studio

Abra um projeto com o Android Studio seguindo estas etapas:

- Abra o Android Studio

. Depois que ele for carregado, selecione "Abrir um projeto existente" neste pop-up:

. Depois que ele for carregado, selecione "Abrir um projeto existente" neste pop-up:

- No seletor de arquivos, escolha

TFLClassify/build.gradleno diretório de trabalho.

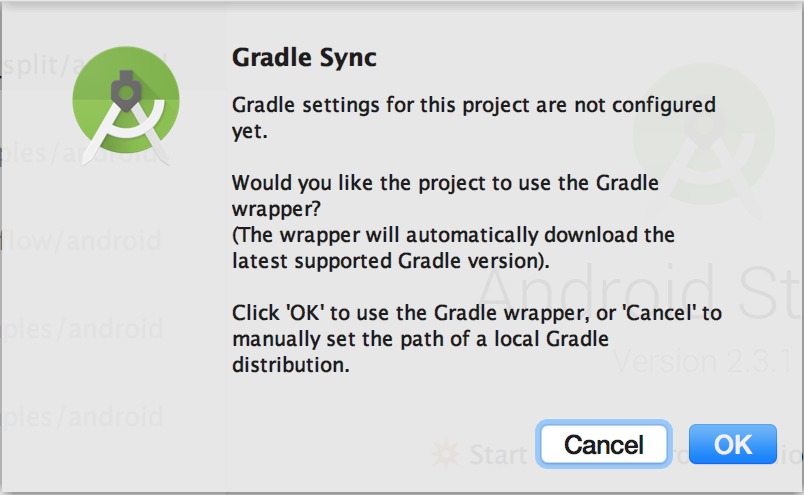

- Na primeira vez que você abrir o projeto, vai aparecer um pop-up "Sincronização do Gradle" perguntando sobre o uso do wrapper do Gradle. Clique em "OK".

- Ative o modo de desenvolvedor e a depuração USB no smartphone, se ainda não tiver feito isso. Essa é uma configuração única. Siga estas instruções.

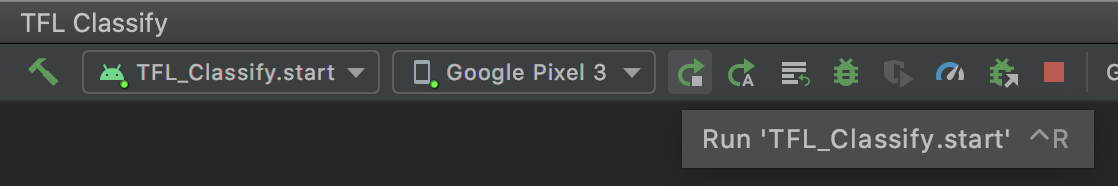

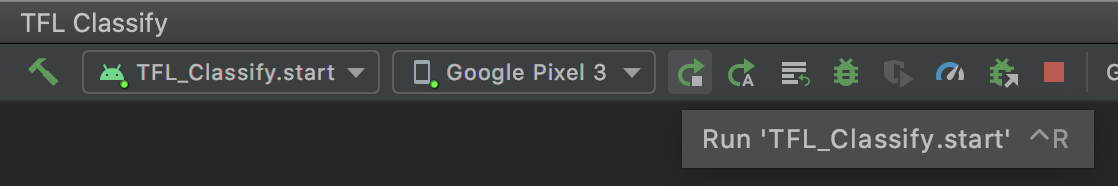

- Quando o projeto e o smartphone estiverem prontos, você poderá executar o projeto em um dispositivo real selecionando

TFL_Classify.starte pressionando o botão de execução na barra de ferramentas:

na barra de ferramentas:

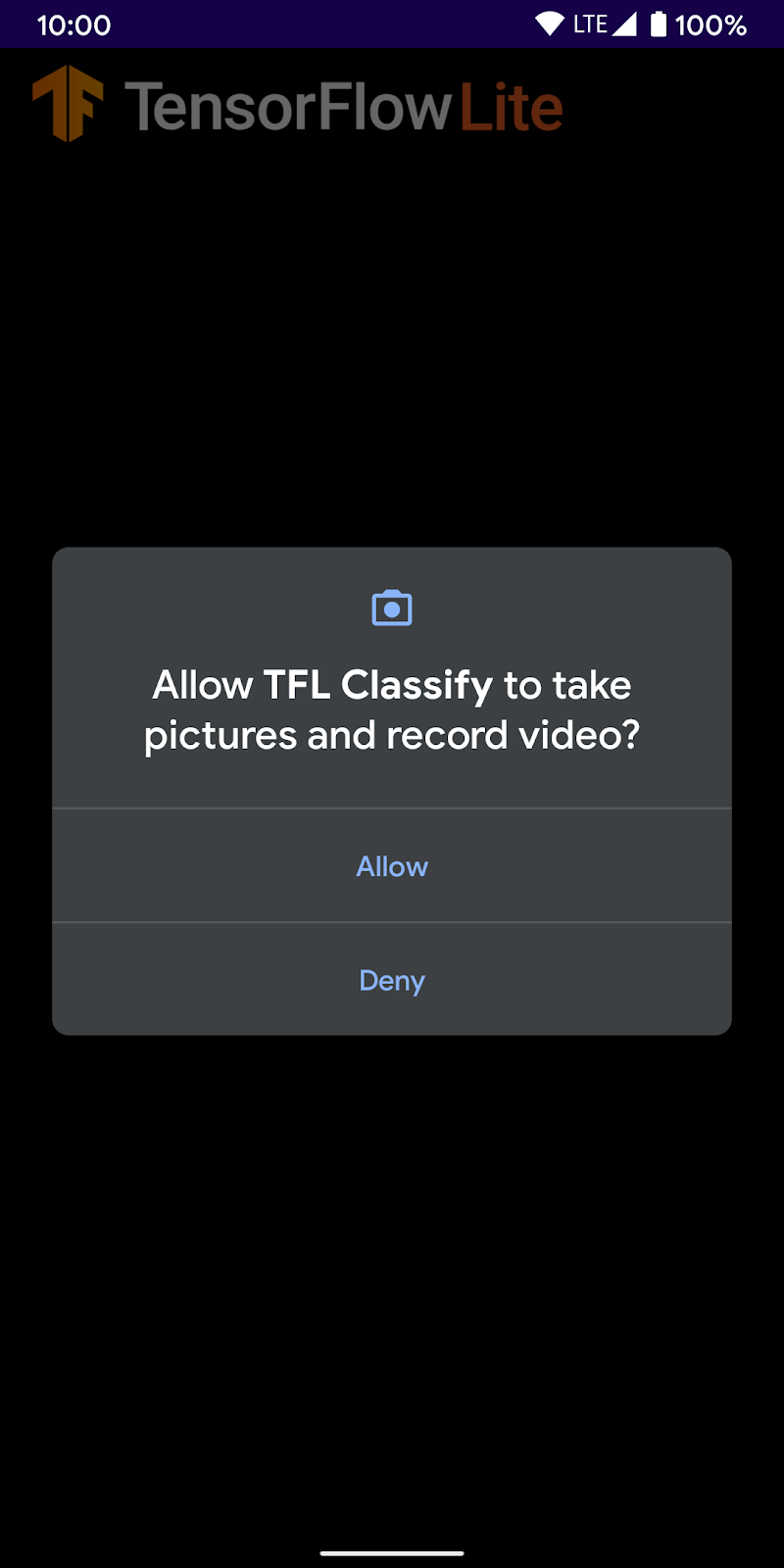

- Agora, permita que a demonstração do Tensorflow acesse sua câmera:

- A tela a seguir vai aparecer no seu smartphone, com números aleatórios no lugar onde os resultados reais vão aparecer.

5. Adicionar o TensorFlow Lite ao app Android

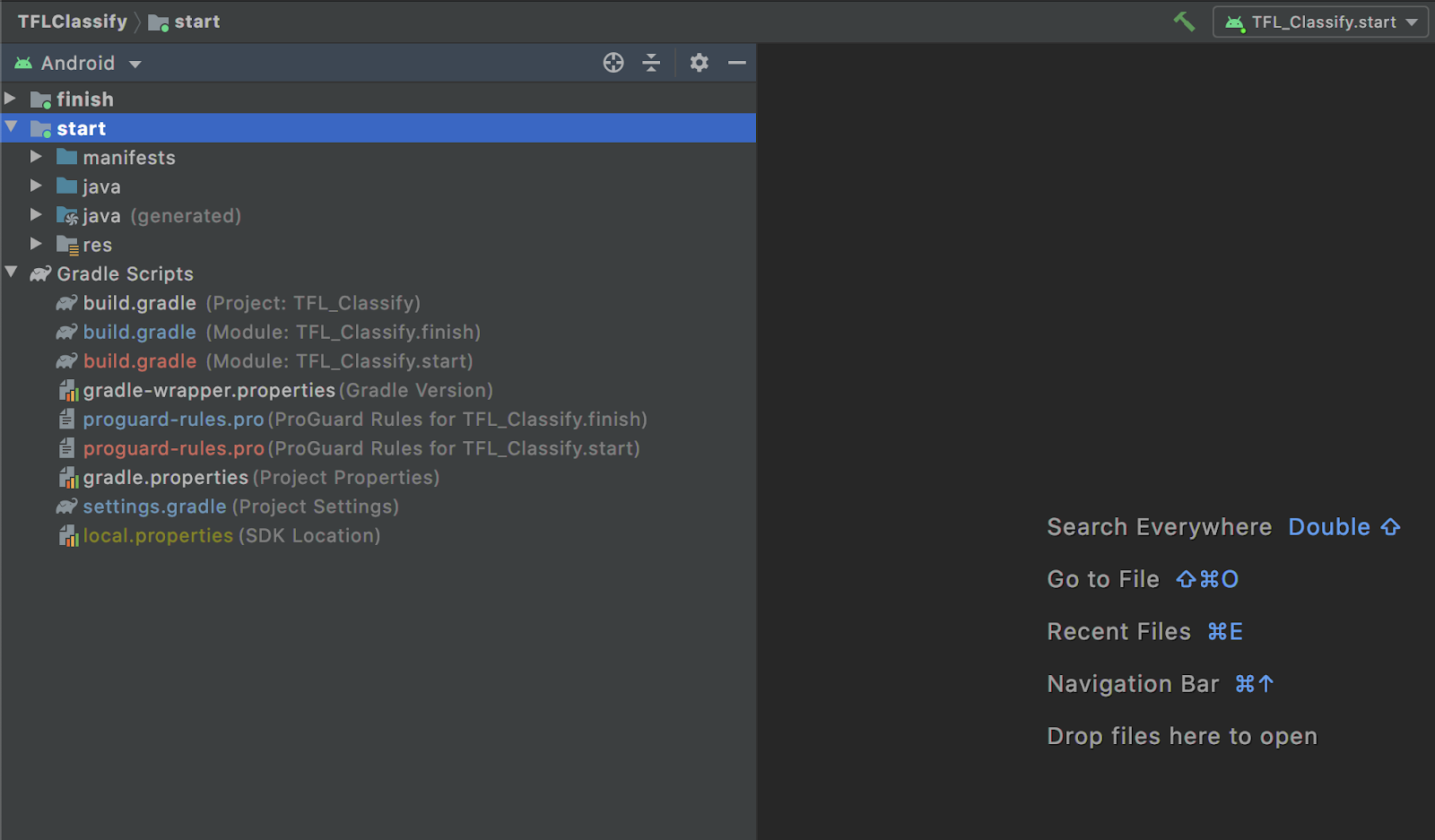

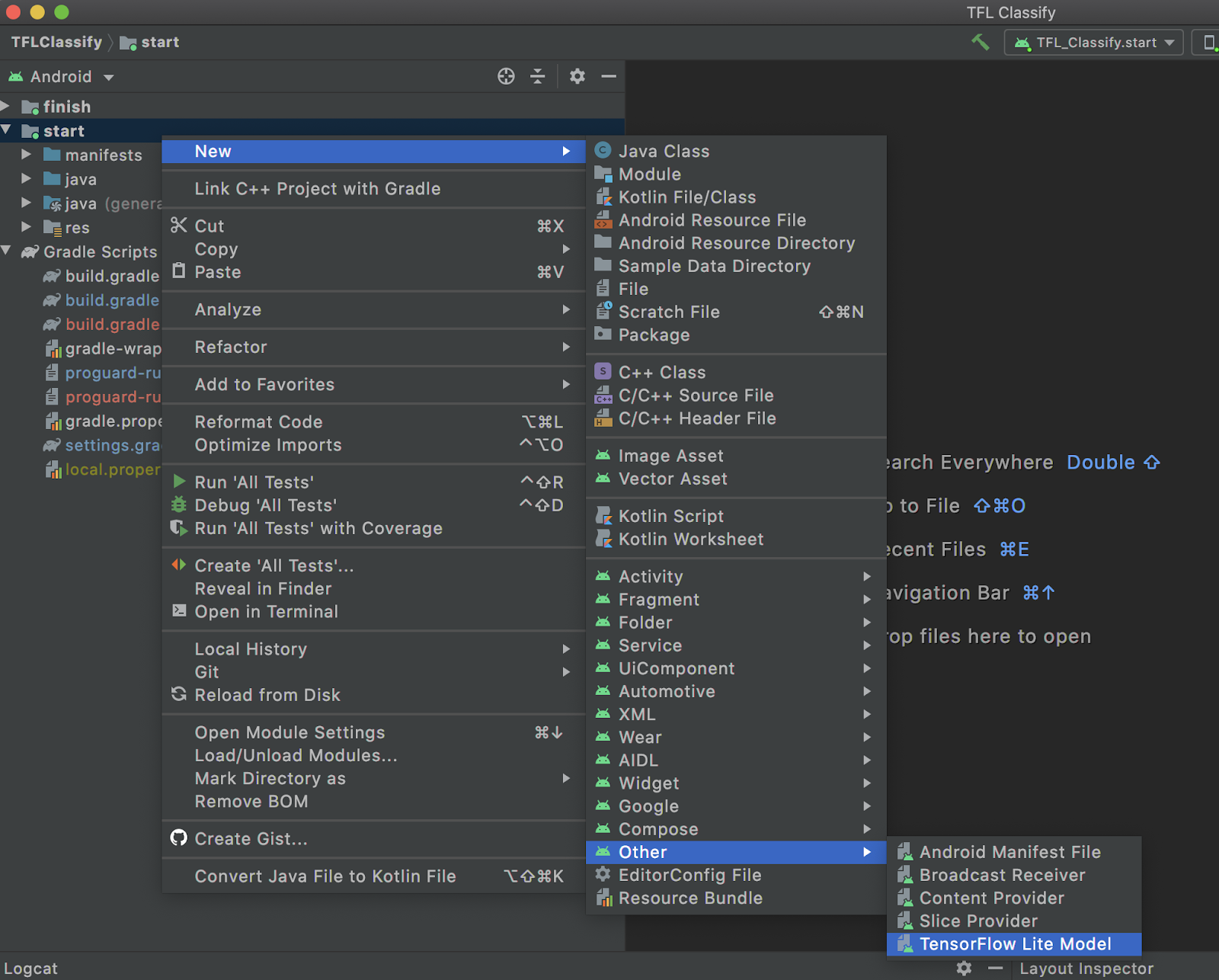

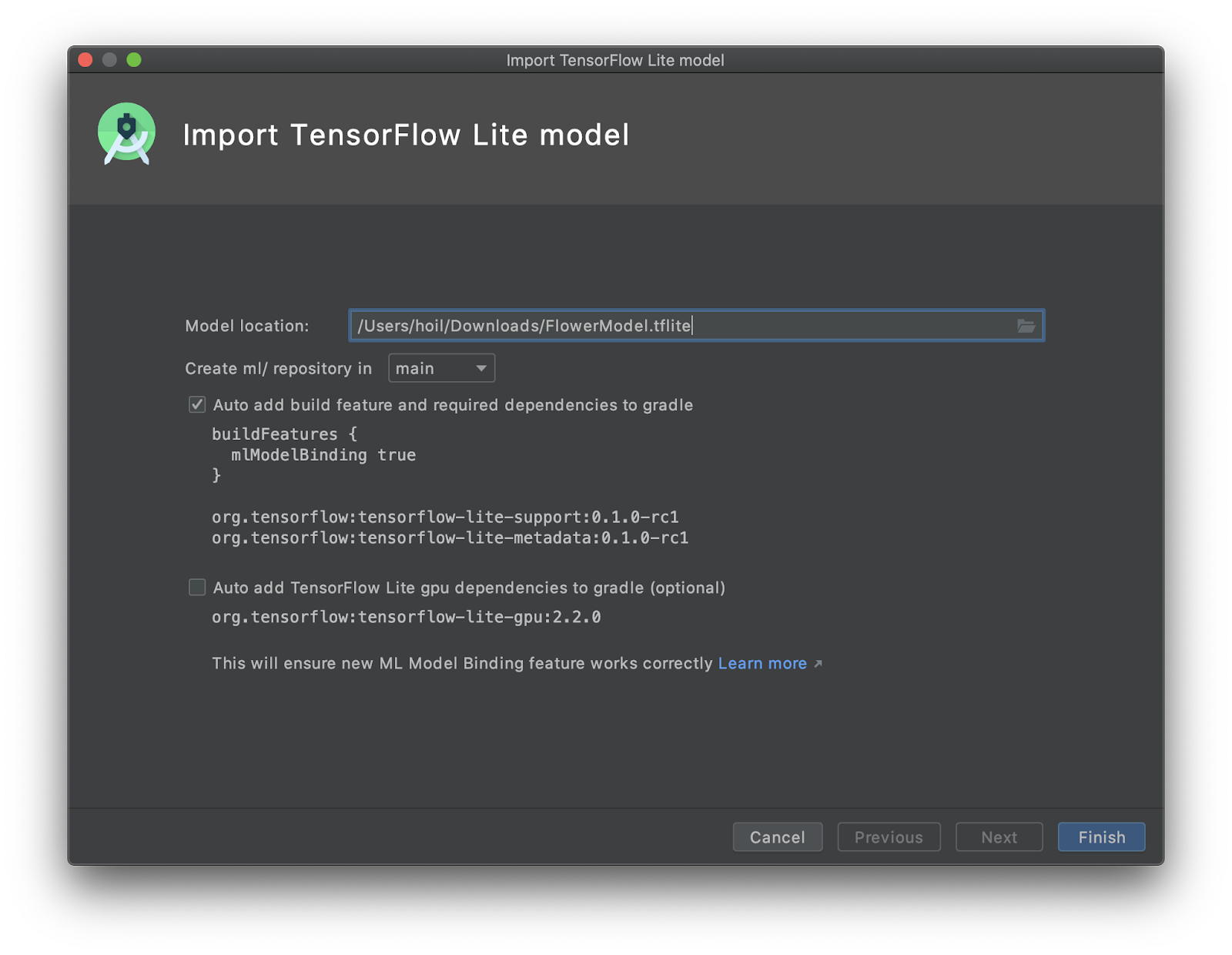

- Selecione o módulo

startno Project Explorer à esquerda:

- Clique com o botão direito do mouse no módulo

startou clique emFilee depois emNew>Other>TensorFlow Lite Model.

- Selecione o local do modelo em que você fez o download do

FlowerModel.tflitetreinado anteriormente.

- Clique em

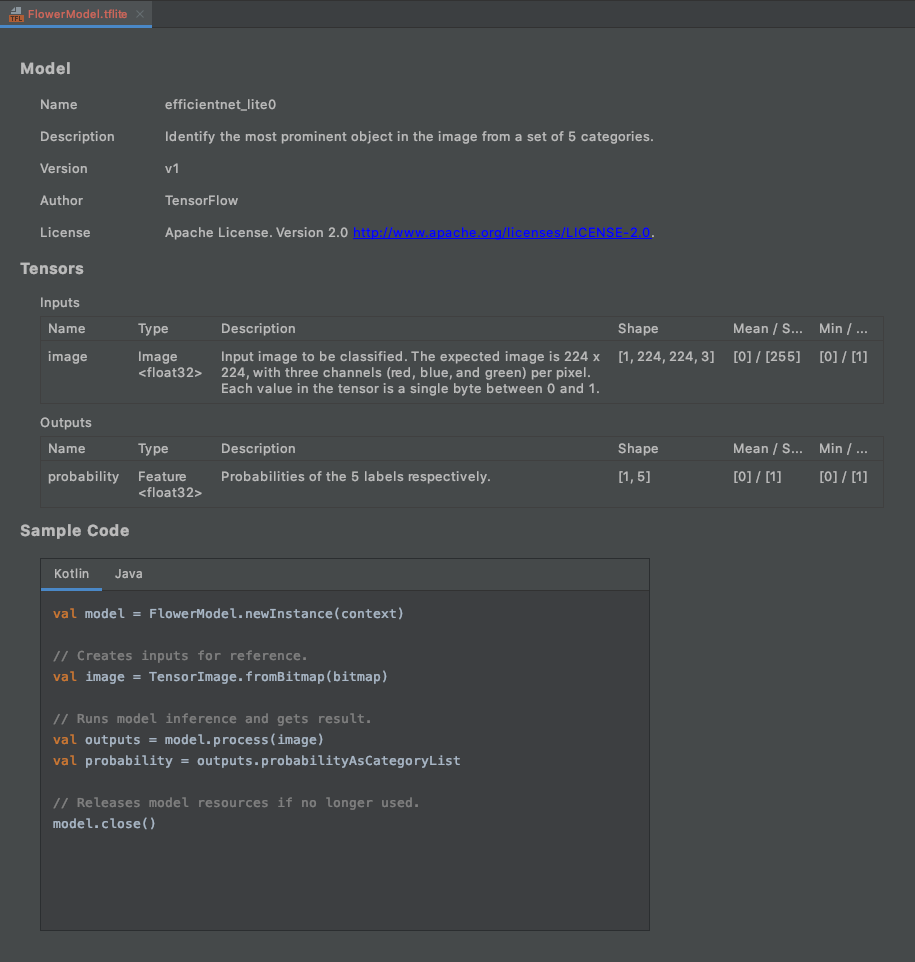

Finish. - Você vai ver o seguinte no final. O FlowerModel.tflite é importado e mostra informações gerais sobre o modelo, incluindo a entrada / saída e alguns códigos de exemplo para você começar.

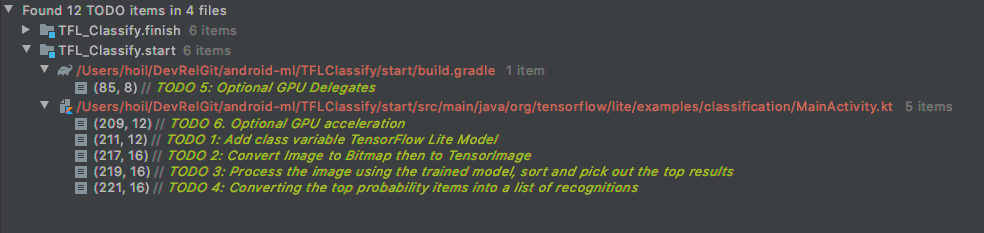

6. Opcional: verificar a lista de tarefas

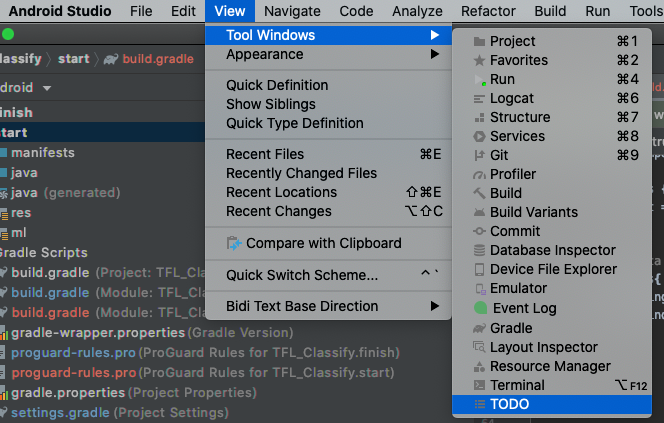

A lista de tarefas facilita a navegação até o local exato em que você precisa atualizar o codelab. Você também pode usá-lo no seu projeto Android para se lembrar do trabalho futuro. É possível adicionar itens de tarefas usando comentários de código e digitando a palavra-chave TODO. Para acessar a lista de tarefas, você pode:

- Uma ótima maneira de saber o que vamos fazer é conferir a lista de tarefas. Para fazer isso, selecione na barra de menus de cima

View>Tool Windows>TODO

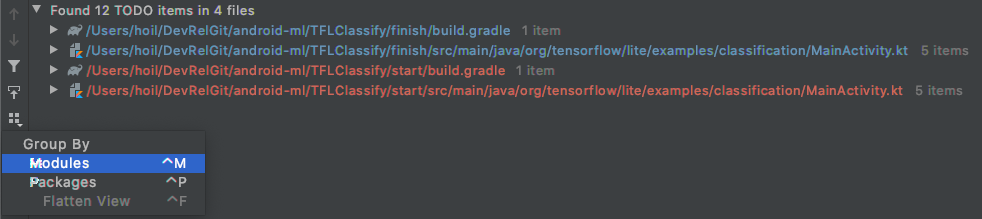

- Por padrão, ele lista todos os TODOs em todos os módulos, o que torna a tarefa um pouco confusa. Podemos classificar apenas as tarefas a serem iniciadas clicando no botão "Agrupar por" ao lado do painel "A fazer" e escolher

Modules.

- Abra todos os itens nos módulos de início:

7. Executar o modelo personalizado com o TensorFlow Lite

- Clique em TODO 1 na lista de TODOs ou abra o arquivo MainActivity.kt e localize TODO 1. Em seguida, inicialize o modelo adicionando esta linha:

private class ImageAnalyzer(ctx: Context, private val listener: RecognitionListener) :

ImageAnalysis.Analyzer {

...

// TODO 1: Add class variable TensorFlow Lite Model

private val flowerModel = FlowerModel.newInstance(ctx)

...

}

- No método de análise do CameraX Analyzer, precisamos converter a entrada da câmera

ImageProxyem umaBitmape criar um objetoTensorImagepara o processo de inferência.

override fun analyze(imageProxy: ImageProxy) {

...

// TODO 2: Convert Image to Bitmap then to TensorImage

val tfImage = TensorImage.fromBitmap(toBitmap(imageProxy))

...

}

- Processe a imagem e realize as seguintes operações no resultado:

- Ordene os resultados em ordem decrescente de probabilidade no atributo

scorecom a maior probabilidade em primeiro lugar. - Use os principais resultados k, conforme definido pela constante

MAX_RESULT_DISPLAY. Você pode variar o valor dessa variável para gerar mais ou menos resultados.

override fun analyze(imageProxy: ImageProxy) {

...

// TODO 3: Process the image using the trained model, sort and pick out the top results

val outputs = flowerModel.process(tfImage)

.probabilityAsCategoryList.apply {

sortByDescending { it.score } // Sort with highest confidence first

}.take(MAX_RESULT_DISPLAY) // take the top results

...

}

- Converta os resultados classificados e filtrados em objetos de dados

Recognitionprontos para serem consumidos porRecyclerViewusando a Vinculação de dados:

override fun analyze(imageProxy: ImageProxy) {

...

// TODO 4: Converting the top probability items into a list of recognitions

for (output in outputs) {

items.add(Recognition(output.label, output.score))

}

...

}

- Comente ou exclua as linhas a seguir, que ajudam a gerar os resultados falsos que vimos antes:

// START - Placeholder code at the start of the codelab. Comment this block of code out.

for (i in 0..MAX_RESULT_DISPLAY-1){

items.add(Recognition("Fake label $i", Random.nextFloat()))

}

// END - Placeholder code at the start of the codelab. Comment this block of code out.

- Para executar o app em um dispositivo real, selecione

TFL_Classify.starte pressione o botão de execução na barra de ferramentas:

na barra de ferramentas:

- A tela a seguir vai aparecer no seu smartphone, com números aleatórios no lugar onde os resultados reais vão aparecer:

8. Opcional: acelerar a inferência com o delegação de GPU

O TensorFlow Lite oferece suporte a vários aceleradores de hardware para acelerar a inferência no seu dispositivo móvel. A GPU é um dos aceleradores que o TensorFlow Lite pode aproveitar com um mecanismo de delegação e é bastante fácil de usar.

- Abra build.gradle no módulo

startou clique em TODO 5 na lista de TODOs e adicione a seguinte dependência:

// TODO 5: Optional GPU Delegates

implementation 'org.tensorflow:tensorflow-lite-gpu:2.3.0'

- Volte para o arquivo MainActivity.kt ou clique em TODO 6 na lista "TODO". Substitua a inicialização simples do flowerModel por esta: extraia uma instância da lista de compatibilidade da GPU e inicialize a GPU dependendo se ela é uma das GPUs compatíveis listadas. Caso contrário, inicie quatro linhas de execução de CPU para executar o modelo:

private class ImageAnalyzer(ctx: Context, private val listener: RecognitionListener) :

ImageAnalysis.Analyzer {

...

// TODO 1: Add class variable TensorFlow Lite Model

// Initializing the flowerModel by lazy so that it runs in the same thread when the process

// method is called.

private val flowerModel: FlowerModel by lazy{

// TODO 6. Optional GPU acceleration

val compatList = CompatibilityList()

val options = if(compatList.isDelegateSupportedOnThisDevice){

Log.d(TAG, "This device is GPU Compatible ")

Model.Options.Builder().setDevice(Model.Device.GPU).build()

} else {

Log.d(TAG, "This device is GPU Incompatible ")

Model.Options.Builder().setNumThreads(4).build()

}

...

}

- Mude o inicializador do modelo para usar isso adicionando

optionsà entrada do método:

private class ImageAnalyzer(ctx: Context, private val listener: RecognitionListener) :

ImageAnalysis.Analyzer {

private val flowerModel: FlowerModel by lazy{

...

// Initialize the Flower Model

FlowerModel.newInstance(ctx, options)

}

}

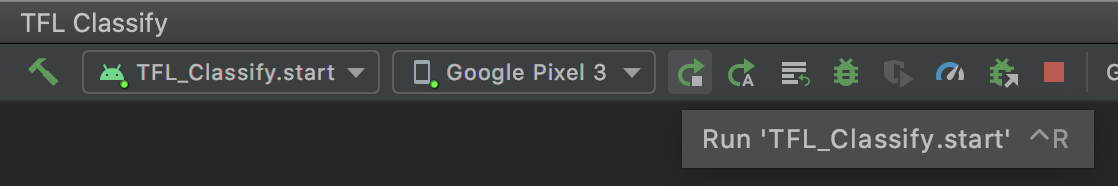

- Para executar o app em um dispositivo real, selecione

TFL_Classify.starte pressione o botão de execução na barra de ferramentas:

na barra de ferramentas:

9. Próximos passos

Confira alguns links para mais informações:

- Teste outros modelos do TFLite compatíveis com a vinculação de modelos de ML do tfhub.dev.

- Saiba mais sobre o TFLite nas documentações do tensorflow.org e do repositório de código (links em inglês).

- Tente usar outros modelos pré-treinados do TFLite, incluindo um detector de hotwords de fala e uma versão de resposta inteligente no dispositivo.

- Saiba mais sobre o TensorFlow em geral nos nossos documentos de primeiros passos.