1. Introduzione

Eventarc semplifica la connessione di vari servizi (Cloud Run, Kubernetes, Workflows) con eventi provenienti da diverse origini. Ti consente di creare architetture basate su eventi in cui i microservizi sono accoppiati in modo lasco e distribuiti. Inoltre, si occupa di importazione, invio, sicurezza, autorizzazione e gestione degli errori degli eventi, il che migliora l'agilità degli sviluppatori e la resilienza delle applicazioni. Consulta il codelab Attiva Cloud Run con eventi da Eventarc per un'introduzione a Eventarc.

In questo codelab utilizzerai Eventarc per leggere gli eventi da Pub/Sub, Cloud Storage e Cloud Audit Logs e trasmetterli a un servizio Kubernetes in esecuzione su Google Kubernetes Engine (GKE).

Obiettivi didattici

- Creare un cluster GKE.

- Crea un servizio GKE come destinazione evento.

- Crea un trigger Pub/Sub.

- Creare un trigger Cloud Storage

- Crea un trigger di Cloud Audit Logs.

2. Configurazione e requisiti

Configurazione dell'ambiente a tuo ritmo

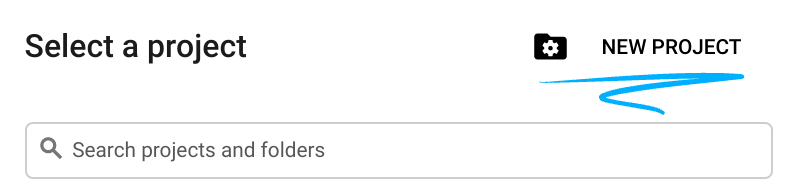

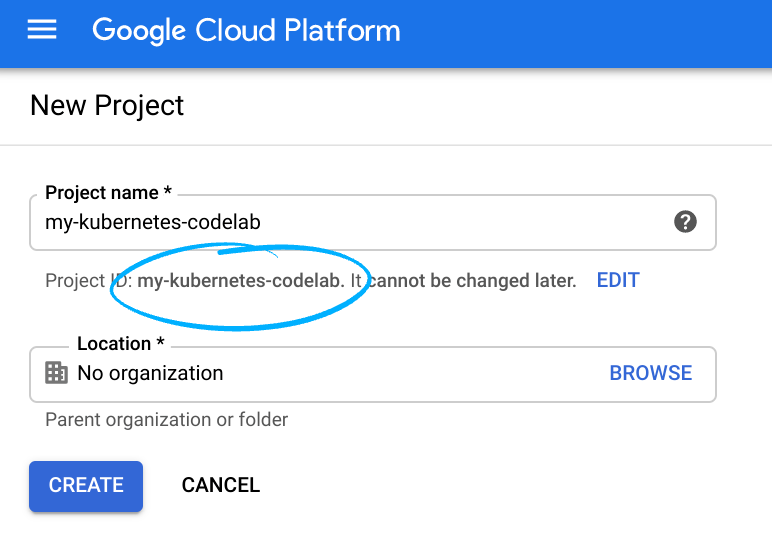

- Accedi alla console Google Cloud e crea un nuovo progetto o riutilizzane uno esistente. Se non hai ancora un account Gmail o Google Workspace, devi crearne uno.

- Il nome del progetto è il nome visualizzato per i partecipanti a questo progetto. Si tratta di una stringa di caratteri non utilizzata dalle API di Google. Puoi aggiornarlo in qualsiasi momento.

- L'ID progetto è univoco per tutti i progetti Google Cloud ed è immutabile (non può essere modificato dopo essere stato impostato). La console Cloud genera automaticamente una stringa univoca; in genere non è importante quale sia. Nella maggior parte dei codelab, dovrai fare riferimento all'ID progetto (in genere identificato come

PROJECT_ID). Se l'ID generato non ti piace, puoi generarne un altro casuale. In alternativa, puoi provare il tuo e vedere se è disponibile. Non può essere modificato dopo questo passaggio e rimarrà invariato per tutta la durata del progetto. - Per tua informazione, esiste un terzo valore, un Numero progetto, utilizzato da alcune API. Scopri di più su tutti e tre questi valori nella documentazione.

- Successivamente, dovrai abilitare la fatturazione nella console Cloud per utilizzare le API/risorse Cloud. L'esecuzione di questo codelab non dovrebbe costare molto, se non del tutto. Per arrestare le risorse in modo da non incorrere in fatturazione oltre questo tutorial, puoi eliminare le risorse che hai creato o l'intero progetto. I nuovi utenti di Google Cloud possono partecipare al programma Prova senza costi di 300$.

Avvia Cloud Shell

Sebbene Google Cloud possa essere utilizzato da remoto dal tuo laptop, in questo codelab utilizzerai Google Cloud Shell, un ambiente a riga di comando in esecuzione nel cloud.

Nella console Google Cloud, fai clic sull'icona di Cloud Shell nella barra degli strumenti in alto a destra:

Bastano pochi istanti per eseguire il provisioning e connettersi all'ambiente. Al termine, dovresti vedere qualcosa di simile a questo:

Questa macchina virtuale contiene tutti gli strumenti di sviluppo di cui avrai bisogno. Offre una home directory permanente da 5 GB e viene eseguita su Google Cloud, migliorando notevolmente le prestazioni e l'autenticazione di rete. Tutto il lavoro in questo codelab può essere svolto in un browser. Non devi installare nulla.

Prima di iniziare

In Cloud Shell, assicurati che l'ID progetto sia configurato:

PROJECT_ID=your-project-id gcloud config set project $PROJECT_ID

3. Crea un cluster GKE

Innanzitutto, abilita i servizi richiesti per GKE:

gcloud services enable container.googleapis.com

Crea un cluster GKE Autopilot:

CLUSTER_NAME=eventarc-cluster REGION=us-central1 gcloud container clusters create-auto $CLUSTER_NAME --region $REGION

Assicurati che la creazione del cluster sia completata prima di passare al passaggio successivo.

4. Esegui il deployment di un servizio GKE

Prima di eseguire il deployment di un servizio, ottieni le credenziali di autenticazione per interagire con il cluster con kubectl:

gcloud container clusters get-credentials $CLUSTER_NAME \

--region $REGION

Successivamente, esegui il deployment del container ciao di Cloud Run come deployment Kubernetes su GKE. Questo servizio registra le richieste HTTP e CloudEvents ricevute:

SERVICE_NAME=hello-gke

kubectl create deployment $SERVICE_NAME \

--image=gcr.io/cloudrun/hello

Esponi il deployment come servizio Kubernetes interno. Viene creato un servizio con un IP stabile accessibile all'interno del cluster:

kubectl expose deployment $SERVICE_NAME \ --type ClusterIP --port 80 --target-port 8080

Prima di passare al passaggio successivo, assicurati che il pod sia in esecuzione:

kubectl get pods NAME READY STATUS hello-gke-df6469d4b-5vv22 1/1 Running

Puoi anche visualizzare il servizio:

kubectl get svc NAME TYPE CLUSTER-IP EXTERNAL-IP hello-gke LoadBalancer 10.51.1.26 <none>

5. Configura Eventarc

In questo passaggio, eseguirai i passaggi per configurare Eventarc e inizializzare le destinazioni GKE di Eventarc.

Innanzitutto, abilita i servizi richiesti per le destinazioni Eventarc e Eventarc GKE:

gcloud services enable eventarc.googleapis.com \ cloudresourcemanager.googleapis.com

Successivamente, abilita Eventarc per gestire i cluster GKE:

gcloud eventarc gke-destinations init

Eventarc crea un pod Event Forwarder separato per ogni attivatore che ha come target un servizio GKE e richiede autorizzazioni esplicite per apportare modifiche al cluster. Ciò viene fatto concedendo a un service account speciale le autorizzazioni per gestire le risorse nel cluster. Questa operazione deve essere eseguita una volta per progetto Google Cloud.

6. Rilevamento di eventi

Prima di creare gli attivatori, puoi scoprire quali sono le origini evento, i tipi di eventi che possono emettere e come configurare gli attivatori per utilizzarli.

Puoi consultare la pagina della documentazione sugli eventi supportati da Eventarc.Puoi anche esplorare gli eventi utilizzando gcloud.

Per visualizzare l'elenco dei diversi tipi di eventi:

gcloud beta eventarc attributes types list NAME DESCRIPTION google.cloud.audit.log.v1.written Cloud Audit Log written google.cloud.pubsub.topic.v1.messagePublished Cloud Pub/Sub message published google.cloud.storage.object.v1.archived Cloud Storage: Sent when a live version of an (object versioned) object is archived or deleted. google.cloud.storage.object.v1.deleted Cloud Storage: Sent when an object has been permanently deleted. google.cloud.storage.object.v1.finalized Cloud Storage: Sent when a new object (or a new generation of an existing object). google.cloud.storage.object.v1.metadataUpdated Cloud Storage: Sent when the metadata of an existing object changes.

Per saperne di più su ciascun tipo di evento:

gcloud beta eventarc attributes types describe google.cloud.audit.log.v1.written attributes: type,serviceName,methodName,resourceName description: 'Cloud Audit Log: Sent when a log is written.' name: google.cloud.audit.log.v1.written

Per visualizzare l'elenco dei servizi che emettono un determinato tipo di evento:

gcloud beta eventarc attributes service-names list --type=google.cloud.audit.log.v1.written SERVICE_NAME DISPLAY_NAME accessapproval.googleapis.com Access Approval accesscontextmanager.googleapis.com Access Context Manager admin.googleapis.com Google Workspace Admin aiplatform.googleapis.com AI Platform (under Vertex AI) apigee.googleapis.com Apigee apigeeconnect.googleapis.com Apigee Connect ... workflows.googleapis.com Workflows

Per visualizzare l'elenco dei nomi dei metodi (eventi secondari) che ogni servizio può emettere:

gcloud beta eventarc attributes method-names list --type=google.cloud.audit.log.v1.written --service-name=workflows.googleapis.com METHOD_NAME google.cloud.workflows.v1.Workflows.CreateWorkflow google.cloud.workflows.v1.Workflows.DeleteWorkflow google.cloud.workflows.v1.Workflows.GetWorkflow google.cloud.workflows.v1.Workflows.ListWorkflows google.cloud.workflows.v1.Workflows.UpdateWorkflow google.cloud.workflows.v1beta.Workflows.CreateWorkflow google.cloud.workflows.v1beta.Workflows.DeleteWorkflow google.cloud.workflows.v1beta.Workflows.GetWorkflow google.cloud.workflows.v1beta.Workflows.ListWorkflows google.cloud.workflows.v1beta.Workflows.UpdateWorkflow

7. Creare un trigger Pub/Sub

Un modo per ricevere eventi è tramite Pub/Sub. Qualsiasi applicazione può pubblicare messaggi in Pub/Sub e questi messaggi possono essere recapitati ai servizi tramite Eventarc.

Configurazione

Prima di creare gli attivatori, devi avere un account di servizio da utilizzare.

Crea un account di servizio:

SERVICE_ACCOUNT=eventarc-gke-trigger-sa gcloud iam service-accounts create $SERVICE_ACCOUNT

All'account di servizio devono essere concessi i seguenti ruoli per gli attivatori con destinazioni GKE:

roles/pubsub.subscriberroles/monitoring.metricWriterroles/eventarc.eventReceiver(Solo per gli attivatori AuditLog. Questo verrà aggiunto in un passaggio successivo.

Concedi i ruoli:

gcloud projects add-iam-policy-binding $PROJECT_ID \ --member serviceAccount:$SERVICE_ACCOUNT@$PROJECT_ID.iam.gserviceaccount.com \ --role roles/pubsub.subscriber gcloud projects add-iam-policy-binding $PROJECT_ID \ --member serviceAccount:$SERVICE_ACCOUNT@$PROJECT_ID.iam.gserviceaccount.com \ --role roles/monitoring.metricWriter

Crea

Crea un trigger per instradare i messaggi Pub/Sub al tuo servizio:

TRIGGER_NAME=trigger-pubsub-gke gcloud eventarc triggers create $TRIGGER_NAME \ --destination-gke-cluster=$CLUSTER_NAME \ --destination-gke-location=$REGION \ --destination-gke-namespace=default \ --destination-gke-service=$SERVICE_NAME \ --destination-gke-path=/ \ --event-filters="type=google.cloud.pubsub.topic.v1.messagePublished" \ --location=$REGION \ --service-account=$SERVICE_ACCOUNT@$PROJECT_ID.iam.gserviceaccount.com

Test

Puoi verificare che l'attivatore sia stato creato elencando tutti gli attivatori:

gcloud eventarc triggers list

L'trigger Pub/Sub crea un argomento Pub/Sub sottostante. Scopriamolo e assegnalo a una variabile:

TOPIC_ID=$(gcloud eventarc triggers describe $TRIGGER_NAME --location $REGION --format='value(transport.pubsub.topic)')

Utilizza gcloud per pubblicare un messaggio nell'argomento:

gcloud pubsub topics publish $TOPIC_ID --message="Hello World"

Per verificare se l'evento viene ricevuto, individua prima il nome del pod:

kubectl get pods NAME READY STATUS hello-gke-df6469d4b-5vv22 1/1 Running

e memorizzalo in una variabile:

POD_NAME=hello-gke-df6469d4b-5vv22

Controlla i log del pod per verificare l'evento ricevuto:

kubectl logs $POD_NAME

{

"severity": "INFO",

"eventType": "google.cloud.pubsub.topic.v1.messagePublished",

"message": "Received event of type google.cloud.pubsub.topic.v1.messagePublished. Event data: Hello World",

"event": {

"data": {

"subscription": "projects/atamel-eventarc-gke/subscriptions/eventarc-us-central1-trigger-pubsub-gke-sub-270",

"message": {

"data": "SGVsbG8gV29ybGQ=",

"messageId": "6031025573654834",

"publishTime": "2022-10-19T14:13:07.990Z"

}

},

"datacontenttype": "application/json",

"id": "6031025573654834",

"source": "//pubsub.googleapis.com/projects/atamel-eventarc-gke/topics/eventarc-us-central1-trigger-pubsub-gke-729",

"specversion": "1.0",

"time": "2022-10-19T14:13:07.99Z",

"type": "google.cloud.pubsub.topic.v1.messagePublished"

}

}

8. Creare un trigger Cloud Storage

Un altro modo per ricevere gli eventi è tramite Cloud Storage. Ad esempio, un'applicazione può caricare un file in un bucket e l'evento può essere inviato ai servizi tramite Eventarc.

Configurazione

Prima di creare un trigger Cloud Storage, crea un bucket per ricevere gli eventi da:

BUCKET_NAME=eventarc-gcs-$PROJECT_ID gcloud storage buckets update gs://$BUCKET_NAME --location=$REGION

Devi anche aggiungere il ruolo pubsub.publisher all'account di servizio Cloud Storage per gli trigger Cloud Storage:

SERVICE_ACCOUNT_STORAGE=$(gcloud storage service-agent --project=$PROJECT_ID)

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member serviceAccount:$SERVICE_ACCOUNT_STORAGE \

--role roles/pubsub.publisher

Crea

Crea un trigger per inoltrare gli eventi di creazione di nuovi file dal bucket al tuo servizio:

TRIGGER_NAME=trigger-storage-gke gcloud eventarc triggers create $TRIGGER_NAME \ --destination-gke-cluster=$CLUSTER_NAME \ --destination-gke-location=$REGION \ --destination-gke-namespace=default \ --destination-gke-service=$SERVICE_NAME \ --destination-gke-path=/ \ --event-filters="type=google.cloud.storage.object.v1.finalized" \ --event-filters="bucket=$BUCKET_NAME" \ --location=$REGION \ --service-account=$SERVICE_ACCOUNT@$PROJECT_ID.iam.gserviceaccount.com

Test

Puoi verificare che l'attivatore sia stato creato elencando tutti gli attivatori:

gcloud eventarc triggers list

Crea un file e utilizza gcloud storage per caricarlo nel bucket:

echo "Hello World" > random.txt gcloud storage cp random.txt gs://$BUCKET_NAME/random.txt

Controlla i log del pod per verificare l'evento ricevuto:

kubectl logs $POD_NAME

{

"severity": "INFO",

"eventType": "google.cloud.storage.object.v1.finalized",

"message": "Received event of type google.cloud.storage.object.v1.finalized. Event data: {\n \"kind\": \"storage#object\",\n \"id\": \"eventarc-gcs-atamel-eventarc-gke/random.txt/1666190425669022\",\n \"selfLink\": \"https://www.googleapis.com/storage/v1/b/eventarc-gcs-atamel-eventarc-gke/o/random.txt\",\n \"name\": \"random.txt\",\n \"bucket\": \"eventarc-gcs-atamel-eventarc-gke\",\n \"generation\": \"1666190425669022\",\n \"metageneration\": \"1\",\n \"contentType\": \"text/plain\",\n \"timeCreated\": \"2022-10-19T14:40:25.678Z\",\n \"updated\": \"2022-10-19T14:40:25.678Z\",\n \"storageClass\": \"STANDARD\",\n \"timeStorageClassUpdated\": \"2022-10-19T14:40:25.678Z\",\n \"size\": \"12\",\n \"md5Hash\": \"5Z/5eUEET4XfUpfhwwLSYA==\",\n \"mediaLink\": \"https://storage.googleapis.com/download/storage/v1/b/eventarc-gcs-atamel-eventarc-gke/o/random.txt?generation=1666190425669022\u0026alt=media\",\n \"contentLanguage\": \"en\",\n \"crc32c\": \"R1jUOQ==\",\n \"etag\": \"CJ77zIPD7PoCEAE=\"\n}\n",

"event": {

"bucket": "eventarc-gcs-atamel-eventarc-gke",

"data": {

"kind": "storage#object",

"id": "eventarc-gcs-atamel-eventarc-gke/random.txt/1666190425669022",

"selfLink": "https://www.googleapis.com/storage/v1/b/eventarc-gcs-atamel-eventarc-gke/o/random.txt",

"name": "random.txt",

"bucket": "eventarc-gcs-atamel-eventarc-gke",

"generation": "1666190425669022",

"metageneration": "1",

"contentType": "text/plain",

"timeCreated": "2022-10-19T14:40:25.678Z",

"updated": "2022-10-19T14:40:25.678Z",

"storageClass": "STANDARD",

"timeStorageClassUpdated": "2022-10-19T14:40:25.678Z",

"size": "12",

"md5Hash": "5Z/5eUEET4XfUpfhwwLSYA==",

"mediaLink": "https://storage.googleapis.com/download/storage/v1/b/eventarc-gcs-atamel-eventarc-gke/o/random.txt?generation=1666190425669022\u0026alt=media",

"contentLanguage": "en",

"crc32c": "R1jUOQ==",

"etag": "CJ77zIPD7PoCEAE="

},

"datacontenttype": "application/json",

"id": "6031255652220627",

"source": "//storage.googleapis.com/projects/_/buckets/eventarc-gcs-atamel-eventarc-gke",

"specversion": "1.0",

"subject": "objects/random.txt",

"time": "2022-10-19T14:40:25.678152Z",

"type": "google.cloud.storage.object.v1.finalized"

}

}

9. Creare un trigger di Cloud Audit Logs

Sebbene l'trigger Cloud Storage sia il modo migliore per ascoltare gli eventi di Cloud Storage, in questo passaggio crei un trigger Cloud Audit Log per eseguire la stessa operazione.

Configurazione

Per ricevere eventi da un servizio, devi attivare gli audit log. Nella console Google Cloud, seleziona IAM & Admin e Audit Logs dal menu in alto a sinistra. Nell'elenco dei servizi, seleziona Google Cloud Storage:

Sul lato destro, assicurati che Admin, Read e Write siano selezionati e fai clic su Save:

Devi anche aggiungere il ruolo eventarc.eventReceiver all'account di servizio dell'attivatore per gli attivatori degli audit log di Cloud:

gcloud projects add-iam-policy-binding $PROJECT_ID \ --member serviceAccount:$SERVICE_ACCOUNT@$PROJECT_ID.iam.gserviceaccount.com \ --role roles/eventarc.eventReceiver

Crea

Crea un trigger per inoltrare gli eventi di creazione di nuovi file dal bucket al tuo servizio:

TRIGGER_NAME=trigger-auditlog-storage-gke gcloud eventarc triggers create $TRIGGER_NAME \ --destination-gke-cluster=$CLUSTER_NAME \ --destination-gke-location=$REGION \ --destination-gke-namespace=default \ --destination-gke-service=$SERVICE_NAME \ --destination-gke-path=/ \ --event-filters="type=google.cloud.audit.log.v1.written" \ --event-filters="serviceName=storage.googleapis.com" \ --event-filters="methodName=storage.objects.create" \ --event-filters-path-pattern="resourceName=/projects/_/buckets/$BUCKET_NAME/objects/*" \ --location=$REGION \ --service-account=$SERVICE_ACCOUNT@$PROJECT_ID.iam.gserviceaccount.com

Test

L'inizializzazione degli attivatori degli audit log richiede un po' di tempo. Puoi verificare che l'attivatore sia stato creato elencando tutti gli attivatori:

gcloud eventarc triggers list

Dovresti vedere che il campo Active è Yes:

NAME TYPE DESTINATION ACTIVE trigger-auditlog-storage-gke google.cloud.audit.log.v1.written GKE: hello-gke Yes

Crea un file e utilizza gcloud storage per caricarlo nel bucket:

echo "Hello World" > random.txt gcloud storage cp random.txt gs://$BUCKET_NAME/random.txt

Controlla i log del pod per verificare l'evento ricevuto:

kubectl logs $POD_NAME

{

"severity": "INFO",

"eventType": "google.cloud.audit.log.v1.written",

"message": "Received event of type google.cloud.audit.log.v1.written. Event data: {\"protoPayload\":{\"status\":{},\"authenticationInfo\":{\"principalEmail\":\"atameldev@gmail.com\"},\"requestMetadata\":{\"callerIp\":\"149.71.143.227\",\"callerSuppliedUserAgent\":\"apitools Python/3.10.4 gsutil/5.14 (darwin) analytics/disabled interactive/True command/cp google-cloud-sdk/405.0.1,gzip(gfe)\",\"requestAttributes\":{\"time\":\"2022-10-19T15:05:54.144615670Z\",\"auth\":{}},\"destinationAttributes\":{}},\"serviceName\":\"storage.googleapis.com\",\"methodName\":\"storage.objects.create\",\"authorizationInfo\":[{\"resource\":\"projects/_/buckets/eventarc-gcs-atamel-eventarc-gke/objects/random.txt\",\"permission\":\"storage.objects.delete\",\"granted\":true,\"resourceAttributes\":{}},{\"resource\":\"projects/_/buckets/eventarc-gcs-atamel-eventarc-gke/objects/random.txt\",\"permission\":\"storage.objects.create\",\"granted\":true,\"resourceAttributes\":{}}],\"resourceName\":\"projects/_/buckets/eventarc-gcs-atamel-eventarc-gke/objects/random.txt\",\"serviceData\":{\"@type\":\"type.googleapis.com/google.iam.v1.logging.AuditData\",\"policyDelta\":{\"bindingDeltas\":[{\"action\":\"ADD\",\"role\":\"roles/storage.legacyObjectOwner\",\"member\":\"projectOwner:atamel-eventarc-gke\"},{\"action\":\"ADD\",\"role\":\"roles/storage.legacyObjectOwner\",\"member\":\"projectEditor:atamel-eventarc-gke\"},{\"action\":\"ADD\",\"role\":\"roles/storage.legacyObjectOwner\",\"member\":\"user:atameldev@gmail.com\"},{\"action\":\"ADD\",\"role\":\"roles/storage.legacyObjectReader\",\"member\":\"projectViewer:atamel-eventarc-gke\"}]}},\"resourceLocation\":{\"currentLocations\":[\"us-central1\"]}},\"insertId\":\"-8vmrbve7pol2\",\"resource\":{\"type\":\"gcs_bucket\",\"labels\":{\"project_id\":\"atamel-eventarc-gke\",\"bucket_name\":\"eventarc-gcs-atamel-eventarc-gke\",\"location\":\"us-central1\"}},\"timestamp\":\"2022-10-19T15:05:54.138732321Z\",\"severity\":\"INFO\",\"logName\":\"projects/atamel-eventarc-gke/logs/cloudaudit.googleapis.com%2Fdata_access\",\"receiveTimestamp\":\"2022-10-19T15:05:54.839604461Z\"}",

"event": {

"data": {

"protoPayload": {

"status": {

},

"authenticationInfo": {

"principalEmail": "atameldev@gmail.com"

},

"requestMetadata": {

"callerIp": "149.71.143.227",

"callerSuppliedUserAgent": "apitools Python/3.10.4 gsutil/5.14 (darwin) analytics/disabled interactive/True command/cp google-cloud-sdk/405.0.1,gzip(gfe)",

"requestAttributes": {

"time": "2022-10-19T15:05:54.144615670Z",

"auth": {

}

},

"destinationAttributes": {

}

},

"serviceName": "storage.googleapis.com",

"methodName": "storage.objects.create",

"authorizationInfo": [

{

"resource": "projects/_/buckets/eventarc-gcs-atamel-eventarc-gke/objects/random.txt",

"permission": "storage.objects.delete",

"granted": true,

"resourceAttributes": {

}

},

{

"resource": "projects/_/buckets/eventarc-gcs-atamel-eventarc-gke/objects/random.txt",

"permission": "storage.objects.create",

"granted": true,

"resourceAttributes": {

}

}

],

"resourceName": "projects/_/buckets/eventarc-gcs-atamel-eventarc-gke/objects/random.txt",

"serviceData": {

"@type": "type.googleapis.com/google.iam.v1.logging.AuditData",

"policyDelta": {

"bindingDeltas": [

{

"action": "ADD",

"role": "roles/storage.legacyObjectOwner",

"member": "projectOwner:atamel-eventarc-gke"

},

{

"action": "ADD",

"role": "roles/storage.legacyObjectOwner",

"member": "projectEditor:atamel-eventarc-gke"

},

{

"action": "ADD",

"role": "roles/storage.legacyObjectOwner",

"member": "user:atameldev@gmail.com"

},

{

"action": "ADD",

"role": "roles/storage.legacyObjectReader",

"member": "projectViewer:atamel-eventarc-gke"

}

]

}

},

"resourceLocation": {

"currentLocations": [

"us-central1"

]

}

},

"insertId": "-8vmrbve7pol2",

"resource": {

"type": "gcs_bucket",

"labels": {

"project_id": "atamel-eventarc-gke",

"bucket_name": "eventarc-gcs-atamel-eventarc-gke",

"location": "us-central1"

}

},

"timestamp": "2022-10-19T15:05:54.138732321Z",

"severity": "INFO",

"logName": "projects/atamel-eventarc-gke/logs/cloudaudit.googleapis.com%2Fdata_access",

"receiveTimestamp": "2022-10-19T15:05:54.839604461Z"

},

"datacontenttype": "application/json; charset=utf-8",

"dataschema": "https://googleapis.github.io/google-cloudevents/jsonschema/google/events/cloud/audit/v1/LogEntryData.json",

"id": "projects/atamel-eventarc-gke/logs/cloudaudit.googleapis.com%2Fdata_access-8vmrbve7pol21666191954138732",

"methodname": "storage.objects.create",

"recordedtime": "2022-10-19T15:05:54.138732321Z",

"resourcename": "projects/_/buckets/eventarc-gcs-atamel-eventarc-gke/objects/random.txt",

"servicename": "storage.googleapis.com",

"source": "//cloudaudit.googleapis.com/projects/atamel-eventarc-gke/logs/data_access",

"specversion": "1.0",

"subject": "storage.googleapis.com/projects/_/buckets/eventarc-gcs-atamel-eventarc-gke/objects/random.txt",

"time": "2022-10-19T15:05:54.839604461Z",

"type": "google.cloud.audit.log.v1.written"

}

}

10. Complimenti!

Complimenti per aver completato il codelab.

Argomenti trattati

- Creare un cluster GKE.

- Crea un servizio GKE come destinazione evento.

- Crea un trigger Pub/Sub.

- Crea un trigger Cloud Storage.

- Crea un trigger di Cloud Audit Logs.