1. Introduction

Bonjour ! Vous aimez l'idée des agents, ces petits assistants qui peuvent faire des choses pour vous sans que vous ayez à lever le petit doigt, n'est-ce pas ? Formidable ! Mais soyons réalistes : un seul agent ne suffit pas toujours, surtout lorsque vous vous attaquez à des projets plus importants et plus complexes. Vous aurez probablement besoin de toute une équipe ! C'est là que les systèmes multi-agents entrent en jeu.

Les agents, lorsqu'ils sont optimisés par des LLM, vous offrent une flexibilité incroyable par rapport à l'ancien codage en dur. Mais, et il y a toujours un "mais", elles présentent des défis complexes. C'est exactement ce que nous allons aborder dans cet atelier.

Voici ce que vous pouvez vous attendre à apprendre (pensez-y comme à une amélioration de votre jeu d'agent) :

Créer votre premier agent avec LangGraph : nous allons nous salir les mains en créant votre propre agent à l'aide de LangGraph, un framework populaire. Vous apprendrez à créer des outils qui se connectent à des bases de données, à exploiter la dernière API Gemini 2 pour effectuer des recherches sur Internet et à optimiser les requêtes et les réponses. Votre agent pourra ainsi interagir non seulement avec les LLM, mais aussi avec les services existants. Nous vous montrerons également comment fonctionne l'appel de fonction.

Orchestration d'agents, à votre façon : nous allons explorer différentes façons d'orchestrer vos agents, des chemins simples et directs aux scénarios multipath plus complexes. Considérez-le comme le chef d'orchestre de votre équipe d'agents.

Systèmes multi-agents : vous découvrirez comment configurer un système dans lequel vos agents peuvent collaborer et accomplir des tâches ensemble, le tout grâce à une architecture événementielle.

Liberté des LLM : utilisez le meilleur outil pour chaque tâche. Nous ne sommes pas limités à un seul LLM ! Vous découvrirez comment utiliser plusieurs LLM en leur attribuant différents rôles pour améliorer la résolution de problèmes à l'aide de "modèles de pensée" intéressants.

Contenu dynamique ? Pas de problème ! : Imaginez votre agent créant du contenu dynamique adapté spécifiquement à chaque utilisateur, en temps réel. Nous allons vous montrer comment faire.

Passer au cloud avec Google Cloud : oubliez les simples manipulations dans un notebook. Nous vous montrerons comment concevoir et déployer votre système multi-agent sur Google Cloud pour qu'il soit prêt à être utilisé dans le monde réel.

Ce projet sera un bon exemple de la façon d'utiliser toutes les techniques dont nous avons parlé.

2. Architecture

Être enseignant ou travailler dans le secteur de l'éducation peut être très gratifiant, mais soyons honnêtes, la charge de travail, en particulier tout le travail de préparation, peut être difficile ! De plus, le personnel est souvent insuffisant et les cours particuliers peuvent être coûteux. C'est pourquoi nous proposons un assistant d'enseignement basé sur l'IA. Cet outil peut alléger la charge de travail des enseignants et combler le manque de personnel et de tutorat abordable.

Notre assistant pédagogique IA peut générer des plans de cours détaillés, des quiz amusants, des résumés audio faciles à suivre et des devoirs personnalisés. Les enseignants peuvent ainsi se concentrer sur ce qu'ils font de mieux : échanger avec les élèves et les aider à aimer apprendre.

Le système comporte deux sites : l'un permet aux enseignants de créer des plans de cours pour les semaines à venir,

et un autre pour que les élèves puissent accéder aux quiz, aux résumés audio et aux devoirs.

Très bien, examinons l'architecture qui alimente notre assistant pédagogique, Aidemy. Comme vous pouvez le voir, nous l'avons décomposé en plusieurs composants clés qui fonctionnent tous ensemble pour y parvenir.

Principaux éléments et technologies de l'architecture :

Google Cloud Platform (GCP) : élément central de l'ensemble du système :

- Vertex AI : accède aux LLM Gemini de Google.

- Cloud Run : plate-forme sans serveur permettant de déployer des agents et des fonctions conteneurisés.

- Cloud SQL : base de données PostgreSQL pour les données du programme.

- Pub/Sub et Eventarc : base de l'architecture basée sur les événements, qui permet la communication asynchrone entre les composants.

- Cloud Storage : stocke les résumés audio et les fichiers de devoirs.

- Secret Manager : gère de manière sécurisée les identifiants de base de données.

- Artifact Registry : stocke les images Docker pour les agents.

- Compute Engine : pour déployer un LLM auto-hébergé au lieu de s'appuyer sur des solutions de fournisseurs

LLM : le "cerveau" du système :

- Modèles Gemini de Google : (Gemini x Pro, Gemini x Flash, Gemini x Flash Thinking) utilisés pour la planification des cours, la génération de contenu, la création de HTML dynamique, l'explication des quiz et la combinaison des devoirs.

- DeepSeek : utilisé pour la tâche spécialisée de génération de devoirs d'autoformation

LangChain et LangGraph : frameworks pour le développement d'applications LLM

- Facilite la création de workflows multi-agents complexes.

- Permet l'orchestration intelligente des outils (appels d'API, requêtes de base de données, recherches sur le Web).

- Implémente une architecture basée sur des événements pour l'évolutivité et la flexibilité du système.

En substance, notre architecture combine la puissance des LLM avec des données structurées et une communication basée sur les événements, le tout fonctionnant sur Google Cloud. Cela nous permet de créer un assistant pédagogique évolutif, fiable et efficace.

3. Avant de commencer

Dans la console Google Cloud, sur la page de sélection du projet, sélectionnez ou créez un projet Google Cloud. Assurez-vous que la facturation est activée pour votre projet Cloud. Découvrez comment vérifier si la facturation est activée sur un projet.

Activer Gemini Code Assist dans Cloud Shell IDE

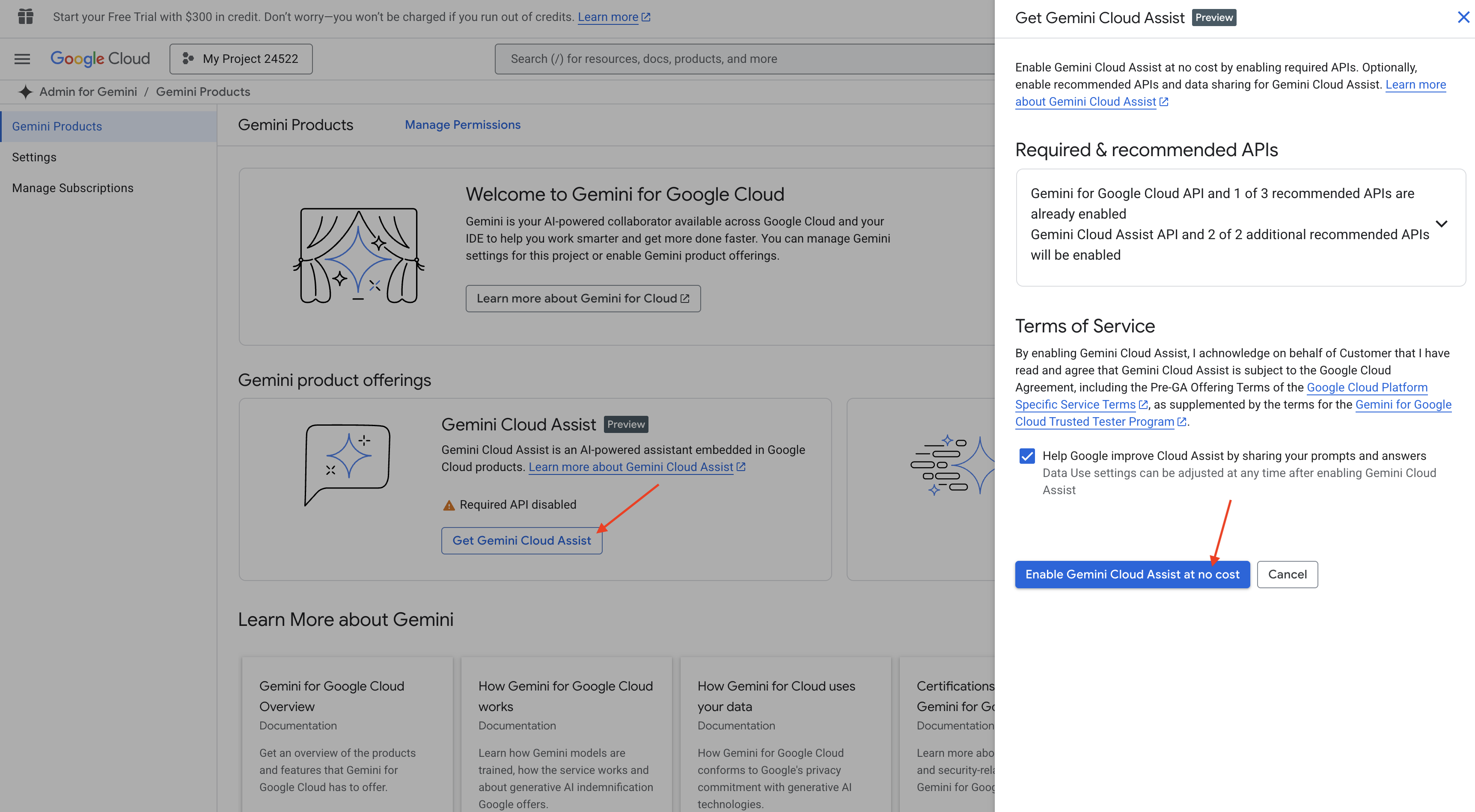

👉 Dans la console Google Cloud, accédez aux outils Gemini Code Assist, puis activez Gemini Code Assist sans frais en acceptant les conditions d'utilisation.

Ignorez la configuration des autorisations et quittez cette page.

Travailler dans l'éditeur Cloud Shell

👉 Cliquez sur Activer Cloud Shell en haut de la console Google Cloud (icône en forme de terminal en haut du volet Cloud Shell), puis sur le bouton Ouvrir l'éditeur (icône en forme de dossier ouvert avec un crayon). L'éditeur de code Cloud Shell s'ouvre dans la fenêtre. Un explorateur de fichiers s'affiche sur la gauche.

👉 Cliquez sur le bouton Cloud Code – Se connecter dans la barre d'état inférieure (voir ci-dessous). Autorisez le plug-in comme indiqué. Si Cloud Code – Aucun projet est affiché dans la barre d'état, cliquez dessus. Dans le menu déroulant "Sélectionner un projet Google Cloud", sélectionnez le projet Google Cloud que vous avez créé.

👉 Ouvrez le terminal dans l'IDE cloud,  ou

ou  .

.

👉 Dans le terminal, vérifiez que vous êtes déjà authentifié et que le projet est défini sur votre ID de projet à l'aide de la commande suivante :

gcloud auth list

👉 Exécutez la commande en veillant à remplacer <YOUR_PROJECT_ID> par l'ID de votre projet :

echo <YOUR_PROJECT_ID> > ~/project_id.txt

gcloud config set project $(cat ~/project_id.txt)

👉 Exécutez la commande suivante pour activer les API Google Cloud nécessaires :

gcloud services enable compute.googleapis.com \

storage.googleapis.com \

run.googleapis.com \

artifactregistry.googleapis.com \

aiplatform.googleapis.com \

eventarc.googleapis.com \

sqladmin.googleapis.com \

secretmanager.googleapis.com \

cloudbuild.googleapis.com \

cloudresourcemanager.googleapis.com \

cloudfunctions.googleapis.com \

cloudaicompanion.googleapis.com

Cette opération peut prendre quelques minutes.

Configurer les autorisations

👉 Configurez les autorisations du compte de service. Dans le terminal, exécutez la commande suivante :

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

export SERVICE_ACCOUNT_NAME=$(gcloud compute project-info describe --format="value(defaultServiceAccount)")

echo "Here's your SERVICE_ACCOUNT_NAME $SERVICE_ACCOUNT_NAME"

👉 Accorder des autorisations. Dans le terminal, exécutez la commande suivante :

#Cloud Storage (Read/Write):

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/storage.objectAdmin"

#Pub/Sub (Publish/Receive):

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/pubsub.publisher"

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/pubsub.subscriber"

#Cloud SQL (Read/Write):

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/cloudsql.editor"

#Eventarc (Receive Events):

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/iam.serviceAccountTokenCreator"

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/eventarc.eventReceiver"

#Vertex AI (User):

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/aiplatform.user"

#Secret Manager (Read):

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/secretmanager.secretAccessor"

👉 Validez le résultat dans votre console IAM.

👉 Exécutez les commandes suivantes dans le terminal pour créer une instance Cloud SQL nommée aidemy. Nous en aurons besoin plus tard, mais comme ce processus peut prendre un certain temps, nous allons le faire maintenant.

gcloud sql instances create aidemy \

--database-version=POSTGRES_14 \

--cpu=2 \

--memory=4GB \

--region=us-central1 \

--root-password=1234qwer \

--storage-size=10GB \

--storage-auto-increase

4. Créer le premier agent

Avant de nous plonger dans les systèmes multi-agents complexes, nous devons établir un bloc de construction fondamental : un agent unique et fonctionnel. Dans cette section, nous allons commencer par créer un agent simple de "fournisseur de livres". L'agent fournisseur de livres prend une catégorie en entrée et utilise un LLM Gemini pour générer une représentation JSON d'un livre dans cette catégorie. Il diffuse ensuite ces recommandations de livres en tant que point de terminaison d'API REST .

👉 Dans un autre onglet de navigateur, ouvrez la console Google Cloud dans votre navigateur Web. Dans le menu de navigation (☰), accédez à "Cloud Run". Cliquez sur le bouton "+ … ÉCRIRE UNE FONCTION".

👉 Nous allons ensuite configurer les paramètres de base de la fonction Cloud Run :

- Nom du service :

book-provider - Région :

us-central1 - Environnement d'exécution :

Python 3.12 - Authentification : définissez

Allow unauthenticated invocationssur "Activée".

👉 Conservez les autres paramètres par défaut, puis cliquez sur Créer. Vous êtes redirigé vers l'éditeur de code source.

Vous verrez des fichiers main.py et requirements.txt préremplis.

main.py contiendra la logique métier de la fonction, et requirements.txt contiendra les packages nécessaires.

👉 Nous sommes maintenant prêts à écrire du code ! Mais avant de nous lancer, voyons si Gemini Code Assist peut nous donner un coup de pouce. Revenez à l'éditeur Cloud Shell, puis cliquez sur l'icône Gemini Code Assist en haut de l'écran pour ouvrir le chat Gemini Code Assist.

👉 Collez la requête suivante dans le champ de requête :

Use the functions_framework library to be deployable as an HTTP function.

Accept a request with category and number_of_book parameters (either in JSON body or query string).

Use langchain and gemini to generate the data for book with fields bookname, author, publisher, publishing_date.

Use pydantic to define a Book model with the fields: bookname (string, description: "Name of the book"), author (string, description: "Name of the author"), publisher (string, description: "Name of the publisher"), and publishing_date (string, description: "Date of publishing").

Use langchain and gemini model to generate book data. the output should follow the format defined in Book model.

The logic should use JsonOutputParser from langchain to enforce output format defined in Book Model.

Have a function get_recommended_books(category) that internally uses langchain and gemini to return a single book object.

The main function, exposed as the Cloud Function, should call get_recommended_books() multiple times (based on number_of_book) and return a JSON list of the generated book objects.

Handle the case where category or number_of_book are missing by returning an error JSON response with a 400 status code.

return a JSON string representing the recommended books. use os library to retrieve GOOGLE_CLOUD_PROJECT env var. Use ChatVertexAI from langchain for the LLM call

Code Assist génère ensuite une solution potentielle, en fournissant à la fois le code source et un fichier de dépendances requirements.txt. (NE PAS UTILISER CE CODE)

Nous vous encourageons à comparer le code généré par l'assistance au code avec la solution testée et correcte fournie ci-dessous. Cela vous permet d'évaluer l'efficacité de l'outil et d'identifier les éventuelles incohérences. Bien qu'il ne faille jamais faire aveuglément confiance aux LLM, Code Assist peut être un excellent outil pour le prototypage rapide et la génération de structures de code initiales. Il doit être utilisé pour prendre un bon départ.

Comme il s'agit d'un atelier, nous allons utiliser le code validé fourni ci-dessous. Toutefois, n'hésitez pas à tester le code généré par Code Assist à votre rythme pour mieux comprendre ses capacités et ses limites.

👉 Revenez à l'éditeur de code source de la fonction Cloud Run (dans l'autre onglet du navigateur). Remplacez soigneusement le contenu existant de main.py par le code fourni ci-dessous :

import functions_framework

import json

from flask import Flask, jsonify, request

from langchain_google_vertexai import ChatVertexAI

from langchain_core.output_parsers import JsonOutputParser

from langchain_core.prompts import PromptTemplate

from pydantic import BaseModel, Field

import os

class Book(BaseModel):

bookname: str = Field(description="Name of the book")

author: str = Field(description="Name of the author")

publisher: str = Field(description="Name of the publisher")

publishing_date: str = Field(description="Date of publishing")

project_id = os.environ.get("GOOGLE_CLOUD_PROJECT")

llm = ChatVertexAI(model_name="gemini-2.0-flash-lite-001")

def get_recommended_books(category):

"""

A simple book recommendation function.

Args:

category (str): category

Returns:

str: A JSON string representing the recommended books.

"""

parser = JsonOutputParser(pydantic_object=Book)

question = f"Generate a random made up book on {category} with bookname, author and publisher and publishing_date"

prompt = PromptTemplate(

template="Answer the user query.\n{format_instructions}\n{query}\n",

input_variables=["query"],

partial_variables={"format_instructions": parser.get_format_instructions()},

)

chain = prompt | llm | parser

response = chain.invoke({"query": question})

return json.dumps(response)

@functions_framework.http

def recommended(request):

request_json = request.get_json(silent=True) # Get JSON data

if request_json and 'category' in request_json and 'number_of_book' in request_json:

category = request_json['category']

number_of_book = int(request_json['number_of_book'])

elif request.args and 'category' in request.args and 'number_of_book' in request.args:

category = request.args.get('category')

number_of_book = int(request.args.get('number_of_book'))

else:

return jsonify({'error': 'Missing category or number_of_book parameters'}), 400

recommendations_list = []

for i in range(number_of_book):

book_dict = json.loads(get_recommended_books(category))

print(f"book_dict=======>{book_dict}")

recommendations_list.append(book_dict)

return jsonify(recommendations_list)

👉 Remplacez le contenu de requirements.txt par ce qui suit :

functions-framework==3.*

google-genai==1.0.0

flask==3.1.0

jsonify==0.5

langchain_google_vertexai==2.0.13

langchain_core==0.3.34

pydantic==2.10.5

👉 Nous allons définir le point d'entrée de la fonction : recommended

👉 Cliquez sur ENREGISTRER ET DÉPLOYER (ou ENREGISTRER ET REDÉPLOYER) pour déployer la fonction. Attendez la fin du processus de déploiement. L'état s'affiche dans la console Cloud. Cette opération peut prendre plusieurs minutes.

👉 Une fois le déploiement effectué, revenez à l'éditeur Cloud Shell et exécutez la commande suivante dans le terminal :

👉 Une fois le déploiement effectué, revenez à l'éditeur Cloud Shell et exécutez la commande suivante dans le terminal :

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

export BOOK_PROVIDER_URL=$(gcloud run services describe book-provider --region=us-central1 --project=$PROJECT_ID --format="value(status.url)")

curl -X POST -H "Content-Type: application/json" -d '{"category": "Science Fiction", "number_of_book": 2}' $BOOK_PROVIDER_URL

Il devrait afficher des données de livres au format JSON.

[

{"author":"Anya Sharma","bookname":"Echoes of the Singularity","publisher":"NovaLight Publishing","publishing_date":"2077-03-15"},

{"author":"Anya Sharma","bookname":"Echoes of the Quantum Dawn","publisher":"Nova Genesis Publishing","publishing_date":"2077-03-15"}

]

Félicitations ! Vous avez déployé une fonction Cloud Run avec succès. Il s'agit de l'un des services que nous intégrerons lors du développement de notre agent Aidemy.

5. Outils de création : connecter des agents à un service RESTFUL et à des données

Téléchargeons le projet Bootstrap Skeleton. Assurez-vous d'être dans l'éditeur Cloud Shell. Dans le terminal, exécutez

git clone https://github.com/weimeilin79/aidemy-bootstrap.git

Après avoir exécuté cette commande, un nouveau dossier nommé aidemy-bootstrap sera créé dans votre environnement Cloud Shell.

Dans le volet "Explorateur" de l'éditeur Cloud Shell (généralement sur la gauche), vous devriez maintenant voir le dossier créé lorsque vous avez cloné le dépôt Git aidemy-bootstrap. Ouvrez le dossier racine de votre projet dans l'explorateur. Vous y trouverez un sous-dossier planner. Ouvrez-le également.

Commençons à créer les outils que nos agents utiliseront pour devenir vraiment utiles. Comme vous le savez, les LLM sont excellents pour raisonner et générer du texte, mais ils ont besoin d'accéder à des ressources externes pour effectuer des tâches concrètes et fournir des informations précises et à jour. Considérez ces outils comme le "couteau suisse" de l'agent, qui lui permet d'interagir avec le monde.

Lorsque vous créez un agent, il est facile de tomber dans le piège du codage en dur d'une multitude de détails. Cela crée un agent qui n'est pas flexible. Au lieu de cela, en créant et en utilisant des outils, l'agent a accès à une logique ou à des systèmes externes, ce qui lui confère les avantages du LLM et de la programmation traditionnelle.

Dans cette section, nous allons créer la base de l'agent de planification, que les enseignants utiliseront pour générer des plans de cours. Avant que l'agent ne commence à générer un plan, nous voulons définir des limites en fournissant plus de détails sur le sujet et le thème. Nous allons créer trois outils :

- Appel d'API RESTful : interaction avec une API préexistante pour récupérer des données.

- Requête de base de données : récupération de données structurées à partir d'une base de données Cloud SQL.

- Recherche Google : accédez à des informations en temps réel sur le Web.

Récupérer des recommandations de livres à partir d'une API

Commençons par créer un outil qui récupère les recommandations de livres à partir de l'API book-provider que nous avons déployée dans la section précédente. Cet exemple montre comment un agent peut exploiter des services existants.

Dans l'éditeur Cloud Shell, ouvrez le projet aidemy-bootstrap que vous avez cloné dans la section précédente.

👉 Modifiez le fichier book.py dans le dossier planner, puis collez le code suivant à la fin du fichier :

def recommend_book(query: str):

"""

Get a list of recommended book from an API endpoint

Args:

query: User's request string

"""

region = get_next_region();

llm = VertexAI(model_name="gemini-1.5-pro", location=region)

query = f"""The user is trying to plan a education course, you are the teaching assistant. Help define the category of what the user requested to teach, respond the categroy with no more than two word.

user request: {query}

"""

print(f"-------->{query}")

response = llm.invoke(query)

print(f"CATEGORY RESPONSE------------>: {response}")

# call this using python and parse the json back to dict

category = response.strip()

headers = {"Content-Type": "application/json"}

data = {"category": category, "number_of_book": 2}

books = requests.post(BOOK_PROVIDER_URL, headers=headers, json=data)

return books.text

if __name__ == "__main__":

print(recommend_book("I'm doing a course for my 5th grade student on Math Geometry, I'll need to recommend few books come up with a teach plan, few quizes and also a homework assignment."))

Explication :

- recommend_book(query: str) : cette fonction prend la requête d'un utilisateur en entrée.

- Interaction avec le LLM : utilise le LLM pour extraire la catégorie de la requête. Cela montre comment vous pouvez utiliser le LLM pour créer des paramètres pour les outils.

- Appel d'API : il envoie une requête POST à l'API du fournisseur de livres, en transmettant la catégorie et le nombre de livres souhaités.

👉 Pour tester cette nouvelle fonction, définissez la variable d'environnement et exécutez la commande suivante :

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

cd ~/aidemy-bootstrap/planner/

export BOOK_PROVIDER_URL=$(gcloud run services describe book-provider --region=us-central1 --project=$PROJECT_ID --format="value(status.url)")

👉 Installez les dépendances et exécutez le code pour vous assurer qu'il fonctionne :

cd ~/aidemy-bootstrap/planner/

python -m venv env

source env/bin/activate

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

pip install -r requirements.txt

python book.py

Une chaîne JSON contenant des recommandations de livres récupérées à partir de l'API book-provider doit s'afficher. Les résultats sont générés de manière aléatoire. Vos livres ne seront peut-être pas les mêmes, mais vous devriez recevoir deux recommandations de livres au format JSON.

[{"author":"Anya Sharma","bookname":"Echoes of the Singularity","publisher":"NovaLight Publishing","publishing_date":"2077-03-15"},{"author":"Anya Sharma","bookname":"Echoes of the Quantum Dawn","publisher":"Nova Genesis Publishing","publishing_date":"2077-03-15"}]

Si vous voyez ce message, cela signifie que le premier outil fonctionne correctement.

Au lieu de créer explicitement un appel d'API RESTful avec des paramètres spécifiques, nous utilisons le langage naturel ("Je suis un cours..."). L'agent extrait ensuite intelligemment les paramètres nécessaires (comme la catégorie) à l'aide du traitement du langage naturel (NLP, Natural Language Processing), ce qui montre comment l'agent exploite la compréhension du langage naturel pour interagir avec l'API.

👉 Supprimez le code de test suivant de book.py.

if __name__ == "__main__":

print(recommend_book("I'm doing a course for my 5th grade student on Math Geometry, I'll need to recommend few books come up with a teach plan, few quizes and also a homework assignment."))

Obtenir des données de programme à partir d'une base de données

Ensuite, nous allons créer un outil qui récupère les données structurées du programme à partir d'une base de données Cloud SQL PostgreSQL. Cela permet à l'agent d'accéder à une source d'informations fiable pour la planification des cours.

Vous souvenez-vous de l'instance Cloud SQL aidemy que vous avez créée à l'étape précédente ? Voici où il sera utilisé.

👉 Dans le terminal, exécutez la commande suivante pour créer une base de données nommée aidemy-db dans la nouvelle instance.

gcloud sql databases create aidemy-db \

--instance=aidemy

Vérifions l'instance dans Cloud SQL de la console Google Cloud. Vous devriez voir une instance Cloud SQL nommée aidemy.

👉 Cliquez sur le nom de l'instance pour afficher ses détails. 👉 Sur la page "Détails de l'instance Cloud SQL", cliquez sur Cloud SQL Studio dans le menu de navigation de gauche. Un nouvel onglet s'affiche.

Sélectionnez aidemy-db comme base de données, saisissez postgres comme utilisateur et 1234qwer comme mot de passe.

Cliquez sur Authentifier.

👉 Dans l'éditeur de requête SQL Studio, accédez à l'onglet Éditeur 1, puis collez le code SQL suivant :

CREATE TABLE curriculums (

id SERIAL PRIMARY KEY,

year INT,

subject VARCHAR(255),

description TEXT

);

-- Inserting detailed curriculum data for different school years and subjects

INSERT INTO curriculums (year, subject, description) VALUES

-- Year 5

(5, 'Mathematics', 'Introduction to fractions, decimals, and percentages, along with foundational geometry and problem-solving techniques.'),

(5, 'English', 'Developing reading comprehension, creative writing, and basic grammar, with a focus on storytelling and poetry.'),

(5, 'Science', 'Exploring basic physics, chemistry, and biology concepts, including forces, materials, and ecosystems.'),

(5, 'Computer Science', 'Basic coding concepts using block-based programming and an introduction to digital literacy.'),

-- Year 6

(6, 'Mathematics', 'Expanding on fractions, ratios, algebraic thinking, and problem-solving strategies.'),

(6, 'English', 'Introduction to persuasive writing, character analysis, and deeper comprehension of literary texts.'),

(6, 'Science', 'Forces and motion, the human body, and introductory chemical reactions with hands-on experiments.'),

(6, 'Computer Science', 'Introduction to algorithms, logical reasoning, and basic text-based programming (Python, Scratch).'),

-- Year 7

(7, 'Mathematics', 'Algebraic expressions, geometry, and introduction to statistics and probability.'),

(7, 'English', 'Analytical reading of classic and modern literature, essay writing, and advanced grammar skills.'),

(7, 'Science', 'Introduction to cells and organisms, chemical reactions, and energy transfer in physics.'),

(7, 'Computer Science', 'Building on programming skills with Python, introduction to web development, and cyber safety.');

Ce code SQL crée une table nommée curriculums et insère des exemples de données.

👉 Cliquez sur Exécuter pour exécuter le code SQL. Un message de confirmation doit vous indiquer que les instructions ont bien été exécutées.

👉 Développez l'explorateur, recherchez la table curriculums que vous venez de créer, puis cliquez sur Requête. Un nouvel onglet de l'éditeur doit s'ouvrir avec le code SQL généré pour vous.

SELECT * FROM

"public"."curriculums" LIMIT 1000;

👉 Cliquez sur Exécuter.

Le tableau de résultats doit afficher les lignes de données que vous avez insérées à l'étape précédente, ce qui confirme que la table et les données ont été créées correctement.

Maintenant que vous avez créé une base de données avec des exemples de données de programme, nous allons créer un outil pour les récupérer.

👉 Dans l'éditeur Cloud Code, modifiez le fichier curriculums.py dans le dossier aidemy-bootstrap et collez le code suivant à la fin du fichier :

def connect_with_connector() -> sqlalchemy.engine.base.Engine:

db_user = os.environ["DB_USER"]

db_pass = os.environ["DB_PASS"]

db_name = os.environ["DB_NAME"]

print(f"--------------------------->db_user: {db_user!r}")

print(f"--------------------------->db_pass: {db_pass!r}")

print(f"--------------------------->db_name: {db_name!r}")

connector = Connector()

pool = sqlalchemy.create_engine(

"postgresql+pg8000://",

creator=lambda: connector.connect(

instance_connection_name,

"pg8000",

user=db_user,

password=db_pass,

db=db_name,

),

pool_size=2,

max_overflow=2,

pool_timeout=30, # 30 seconds

pool_recycle=1800, # 30 minutes

)

return pool

def get_curriculum(year: int, subject: str):

"""

Get school curriculum

Args:

subject: User's request subject string

year: User's request year int

"""

try:

stmt = sqlalchemy.text(

"SELECT description FROM curriculums WHERE year = :year AND subject = :subject"

)

with db.connect() as conn:

result = conn.execute(stmt, parameters={"year": year, "subject": subject})

row = result.fetchone()

if row:

return row[0]

else:

return None

except Exception as e:

print(e)

return None

db = connect_with_connector()

Explication :

- Variables d'environnement : le code récupère les identifiants de base de données et les informations de connexion à partir des variables d'environnement (plus d'informations ci-dessous).

- connect_with_connector() : cette fonction utilise le connecteur Cloud SQL pour établir une connexion sécurisée à la base de données.

- get_curriculum(year: int, subject: str) : cette fonction prend l'année et la matière comme entrée, interroge la table des programmes et renvoie la description du programme correspondant.

👉 Avant d'exécuter le code, nous devons définir certaines variables d'environnement. Dans le terminal, exécutez la commande suivante :

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

export INSTANCE_NAME="aidemy"

export REGION="us-central1"

export DB_USER="postgres"

export DB_PASS="1234qwer"

export DB_NAME="aidemy-db"

👉 Pour tester, ajoutez le code suivant à la fin de curriculums.py :

if __name__ == "__main__":

print(get_curriculum(6, "Mathematics"))

👉 Exécutez le code :

cd ~/aidemy-bootstrap/planner/

source env/bin/activate

python curriculums.py

La description du programme de mathématiques de 6e année devrait s'afficher dans la console.

Expanding on fractions, ratios, algebraic thinking, and problem-solving strategies.

Si la description du programme s'affiche, cela signifie que l'outil de base de données fonctionne correctement. Arrêtez le script en appuyant sur Ctrl+C s'il est toujours en cours d'exécution.

👉 Supprimez le code de test suivant de curriculums.py.

if __name__ == "__main__":

print(get_curriculum(6, "Mathematics"))

👉 Pour quitter l'environnement virtuel, exécutez la commande suivante dans le terminal :

deactivate

6. Outils de création : accéder à des informations en temps réel sur le Web

Enfin, nous allons créer un outil qui utilise l'intégration de Gemini 2 et de la recherche Google pour accéder à des informations en temps réel sur le Web. Cela permet à l'agent de rester à jour et de fournir des résultats pertinents.

L'intégration de Gemini 2 à l'API Recherche Google améliore les capacités de l'agent en fournissant des résultats de recherche plus précis et contextuels. Les agents peuvent ainsi accéder à des informations à jour et ancrer leurs réponses dans des données réelles, ce qui minimise les hallucinations. L'intégration améliorée de l'API facilite également les requêtes en langage naturel, ce qui permet aux agents de formuler des demandes de recherche complexes et nuancées.

Cette fonction prend en entrée une requête de recherche, un programme, une matière et une année, et utilise l'API Gemini et l'outil de recherche Google pour récupérer des informations pertinentes sur Internet. Si vous regardez attentivement, vous verrez qu'il utilise le SDK Google Generative AI pour appeler des fonctions sans utiliser d'autre framework.

👉 Modifiez search.py dans le dossier aidemy-bootstrap et collez le code suivant à la fin du fichier :

model_id = "gemini-2.0-flash-001"

google_search_tool = Tool(

google_search = GoogleSearch()

)

def search_latest_resource(search_text: str, curriculum: str, subject: str, year: int):

"""

Get latest information from the internet

Args:

search_text: User's request category string

subject: "User's request subject" string

year: "User's request year" integer

"""

search_text = "%s in the context of year %d and subject %s with following curriculum detail %s " % (search_text, year, subject, curriculum)

region = get_next_region()

client = genai.Client(vertexai=True, project=PROJECT_ID, location=region)

print(f"search_latest_resource text-----> {search_text}")

response = client.models.generate_content(

model=model_id,

contents=search_text,

config=GenerateContentConfig(

tools=[google_search_tool],

response_modalities=["TEXT"],

)

)

print(f"search_latest_resource response-----> {response}")

return response

if __name__ == "__main__":

response = search_latest_resource("What are the syllabus for Year 6 Mathematics?", "Expanding on fractions, ratios, algebraic thinking, and problem-solving strategies.", "Mathematics", 6)

for each in response.candidates[0].content.parts:

print(each.text)

Explication :

- Définition de l'outil google_search_tool : encapsuler l'objet GoogleSearch dans un outil

- search_latest_resource(search_text: str, subject: str, year: int) : cette fonction prend une requête de recherche, un sujet et une année en entrée, puis utilise l'API Gemini pour effectuer une recherche Google.

- GenerateContentConfig : définissez qu'il a accès à l'outil GoogleSearch.

Le modèle Gemini analyse en interne le search_text et détermine s'il peut répondre directement à la question ou s'il doit utiliser l'outil GoogleSearch. Il s'agit d'une étape essentielle du processus de raisonnement du LLM. Le modèle a été entraîné à reconnaître les situations où des outils externes sont nécessaires. Si le modèle décide d'utiliser l'outil GoogleSearch, le SDK Google Generative AI gère l'invocation proprement dite. Le SDK prend la décision du modèle et les paramètres qu'il génère, puis les envoie à l'API Google Search. Cette partie est masquée pour l'utilisateur dans le code.

Le modèle Gemini intègre ensuite les résultats de recherche dans sa réponse. Il peut utiliser ces informations pour répondre à la question de l'utilisateur, générer un résumé ou effectuer une autre tâche.

👉 Pour tester, exécutez le code :

cd ~/aidemy-bootstrap/planner/

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

source env/bin/activate

python search.py

Vous devriez voir la réponse de l'API Gemini Search contenant les résultats de recherche liés à "Programme de mathématiques de 5e année". Le résultat exact dépendra des résultats de recherche, mais il s'agira d'un objet JSON contenant des informations sur la recherche.

Si des résultats de recherche s'affichent, cela signifie que l'outil de recherche Google fonctionne correctement. Si le script est toujours en cours d'exécution, arrêtez-le en appuyant sur Ctrl+C.

👉 Supprimez la dernière partie du code.

if __name__ == "__main__":

response = search_latest_resource("What are the syllabus for Year 6 Mathematics?", "Expanding on fractions, ratios, algebraic thinking, and problem-solving strategies.", "Mathematics", 6)

for each in response.candidates[0].content.parts:

print(each.text)

👉 Quittez l'environnement virtuel en exécutant la commande suivante dans le terminal :

deactivate

Félicitations ! Vous avez maintenant créé trois outils puissants pour votre agent de planification : un connecteur d'API, un connecteur de base de données et un outil de recherche Google. Ces outils permettront à l'agent d'accéder aux informations et aux fonctionnalités dont il a besoin pour créer des plans d'enseignement efficaces.

7. Orchestrer avec LangGraph

Maintenant que nous avons créé nos outils individuels, il est temps de les orchestrer à l'aide de LangGraph. Cela nous permettra de créer un agent de planification plus sophistiqué, capable de décider intelligemment quels outils utiliser et quand, en fonction de la demande de l'utilisateur.

LangGraph est une bibliothèque Python conçue pour faciliter la création d'applications avec état et multi-acteurs à l'aide de grands modèles de langage (LLM). Considérez-le comme un framework permettant d'orchestrer des conversations et des workflows complexes impliquant des LLM, des outils et d'autres agents.

Concepts clés

- Structure du graphique : LangGraph représente la logique de votre application sous forme de graphique orienté. Chaque nœud du graphique représente une étape du processus (par exemple, un appel à un LLM, une invocation d'outil ou une vérification conditionnelle). Les arêtes définissent le flux d'exécution entre les nœuds.

- État : LangGraph gère l'état de votre application à mesure qu'elle progresse dans le graphique. Cet état peut inclure des variables telles que la saisie de l'utilisateur, les résultats des appels d'outils, les sorties intermédiaires des LLM et toute autre information qui doit être conservée entre les étapes.

- Nœuds : chaque nœud représente un calcul ou une interaction. Elles peuvent être :

- Nœuds d'outil : utiliser un outil (par exemple, effectuer une recherche sur le Web ou interroger une base de données)

- Nœuds de fonction : exécutent une fonction Python.

- Arêtes : elles relient les nœuds et définissent le flux d'exécution. Elles peuvent être :

- Arêtes directes : flux simple et inconditionnel d'un nœud à un autre.

- Arêtes conditionnelles : le flux dépend du résultat d'un nœud conditionnel.

Nous allons utiliser LangGraph pour implémenter l'orchestration. Modifions le fichier aidemy.py sous le dossier aidemy-bootstrap pour définir notre logique LangGraph.

👉 Ajoutez le code suivant à la fin de .

aidemy.py :

tools = [get_curriculum, search_latest_resource, recommend_book]

def determine_tool(state: MessagesState):

llm = ChatVertexAI(model_name="gemini-2.0-flash-001", location=get_next_region())

sys_msg = SystemMessage(

content=(

f"""You are a helpful teaching assistant that helps gather all needed information.

Your ultimate goal is to create a detailed 3-week teaching plan.

You have access to tools that help you gather information.

Based on the user request, decide which tool(s) are needed.

"""

)

)

llm_with_tools = llm.bind_tools(tools)

return {"messages": llm_with_tools.invoke([sys_msg] + state["messages"])}

Cette fonction est chargée de prendre l'état actuel de la conversation, de fournir un message système au LLM, puis de lui demander de générer une réponse. Le LLM peut soit répondre directement à l'utilisateur, soit choisir d'utiliser l'un des outils disponibles.

tools : cette liste représente l'ensemble des outils dont dispose l'agent. Il contient trois fonctions d'outil que nous avons définies dans les étapes précédentes : get_curriculum, search_latest_resource et recommend_book. llm.bind_tools(tools) : "lie" la liste des outils à l'objet llm. L'association des outils indique au LLM que ces outils sont disponibles et lui fournit des informations sur la façon de les utiliser (par exemple, les noms des outils, les paramètres qu'ils acceptent et ce qu'ils font).

Nous allons utiliser LangGraph pour implémenter l'orchestration.

👉 Ajoutez le code suivant à la fin de .

aidemy.py :

def prep_class(prep_needs):

builder = StateGraph(MessagesState)

builder.add_node("determine_tool", determine_tool)

builder.add_node("tools", ToolNode(tools))

builder.add_edge(START, "determine_tool")

builder.add_conditional_edges("determine_tool",tools_condition)

builder.add_edge("tools", "determine_tool")

memory = MemorySaver()

graph = builder.compile(checkpointer=memory)

config = {"configurable": {"thread_id": "1"}}

messages = graph.invoke({"messages": prep_needs},config)

print(messages)

for m in messages['messages']:

m.pretty_print()

teaching_plan_result = messages["messages"][-1].content

return teaching_plan_result

if __name__ == "__main__":

prep_class("I'm doing a course for year 5 on subject Mathematics in Geometry, , get school curriculum, and come up with few books recommendation plus search latest resources on the internet base on the curriculum outcome. And come up with a 3 week teaching plan")

Explication :

StateGraph(MessagesState): crée un objetStateGraph. UnStateGraphest un concept fondamental dans LangGraph. Il représente le workflow de votre agent sous la forme d'un graphique, où chaque nœud du graphique représente une étape du processus. Considérez-le comme un plan définissant la façon dont l'agent raisonnera et agira.- Périphérie conditionnelle : à partir du nœud

"determine_tool", l'argumenttools_conditionest probablement une fonction qui détermine la périphérie à suivre en fonction du résultat de la fonctiondetermine_tool. Les arêtes conditionnelles permettent au graphique de se ramifier en fonction de la décision du LLM concernant l'outil à utiliser (ou s'il doit répondre directement à l'utilisateur). C'est là que l'intelligence de l'agent entre en jeu : il peut adapter son comportement de manière dynamique en fonction de la situation. - Boucle : ajoute une arête au graphique qui relie le nœud

"tools"au nœud"determine_tool". Cela crée une boucle dans le graphique, ce qui permet à l'agent d'utiliser les outils de manière répétée jusqu'à ce qu'il ait recueilli suffisamment d'informations pour accomplir la tâche et fournir une réponse satisfaisante. Cette boucle est essentielle pour les tâches complexes qui nécessitent plusieurs étapes de raisonnement et de collecte d'informations.

Maintenant, testons notre agent de planification pour voir comment il orchestre les différents outils.

Ce code exécutera la fonction prep_class avec une entrée utilisateur spécifique, simulant une demande de création d'un plan d'enseignement pour les mathématiques de 5e année en géométrie, en utilisant le programme, des recommandations de livres et les dernières ressources Internet.

👉 Dans votre terminal, si vous l'avez fermé ou si les variables d'environnement ne sont plus définies, réexécutez les commandes suivantes.

export BOOK_PROVIDER_URL=$(gcloud run services describe book-provider --region=us-central1 --project=$PROJECT_ID --format="value(status.url)")

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

export INSTANCE_NAME="aidemy"

export REGION="us-central1"

export DB_USER="postgres"

export DB_PASS="1234qwer"

export DB_NAME="aidemy-db"

👉 Exécutez le code :

cd ~/aidemy-bootstrap/planner/

source env/bin/activate

pip install -r requirements.txt

python aidemy.py

Consultez le journal dans le terminal. Vous devez voir la preuve que l'agent appelle les trois outils (obtenir le programme scolaire, obtenir des recommandations de livres et rechercher les dernières ressources) avant de fournir le plan d'enseignement final. Cela montre que l'orchestration LangGraph fonctionne correctement et que l'agent utilise intelligemment tous les outils disponibles pour répondre à la demande de l'utilisateur.

================================ Human Message =================================

I'm doing a course for year 5 on subject Mathematics in Geometry, , get school curriculum, and come up with few books recommendation plus search latest resources on the internet base on the curriculum outcome. And come up with a 3 week teaching plan

================================== Ai Message ==================================

Tool Calls:

get_curriculum (xxx)

Call ID: xxx

Args:

year: 5.0

subject: Mathematics

================================= Tool Message =================================

Name: get_curriculum

Introduction to fractions, decimals, and percentages, along with foundational geometry and problem-solving techniques.

================================== Ai Message ==================================

Tool Calls:

search_latest_resource (xxxx)

Call ID: xxxx

Args:

year: 5.0

search_text: Geometry

curriculum: {"content": "Introduction to fractions, decimals, and percentages, along with foundational geometry and problem-solving techniques."}

subject: Mathematics

================================= Tool Message =================================

Name: search_latest_resource

candidates=[Candidate(content=Content(parts=[Part(.....) automatic_function_calling_history=[] parsed=None

================================== Ai Message ==================================

Tool Calls:

recommend_book (93b48189-4d69-4c09-a3bd-4e60cdc5f1c6)

Call ID: 93b48189-4d69-4c09-a3bd-4e60cdc5f1c6

Args:

query: Mathematics Geometry Year 5

================================= Tool Message =================================

Name: recommend_book

[{.....}]

================================== Ai Message ==================================

Based on the curriculum outcome, here is a 3-week teaching plan for year 5 Mathematics Geometry:

**Week 1: Introduction to Shapes and Properties**

.........

Arrêtez le script en appuyant sur Ctrl+C s'il est toujours en cours d'exécution.

👉 (FACULTATIF) Remplacez le code de test par une autre requête, qui nécessite l'appel d'autres outils.

if __name__ == "__main__":

prep_class("I'm doing a course for year 5 on subject Mathematics in Geometry, search latest resources on the internet base on the subject. And come up with a 3 week teaching plan")

👉 Si vous avez fermé votre terminal ou si les variables d'environnement ne sont plus définies, réexécutez les commandes suivantes.

gcloud config set project $(cat ~/project_id.txt)

export BOOK_PROVIDER_URL=$(gcloud run services describe book-provider --region=us-central1 --project=$PROJECT_ID --format="value(status.url)")

export PROJECT_ID=$(gcloud config get project)

export INSTANCE_NAME="aidemy"

export REGION="us-central1"

export DB_USER="postgres"

export DB_PASS="1234qwer"

export DB_NAME="aidemy-db"

👉 (CETTE ÉTAPE EST FACULTATIVE. NE L'EFFECTUEZ QUE SI VOUS AVEZ EXÉCUTÉ L'ÉTAPE PRÉCÉDENTE.) Exécutez à nouveau le code :

cd ~/aidemy-bootstrap/planner/

source env/bin/activate

python aidemy.py

Qu'avez-vous remarqué cette fois-ci ? À quels outils l'agent a-t-il fait appel ? Vous devriez constater que l'agent n'appelle que l'outil search_latest_resource cette fois-ci. En effet, la requête ne précise pas qu'elle a besoin des deux autres outils, et notre LLM est suffisamment intelligent pour ne pas les appeler.

================================ Human Message =================================

I'm doing a course for year 5 on subject Mathematics in Geometry, search latest resources on the internet base on the subject. And come up with a 3 week teaching plan

================================== Ai Message ==================================

Tool Calls:

get_curriculum (xxx)

Call ID: xxx

Args:

year: 5.0

subject: Mathematics

================================= Tool Message =================================

Name: get_curriculum

Introduction to fractions, decimals, and percentages, along with foundational geometry and problem-solving techniques.

================================== Ai Message ==================================

Tool Calls:

search_latest_resource (xxx)

Call ID: xxxx

Args:

year: 5.0

subject: Mathematics

curriculum: {"content": "Introduction to fractions, decimals, and percentages, along with foundational geometry and problem-solving techniques."}

search_text: Geometry

================================= Tool Message =================================

Name: search_latest_resource

candidates=[Candidate(content=Content(parts=[Part(.......token_count=40, total_token_count=772) automatic_function_calling_history=[] parsed=None

================================== Ai Message ==================================

Based on the information provided, a 3-week teaching plan for Year 5 Mathematics focusing on Geometry could look like this:

**Week 1: Introducing 2D Shapes**

........

* Use visuals, manipulatives, and real-world examples to make the learning experience engaging and relevant.

Arrêtez le script en appuyant sur Ctrl+C.

👉 (NE PAS PASSER CETTE ÉTAPE !) Supprimez le code de test pour que votre fichier aidemy.py reste propre :

if __name__ == "__main__":

prep_class("I'm doing a course for year 5 on subject Mathematics in Geometry, search latest resources on the internet base on the subject. And come up with a 3 week teaching plan")

Maintenant que la logique de notre agent est définie, lançons l'application Web Flask. Les enseignants pourront ainsi interagir avec l'agent à l'aide d'une interface basée sur des formulaires qui leur est familière. Bien que les interactions avec les chatbots soient courantes avec les LLM, nous optons pour une UI d'envoi de formulaire traditionnelle, car elle peut être plus intuitive pour de nombreux enseignants.

👉 Si vous avez fermé votre terminal ou si les variables d'environnement ne sont plus définies, réexécutez les commandes suivantes.

export BOOK_PROVIDER_URL=$(gcloud run services describe book-provider --region=us-central1 --project=$PROJECT_ID --format="value(status.url)")

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

export INSTANCE_NAME="aidemy"

export REGION="us-central1"

export DB_USER="postgres"

export DB_PASS="1234qwer"

export DB_NAME="aidemy-db"

👉 Lancez maintenant l'UI Web.

cd ~/aidemy-bootstrap/planner/

source env/bin/activate

python app.py

Recherchez les messages de démarrage dans la sortie du terminal Cloud Shell. Flask affiche généralement des messages indiquant qu'il est en cours d'exécution et sur quel port.

Running on http://127.0.0.1:8080

Running on http://127.0.0.1:8080

The application needs to keep running to serve requests.

👉 Dans le menu "Aperçu sur le Web" en haut à droite, sélectionnez Prévisualiser sur le port 8080. Cloud Shell ouvre un nouvel onglet ou une nouvelle fenêtre de navigateur avec l'aperçu Web de votre application.

Dans l'interface de l'application, sélectionnez 5 pour l'année, sélectionnez le sujet Mathematics et saisissez Geometry dans la demande de module complémentaire.

👉 Si vous avez quitté l'interface utilisateur de votre application, revenez-y. Vous devriez voir le résultat généré.

👉 Dans votre terminal, arrêtez le script en appuyant sur Ctrl+C.

👉 Dans votre terminal, quittez l'environnement virtuel :

deactivate

8. Déployer l'agent de planification dans le cloud

Créer et transférer l'image vers le registre

Il est temps de déployer cela dans le cloud.

👉 Dans le terminal, créez un dépôt d'artefacts pour stocker l'image Docker que nous allons créer.

gcloud artifacts repositories create agent-repository \

--repository-format=docker \

--location=us-central1 \

--description="My agent repository"

Le message "Dépôt [agent-repository] créé" devrait s'afficher.

👉 Exécutez la commande suivante pour créer l'image Docker.

cd ~/aidemy-bootstrap/planner/

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

docker build -t gcr.io/${PROJECT_ID}/aidemy-planner .

👉 Nous devons ajouter un tag à l'image pour qu'elle soit hébergée dans Artifact Registry au lieu de GCR, puis transférer l'image taguée vers Artifact Registry :

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

docker tag gcr.io/${PROJECT_ID}/aidemy-planner us-central1-docker.pkg.dev/${PROJECT_ID}/agent-repository/aidemy-planner

docker push us-central1-docker.pkg.dev/${PROJECT_ID}/agent-repository/aidemy-planner

Une fois le transfert terminé, vous pouvez vérifier que l'image est bien stockée dans Artifact Registry.

👉 Accédez à Artifact Registry dans la console Google Cloud. Vous devriez trouver l'image aidemy-planner dans le dépôt agent-repository.

Sécuriser les identifiants de base de données avec Secret Manager

Pour gérer et accéder aux identifiants de base de données de manière sécurisée, nous allons utiliser Google Cloud Secret Manager. Cela permet d'éviter d'encoder en dur des informations sensibles dans le code de notre application et renforce la sécurité.

Nous allons créer des secrets individuels pour le nom d'utilisateur, le mot de passe et le nom de la base de données. Cette approche nous permet de gérer chaque identifiant de manière indépendante.

👉 Dans le terminal, exécutez la commande suivante :

gcloud secrets create db-user

printf "postgres" | gcloud secrets versions add db-user --data-file=-

gcloud secrets create db-pass

printf "1234qwer" | gcloud secrets versions add db-pass --data-file=-

gcloud secrets create db-name

printf "aidemy-db" | gcloud secrets versions add db-name --data-file=-

L'utilisation de Secret Manager est une étape importante pour sécuriser votre application et éviter l'exposition accidentelle d'identifiants sensibles. Il respecte les bonnes pratiques de sécurité pour les déploiements cloud.

Déployer dans Cloud Run

Cloud Run est une plate-forme sans serveur entièrement gérée qui vous permet de déployer des applications conteneurisées rapidement et facilement. Elle élimine la gestion de l'infrastructure, ce qui vous permet de vous concentrer sur l'écriture et le déploiement de votre code. Nous allons déployer notre planificateur en tant que service Cloud Run.

👉 Dans la console Google Cloud, accédez à Cloud Run. Cliquez sur DÉPLOYER UN CONTENEUR, puis sélectionnez SERVICE. Configurez votre service Cloud Run :

- Image de conteneur : cliquez sur "Sélectionner" dans le champ de l'URL. Recherchez l'URL de l'image que vous avez transférée vers Artifact Registry (par exemple, us-central1-docker.pkg.dev/YOUR_PROJECT_ID/agent-repository/aidemy-planner/YOUR_IMG).

- Service name (Nom du service) :

aidemy-planner - Région : sélectionnez la région

us-central1. - Authentification : pour cet atelier, vous pouvez autoriser les appels non authentifiés. Pour la production, vous souhaiterez probablement limiter l'accès.

- Développez la section "Conteneur(s), volumes, mise en réseau, sécurité", puis définissez les éléments suivants dans l'onglet Conteneur(s) :

- Onglet "Paramètres" :

- Ressources

- memory : 2 Gio

- Ressources

- Onglet "Variables et secrets" :

- Variables d'environnement : ajoutez les variables suivantes en cliquant sur le bouton + Ajouter une variable :

- Ajoutez le nom

GOOGLE_CLOUD_PROJECTet la valeur <YOUR_PROJECT_ID>. - Ajoutez le nom

BOOK_PROVIDER_URLet définissez la valeur sur l'URL de votre fonction de fournisseur de livres, que vous pouvez déterminer à l'aide de la commande suivante dans le terminal :gcloud config set project $(cat ~/project_id.txt) gcloud run services describe book-provider \ --region=us-central1 \ --project=$PROJECT_ID \ --format="value(status.url)"

- Ajoutez le nom

- Dans la section Secrets exposés en tant que variables d'environnement, ajoutez les secrets suivants en cliquant sur le bouton + Référencer en tant que secret :

- Ajouter un nom :

DB_USER, secret : sélectionnezdb-useret version :latest - Ajouter un nom :

DB_PASS, secret : sélectionnezdb-passet version :latest - Ajouter un nom :

DB_NAME, secret : sélectionnezdb-nameet version :latest

- Ajouter un nom :

- Variables d'environnement : ajoutez les variables suivantes en cliquant sur le bouton + Ajouter une variable :

- Onglet "Paramètres" :

Conservez les valeurs par défaut des autres options.

👉 Cliquez sur CRÉER.

Cloud Run déploie votre service.

Une fois le service déployé, si vous n'êtes pas déjà sur la page d'informations, cliquez sur son nom pour y accéder. L'URL déployée est disponible en haut de la page.

👉 Dans l'interface de l'application, sélectionnez 7 pour l'année, choisissez Mathematics comme sujet et saisissez Algebra dans le champ "Demande de module complémentaire".

👉 Cliquez sur Générer un plan. L'agent disposera ainsi du contexte nécessaire pour générer un plan de cours personnalisé.

Félicitations ! Vous avez créé un plan de cours à l'aide de notre puissant agent d'IA. Cela montre le potentiel des agents pour réduire considérablement la charge de travail et simplifier les tâches, ce qui améliore l'efficacité et facilite la vie des enseignants.

9. Systèmes multi-agents

Maintenant que nous avons implémenté l'outil de création de plans de cours, concentrons-nous sur la création du portail des élèves. Ce portail permettra aux élèves d'accéder aux quiz, aux résumés audio et aux devoirs liés à leurs cours. Compte tenu de l'étendue de cette fonctionnalité, nous allons exploiter la puissance des systèmes multi-agents pour créer une solution modulaire et évolutive.

Comme nous l'avons vu précédemment, au lieu de s'appuyer sur un seul agent pour tout gérer, un système multi-agents nous permet de répartir la charge de travail en tâches plus petites et spécialisées, chacune étant gérée par un agent dédié. Cette approche présente plusieurs avantages clés :

Modularité et maintenabilité : au lieu de créer un seul agent qui fait tout, créez des agents plus petits et spécialisés avec des responsabilités bien définies. Cette modularité facilite la compréhension, la maintenance et le débogage du système. Lorsqu'un problème survient, vous pouvez l'isoler sur un agent spécifique, au lieu d'avoir à parcourir un codebase volumineux.

Évolutivité : la mise à l'échelle d'un agent unique et complexe peut constituer un goulot d'étranglement. Avec un système multi-agents, vous pouvez mettre à l'échelle des agents individuels en fonction de leurs besoins spécifiques. Par exemple, si un agent traite un volume élevé de requêtes, vous pouvez facilement créer d'autres instances de cet agent sans affecter le reste du système.

Spécialisation des équipes : imaginez que vous ne demanderiez pas à un seul ingénieur de créer une application entière à partir de zéro. Au lieu de cela, vous constituez une équipe de spécialistes, chacun ayant une expertise dans un domaine particulier. De même, un système multi-agents vous permet d'exploiter les points forts de différents LLM et outils, en les attribuant à des agents les mieux adaptés à des tâches spécifiques.

Développement en parallèle : différentes équipes peuvent travailler simultanément sur différents agents, ce qui accélère le processus de développement. Comme les agents sont indépendants, les modifications apportées à l'un d'eux sont moins susceptibles d'avoir un impact sur les autres.

Architecture basée sur des événements

Pour permettre une communication et une coordination efficaces entre ces agents, nous utiliserons une architecture basée sur les événements. Cela signifie que les agents réagissent aux "événements" qui se produisent dans le système.

Les agents s'abonnent à des types d'événements spécifiques (par exemple, "plan de cours généré", "devoir créé"). Lorsqu'un événement se produit, les agents concernés sont avertis et peuvent réagir en conséquence. Ce découplage favorise la flexibilité, l'évolutivité et la réactivité en temps réel.

Pour commencer, nous avons besoin d'un moyen de diffuser ces événements. Pour ce faire, nous allons configurer un sujet Pub/Sub. Commençons par créer un thème appelé plan.

👉 Accédez à Google Cloud Console Pub/Sub.

👉 Cliquez sur le bouton Créer un sujet.

👉 Configurez le sujet avec l'ID/le nom plan et décochezAdd a default subscription. Conservez les autres paramètres par défaut, puis cliquez sur Créer.

La page Pub/Sub s'actualise et le sujet que vous venez de créer doit maintenant figurer dans le tableau.

Nous allons maintenant intégrer la fonctionnalité de publication d'événements Pub/Sub à notre agent de planification. Nous allons ajouter un outil qui envoie un événement "plan" au sujet Pub/Sub que nous venons de créer. Cet événement signalera aux autres agents du système (comme ceux du portail des élèves) qu'un nouveau plan d'enseignement est disponible.

👉 Revenez à l'éditeur Cloud Code et ouvrez le fichier app.py situé dans le dossier planner. Nous allons ajouter une fonction qui publie l'événement. Remplacer :

##ADD SEND PLAN EVENT FUNCTION HERE

par le code suivant

def send_plan_event(teaching_plan:str):

"""

Send the teaching event to the topic called plan

Args:

teaching_plan: teaching plan

"""

publisher = pubsub_v1.PublisherClient()

print(f"-------------> Sending event to topic plan: {teaching_plan}")

topic_path = publisher.topic_path(PROJECT_ID, "plan")

message_data = {"teaching_plan": teaching_plan}

data = json.dumps(message_data).encode("utf-8")

future = publisher.publish(topic_path, data)

return f"Published message ID: {future.result()}"

- send_plan_event : cette fonction prend le programme d'enseignement généré en entrée, crée un client d'éditeur Pub/Sub, construit le chemin du sujet, convertit le programme d'enseignement en chaîne JSON et publie le message dans le sujet.

Dans le même fichier app.py

👉 Modifiez l'invite pour demander à l'agent d'envoyer l'événement du programme pédagogique au sujet Pub/Sub après avoir généré le programme pédagogique. *Remplacer

### ADD send_plan_event CALL

avec les éléments suivants :

send_plan_event(teaching_plan)

En ajoutant l'outil send_plan_event et en modifiant l'invite, nous avons permis à notre agent de planification de publier des événements sur Pub/Sub, ce qui permet aux autres composants de notre système de réagir à la création de nouveaux plans d'enseignement. Nous disposerons désormais d'un système multi-agents fonctionnel dans les sections suivantes.

10. Aider les élèves grâce aux quiz à la demande

Imaginez un environnement d'apprentissage où les élèves ont accès à une infinité de quiz adaptés à leurs plans d'apprentissage spécifiques. Ces quiz fournissent des commentaires immédiats, y compris des réponses et des explications, ce qui favorise une meilleure compréhension du contenu. C'est le potentiel que nous souhaitons exploiter avec notre portail de quiz optimisé par l'IA.

Pour concrétiser cette vision, nous allons créer un composant de génération de quiz capable de créer des questions à choix multiples en fonction du contenu du programme d'enseignement.

👉 Dans le volet "Explorateur" de l'éditeur Cloud Code, accédez au dossier portal. Ouvrez le fichier quiz.py, puis copiez et collez le code suivant à la fin du fichier.

def generate_quiz_question(file_name: str, difficulty: str, region:str ):

"""Generates a single multiple-choice quiz question using the LLM.

```json

{

"question": "The question itself",

"options": ["Option A", "Option B", "Option C", "Option D"],

"answer": "The correct answer letter (A, B, C, or D)"

}

```

"""

print(f"region: {region}")

# Connect to resourse needed from Google Cloud

llm = VertexAI(model_name="gemini-2.5-flash-preview-04-17", location=region)

plan=None

#load the file using file_name and read content into string call plan

with open(file_name, 'r') as f:

plan = f.read()

parser = JsonOutputParser(pydantic_object=QuizQuestion)

instruction = f"You'll provide one question with difficulty level of {difficulty}, 4 options as multiple choices and provide the anwsers, the quiz needs to be related to the teaching plan {plan}"

prompt = PromptTemplate(

template="Generates a single multiple-choice quiz question\n {format_instructions}\n {instruction}\n",

input_variables=["instruction"],

partial_variables={"format_instructions": parser.get_format_instructions()},

)

chain = prompt | llm | parser

response = chain.invoke({"instruction": instruction})

print(f"{response}")

return response

Dans l'agent, il crée un analyseur de sortie JSON spécialement conçu pour comprendre et structurer la sortie du LLM. Il utilise le modèle QuizQuestion que nous avons défini précédemment pour s'assurer que le résultat analysé est conforme au format correct (question, options et réponse).

👉 Dans votre terminal, exécutez les commandes suivantes pour configurer un environnement virtuel, installer les dépendances et démarrer l'agent :

gcloud config set project $(cat ~/project_id.txt)

cd ~/aidemy-bootstrap/portal/

python -m venv env

source env/bin/activate

pip install -r requirements.txt

python app.py

👉 Dans le menu "Aperçu sur le Web" en haut à droite, sélectionnez Prévisualiser sur le port 8080. Cloud Shell ouvre un nouvel onglet ou une nouvelle fenêtre de navigateur avec l'aperçu Web de votre application.

👉 Dans l'application Web, cliquez sur le lien "Quiz", soit dans la barre de navigation supérieure, soit dans la fiche de la page d'index. Trois quiz générés de manière aléatoire devraient s'afficher pour l'élève. Ces quiz sont basés sur le programme d'enseignement et démontrent la puissance de notre système de génération de quiz basé sur l'IA.

👉 Pour arrêter le processus en cours d'exécution en local, appuyez sur Ctrl+C dans le terminal.

Gemini 2 Thinking pour les explications

Nous avons donc des quiz, ce qui est un bon début. Mais que se passe-t-il si les élèves font une erreur ? C'est là que l'apprentissage se fait vraiment, n'est-ce pas ? Si nous pouvons expliquer pourquoi leur réponse était incorrecte et comment trouver la bonne, ils ont beaucoup plus de chances de s'en souvenir. Cela permet également de dissiper toute confusion et de renforcer leur confiance.

C'est pourquoi nous allons faire appel à la crème de la crème : le modèle de "réflexion" de Gemini 2 ! C'est comme si vous donniez à l'IA un peu plus de temps pour réfléchir avant de vous donner une explication. Il peut ainsi fournir des commentaires plus détaillés et de meilleure qualité.

Nous voulons voir si elle peut aider les élèves en leur fournissant une assistance, en répondant à leurs questions et en leur donnant des explications détaillées. Pour le tester, nous allons commencer par un sujet notoirement difficile : le calcul.

👉 Commencez par accéder à l'éditeur Cloud Code, dans answer.py à l'intérieur du dossier portal. Remplacer le code de fonction suivant

def answer_thinking(question, options, user_response, answer, region):

return ""

avec l'extrait de code suivant :

def answer_thinking(question, options, user_response, answer, region):

try:

llm = VertexAI(model_name="gemini-2.0-flash-001",location=region)

input_msg = HumanMessage(content=[f"Here the question{question}, here are the available options {options}, this student's answer {user_response}, whereas the correct answer is {answer}"])

prompt_template = ChatPromptTemplate.from_messages(

[

SystemMessage(

content=(

"You are a helpful teacher trying to teach the student on question, you were given the question and a set of multiple choices "

"what's the correct answer. use friendly tone"

)

),

input_msg,

]

)

prompt = prompt_template.format()

response = llm.invoke(prompt)

print(f"response: {response}")

return response

except Exception as e:

print(f"Error sending message to chatbot: {e}") # Log this error too!

return f"Unable to process your request at this time. Due to the following reason: {str(e)}"

if __name__ == "__main__":

question = "Evaluate the limit: lim (x→0) [(sin(5x) - 5x) / x^3]"

options = ["A) -125/6", "B) -5/3 ", "C) -25/3", "D) -5/6"]

user_response = "B"

answer = "A"

region = "us-central1"

result = answer_thinking(question, options, user_response, answer, region)

Il s'agit d'une application Langchain très simple qui initialise le modèle Gemini 2 Flash, où nous lui demandons d'agir comme un enseignant utile et de fournir des explications.

👉 Exécutez la commande suivante dans le terminal :

gcloud config set project $(cat ~/project_id.txt)

cd ~/aidemy-bootstrap/portal/

source env/bin/activate

python answer.py

Un résultat semblable à l'exemple fourni dans les instructions d'origine doit s'afficher. Le modèle actuel peut ne pas fournir d'explication complète.

Okay, I see the question and the choices. The question is to evaluate the limit:

lim (x→0) [(sin(5x) - 5x) / x^3]

You chose option B, which is -5/3, but the correct answer is A, which is -125/6.

It looks like you might have missed a step or made a small error in your calculations. This type of limit often involves using L'Hôpital's Rule or Taylor series expansion. Since we have the form 0/0, L'Hôpital's Rule is a good way to go! You need to apply it multiple times. Alternatively, you can use the Taylor series expansion of sin(x) which is:

sin(x) = x - x^3/3! + x^5/5! - ...

So, sin(5x) = 5x - (5x)^3/3! + (5x)^5/5! - ...

Then, (sin(5x) - 5x) = - (5x)^3/3! + (5x)^5/5! - ...

Finally, (sin(5x) - 5x) / x^3 = - 5^3/3! + (5^5 * x^2)/5! - ...

Taking the limit as x approaches 0, we get -125/6.

Keep practicing, you'll get there!

👉 Dans le fichier answer.py, remplacez

model_name de gemini-2.0-flash-001 à gemini-2.0-flash-thinking-exp-01-21 dans la fonction answer_thinking.

Le LLM est remplacé par un autre qui est plus performant en matière de raisonnement. Cela aidera le modèle à générer de meilleures explications.

👉 Exécutez à nouveau le script answer.py pour tester le nouveau modèle de réflexion :

gcloud config set project $(cat ~/project_id.txt)

cd ~/aidemy-bootstrap/portal/

source env/bin/activate

python answer.py

Voici un exemple de réponse du modèle de réflexion, qui est beaucoup plus complète et détaillée, et qui fournit une explication étape par étape de la façon de résoudre le problème de calcul. Cela souligne la puissance des modèles de "réflexion" pour générer des explications de haute qualité. Le résultat doit ressembler à ce qui suit :

Hey there! Let's take a look at this limit problem together. You were asked to evaluate:

lim (x→0) [(sin(5x) - 5x) / x^3]

and you picked option B, -5/3, but the correct answer is actually A, -125/6. Let's figure out why!

It's a tricky one because if we directly substitute x=0, we get (sin(0) - 0) / 0^3 = (0 - 0) / 0 = 0/0, which is an indeterminate form. This tells us we need to use a more advanced technique like L'Hopital's Rule or Taylor series expansion.

Let's use the Taylor series expansion for sin(y) around y=0. Do you remember it? It looks like this:

sin(y) = y - y^3/3! + y^5/5! - ...

where 3! (3 factorial) is 3 × 2 × 1 = 6, 5! is 5 × 4 × 3 × 2 × 1 = 120, and so on.

In our problem, we have sin(5x), so we can substitute y = 5x into the Taylor series:

sin(5x) = (5x) - (5x)^3/3! + (5x)^5/5! - ...

sin(5x) = 5x - (125x^3)/6 + (3125x^5)/120 - ...

Now let's plug this back into our limit expression:

[(sin(5x) - 5x) / x^3] = [ (5x - (125x^3)/6 + (3125x^5)/120 - ...) - 5x ] / x^3

Notice that the '5x' and '-5x' cancel out! So we are left with:

= [ - (125x^3)/6 + (3125x^5)/120 - ... ] / x^3

Now, we can divide every term in the numerator by x^3:

= -125/6 + (3125x^2)/120 - ...

Finally, let's take the limit as x approaches 0. As x gets closer and closer to zero, terms with x^2 and higher powers will become very, very small and approach zero. So, we are left with:

lim (x→0) [ -125/6 + (3125x^2)/120 - ... ] = -125/6

Therefore, the correct answer is indeed **A) -125/6**.

It seems like your answer B, -5/3, might have come from perhaps missing a factor somewhere during calculation or maybe using an incorrect simplification. Double-check your steps when you were trying to solve it!

Don't worry, these limit problems can be a bit tricky sometimes! Keep practicing and you'll get the hang of it. Let me know if you want to go through another similar example or if you have any more questions! 😊

Now that we have confirmed it works, let's use the portal.

👉 SUPPRIMEZ le code de test suivant de answer.py :

if __name__ == "__main__":

question = "Evaluate the limit: lim (x→0) [(sin(5x) - 5x) / x^3]"

options = ["A) -125/6", "B) -5/3 ", "C) -25/3", "D) -5/6"]

user_response = "B"

answer = "A"

region = "us-central1"

result = answer_thinking(question, options, user_response, answer, region)

👉 Exécutez les commandes suivantes dans le terminal pour configurer un environnement virtuel, installer les dépendances et démarrer l'agent :

gcloud config set project $(cat ~/project_id.txt)

cd ~/aidemy-bootstrap/portal/

source env/bin/activate

python app.py

👉 Dans le menu "Aperçu sur le Web" en haut à droite, sélectionnez Prévisualiser sur le port 8080. Cloud Shell ouvre un nouvel onglet ou une nouvelle fenêtre de navigateur avec l'aperçu Web de votre application.

👉 Dans l'application Web, cliquez sur le lien "Quiz", soit dans la barre de navigation supérieure, soit dans la fiche de la page d'index.

👉 Répondez à tous les quiz et assurez-vous de faire au moins une erreur, puis cliquez sur Envoyer.

Plutôt que de rester les bras croisés en attendant la réponse, passez au terminal de l'éditeur Cloud. Vous pouvez observer la progression et les éventuels messages de sortie ou d'erreur générés par votre fonction dans le terminal de l'émulateur. 😁

👉 Dans votre terminal, arrêtez le processus en cours d'exécution en local en appuyant sur Ctrl+C.

11. FACULTATIF : Orchestrer les agents avec Eventarc

Jusqu'à présent, le portail des élèves générait des quiz basés sur un ensemble par défaut de plans de cours. C'est utile, mais cela signifie que notre agent de planification et l'agent de quiz du portail ne communiquent pas vraiment entre eux. Vous vous souvenez de la fonctionnalité que nous avons ajoutée et qui permet à l'agent de planification de publier ses plans d'enseignement nouvellement générés dans un sujet Pub/Sub ? Il est maintenant temps de le connecter à notre agent de portail.

Nous souhaitons que le portail mette à jour automatiquement le contenu de ses quiz chaque fois qu'un nouveau programme d'enseignement est généré. Pour ce faire, nous allons créer un point de terminaison dans le portail qui pourra recevoir ces nouveaux forfaits.

👉 Dans le volet de l'explorateur de l'éditeur Cloud Code, accédez au dossier portal.

👉 Ouvrez le fichier app.py pour le modifier. Remplacez la ligne REPLACE ## REPLACE ME! NEW TEACHING PLAN par le code suivant :

@app.route('/new_teaching_plan', methods=['POST'])

def new_teaching_plan():

try:

# Get data from Pub/Sub message delivered via Eventarc

envelope = request.get_json()

if not envelope:

return jsonify({'error': 'No Pub/Sub message received'}), 400

if not isinstance(envelope, dict) or 'message' not in envelope:

return jsonify({'error': 'Invalid Pub/Sub message format'}), 400

pubsub_message = envelope['message']

print(f"data: {pubsub_message['data']}")

data = pubsub_message['data']

data_str = base64.b64decode(data).decode('utf-8')

data = json.loads(data_str)

teaching_plan = data['teaching_plan']

print(f"File content: {teaching_plan}")

with open("teaching_plan.txt", "w") as f:

f.write(teaching_plan)

print(f"Teaching plan saved to local file: teaching_plan.txt")

return jsonify({'message': 'File processed successfully'})

except Exception as e:

print(f"Error processing file: {e}")

return jsonify({'error': 'Error processing file'}), 500

Recompiler et déployer sur Cloud Run

Vous devrez mettre à jour et redéployer nos agents de planification et de portail sur Cloud Run. Cela garantit qu'ils disposent du code le plus récent et qu'ils sont configurés pour communiquer via des événements.

👉 Tout d'abord, nous allons recompiler et transférer l'image de l'agent planner. Pour cela, exécutez la commande suivante dans le terminal :

cd ~/aidemy-bootstrap/planner/

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

docker build -t gcr.io/${PROJECT_ID}/aidemy-planner .

export PROJECT_ID=$(gcloud config get project)

docker tag gcr.io/${PROJECT_ID}/aidemy-planner us-central1-docker.pkg.dev/${PROJECT_ID}/agent-repository/aidemy-planner