1. Einführung

Hallo! Sie finden die Idee von KI-Agenten gut – kleinen Helfern, die Aufgaben für Sie erledigen, ohne dass Sie einen Finger rühren müssen? Sehr gut! Aber seien wir ehrlich: Ein Agent reicht nicht immer aus, insbesondere wenn Sie größere, komplexere Projekte in Angriff nehmen. Wahrscheinlich brauchen Sie ein ganzes Team von ihnen! Hier kommen Multi-Agent-Systeme ins Spiel.

Agents, die auf LLMs basieren, bieten Ihnen im Vergleich zur herkömmlichen Programmierung eine unglaubliche Flexibilität. Aber, und es gibt immer ein Aber, sie bringen auch einige knifflige Herausforderungen mit sich. Genau darum geht es in diesem Workshop.

Das erwartet Sie:

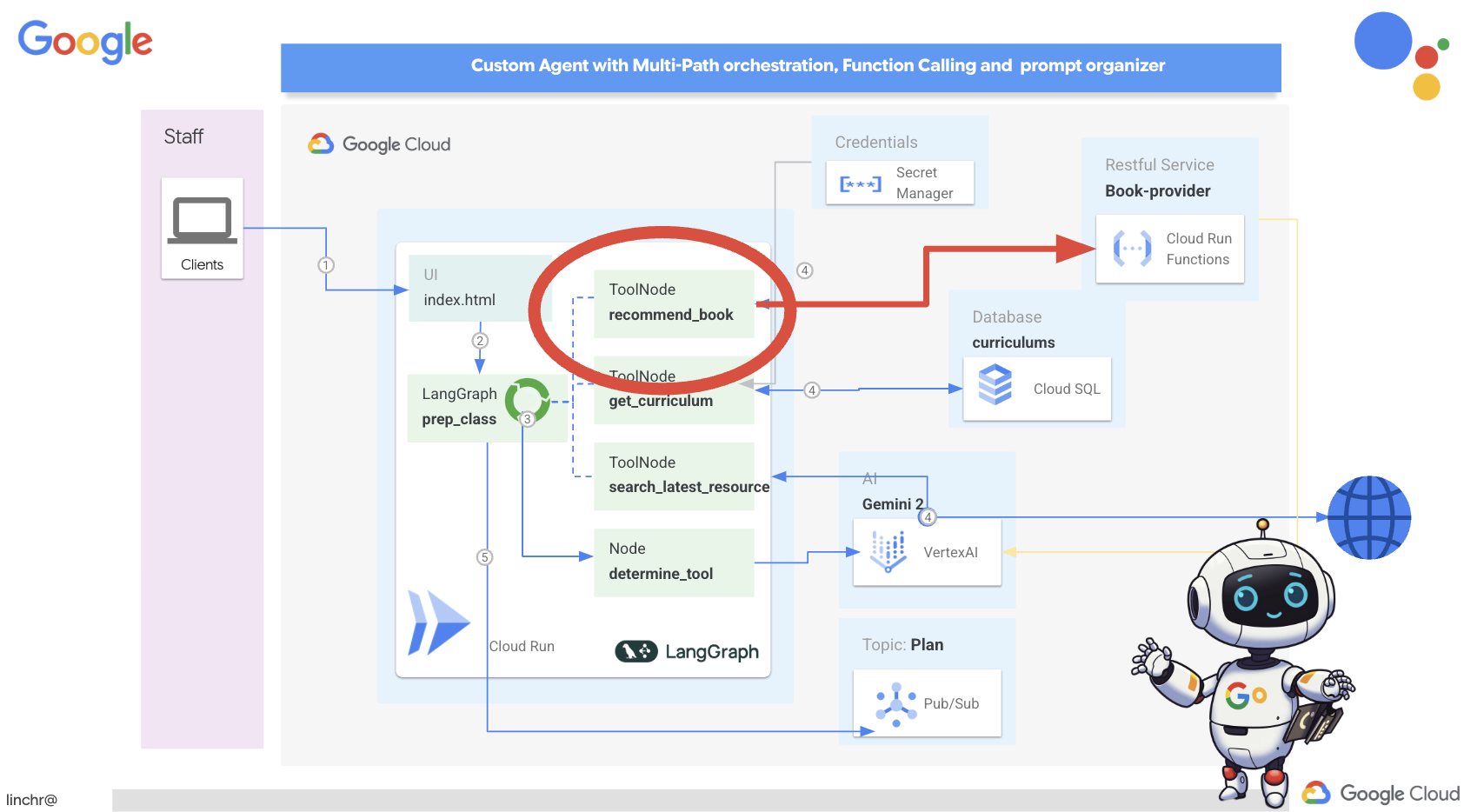

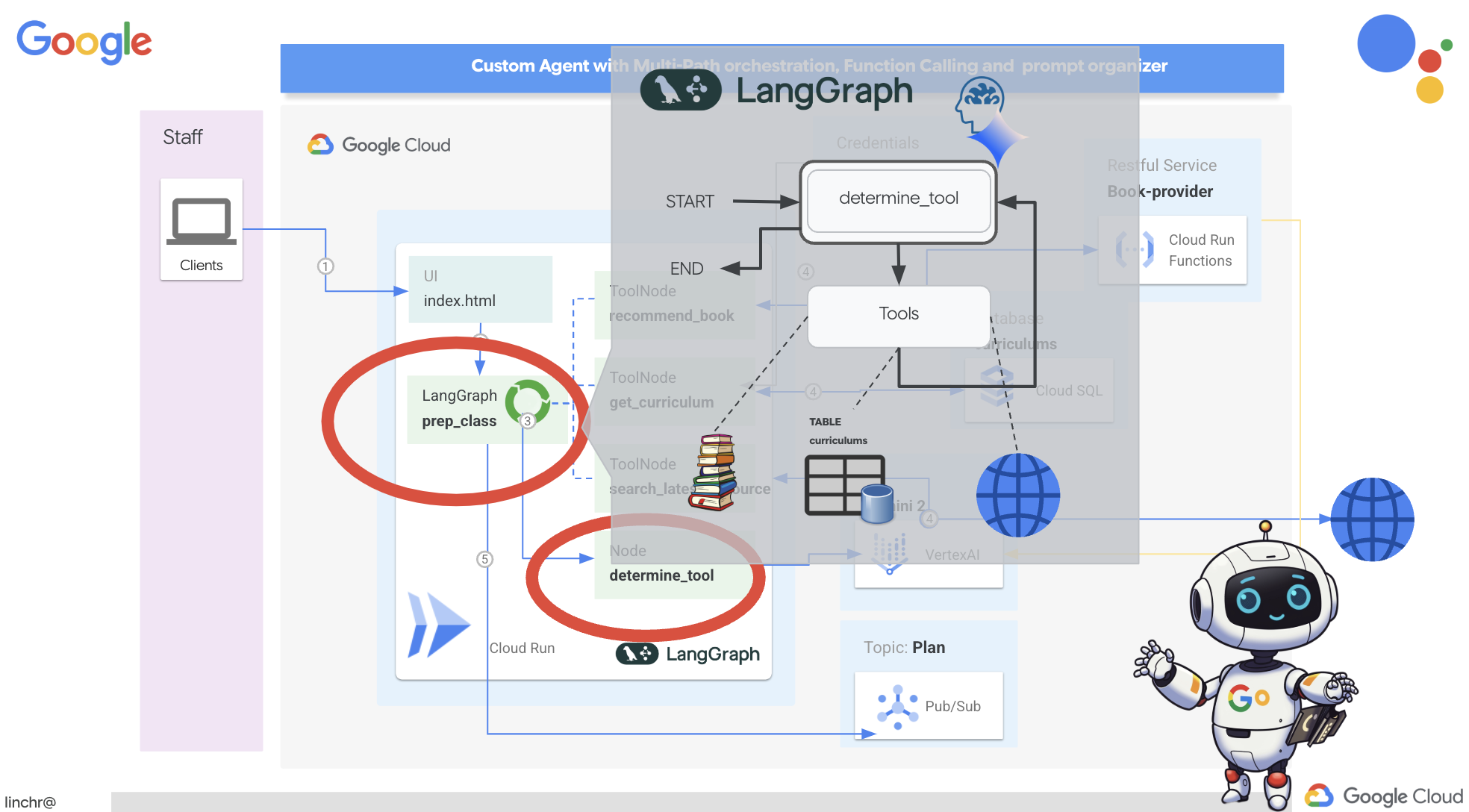

Ersten Agenten mit LangGraph erstellen: Wir erstellen einen eigenen Agenten mit LangGraph, einem beliebten Framework. Sie erfahren, wie Sie Tools erstellen, die eine Verbindung zu Datenbanken herstellen, die neueste Gemini 2-API für die Internetsuche nutzen und die Prompts und Antworten optimieren, damit Ihr Agent nicht nur mit LLMs, sondern auch mit vorhandenen Diensten interagieren kann. Außerdem zeigen wir Ihnen, wie Funktionsaufrufe funktionieren.

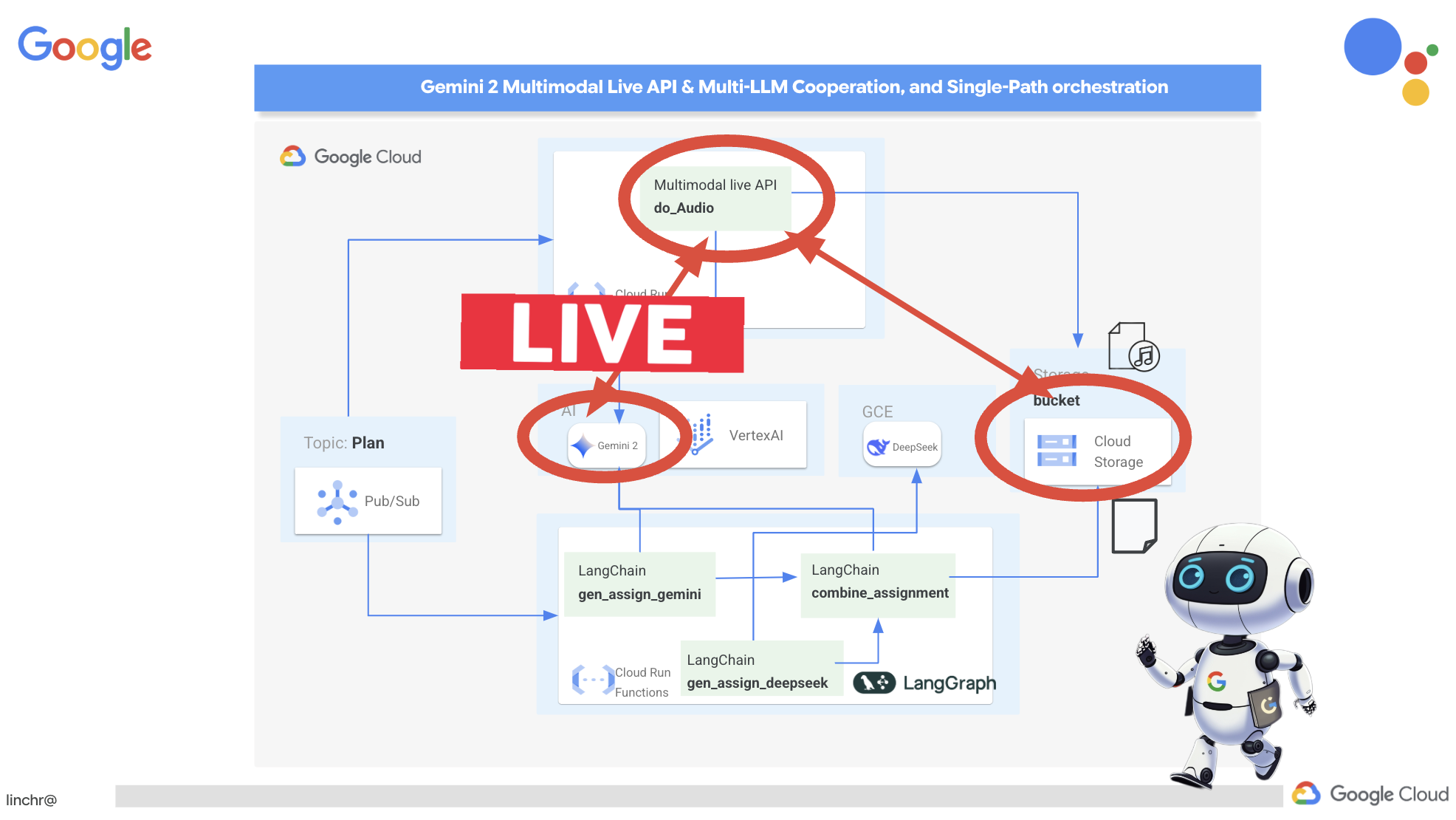

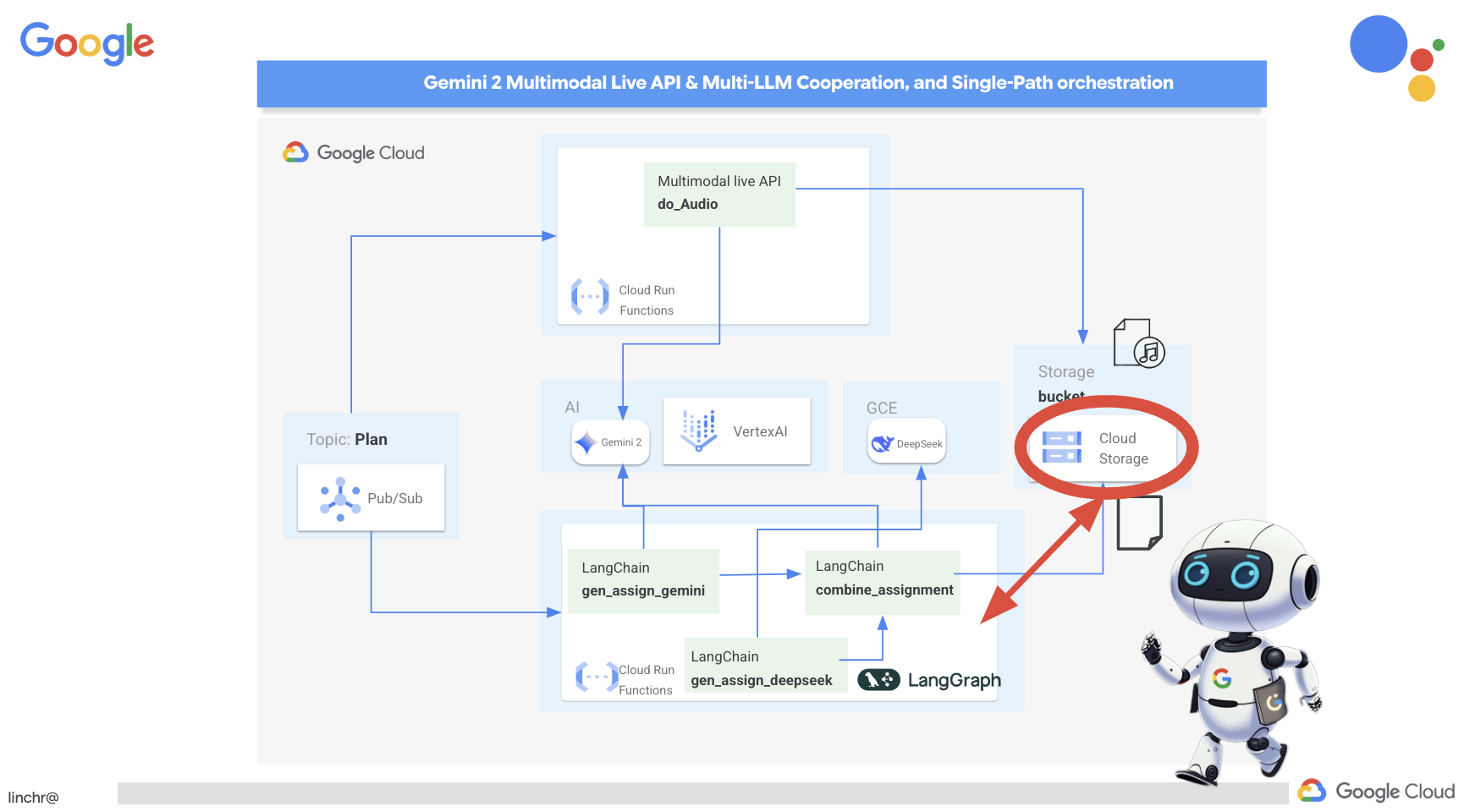

Agent-Orchestration nach Ihren Wünschen: Wir sehen uns verschiedene Möglichkeiten an, Ihre Agents zu orchestrieren – von einfachen geraden Pfaden bis hin zu komplexeren Szenarien mit mehreren Pfaden. Sie können sich das so vorstellen, dass Sie den Ablauf Ihres Agent-Teams steuern.

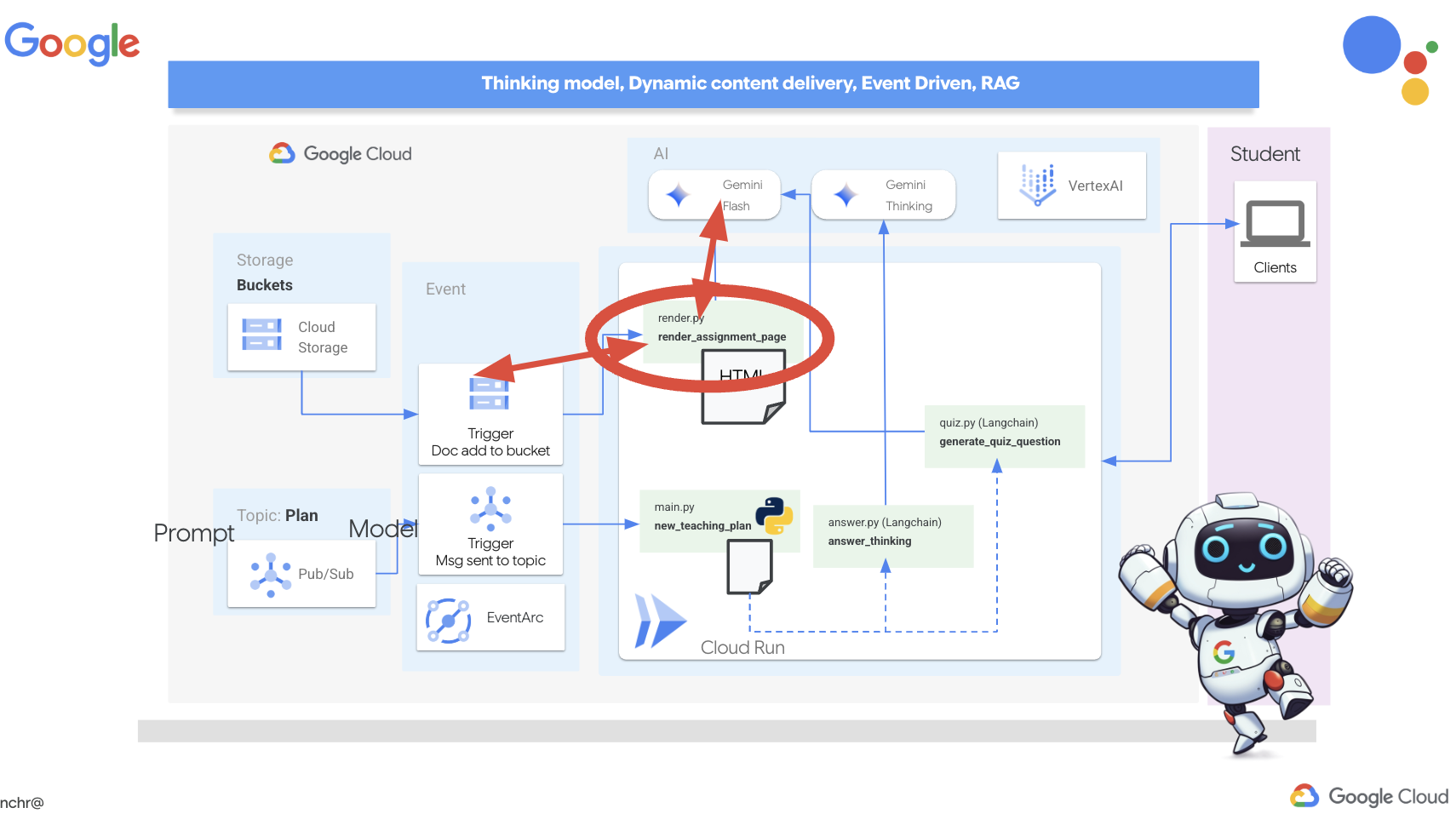

Multi-Agent-Systeme: Sie erfahren, wie Sie ein System einrichten, in dem Ihre Agents zusammenarbeiten und Aufgaben gemeinsam erledigen können – alles dank einer ereignisgesteuerten Architektur.

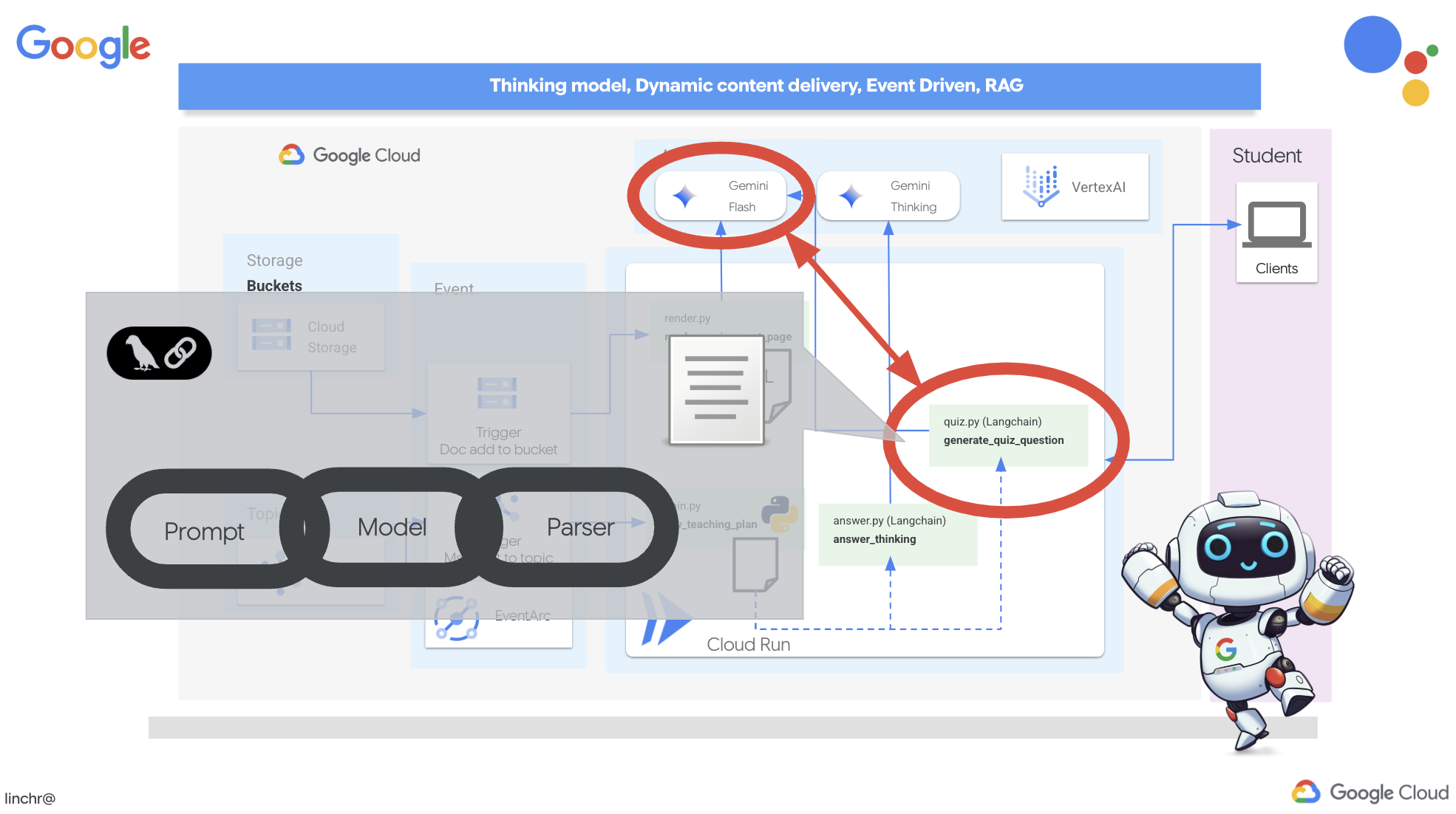

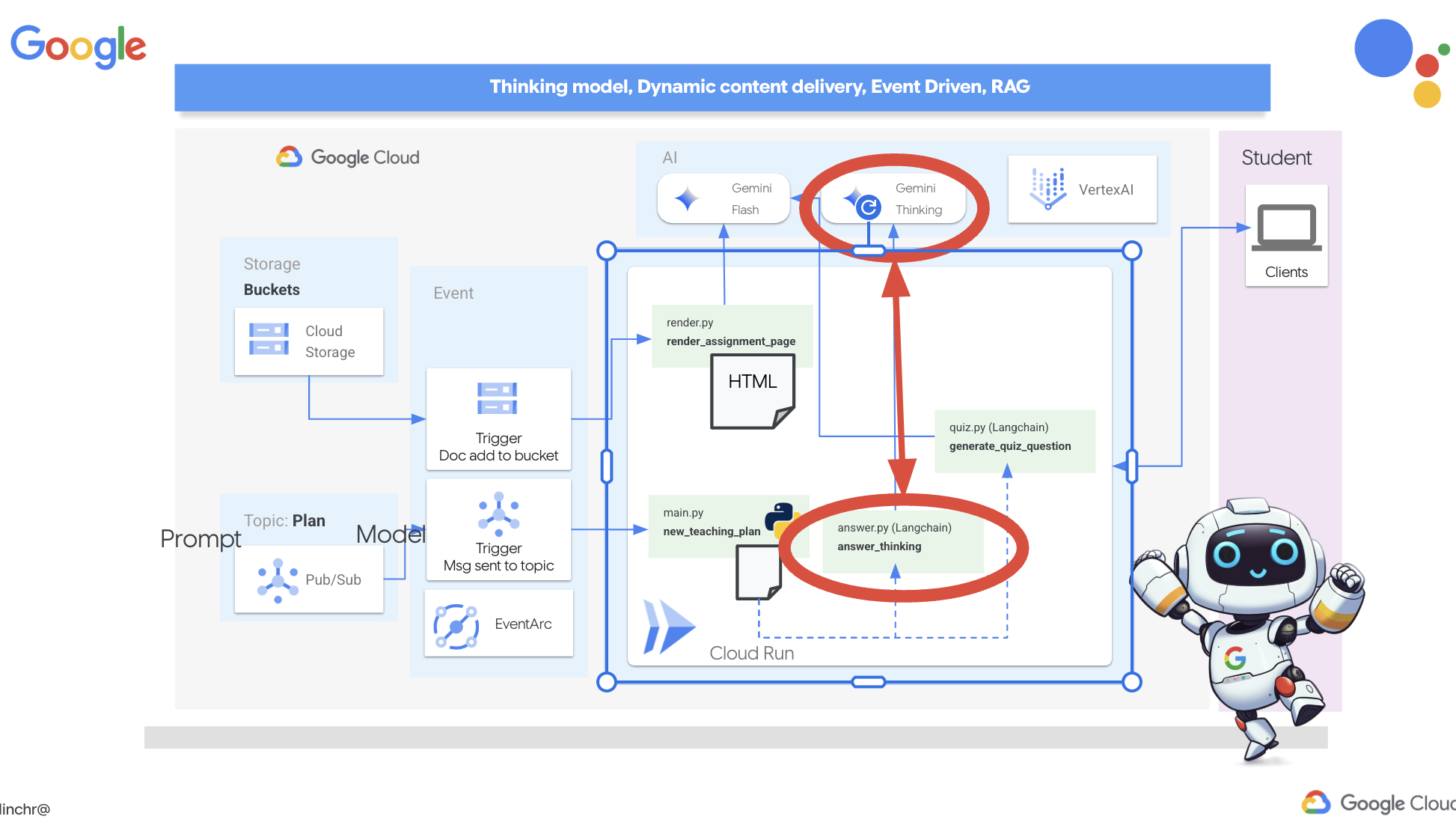

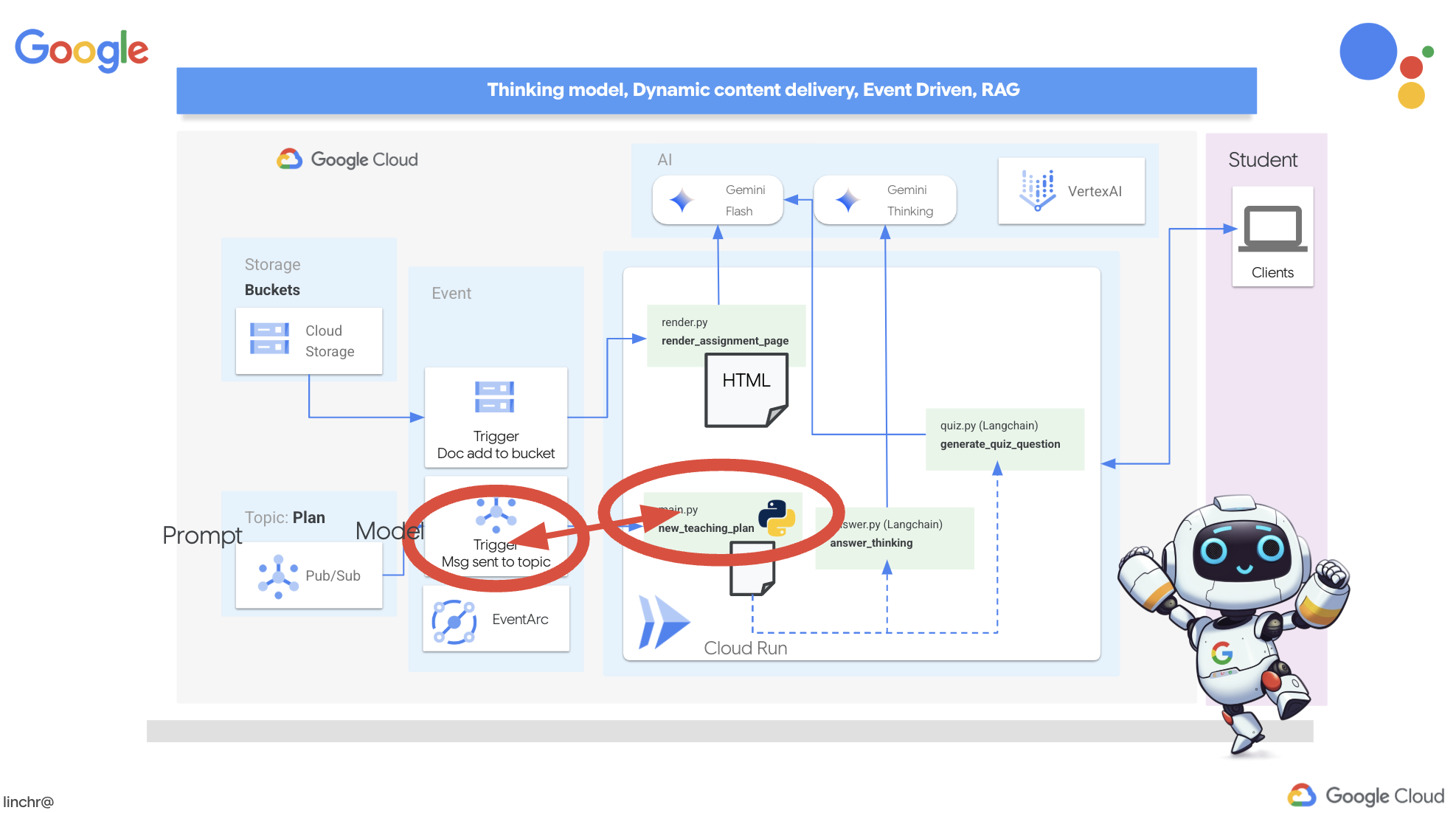

LLM-Freiheit: Das beste Tool für die jeweilige Aufgabe: Wir sind nicht auf ein einziges LLM beschränkt. Sie erfahren, wie Sie mehrere LLMs verwenden und ihnen verschiedene Rollen zuweisen können, um die Problemlösungsfähigkeit mithilfe von „Denkmodellen“ zu steigern.

Dynamischer Content? Kein Problem!: Stellen Sie sich vor, Ihr Agent erstellt dynamische Inhalte, die in Echtzeit speziell auf jeden Nutzer zugeschnitten sind. Wir zeigen Ihnen, wie das geht.

Taking it to the Cloud with Google Cloud: Hier geht es nicht nur darum, in einem Notebook zu spielen. Wir zeigen Ihnen, wie Sie Ihr Multi-Agent-System in Google Cloud entwerfen und bereitstellen, damit es für die reale Welt gerüstet ist.

Dieses Projekt ist ein gutes Beispiel dafür, wie Sie alle Techniken anwenden können, über die wir gesprochen haben.

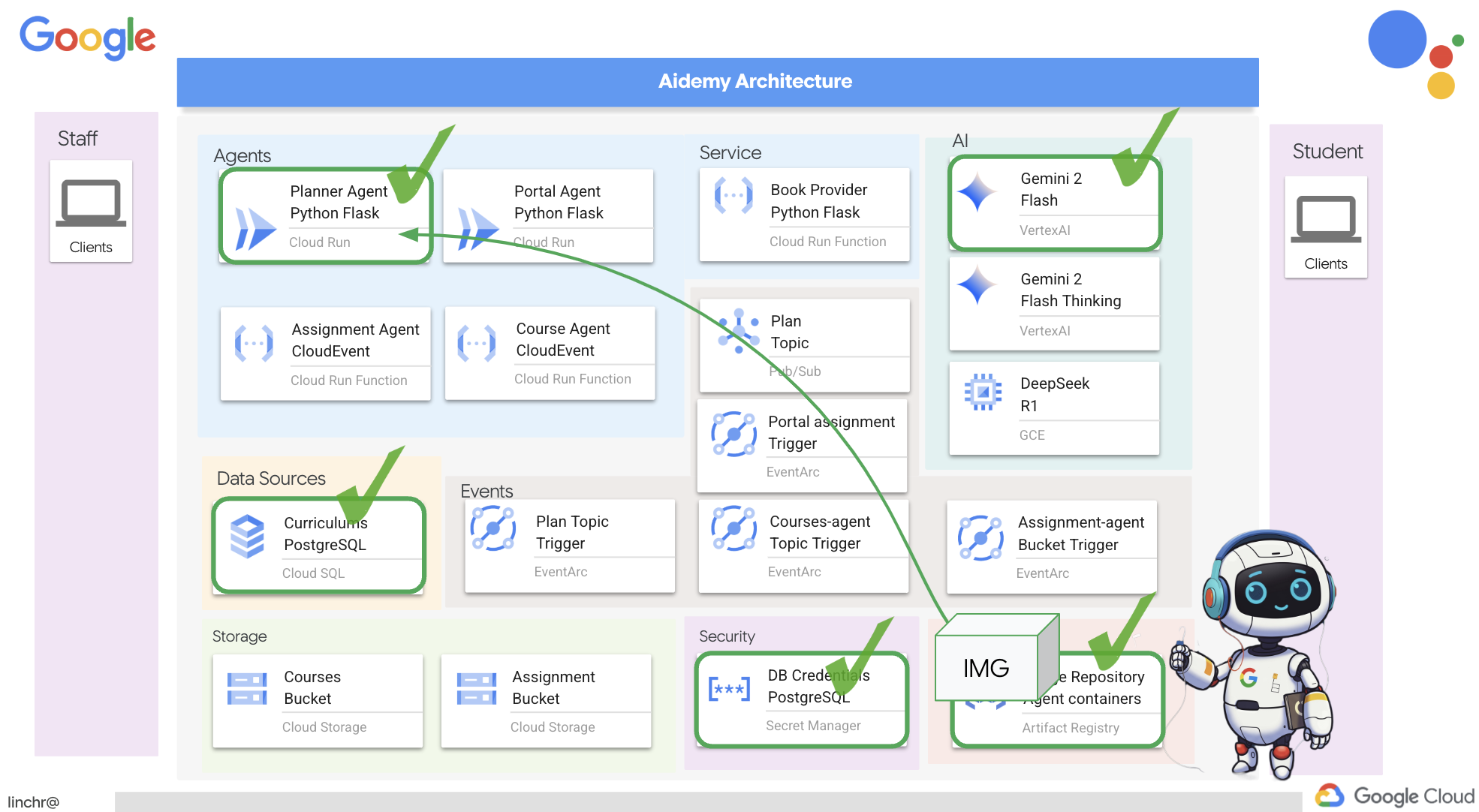

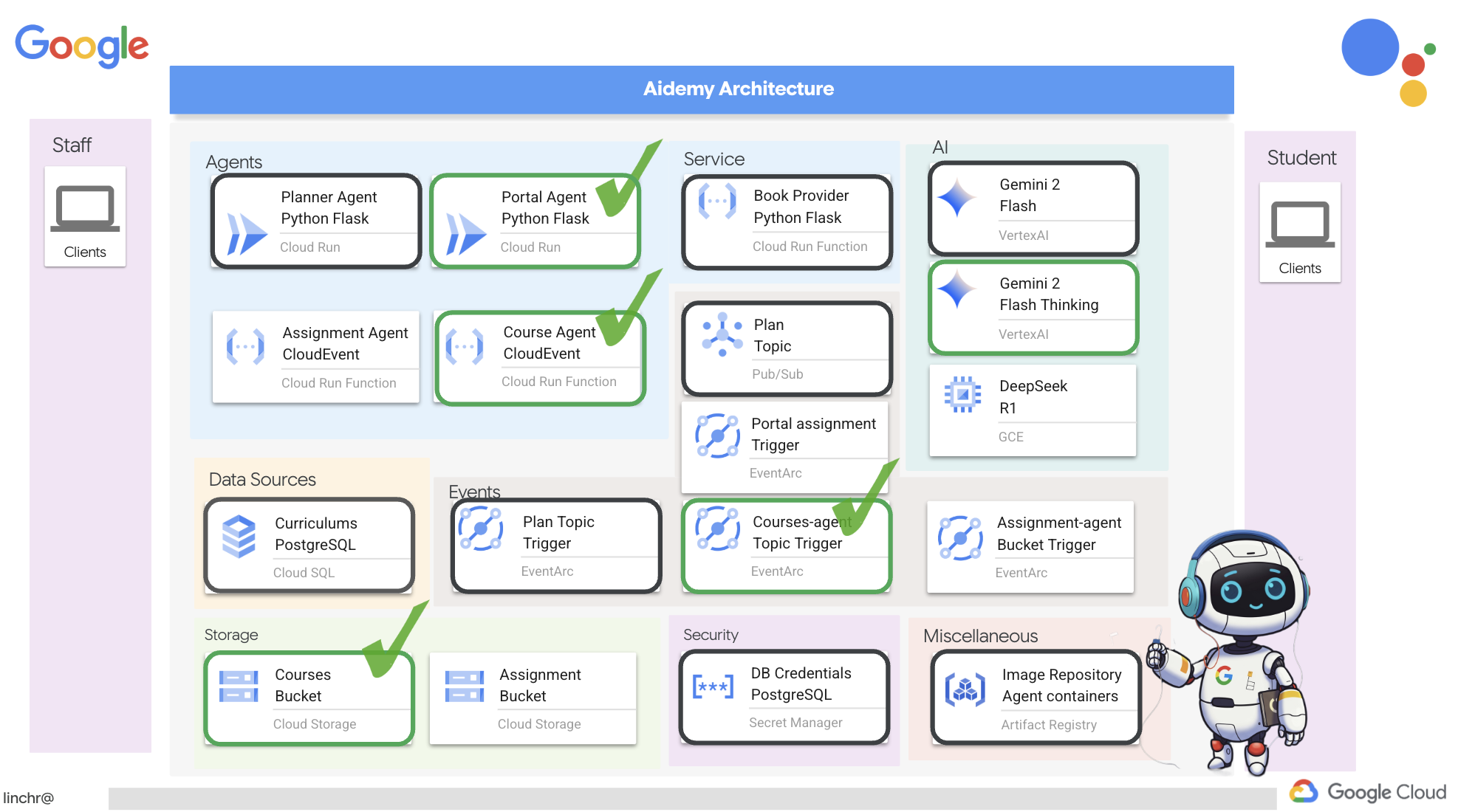

2. Architektur

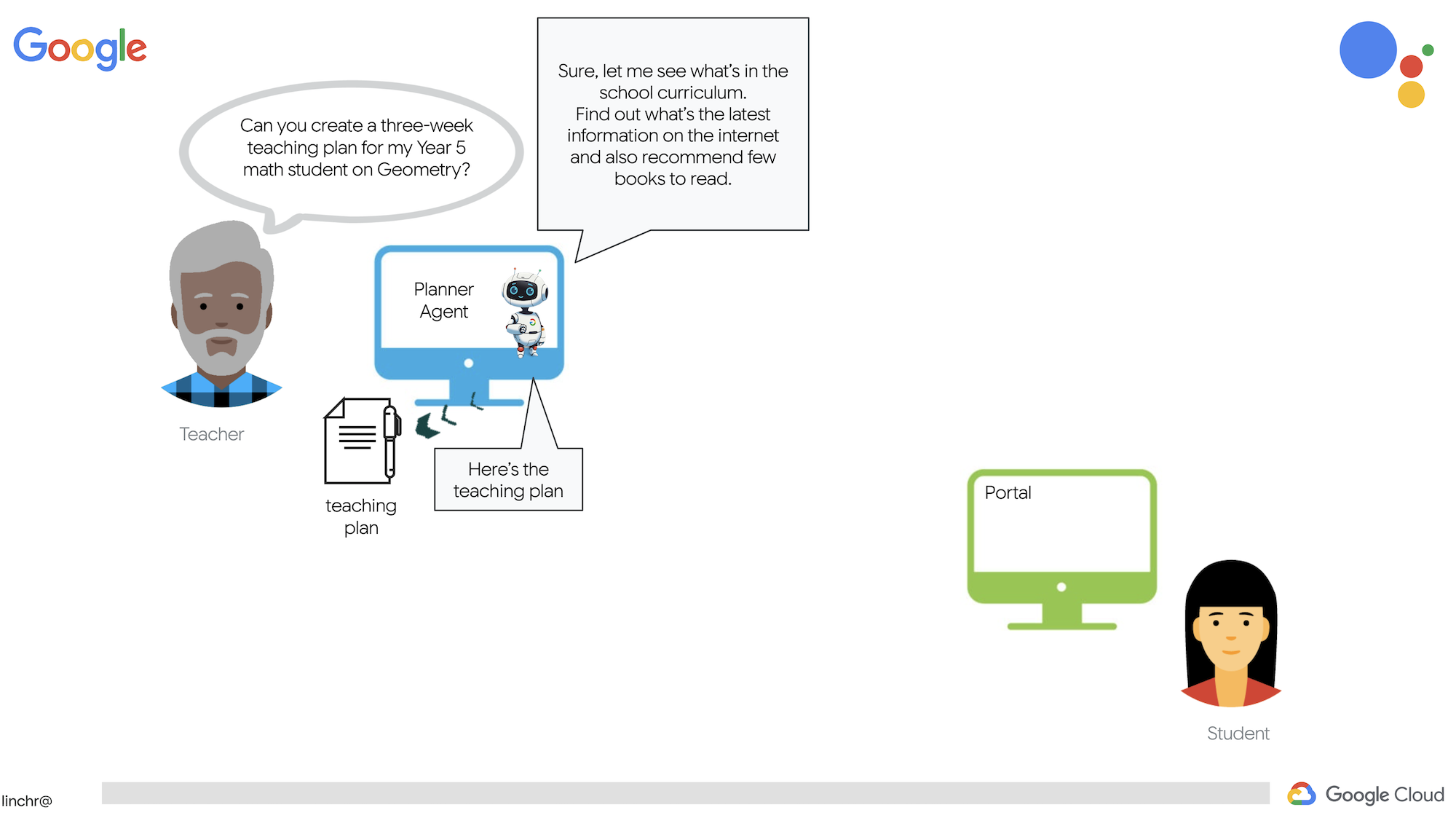

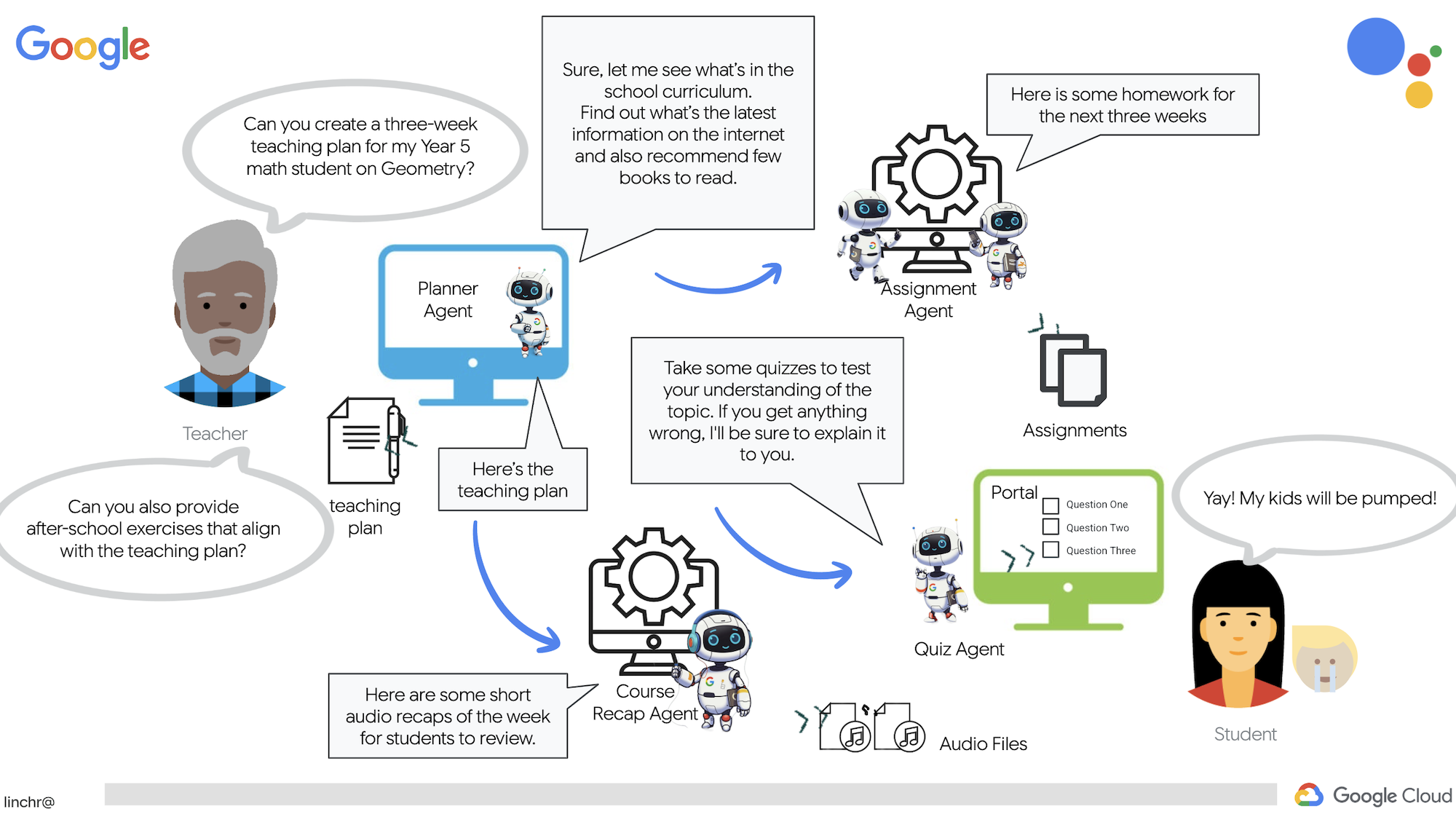

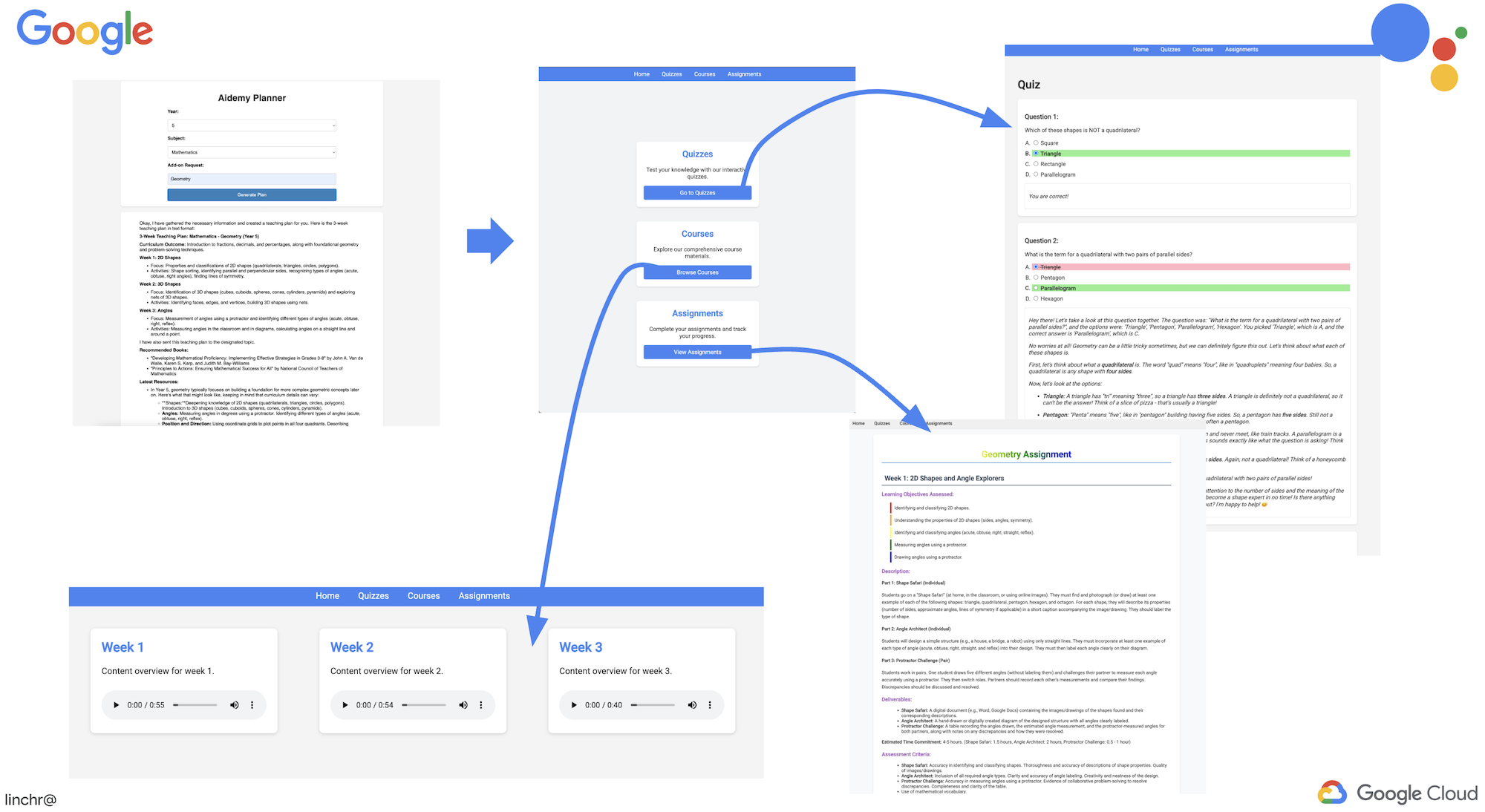

Lehrer zu sein oder im Bildungsbereich zu arbeiten, kann sehr erfüllend sein. Aber die Arbeitsbelastung, insbesondere die ganze Vorbereitung, kann eine Herausforderung sein. Außerdem gibt es oft nicht genügend Personal und Nachhilfe kann teuer sein. Deshalb schlagen wir einen KI-basierten Lehrassistenten vor. Dieses Tool kann Lehrkräfte entlasten und dazu beitragen, die Lücke zu schließen, die durch Personalmangel und den Mangel an erschwinglichen Nachhilfeangeboten entsteht.

Unser KI-Lehrassistent kann detaillierte Unterrichtspläne, unterhaltsame Quizfragen, leicht verständliche Audio-Zusammenfassungen und personalisierte Aufgaben erstellen. So können sich Lehrkräfte auf das konzentrieren, was sie am besten können: mit Schülern in Kontakt treten und ihnen helfen, Spaß am Lernen zu entwickeln.

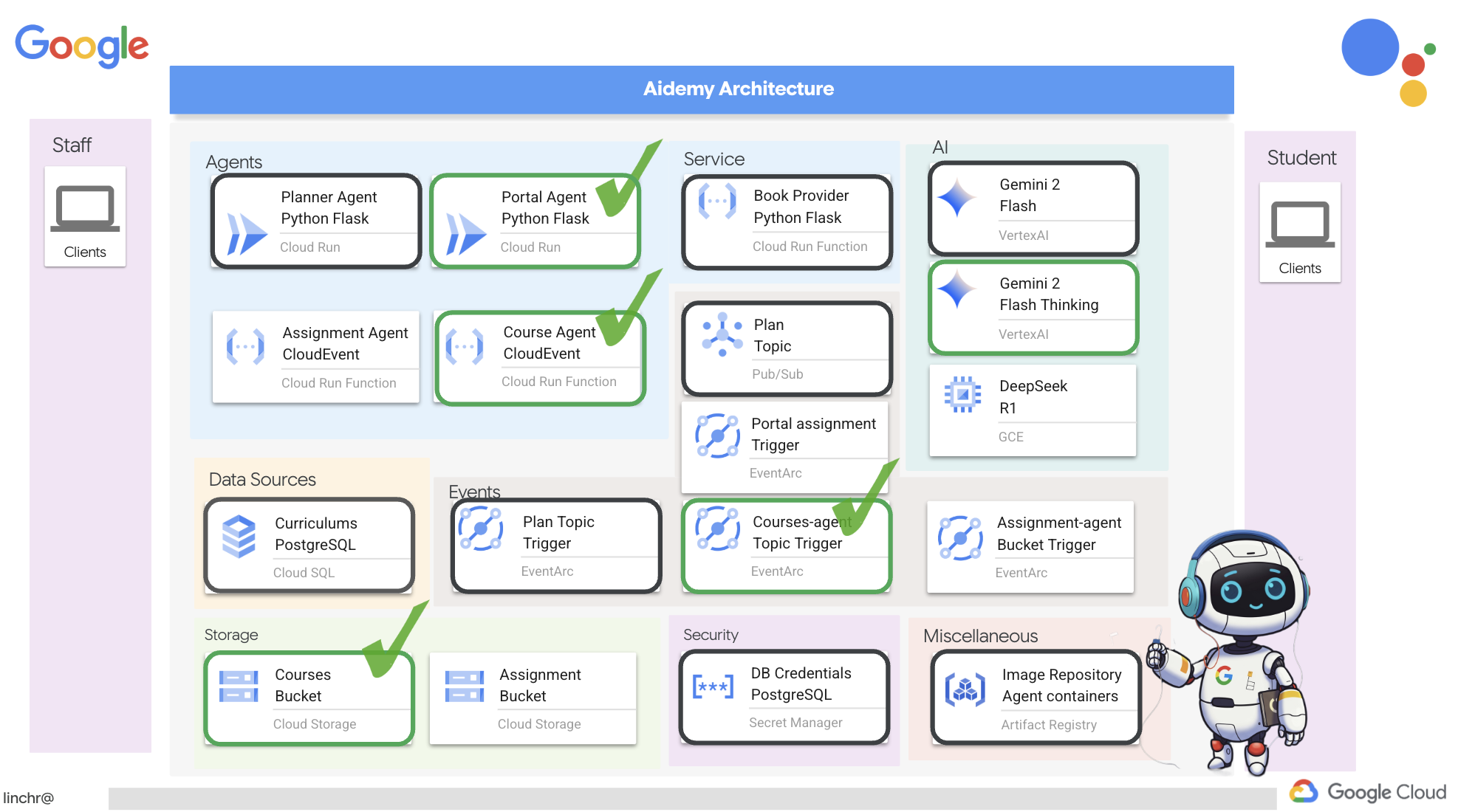

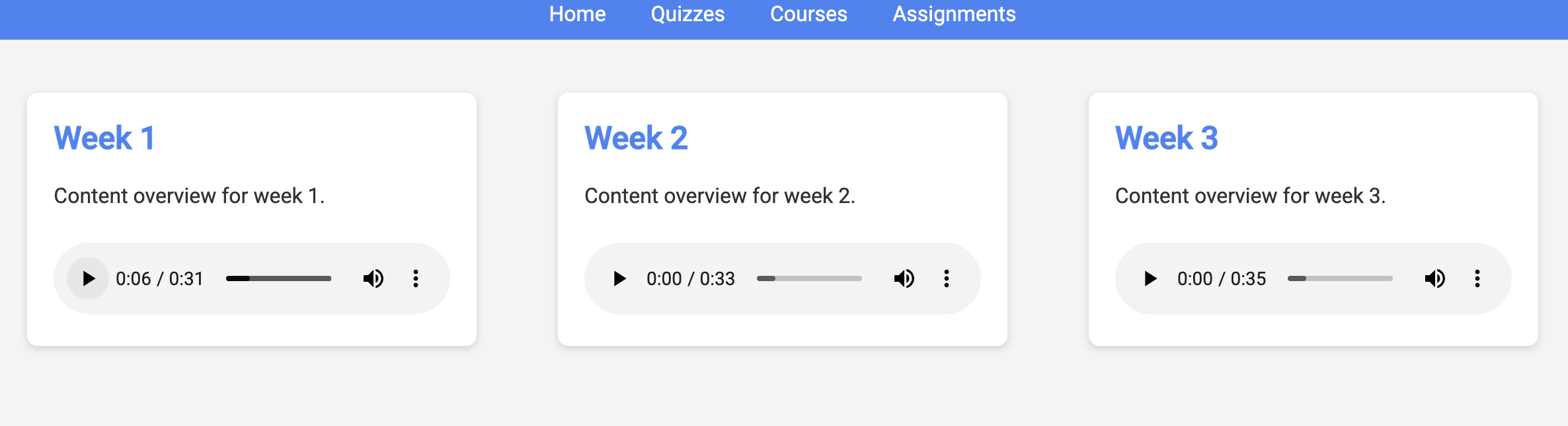

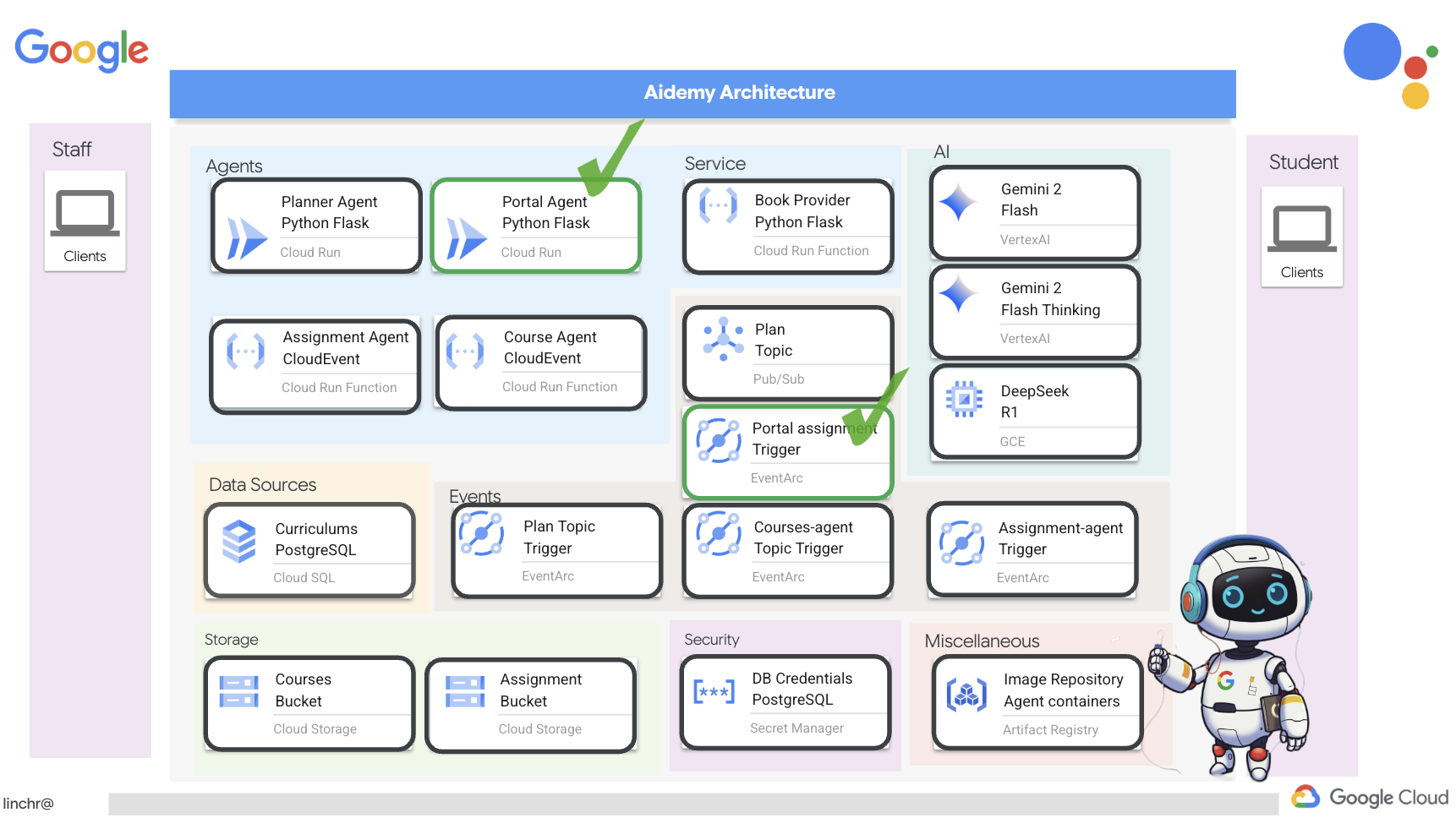

Das System hat zwei Websites: eine für Lehrkräfte, um Unterrichtspläne für die kommenden Wochen zu erstellen,

und eine für Schüler und Studenten, um auf Quizze, Audiozusammenfassungen und Aufgaben zuzugreifen.

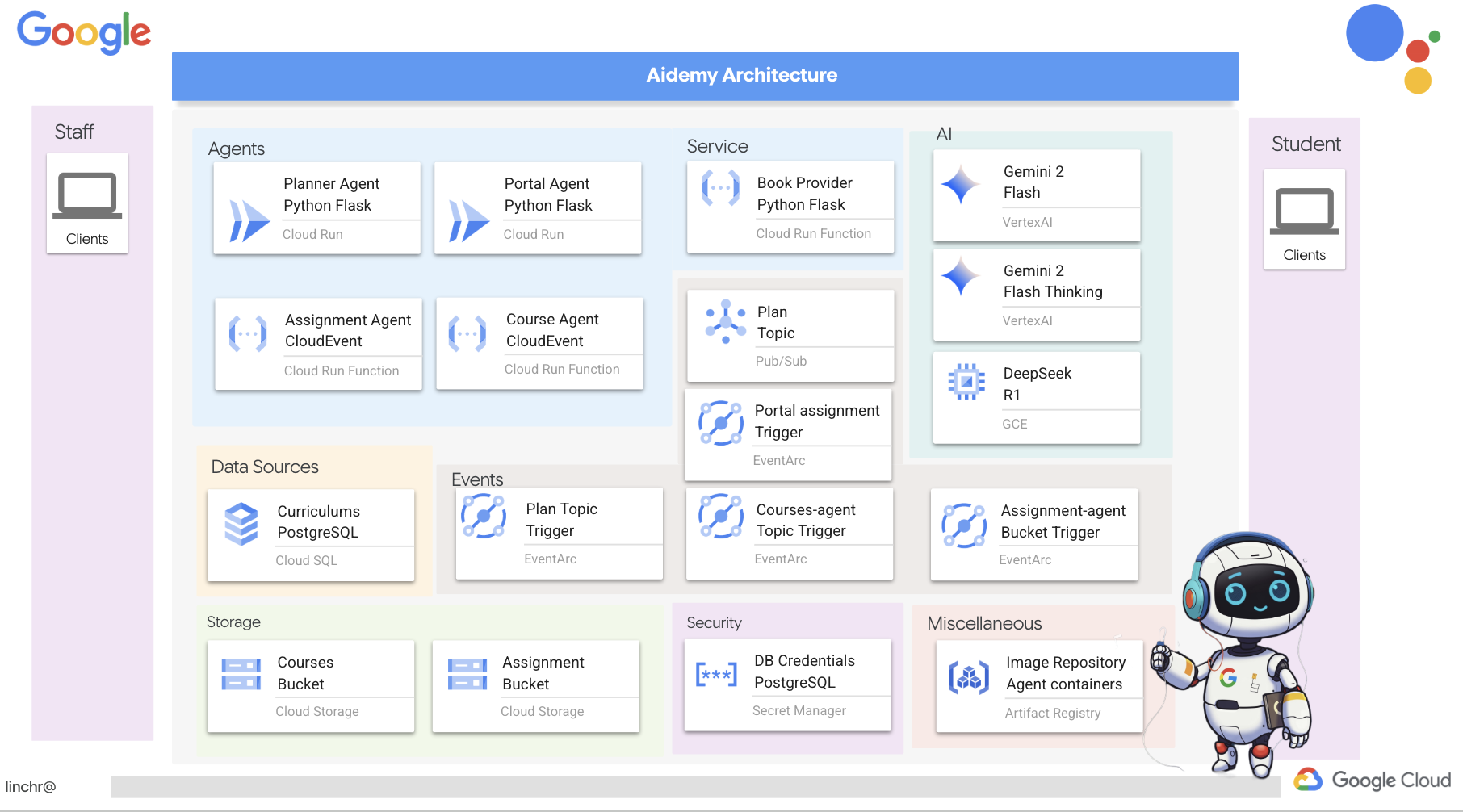

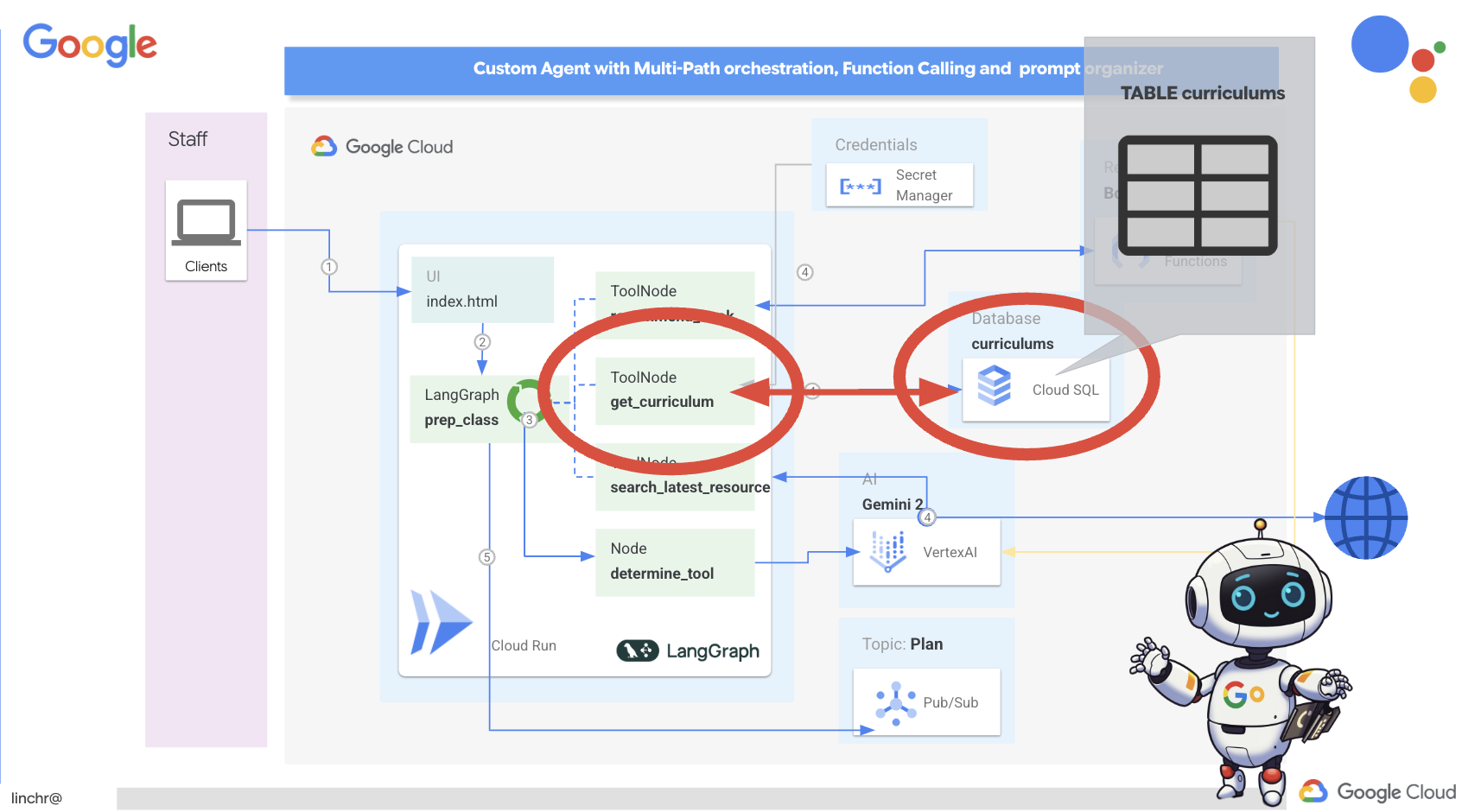

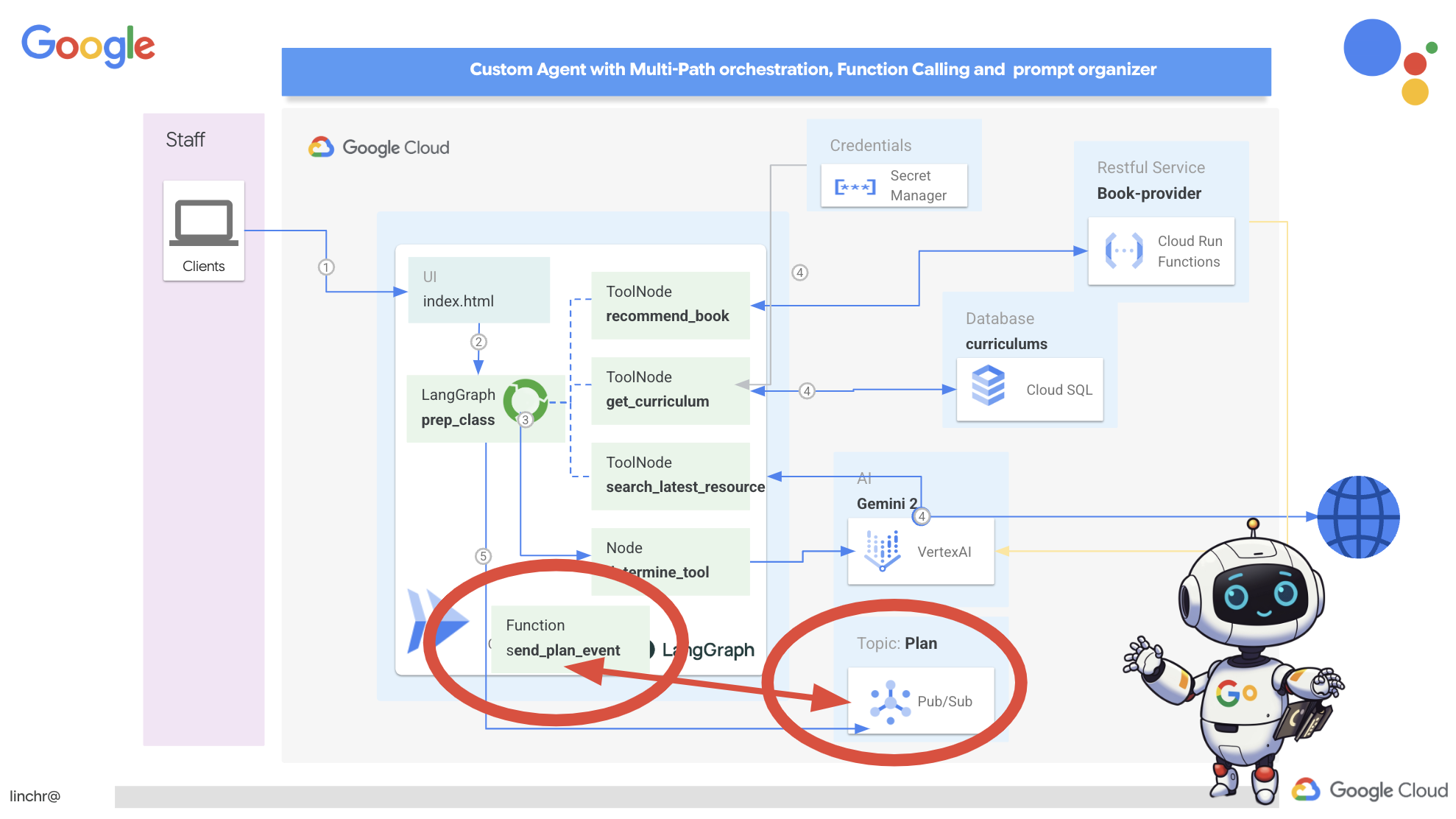

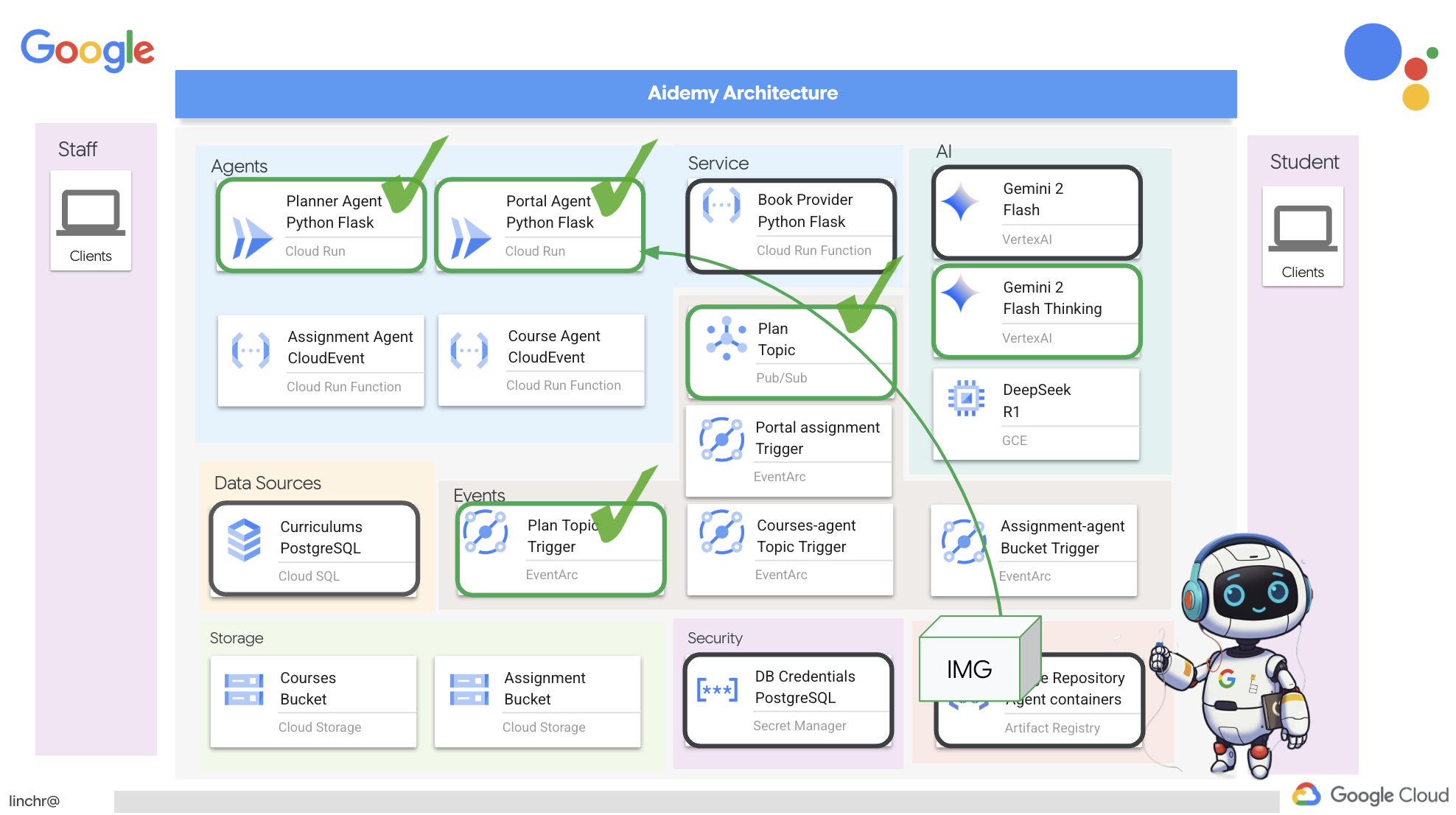

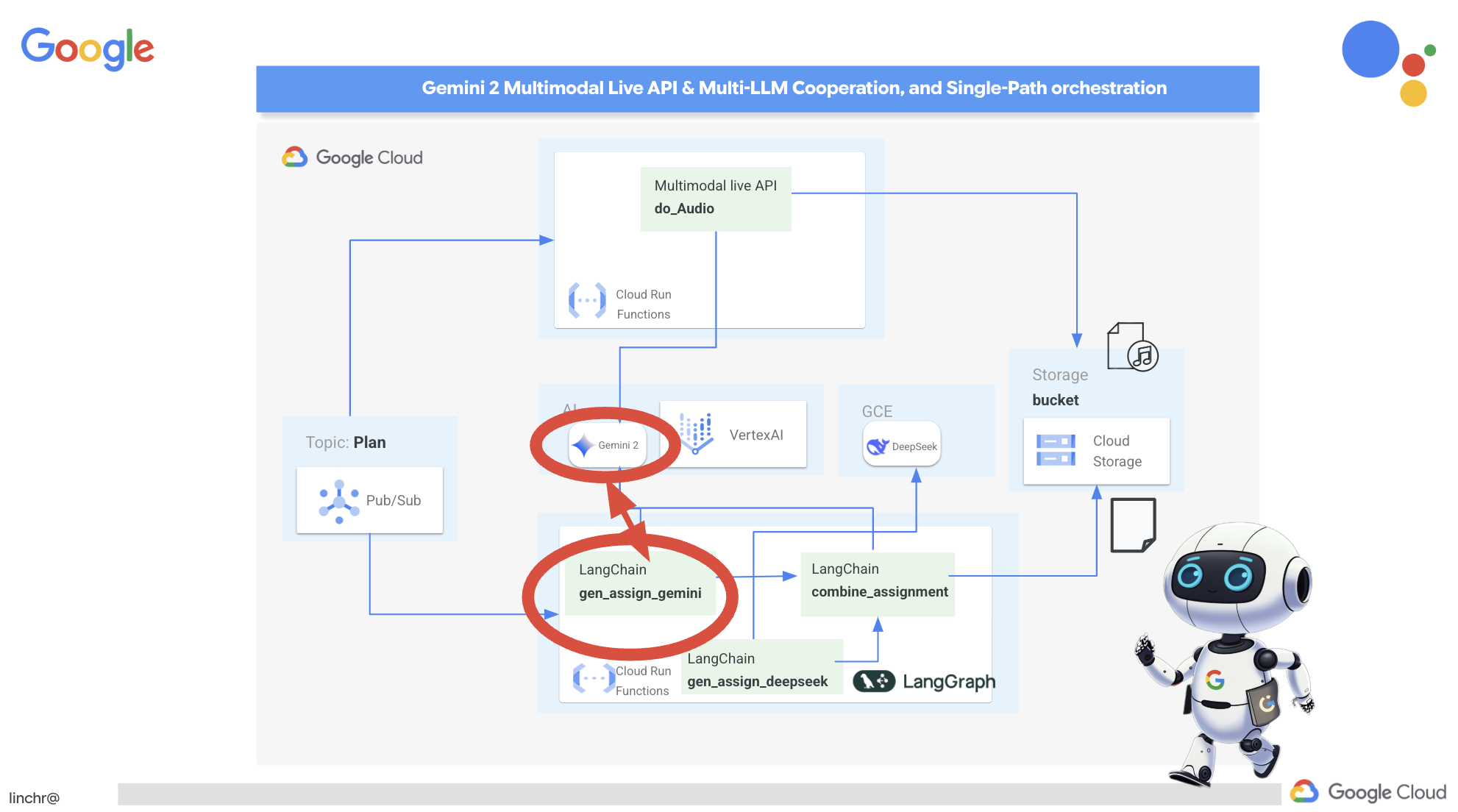

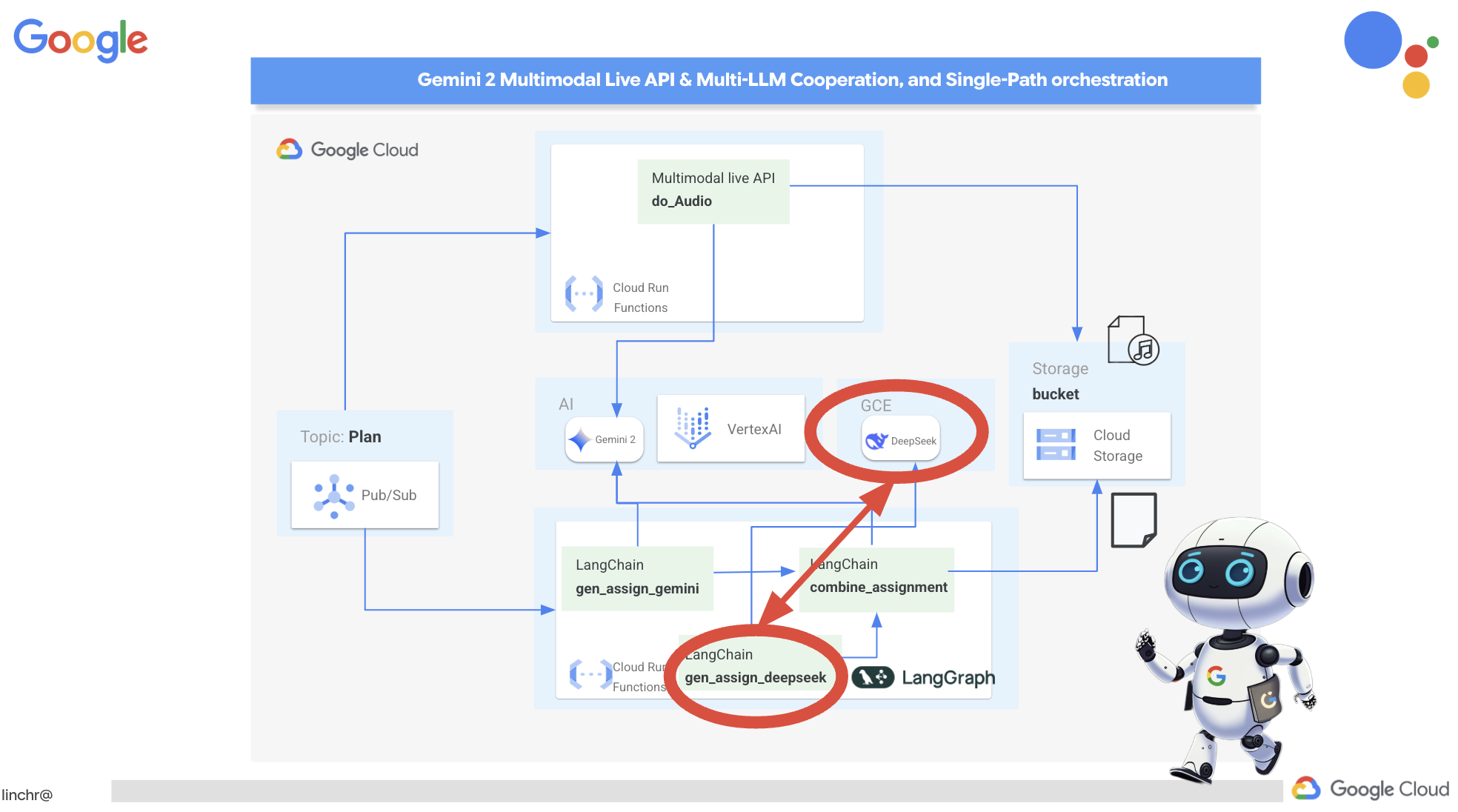

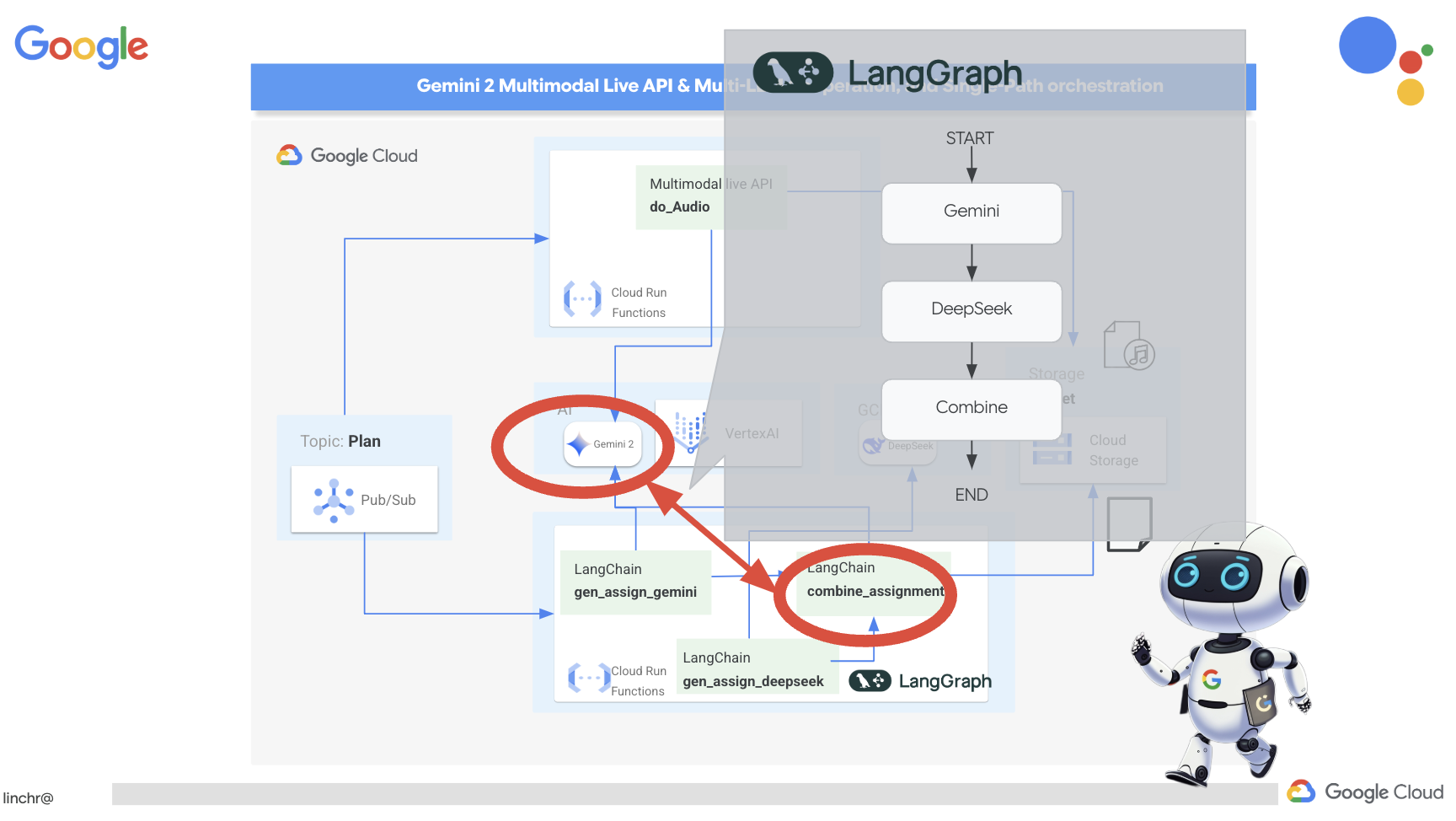

Sehen wir uns nun die Architektur an, die unserem Lehrassistenten Aidemy zugrunde liegt. Wie Sie sehen, haben wir den Prozess in mehrere Schlüsselkomponenten unterteilt, die alle zusammenarbeiten, um dies zu ermöglichen.

Wichtige Architekturelemente und Technologien:

Google Cloud Platform (GCP): Zentral für das gesamte System:

- Vertex AI: Greift auf die Gemini-LLMs von Google zu.

- Cloud Run: Serverlose Plattform zum Bereitstellen von containerisierten Agents und Funktionen.

- Cloud SQL: PostgreSQL-Datenbank für Lehrplandaten.

- Pub/Sub und Eventarc: Grundlage der ereignisgesteuerten Architektur, die die asynchrone Kommunikation zwischen Komponenten ermöglicht.

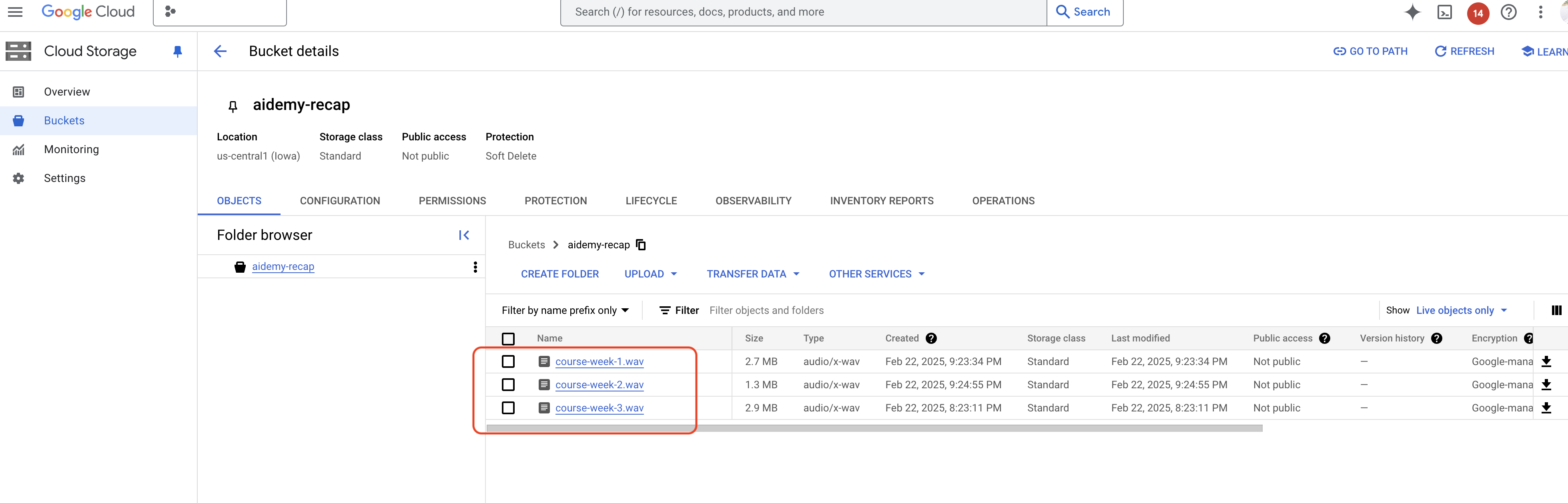

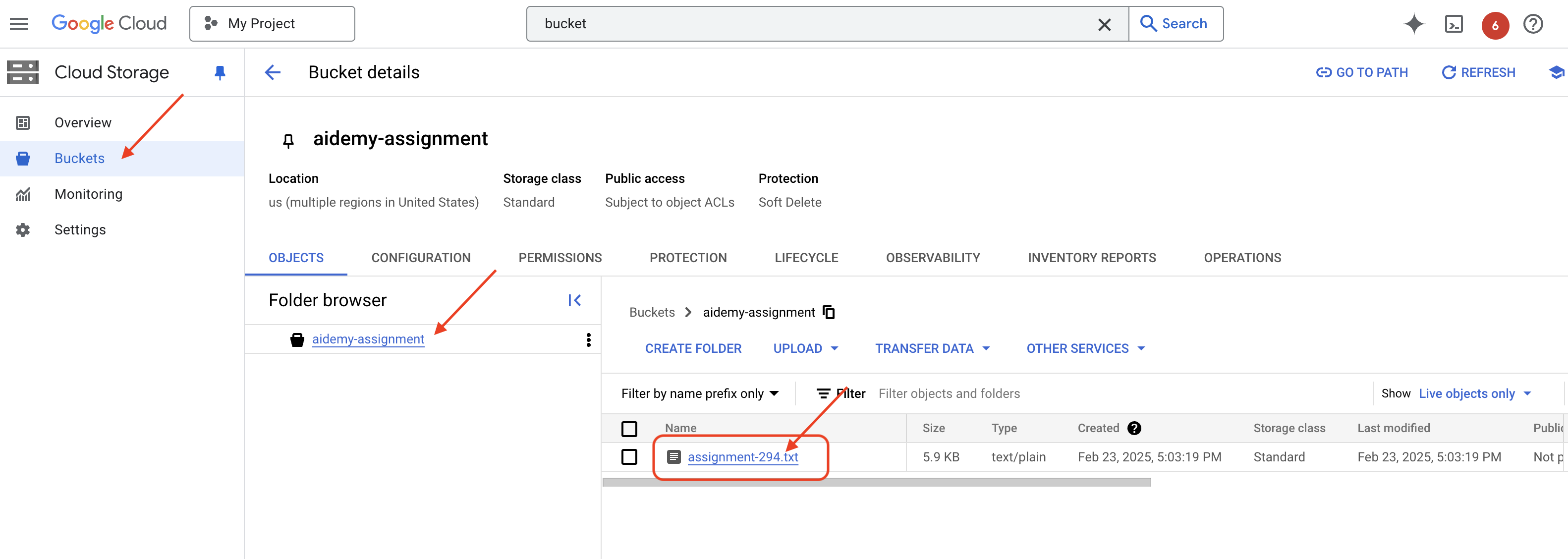

- Cloud Storage: Hier werden Audiozusammenfassungen und Aufgaben-Dateien gespeichert.

- Secret Manager: Verwaltet Datenbankanmeldedaten sicher.

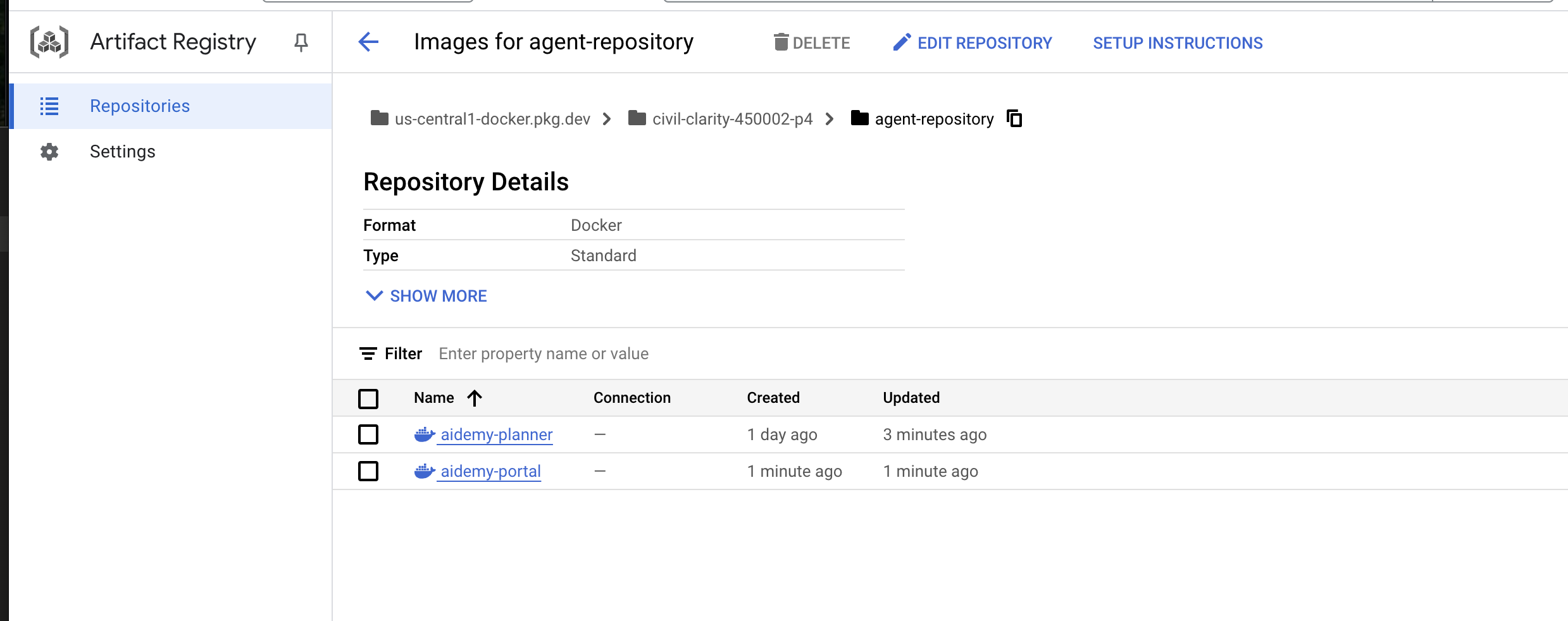

- Artifact Registry: Speichert Docker-Images für die Agents.

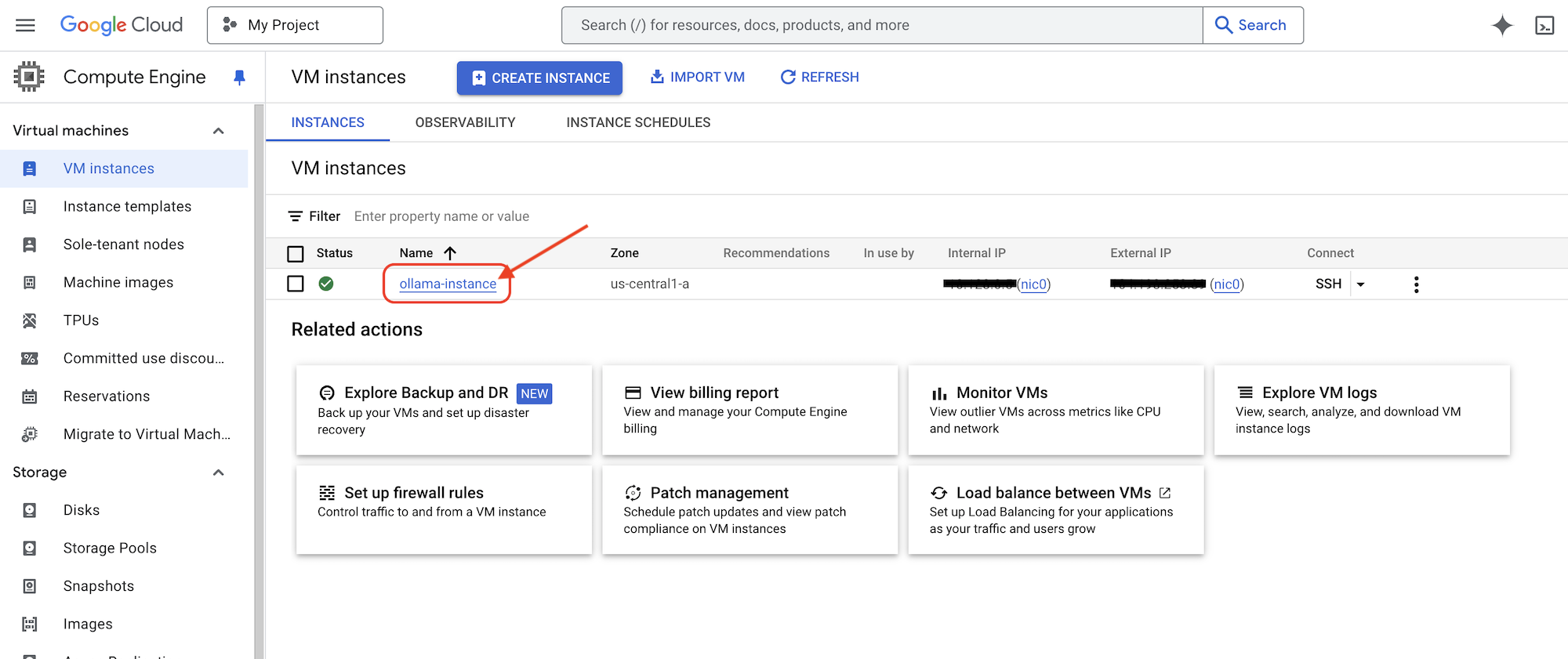

- Compute Engine: Selbstgehostete LLMs bereitstellen, anstatt auf Anbieterlösungen zu setzen

LLMs: Das „Gehirn“ des Systems:

- Gemini-Modelle von Google: (Gemini x Pro, Gemini x Flash, Gemini x Flash Thinking) Werden für die Unterrichtsplanung, die Erstellung von Inhalten, die dynamische HTML-Erstellung, die Erklärung von Quizfragen und die Kombination der Aufgaben verwendet.

- DeepSeek: Wird für die spezielle Aufgabe verwendet, Aufgaben für das Selbststudium zu generieren.

LangChain und LangGraph: Frameworks für die LLM-Anwendungsentwicklung

- Erleichtert die Erstellung komplexer Multi-Agent-Workflows.

- Ermöglicht die intelligente Orchestrierung von Tools (API-Aufrufe, Datenbankabfragen, Websuchen).

- Implementiert eine ereignisgesteuerte Architektur für Systemskalierbarkeit und ‑flexibilität.

Im Wesentlichen kombiniert unsere Architektur die Leistungsfähigkeit von LLMs mit strukturierten Daten und ereignisgesteuerter Kommunikation, die alle in Google Cloud ausgeführt werden. So können wir einen skalierbaren, zuverlässigen und effektiven Lehrassistenten entwickeln.

3. Hinweis

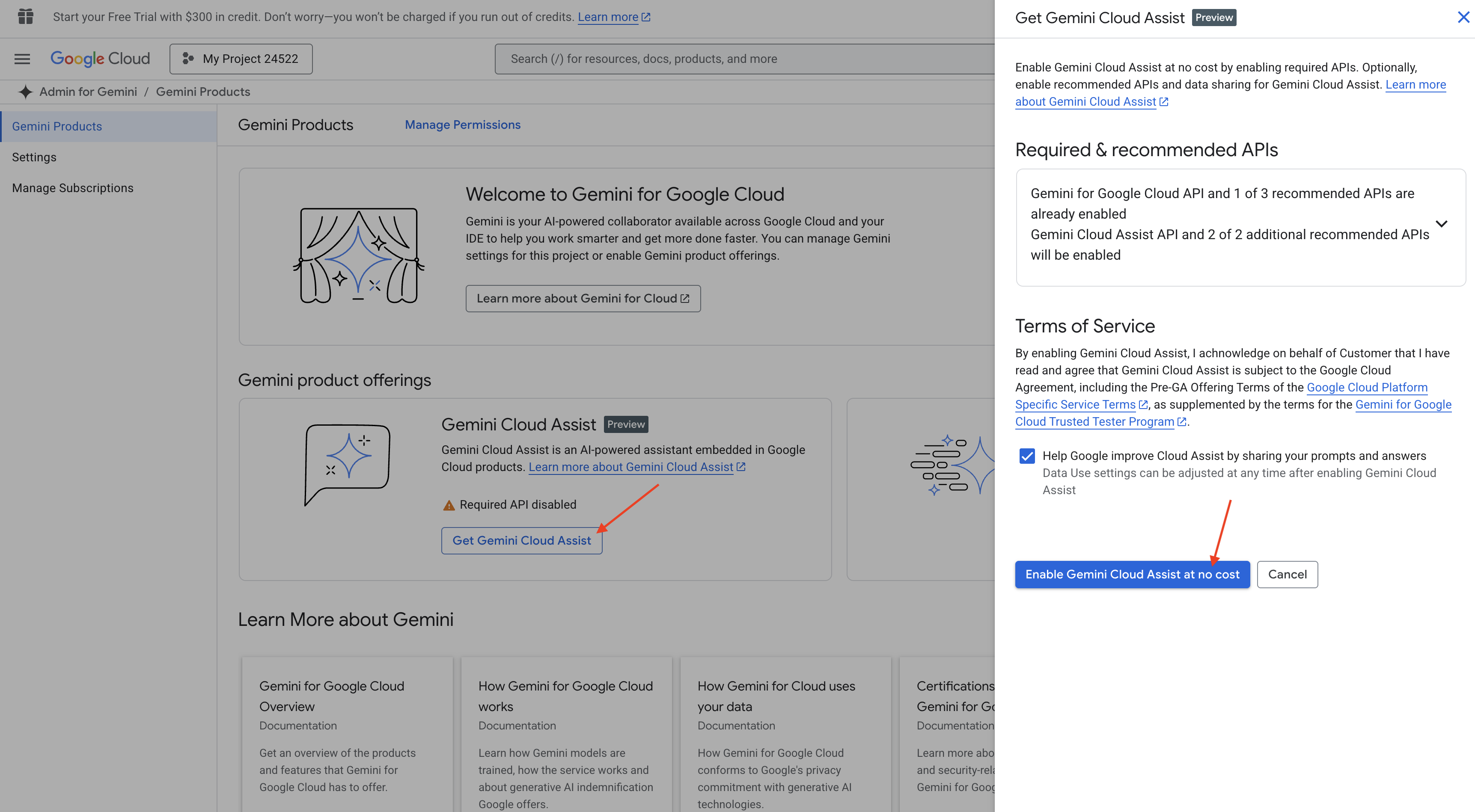

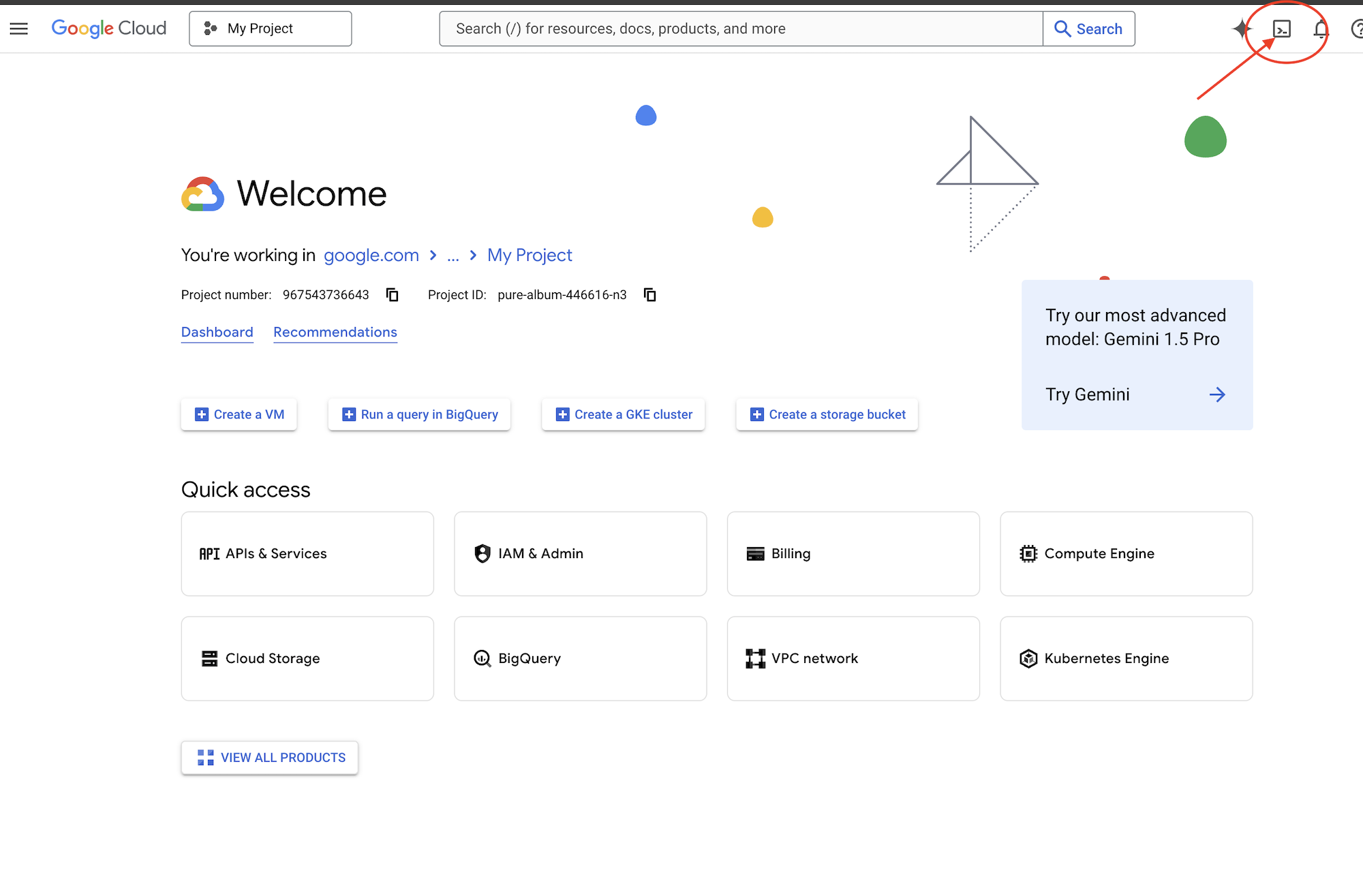

Wählen Sie in der Google Cloud Console auf der Seite zur Projektauswahl ein Google Cloud-Projekt aus oder erstellen Sie eines. Die Abrechnung für das Cloud-Projekt muss aktiviert sein. So prüfen Sie, ob die Abrechnung für ein Projekt aktiviert ist.

Gemini Code Assist in der Cloud Shell-IDE aktivieren

👉 Rufen Sie in der Google Cloud Console die Gemini Code Assist-Tools auf und aktivieren Sie Gemini Code Assist kostenlos, indem Sie den Nutzungsbedingungen zustimmen.

Ignorieren Sie die Einrichtung der Berechtigungen und verlassen Sie diese Seite.

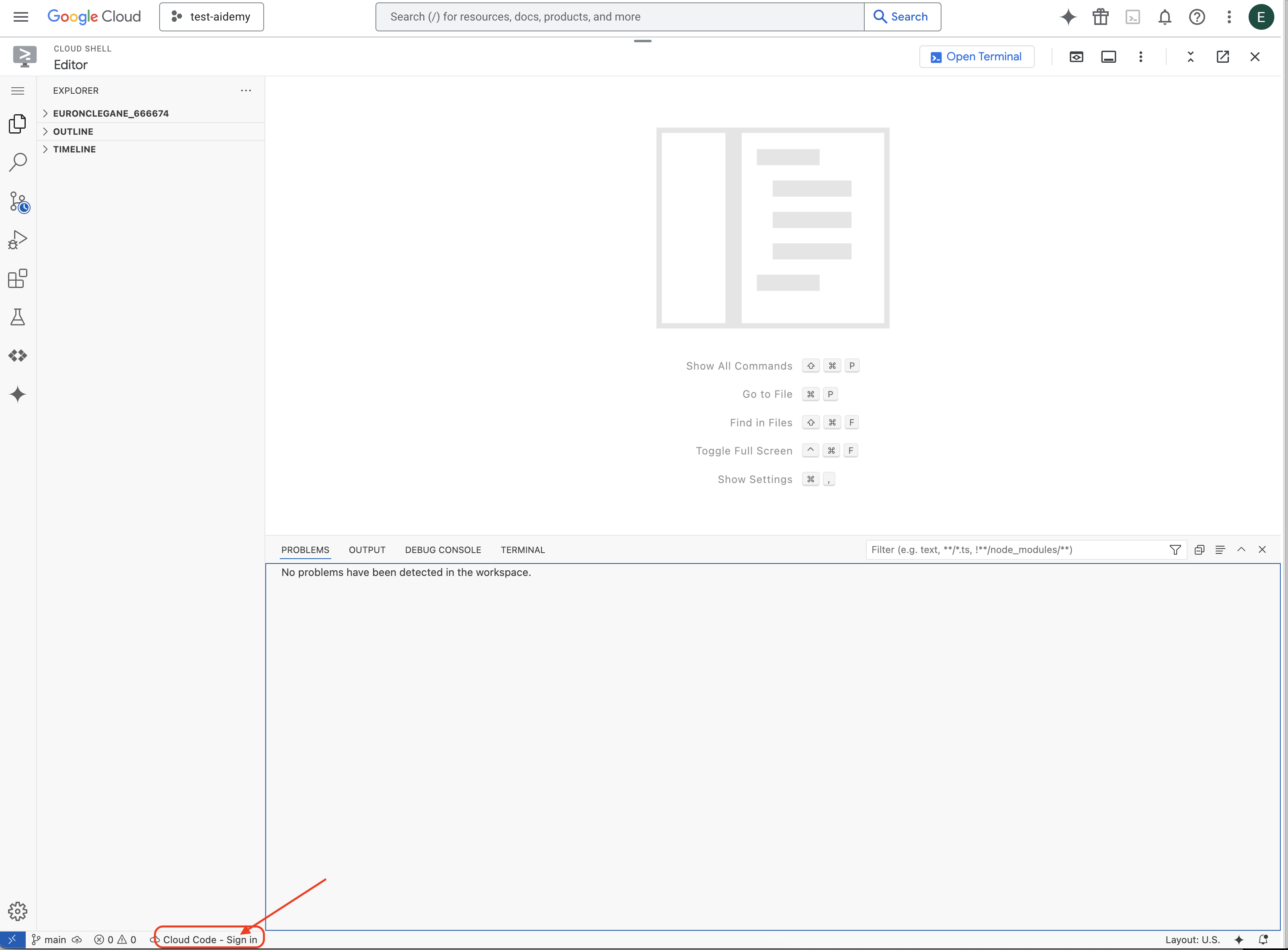

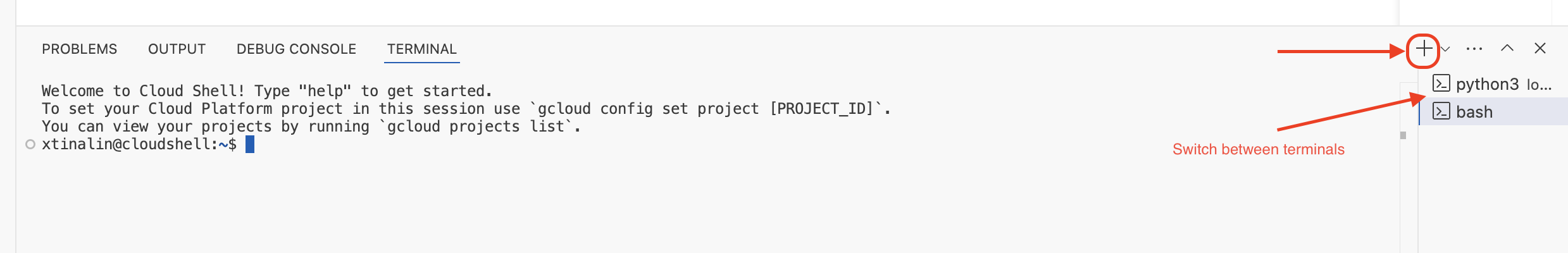

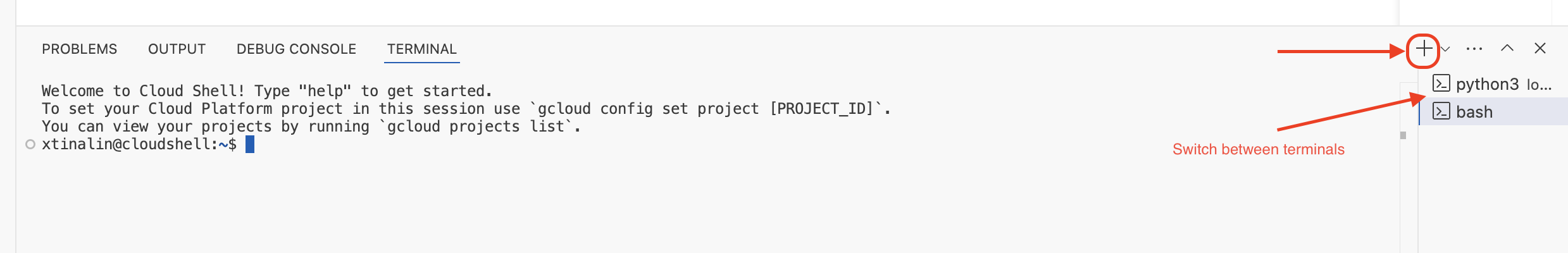

Mit dem Cloud Shell-Editor arbeiten

👉 Klicken Sie oben in der Google Cloud Console auf Cloud Shell aktivieren (das Symbol für das Terminal oben im Cloud Shell-Bereich). Klicken Sie dann auf die Schaltfläche Editor öffnen (sie sieht aus wie ein geöffneter Ordner mit einem Stift). Dadurch wird der Cloud Shell-Code-Editor im Fenster geöffnet. Auf der linken Seite sehen Sie einen Datei-Explorer.

👉 Klicken Sie in der unteren Statusleiste auf die Schaltfläche Cloud Code-Anmeldung, wie unten dargestellt. Autorisieren Sie das Plug-in wie beschrieben. Wenn in der Statusleiste Cloud Code – kein Projekt angezeigt wird, wählen Sie diese Option im Drop-down-Menü „Google Cloud-Projekt auswählen“ aus und wählen Sie dann das gewünschte Google Cloud-Projekt aus der Liste der Projekte aus, die Sie erstellt haben.

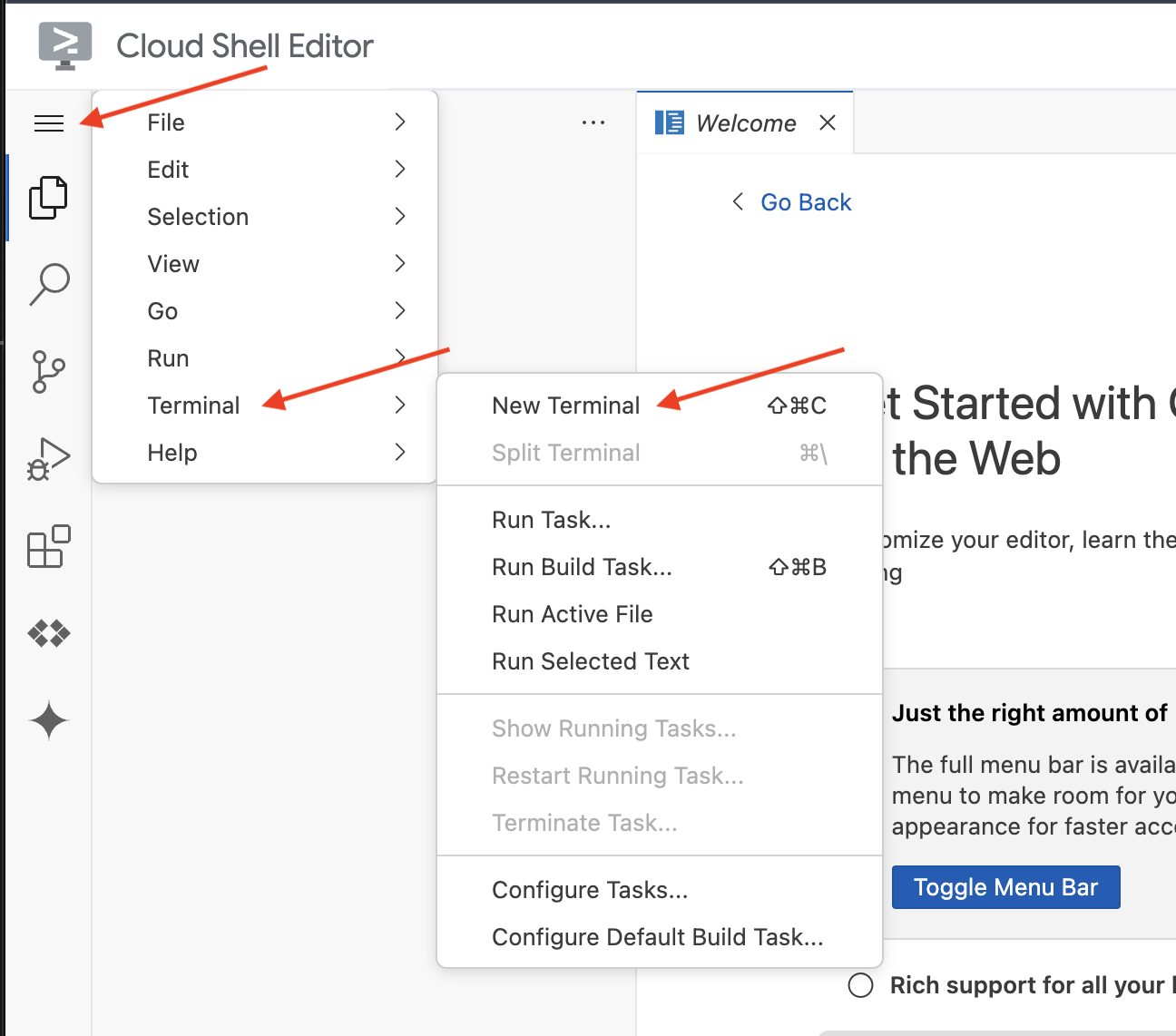

👉 Öffnen Sie das Terminal in der Cloud-IDE  oder

oder  .

.

👉 Prüfen Sie im Terminal mit dem folgenden Befehl, ob Sie bereits authentifiziert sind und das Projekt auf Ihre Projekt-ID festgelegt ist:

gcloud auth list

👉 Ersetzen Sie <YOUR_PROJECT_ID> durch Ihre Projekt-ID:

echo <YOUR_PROJECT_ID> > ~/project_id.txt

gcloud config set project $(cat ~/project_id.txt)

👉 Führen Sie den folgenden Befehl aus, um die erforderlichen Google Cloud APIs zu aktivieren:

gcloud services enable compute.googleapis.com \

storage.googleapis.com \

run.googleapis.com \

artifactregistry.googleapis.com \

aiplatform.googleapis.com \

eventarc.googleapis.com \

sqladmin.googleapis.com \

secretmanager.googleapis.com \

cloudbuild.googleapis.com \

cloudresourcemanager.googleapis.com \

cloudfunctions.googleapis.com \

cloudaicompanion.googleapis.com

Das kann einige Minuten dauern.

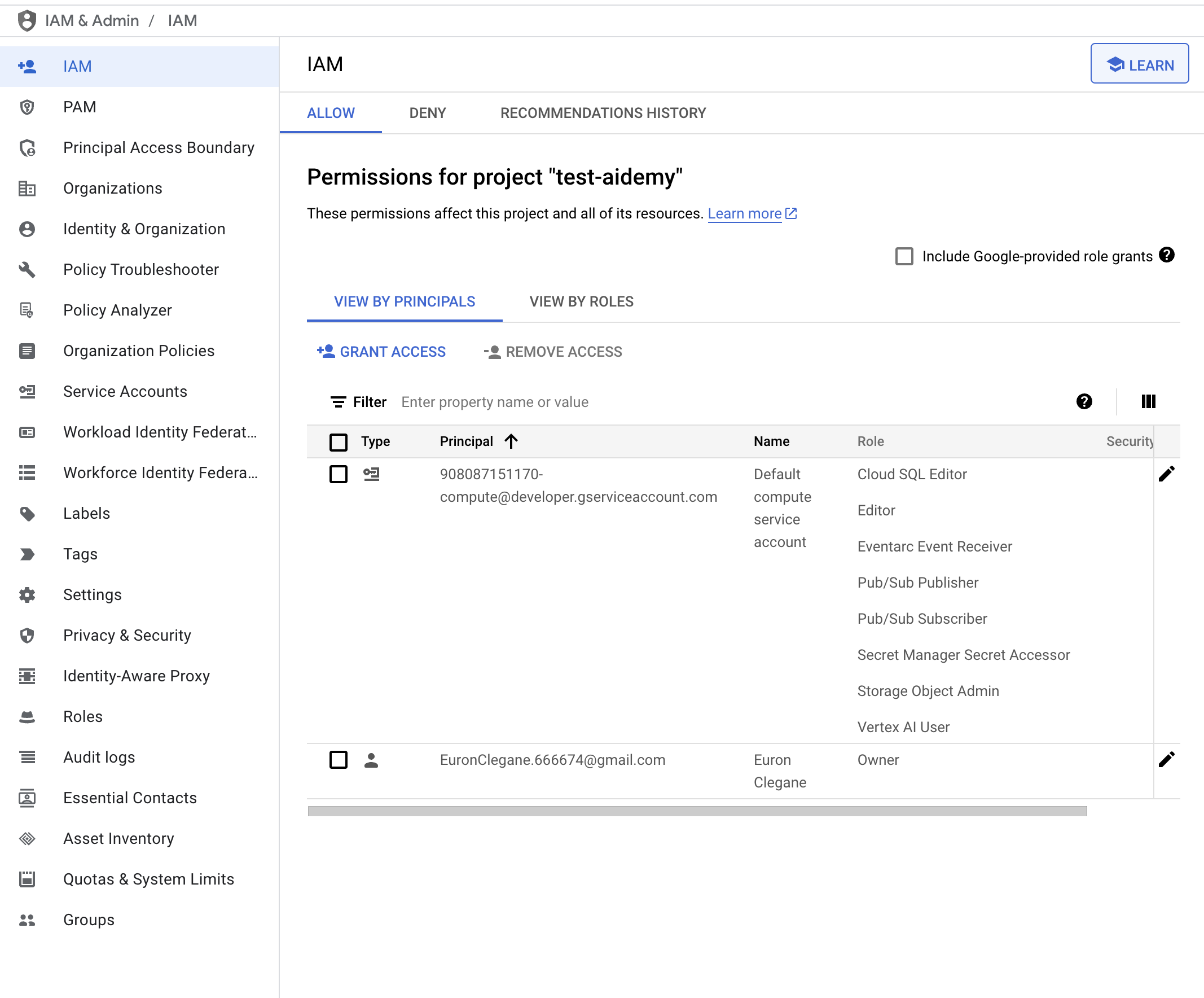

Berechtigung einrichten

👉 Dienstkontoberechtigungen einrichten Führen Sie im Terminal folgenden Befehl aus :

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

export SERVICE_ACCOUNT_NAME=$(gcloud compute project-info describe --format="value(defaultServiceAccount)")

echo "Here's your SERVICE_ACCOUNT_NAME $SERVICE_ACCOUNT_NAME"

👉 Berechtigungen erteilen Führen Sie im Terminal folgenden Befehl aus :

#Cloud Storage (Read/Write):

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/storage.objectAdmin"

#Pub/Sub (Publish/Receive):

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/pubsub.publisher"

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/pubsub.subscriber"

#Cloud SQL (Read/Write):

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/cloudsql.editor"

#Eventarc (Receive Events):

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/iam.serviceAccountTokenCreator"

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/eventarc.eventReceiver"

#Vertex AI (User):

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/aiplatform.user"

#Secret Manager (Read):

gcloud projects add-iam-policy-binding $PROJECT_ID \

--member="serviceAccount:$SERVICE_ACCOUNT_NAME" \

--role="roles/secretmanager.secretAccessor"

👉 Ergebnis in der IAM-Konsole prüfen

👉 Führen Sie die folgenden Befehle im Terminal aus, um eine Cloud SQL-Instanz mit dem Namen aidemy zu erstellen. Wir benötigen diese Informationen später, aber da dieser Vorgang einige Zeit in Anspruch nehmen kann, führen wir ihn jetzt durch.

gcloud sql instances create aidemy \

--database-version=POSTGRES_14 \

--cpu=2 \

--memory=4GB \

--region=us-central1 \

--root-password=1234qwer \

--storage-size=10GB \

--storage-auto-increase

4. Ersten Agenten erstellen

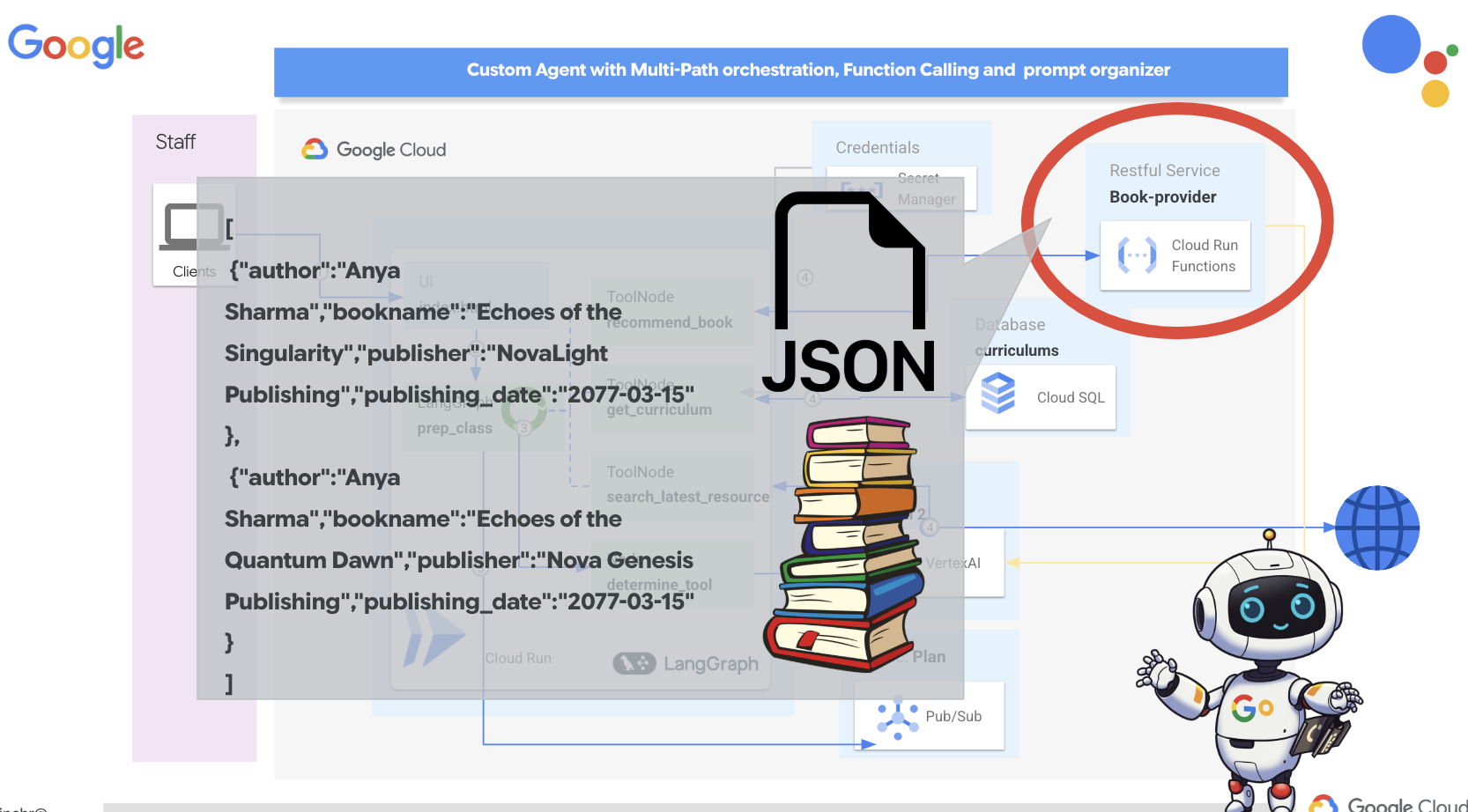

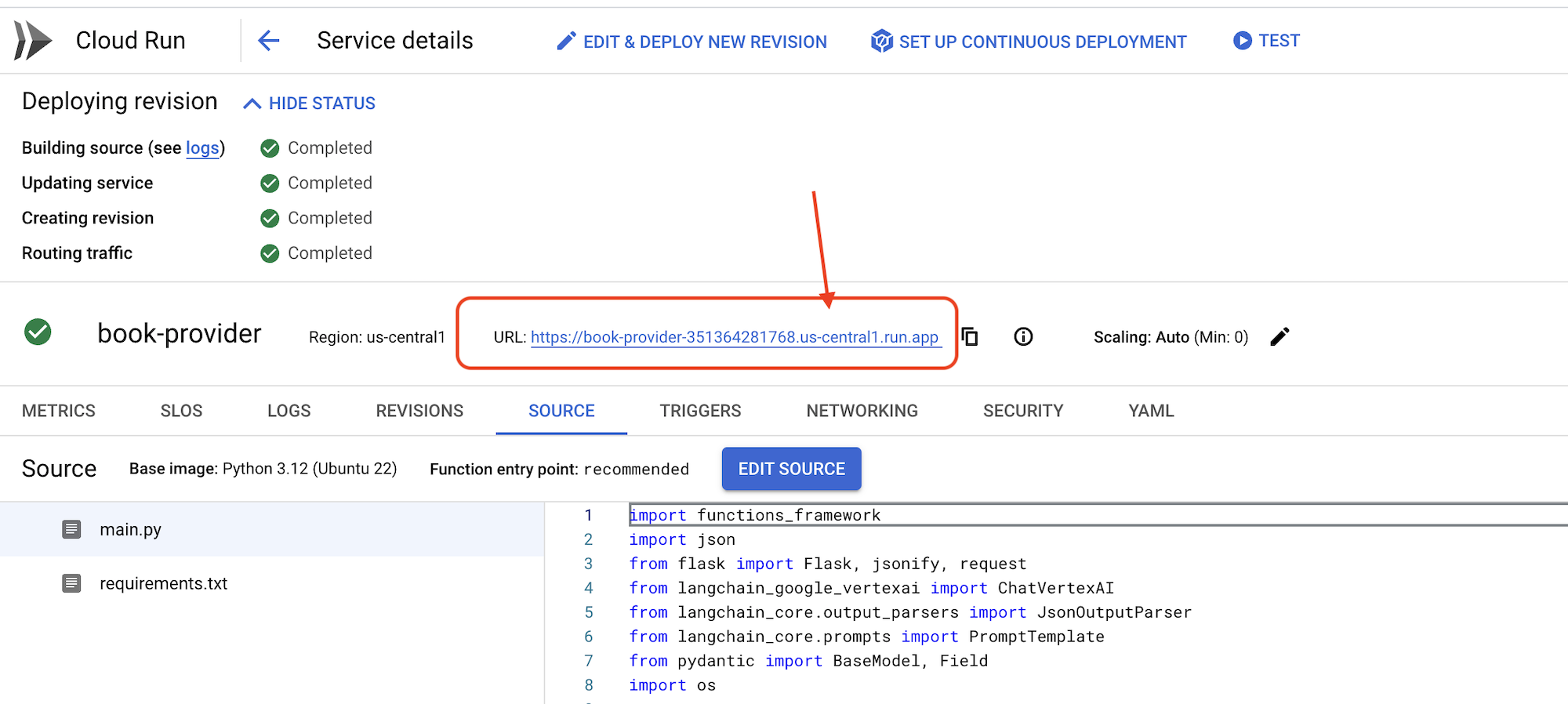

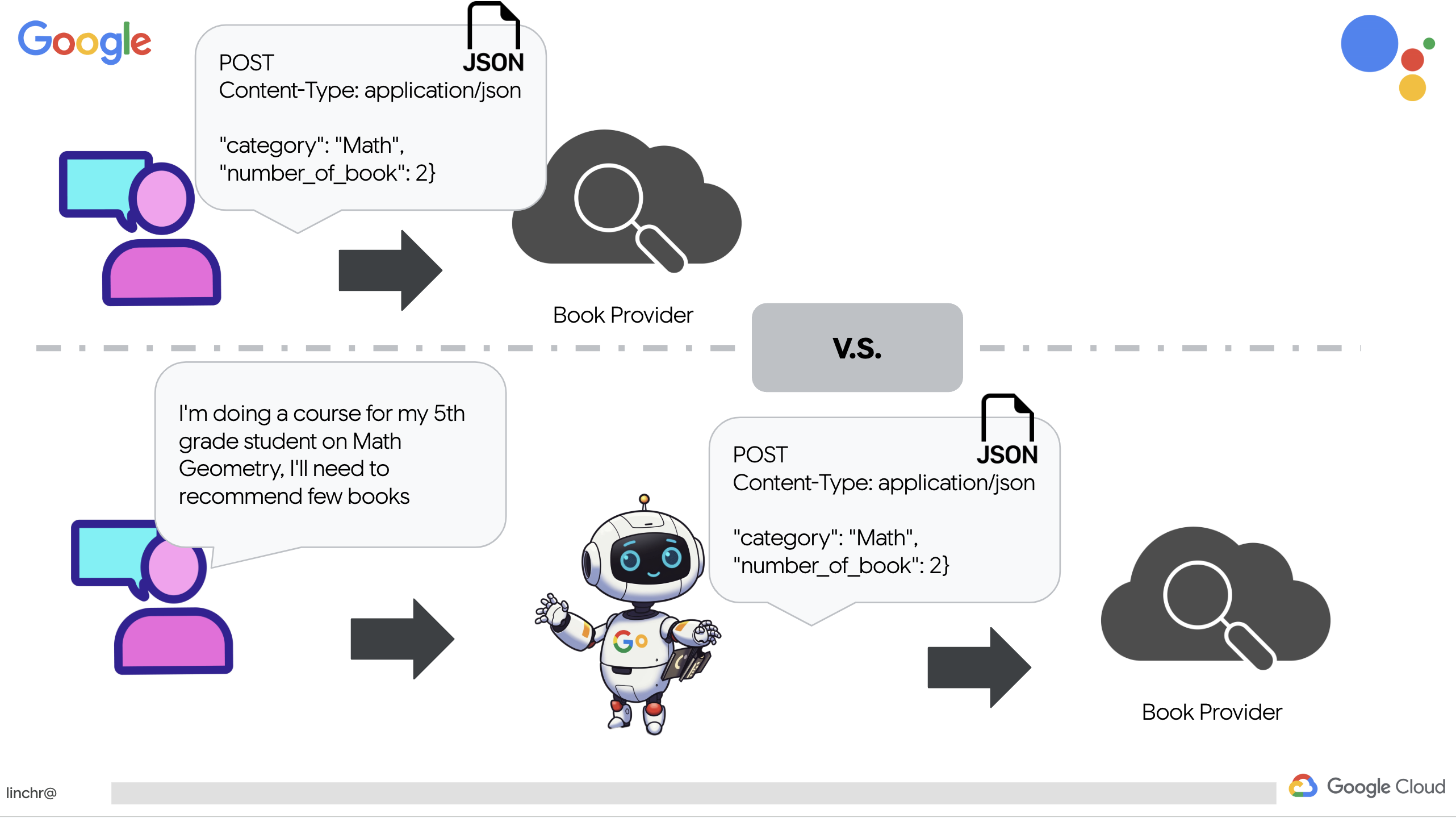

Bevor wir uns komplexen Multi-Agent-Systemen zuwenden, müssen wir einen grundlegenden Baustein schaffen: einen einzelnen, funktionalen Agenten. In diesem Abschnitt erstellen wir einen einfachen Agenten für Buchanbieter. Der Buchanbieter-Agent nimmt eine Kategorie als Eingabe entgegen und verwendet ein Gemini-LLM, um eine JSON-Darstellung eines Buchs in dieser Kategorie zu generieren. Anschließend werden diese Buchempfehlungen als REST API-Endpunkt bereitgestellt .

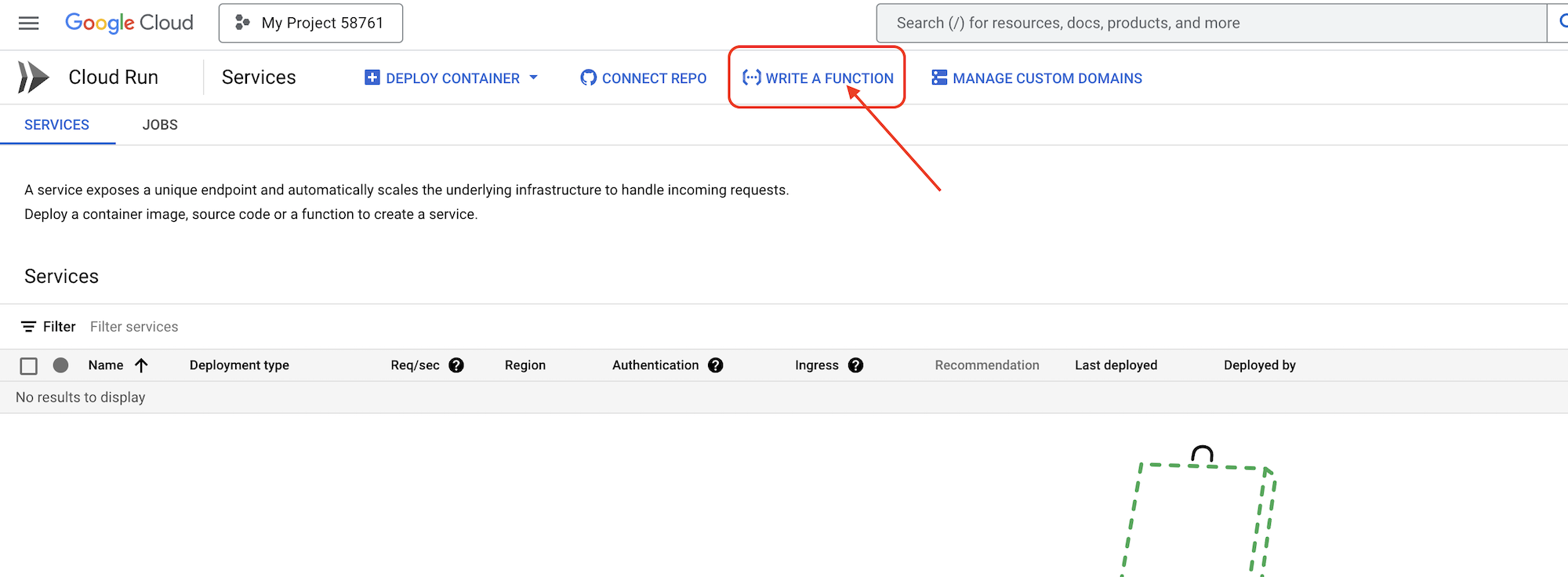

👉 Öffnen Sie in einem anderen Browser-Tab die Google Cloud Console in Ihrem Webbrowser. Rufen Sie im Navigationsmenü (☰) „Cloud Run“ auf. Klicken Sie auf die Schaltfläche „+ … FUNKTION SCHREIBEN“.

👉 Als Nächstes konfigurieren wir die Grundeinstellungen der Cloud Run-Funktion:

- Dienstname:

book-provider - Region:

us-central1 - Laufzeit:

Python 3.12 - Authentifizierung:

Allow unauthenticated invocationsauf „Aktiviert“ setzen.

👉 Übernehmen Sie die anderen Standardeinstellungen und klicken Sie auf Erstellen. Dadurch gelangen Sie zum Quellcode-Editor.

Sie sehen die vorab ausgefüllten Dateien main.py und requirements.txt.

main.py enthält die Geschäftslogik der Funktion, requirements.txt die erforderlichen Pakete.

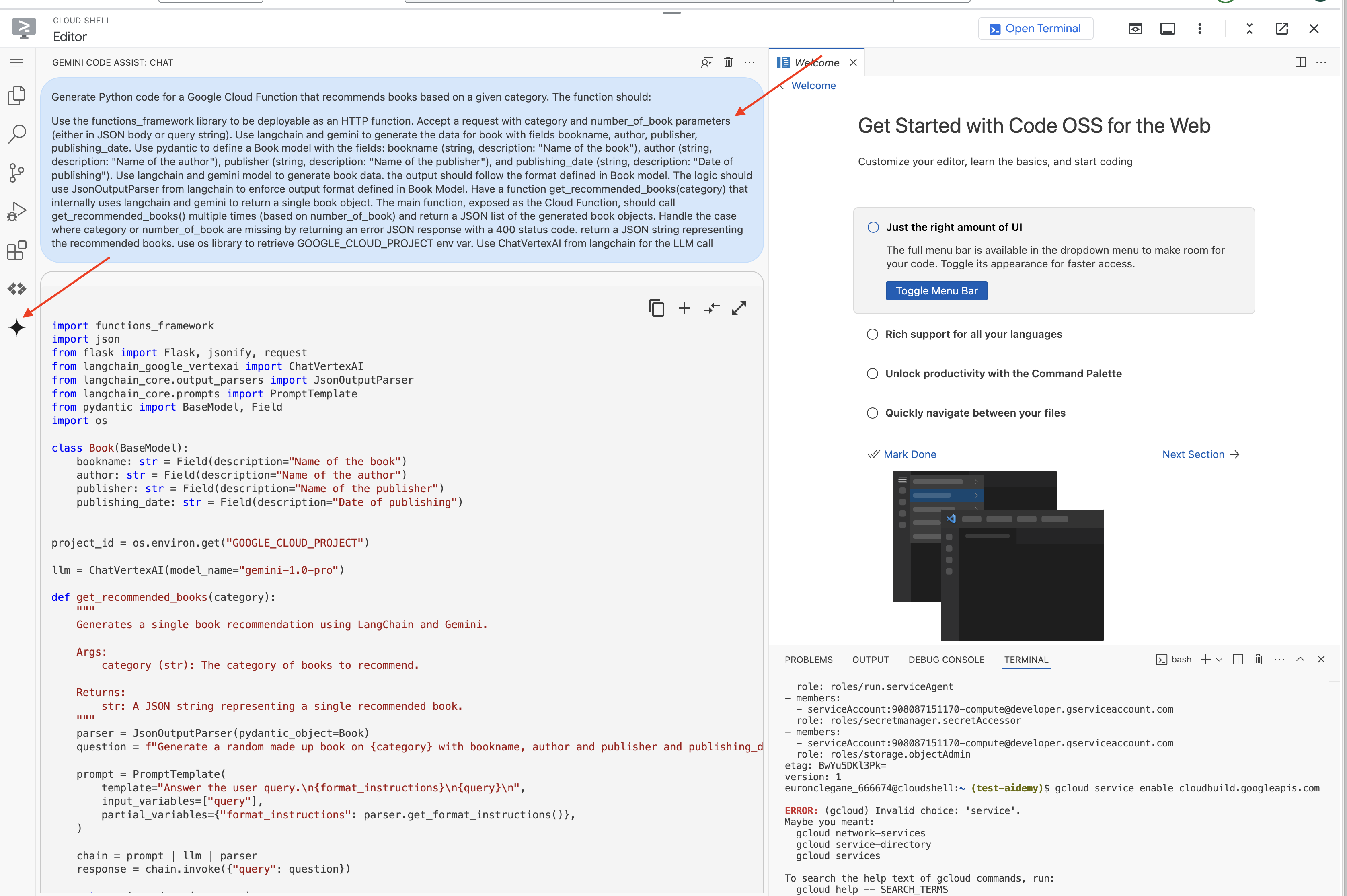

👉 Jetzt können wir Code schreiben. Bevor wir uns das genauer ansehen, wollen wir prüfen, ob Gemini Code Assist uns einen Vorsprung verschaffen kann. Kehren Sie zum Cloud Shell-Editor zurück und klicken Sie oben auf das Gemini Code Assist-Symbol, um den Gemini Code Assist-Chat zu öffnen.

👉 Fügen Sie die folgende Anfrage in das Prompt-Feld ein:

Use the functions_framework library to be deployable as an HTTP function.

Accept a request with category and number_of_book parameters (either in JSON body or query string).

Use langchain and gemini to generate the data for book with fields bookname, author, publisher, publishing_date.

Use pydantic to define a Book model with the fields: bookname (string, description: "Name of the book"), author (string, description: "Name of the author"), publisher (string, description: "Name of the publisher"), and publishing_date (string, description: "Date of publishing").

Use langchain and gemini model to generate book data. the output should follow the format defined in Book model.

The logic should use JsonOutputParser from langchain to enforce output format defined in Book Model.

Have a function get_recommended_books(category) that internally uses langchain and gemini to return a single book object.

The main function, exposed as the Cloud Function, should call get_recommended_books() multiple times (based on number_of_book) and return a JSON list of the generated book objects.

Handle the case where category or number_of_book are missing by returning an error JSON response with a 400 status code.

return a JSON string representing the recommended books. use os library to retrieve GOOGLE_CLOUD_PROJECT env var. Use ChatVertexAI from langchain for the LLM call

Code Assist generiert dann eine mögliche Lösung und stellt sowohl den Quellcode als auch eine Datei „requirements.txt“ mit den Abhängigkeiten bereit. (DIESEN CODE NICHT VERWENDEN)

Wir empfehlen Ihnen, den von Code Assist generierten Code mit der unten bereitgestellten getesteten, korrekten Lösung zu vergleichen. So können Sie die Effektivität des Tools bewerten und potenzielle Abweichungen erkennen. LLMs sollten zwar nie blind vertraut werden, aber Code Assist kann ein hervorragendes Tool für schnelles Prototyping und zum Generieren erster Codestrukturen sein.

Da es sich um einen Workshop handelt, verwenden wir den unten angegebenen bestätigten Code. Sie können den von Code Assist generierten Code jedoch jederzeit ausprobieren, um ein besseres Verständnis der Funktionen und Einschränkungen zu erhalten.

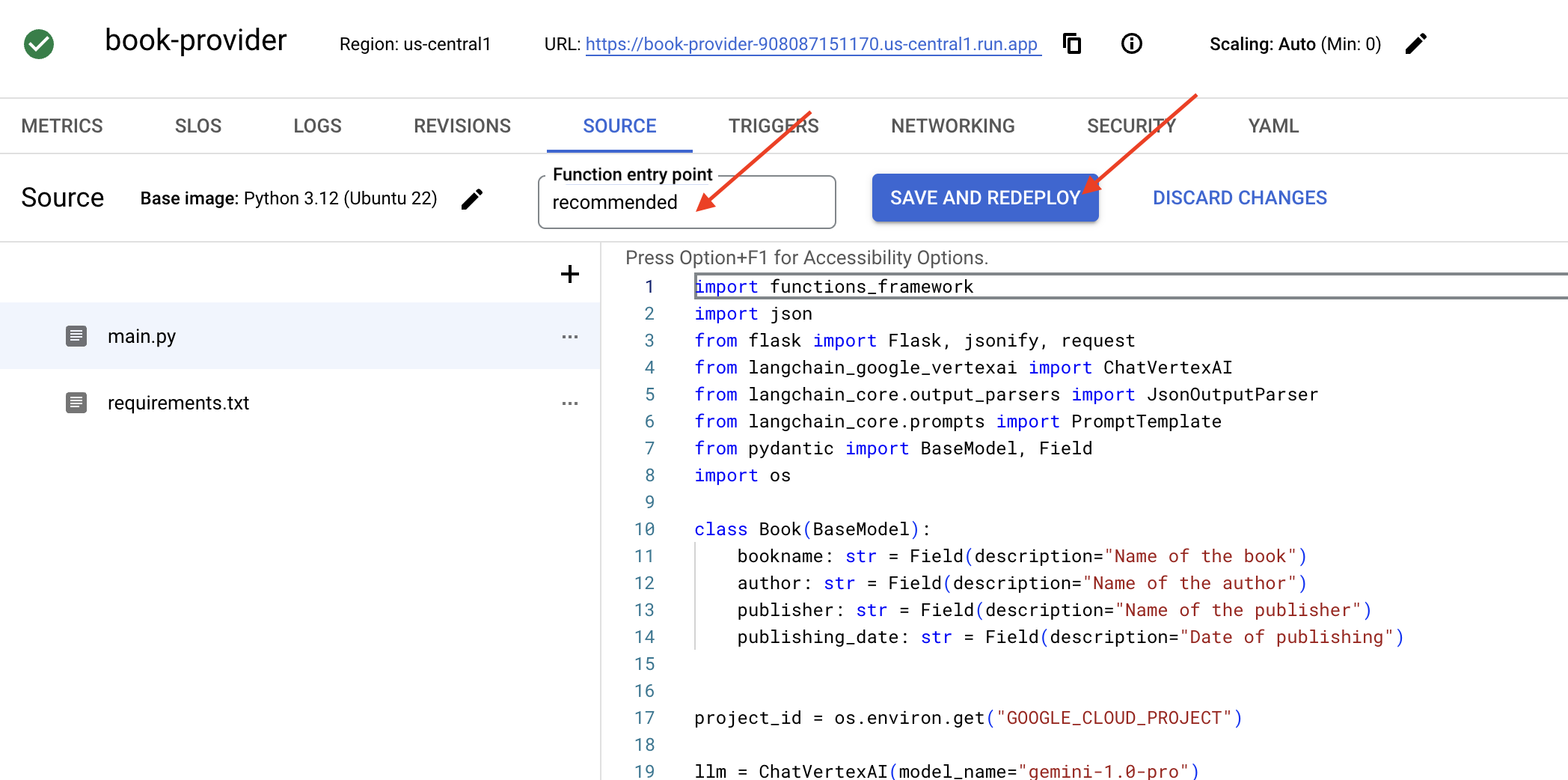

👉 Kehren Sie zum Quellcode-Editor der Cloud Run-Funktion zurück (auf dem anderen Browser-Tab). Ersetzen Sie den vorhandenen Inhalt von main.py sorgfältig durch den unten stehenden Code:

import functions_framework

import json

from flask import Flask, jsonify, request

from langchain_google_vertexai import ChatVertexAI

from langchain_core.output_parsers import JsonOutputParser

from langchain_core.prompts import PromptTemplate

from pydantic import BaseModel, Field

import os

class Book(BaseModel):

bookname: str = Field(description="Name of the book")

author: str = Field(description="Name of the author")

publisher: str = Field(description="Name of the publisher")

publishing_date: str = Field(description="Date of publishing")

project_id = os.environ.get("GOOGLE_CLOUD_PROJECT")

llm = ChatVertexAI(model_name="gemini-2.0-flash-lite-001")

def get_recommended_books(category):

"""

A simple book recommendation function.

Args:

category (str): category

Returns:

str: A JSON string representing the recommended books.

"""

parser = JsonOutputParser(pydantic_object=Book)

question = f"Generate a random made up book on {category} with bookname, author and publisher and publishing_date"

prompt = PromptTemplate(

template="Answer the user query.\n{format_instructions}\n{query}\n",

input_variables=["query"],

partial_variables={"format_instructions": parser.get_format_instructions()},

)

chain = prompt | llm | parser

response = chain.invoke({"query": question})

return json.dumps(response)

@functions_framework.http

def recommended(request):

request_json = request.get_json(silent=True) # Get JSON data

if request_json and 'category' in request_json and 'number_of_book' in request_json:

category = request_json['category']

number_of_book = int(request_json['number_of_book'])

elif request.args and 'category' in request.args and 'number_of_book' in request.args:

category = request.args.get('category')

number_of_book = int(request.args.get('number_of_book'))

else:

return jsonify({'error': 'Missing category or number_of_book parameters'}), 400

recommendations_list = []

for i in range(number_of_book):

book_dict = json.loads(get_recommended_books(category))

print(f"book_dict=======>{book_dict}")

recommendations_list.append(book_dict)

return jsonify(recommendations_list)

👉 Ersetzen Sie den Inhalt von „requirements.txt“ durch Folgendes:

functions-framework==3.*

google-genai==1.0.0

flask==3.1.0

jsonify==0.5

langchain_google_vertexai==2.0.13

langchain_core==0.3.34

pydantic==2.10.5

👉 Wir legen den Funktionseinstiegspunkt fest: recommended

👉 Klicken Sie auf SPEICHERN UND BEREITSTELLEN (oder SPEICHERN UND WIEDER BEREITSTELLEN), um die Funktion bereitzustellen. Warten Sie, bis der Bereitstellungsvorgang abgeschlossen ist. In der Cloud Console wird der Status angezeigt. Dieser Vorgang kann einige Minuten dauern.

👉 Kehren Sie nach der Bereitstellung zum Cloud Shell-Editor zurück und führen Sie im Terminal Folgendes aus:

👉 Kehren Sie nach der Bereitstellung zum Cloud Shell-Editor zurück und führen Sie im Terminal Folgendes aus:

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

export BOOK_PROVIDER_URL=$(gcloud run services describe book-provider --region=us-central1 --project=$PROJECT_ID --format="value(status.url)")

curl -X POST -H "Content-Type: application/json" -d '{"category": "Science Fiction", "number_of_book": 2}' $BOOK_PROVIDER_URL

Es sollten einige Buchdaten im JSON-Format angezeigt werden.

[

{"author":"Anya Sharma","bookname":"Echoes of the Singularity","publisher":"NovaLight Publishing","publishing_date":"2077-03-15"},

{"author":"Anya Sharma","bookname":"Echoes of the Quantum Dawn","publisher":"Nova Genesis Publishing","publishing_date":"2077-03-15"}

]

Glückwunsch! Sie haben eine Cloud Run-Funktion bereitgestellt. Dies ist einer der Dienste, die wir bei der Entwicklung unseres Aidemy-Agents integrieren werden.

5. Tools erstellen: Agents mit RESTFUL-Diensten und Daten verbinden

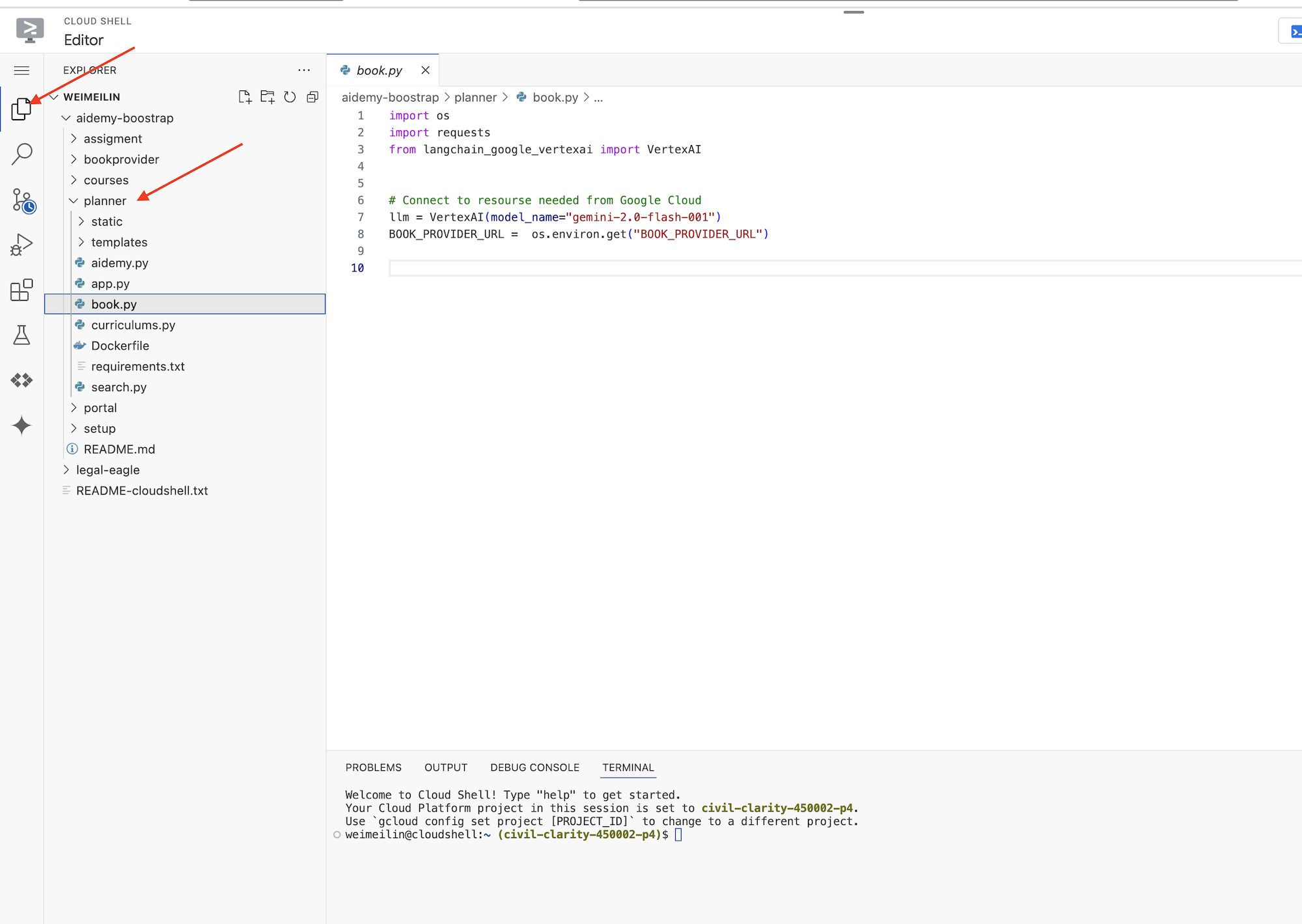

Laden wir das Bootstrap-Skelettprojekt herunter. Achten Sie darauf, dass Sie sich im Cloud Shell-Editor befinden. Führen Sie im Terminal folgenden Befehl aus:

git clone https://github.com/weimeilin79/aidemy-bootstrap.git

Nachdem Sie diesen Befehl ausgeführt haben, wird in Ihrer Cloud Shell-Umgebung ein neuer Ordner mit dem Namen aidemy-bootstrap erstellt.

Im Bereich „Explorer“ des Cloud Shell-Editors (normalerweise auf der linken Seite) sollte jetzt der Ordner angezeigt werden, der beim Klonen des Git-Repositorys aidemy-bootstrap erstellt wurde. Öffnen Sie den Stammordner Ihres Projekts im Explorer. Darin befindet sich der Unterordner planner. Öffnen Sie auch diesen.

Lassen Sie uns mit der Entwicklung der Tools beginnen, die unsere KI-Agenten benötigen, um wirklich hilfreich zu sein. Wie Sie wissen, sind LLMs hervorragend darin, logische Schlüsse zu ziehen und Text zu generieren. Sie benötigen jedoch Zugriff auf externe Ressourcen, um Aufgaben in der realen Welt auszuführen und genaue, aktuelle Informationen bereitzustellen. Stellen Sie sich diese Tools als das „Schweizer Taschenmesser“ des Agenten vor, mit dem er mit der Welt interagieren kann.

Beim Erstellen eines Agents ist es leicht, viele Details fest zu codieren. Dadurch wird ein Agent erstellt, der nicht flexibel ist. Stattdessen hat der Agent durch das Erstellen und Verwenden von Tools Zugriff auf externe Logik oder Systeme, was ihm die Vorteile von LLM und herkömmlicher Programmierung bietet.

In diesem Abschnitt legen wir die Grundlage für den Planner-Agenten, mit dem Lehrkräfte Unterrichtspläne erstellen können. Bevor der Agent einen Plan generiert, möchten wir Grenzen festlegen, indem wir weitere Details zum Fach und Thema angeben. Wir erstellen drei Tools:

- Restful-API-Aufruf:Interaktion mit einer vorhandenen API zum Abrufen von Daten.

- Datenbankabfrage:Abrufen strukturierter Daten aus einer Cloud SQL-Datenbank.

- Google Suche:Zugriff auf Echtzeitinformationen aus dem Web.

Buchempfehlungen über eine API abrufen

Zuerst erstellen wir ein Tool, das Buchempfehlungen von der book-provider-API abruft, die wir im vorherigen Abschnitt bereitgestellt haben. Hier wird gezeigt, wie ein Agent vorhandene Dienste nutzen kann.

Öffnen Sie im Cloud Shell-Editor das Projekt aidemy-bootstrap, das Sie im vorherigen Abschnitt geklont haben.

👉 Bearbeiten Sie die Datei book.py im Ordner planner und fügen Sie den folgenden Code am Ende der Datei ein:

def recommend_book(query: str):

"""

Get a list of recommended book from an API endpoint

Args:

query: User's request string

"""

region = get_next_region();

llm = VertexAI(model_name="gemini-1.5-pro", location=region)

query = f"""The user is trying to plan a education course, you are the teaching assistant. Help define the category of what the user requested to teach, respond the categroy with no more than two word.

user request: {query}

"""

print(f"-------->{query}")

response = llm.invoke(query)

print(f"CATEGORY RESPONSE------------>: {response}")

# call this using python and parse the json back to dict

category = response.strip()

headers = {"Content-Type": "application/json"}

data = {"category": category, "number_of_book": 2}

books = requests.post(BOOK_PROVIDER_URL, headers=headers, json=data)

return books.text

if __name__ == "__main__":

print(recommend_book("I'm doing a course for my 5th grade student on Math Geometry, I'll need to recommend few books come up with a teach plan, few quizes and also a homework assignment."))

Erklärung:

- recommend_book(query: str): Diese Funktion verwendet die Anfrage eines Nutzers als Eingabe.

- LLM-Interaktion: Das LLM wird verwendet, um die Kategorie aus der Anfrage zu extrahieren. Hier wird gezeigt, wie Sie das LLM verwenden können, um Parameter für Tools zu erstellen.

- API-Aufruf: Es wird eine POST-Anfrage an die Book-Provider API gesendet, wobei die Kategorie und die gewünschte Anzahl von Büchern übergeben werden.

👉 Um diese neue Funktion zu testen, legen Sie die Umgebungsvariable fest und führen Sie Folgendes aus :

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

cd ~/aidemy-bootstrap/planner/

export BOOK_PROVIDER_URL=$(gcloud run services describe book-provider --region=us-central1 --project=$PROJECT_ID --format="value(status.url)")

👉 Installieren Sie die Abhängigkeiten und führen Sie den Code aus, um sicherzustellen, dass er funktioniert:

cd ~/aidemy-bootstrap/planner/

python -m venv env

source env/bin/activate

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

pip install -r requirements.txt

python book.py

Sie sollten einen JSON-String mit Buchempfehlungen sehen, die über die Buchanbieter-API abgerufen wurden. Die Ergebnisse werden zufällig generiert. Ihre Bücher sind möglicherweise nicht identisch, aber Sie sollten zwei Buchempfehlungen im JSON-Format erhalten.

[{"author":"Anya Sharma","bookname":"Echoes of the Singularity","publisher":"NovaLight Publishing","publishing_date":"2077-03-15"},{"author":"Anya Sharma","bookname":"Echoes of the Quantum Dawn","publisher":"Nova Genesis Publishing","publishing_date":"2077-03-15"}]

Wenn Sie das sehen, funktioniert das erste Tool richtig.

Anstatt einen RESTful API-Aufruf mit bestimmten Parametern explizit zu erstellen, verwenden wir natürliche Sprache („I'm doing a course...“). Der Agent extrahiert dann intelligent die erforderlichen Parameter (z. B. die Kategorie) mithilfe von NLP und zeigt so, wie der Agent Natural Language Understanding nutzt, um mit der API zu interagieren.

👉Entfernen Sie den folgenden Testcode aus book.py.

if __name__ == "__main__":

print(recommend_book("I'm doing a course for my 5th grade student on Math Geometry, I'll need to recommend few books come up with a teach plan, few quizes and also a homework assignment."))

Curriculum-Daten aus einer Datenbank abrufen

Als Nächstes erstellen wir ein Tool, mit dem strukturierte Lehrplandaten aus einer Cloud SQL PostgreSQL-Datenbank abgerufen werden. So kann der Agent auf eine zuverlässige Informationsquelle für die Unterrichtsplanung zugreifen.

Erinnern Sie sich an die Cloud SQL-Instanz aidemy, die Sie im vorherigen Schritt erstellt haben? Hier wird sie verwendet.

👉 Führen Sie im Terminal den folgenden Befehl aus, um in der neuen Instanz eine Datenbank mit dem Namen aidemy-db zu erstellen.

gcloud sql databases create aidemy-db \

--instance=aidemy

Sehen wir uns die Instanz in Cloud SQL in der Google Cloud Console an. Dort sollte eine Cloud SQL-Instanz mit dem Namen aidemy aufgeführt sein.

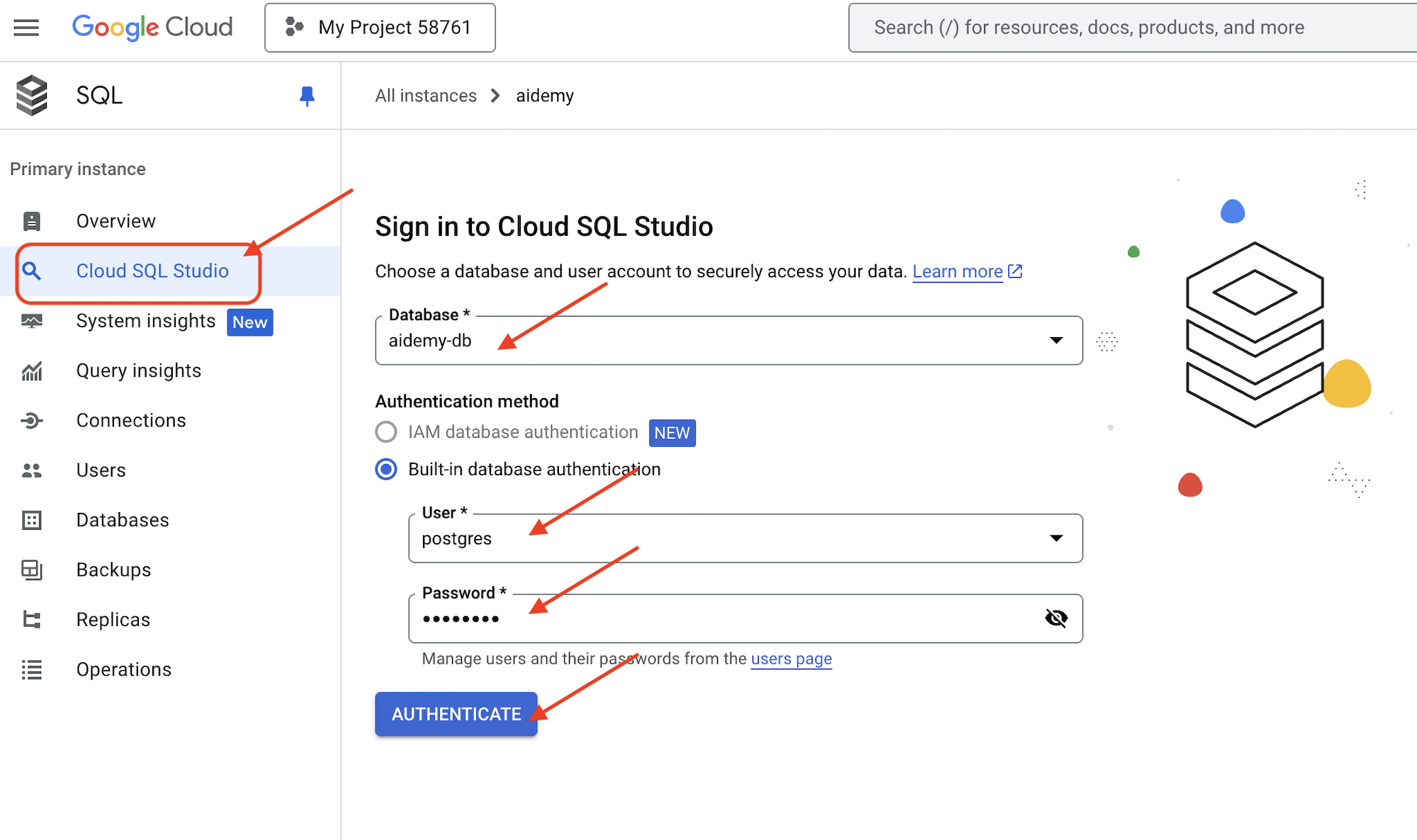

👉 Klicken Sie auf den Instanznamen, um die Details aufzurufen. 👉 Klicken Sie auf der Detailseite der Cloud SQL-Instanz im linken Navigationsmenü auf Cloud SQL Studio. Damit wird ein neuer Tab geöffnet.

Wählen Sie aidemy-db als Datenbank aus, geben Sie postgres als Nutzer und 1234qwer als Passwort ein.

Klicken Sie auf Authentifizieren.

👉 Rufen Sie im SQL Studio-Abfrageeditor den Tab Editor 1 auf und fügen Sie den folgenden SQL-Code ein:

CREATE TABLE curriculums (

id SERIAL PRIMARY KEY,

year INT,

subject VARCHAR(255),

description TEXT

);

-- Inserting detailed curriculum data for different school years and subjects

INSERT INTO curriculums (year, subject, description) VALUES

-- Year 5

(5, 'Mathematics', 'Introduction to fractions, decimals, and percentages, along with foundational geometry and problem-solving techniques.'),

(5, 'English', 'Developing reading comprehension, creative writing, and basic grammar, with a focus on storytelling and poetry.'),

(5, 'Science', 'Exploring basic physics, chemistry, and biology concepts, including forces, materials, and ecosystems.'),

(5, 'Computer Science', 'Basic coding concepts using block-based programming and an introduction to digital literacy.'),

-- Year 6

(6, 'Mathematics', 'Expanding on fractions, ratios, algebraic thinking, and problem-solving strategies.'),

(6, 'English', 'Introduction to persuasive writing, character analysis, and deeper comprehension of literary texts.'),

(6, 'Science', 'Forces and motion, the human body, and introductory chemical reactions with hands-on experiments.'),

(6, 'Computer Science', 'Introduction to algorithms, logical reasoning, and basic text-based programming (Python, Scratch).'),

-- Year 7

(7, 'Mathematics', 'Algebraic expressions, geometry, and introduction to statistics and probability.'),

(7, 'English', 'Analytical reading of classic and modern literature, essay writing, and advanced grammar skills.'),

(7, 'Science', 'Introduction to cells and organisms, chemical reactions, and energy transfer in physics.'),

(7, 'Computer Science', 'Building on programming skills with Python, introduction to web development, and cyber safety.');

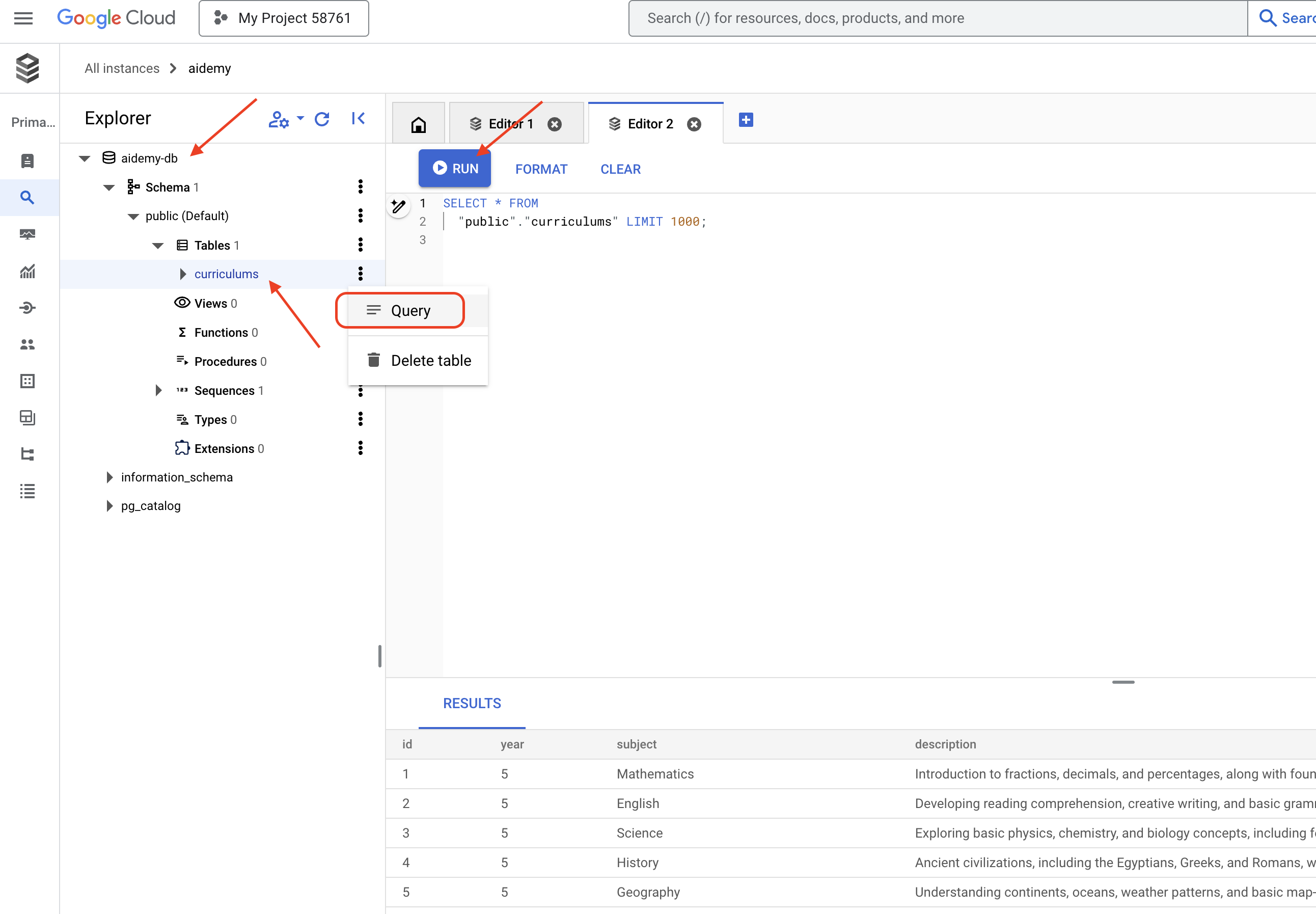

Mit diesem SQL-Code wird eine Tabelle mit dem Namen curriculums erstellt und es werden einige Beispieldaten eingefügt.

👉 Klicken Sie auf Ausführen, um den SQL-Code auszuführen. Sie sollten eine Bestätigungsmeldung sehen, dass die Anweisungen erfolgreich ausgeführt wurden.

👉 Maximieren Sie den Explorer, suchen Sie die neu erstellte Tabelle curriculums und klicken Sie auf Abfrage. Ein neuer Editor-Tab mit für Sie generiertem SQL sollte geöffnet werden.

SELECT * FROM

"public"."curriculums" LIMIT 1000;

👉 Klicken Sie auf Ausführen.

In der Ergebnistabelle sollten die Datenzeilen angezeigt werden, die Sie im vorherigen Schritt eingefügt haben. So wird bestätigt, dass die Tabelle und die Daten korrekt erstellt wurden.

Nachdem Sie nun eine Datenbank mit Beispieldaten für den Lehrplan erstellt haben, entwickeln wir ein Tool, mit dem Sie die Daten abrufen können.

👉 Bearbeiten Sie im Cloud Code-Editor die Datei curriculums.py im Ordner aidemy-bootstrap und fügen Sie den folgenden Code am Ende der Datei ein:

def connect_with_connector() -> sqlalchemy.engine.base.Engine:

db_user = os.environ["DB_USER"]

db_pass = os.environ["DB_PASS"]

db_name = os.environ["DB_NAME"]

print(f"--------------------------->db_user: {db_user!r}")

print(f"--------------------------->db_pass: {db_pass!r}")

print(f"--------------------------->db_name: {db_name!r}")

connector = Connector()

pool = sqlalchemy.create_engine(

"postgresql+pg8000://",

creator=lambda: connector.connect(

instance_connection_name,

"pg8000",

user=db_user,

password=db_pass,

db=db_name,

),

pool_size=2,

max_overflow=2,

pool_timeout=30, # 30 seconds

pool_recycle=1800, # 30 minutes

)

return pool

def get_curriculum(year: int, subject: str):

"""

Get school curriculum

Args:

subject: User's request subject string

year: User's request year int

"""

try:

stmt = sqlalchemy.text(

"SELECT description FROM curriculums WHERE year = :year AND subject = :subject"

)

with db.connect() as conn:

result = conn.execute(stmt, parameters={"year": year, "subject": subject})

row = result.fetchone()

if row:

return row[0]

else:

return None

except Exception as e:

print(e)

return None

db = connect_with_connector()

Erklärung:

- Umgebungsvariablen: Der Code ruft Datenbankanmeldedaten und Verbindungsinformationen aus Umgebungsvariablen ab (siehe unten).

- connect_with_connector(): Diese Funktion stellt mithilfe des Cloud SQL-Connectors eine sichere Verbindung zur Datenbank her.

- get_curriculum(year: int, subject: str): Diese Funktion verwendet das Jahr und das Fach als Eingabe, fragt die Tabelle „curriculums“ ab und gibt die entsprechende Lehrplanbeschreibung zurück.

👉 Bevor wir den Code ausführen können, müssen wir einige Umgebungsvariablen festlegen. Führen Sie dazu im Terminal Folgendes aus:

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

export INSTANCE_NAME="aidemy"

export REGION="us-central1"

export DB_USER="postgres"

export DB_PASS="1234qwer"

export DB_NAME="aidemy-db"

👉 Fügen Sie zum Testen den folgenden Code am Ende von curriculums.py ein:

if __name__ == "__main__":

print(get_curriculum(6, "Mathematics"))

👉 Code ausführen:

cd ~/aidemy-bootstrap/planner/

source env/bin/activate

python curriculums.py

Auf der Konsole sollte die Lehrplanbeschreibung für Mathematik der 6. Klasse angezeigt werden.

Expanding on fractions, ratios, algebraic thinking, and problem-solving strategies.

Wenn Sie die Kursbeschreibung sehen, funktioniert das Datenbanktool richtig. Beenden Sie das Skript durch Drücken von Ctrl+C, falls es noch ausgeführt wird.

👉Entfernen Sie den folgenden Testcode aus curriculums.py.

if __name__ == "__main__":

print(get_curriculum(6, "Mathematics"))

👉 Beenden Sie die virtuelle Umgebung, indem Sie im Terminal Folgendes ausführen:

deactivate

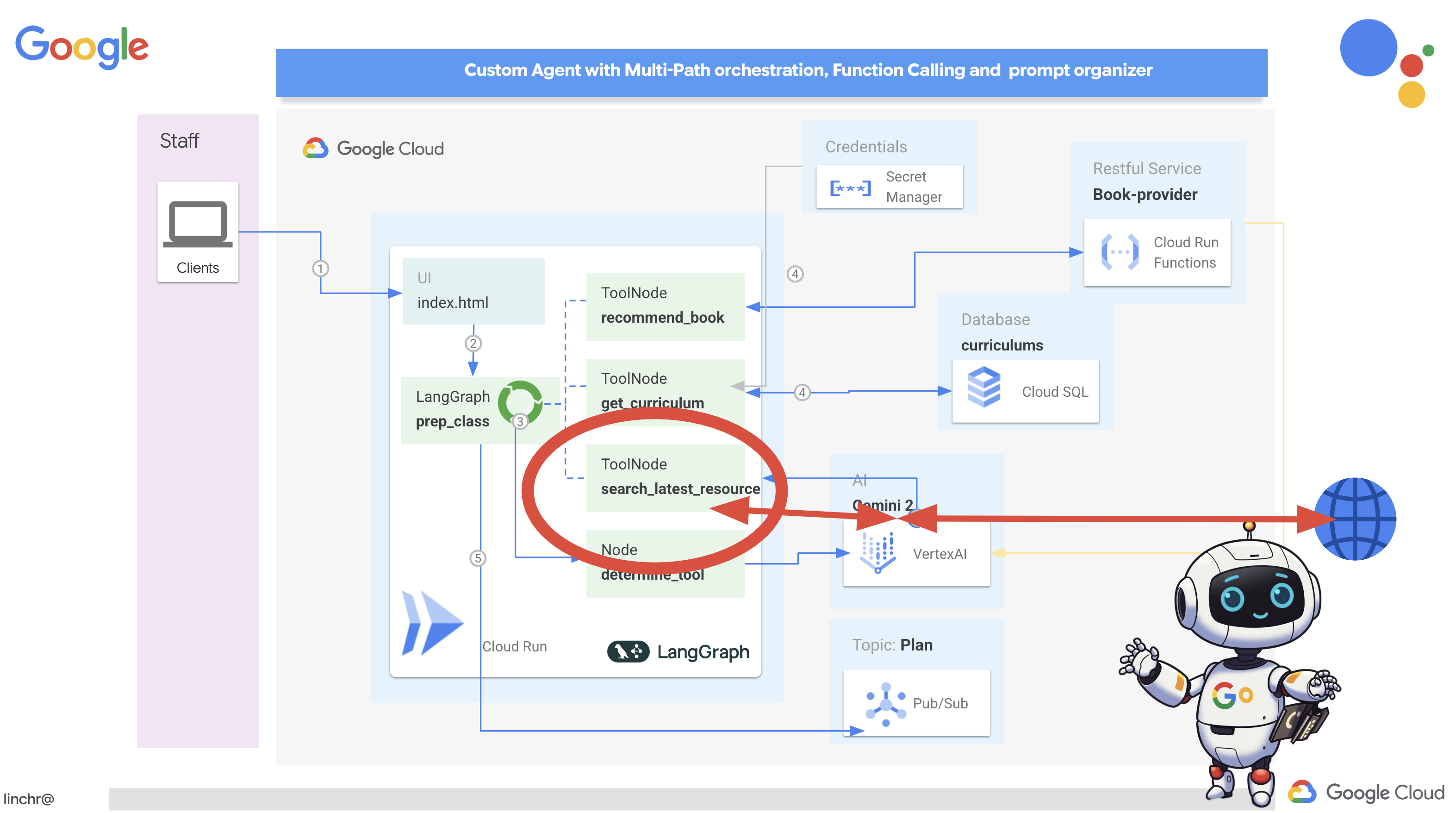

6. Tools entwickeln: Echtzeitinformationen aus dem Web abrufen

Schließlich entwickeln wir ein Tool, das die Integration von Gemini 2 und Google Suche nutzt, um auf Echtzeitinformationen aus dem Web zuzugreifen. So kann der Agent auf dem neuesten Stand bleiben und relevante Ergebnisse liefern.

Die Integration von Gemini 2 in die Google Search API verbessert die Funktionen von Agenten, da genauere und kontextbezogenere Suchergebnisse bereitgestellt werden. So können Agents auf aktuelle Informationen zugreifen und ihre Antworten auf realen Daten basieren lassen, wodurch Halluzinationen minimiert werden. Die verbesserte API-Integration ermöglicht auch natürlichere Sprachanfragen, sodass Kundenservicemitarbeiter komplexe und differenzierte Suchanfragen formulieren können.

Diese Funktion nimmt eine Suchanfrage, einen Lehrplan, ein Fach und ein Jahr als Eingabe entgegen und verwendet die Gemini API und das Google Suche-Tool, um relevante Informationen aus dem Internet abzurufen. Bei genauerer Betrachtung wird deutlich, dass das Google Generative AI SDK für Funktionsaufrufe verwendet wird, ohne dass ein anderes Framework zum Einsatz kommt.

👉 Bearbeiten Sie search.py im Ordner aidemy-bootstrap und fügen Sie den folgenden Code am Ende der Datei ein:

model_id = "gemini-2.0-flash-001"

google_search_tool = Tool(

google_search = GoogleSearch()

)

def search_latest_resource(search_text: str, curriculum: str, subject: str, year: int):

"""

Get latest information from the internet

Args:

search_text: User's request category string

subject: "User's request subject" string

year: "User's request year" integer

"""

search_text = "%s in the context of year %d and subject %s with following curriculum detail %s " % (search_text, year, subject, curriculum)

region = get_next_region()

client = genai.Client(vertexai=True, project=PROJECT_ID, location=region)

print(f"search_latest_resource text-----> {search_text}")

response = client.models.generate_content(

model=model_id,

contents=search_text,

config=GenerateContentConfig(

tools=[google_search_tool],

response_modalities=["TEXT"],

)

)

print(f"search_latest_resource response-----> {response}")

return response

if __name__ == "__main__":

response = search_latest_resource("What are the syllabus for Year 6 Mathematics?", "Expanding on fractions, ratios, algebraic thinking, and problem-solving strategies.", "Mathematics", 6)

for each in response.candidates[0].content.parts:

print(each.text)

Erklärung:

- Tool definieren – google_search_tool: Das GoogleSearch-Objekt in ein Tool einbetten

- search_latest_resource(search_text: str, subject: str, year: int): Diese Funktion verwendet eine Suchanfrage, ein Thema und ein Jahr als Eingabe und führt mit der Gemini API eine Google-Suche durch.

- GenerateContentConfig: Definieren Sie, dass es Zugriff auf das GoogleSearch-Tool hat.

Das Gemini-Modell analysiert intern den search_text und ermittelt, ob die Frage direkt beantwortet werden kann oder ob das GoogleSearch-Tool verwendet werden muss. Dies ist ein wichtiger Schritt im Logikprozess des LLM. Das Modell wurde darauf trainiert, Situationen zu erkennen, in denen externe Tools erforderlich sind. Wenn das Modell beschließt, das GoogleSearch-Tool zu verwenden, übernimmt das Google Generative AI SDK den eigentlichen Aufruf. Das SDK übernimmt die Entscheidung des Modells und die von ihm generierten Parameter und sendet sie an die Google Search API. Dieser Teil ist im Code für den Nutzer ausgeblendet.

Das Gemini-Modell bezieht die Suchergebnisse dann in seine Antwort ein. Sie kann die Informationen verwenden, um die Frage des Nutzers zu beantworten, eine Zusammenfassung zu erstellen oder eine andere Aufgabe auszuführen.

👉 So testen Sie den Code:

cd ~/aidemy-bootstrap/planner/

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

source env/bin/activate

python search.py

Sie sollten die Antwort der Gemini Search API mit Suchergebnissen zum Thema „Lehrplan für Mathematik in der 5. Klasse“ sehen. Die genaue Ausgabe hängt von den Suchergebnissen ab, ist aber ein JSON-Objekt mit Informationen zur Suche.

Wenn Sie Suchergebnisse sehen, funktioniert das Google Suche-Tool richtig. Beenden Sie das Skript durch Drücken von Ctrl+C, falls es noch ausgeführt wird.

👉 Entfernen Sie den letzten Teil des Codes.

if __name__ == "__main__":

response = search_latest_resource("What are the syllabus for Year 6 Mathematics?", "Expanding on fractions, ratios, algebraic thinking, and problem-solving strategies.", "Mathematics", 6)

for each in response.candidates[0].content.parts:

print(each.text)

👉 Beenden Sie die virtuelle Umgebung, indem Sie im Terminal Folgendes ausführen:

deactivate

Glückwunsch! Sie haben jetzt drei leistungsstarke Tools für Ihren Planer-Agent erstellt: einen API-Connector, einen Datenbank-Connector und ein Google Suche-Tool. Mit diesen Tools kann der Agent auf die Informationen und Funktionen zugreifen, die er zum Erstellen effektiver Lehrpläne benötigt.

7. Orchestrierung mit LangGraph

Nachdem wir unsere einzelnen Tools erstellt haben, ist es an der Zeit, sie mit LangGraph zu orchestrieren. So können wir einen ausgefeilteren „Planner“-Agenten erstellen, der basierend auf der Anfrage des Nutzers intelligent entscheiden kann, welche Tools wann verwendet werden sollen.

LangGraph ist eine Python-Bibliothek, mit der sich einfacher zustandsorientierte Anwendungen mit mehreren Akteuren mithilfe von Large Language Models (LLMs) erstellen lassen. Stellen Sie sich das als Framework für die Orchestrierung komplexer Unterhaltungen und Workflows vor, an denen LLMs, Tools und andere Agents beteiligt sind.

Schlüsselkonzepte:

- Diagrammstruktur:LangGraph stellt die Logik Ihrer Anwendung als gerichteten Graphen dar. Jeder Knoten im Diagramm stellt einen Schritt im Prozess dar, z.B. einen Aufruf eines LLM, einen Toolaufruf oder eine bedingte Prüfung. Kanten definieren den Ausführungsfluss zwischen Knoten.

- Status:LangGraph verwaltet den Status Ihrer Anwendung, während sie sich durch den Graphen bewegt. Dieser Status kann Variablen wie die Eingabe des Nutzers, die Ergebnisse von Tool-Aufrufen, Zwischenausgaben von LLMs und alle anderen Informationen enthalten, die zwischen den Schritten beibehalten werden müssen.

- Knoten:Jeder Knoten steht für eine Berechnung oder Interaktion. Sie können Folgendes sein:

- Tool-Knoten:Ein Tool verwenden (z.B. eine Websuche durchführen, eine Datenbank abfragen)

- Funktionsknoten:Führen eine Python-Funktion aus.

- Kanten:Verbinden Knoten und definieren den Ausführungsablauf. Sie können Folgendes sein:

- Direkte Kanten:Ein einfacher, bedingungsloser Fluss von einem Knoten zum nächsten.

- Bedingte Kanten:Der Ablauf hängt vom Ergebnis eines bedingten Knotens ab.

Wir verwenden LangGraph, um die Orchestrierung zu implementieren. Bearbeiten wir die Datei aidemy.py im Ordner aidemy-bootstrap, um unsere LangGraph-Logik zu definieren.

👉 Fügen Sie den folgenden Code am Ende von ein.

aidemy.py:

tools = [get_curriculum, search_latest_resource, recommend_book]

def determine_tool(state: MessagesState):

llm = ChatVertexAI(model_name="gemini-2.0-flash-001", location=get_next_region())

sys_msg = SystemMessage(

content=(

f"""You are a helpful teaching assistant that helps gather all needed information.

Your ultimate goal is to create a detailed 3-week teaching plan.

You have access to tools that help you gather information.

Based on the user request, decide which tool(s) are needed.

"""

)

)

llm_with_tools = llm.bind_tools(tools)

return {"messages": llm_with_tools.invoke([sys_msg] + state["messages"])}

Diese Funktion ist dafür zuständig, den aktuellen Status der Unterhaltung zu erfassen, dem LLM eine Systemnachricht zu senden und das LLM dann aufzufordern, eine Antwort zu generieren. Das LLM kann entweder direkt auf den Nutzer reagieren oder eines der verfügbaren Tools verwenden.

tools : Diese Liste enthält die Tools, die dem Agent zur Verfügung stehen. Sie enthält drei Tool-Funktionen, die wir in den vorherigen Schritten definiert haben: get_curriculum, search_latest_resource und recommend_book. llm.bind_tools(tools): Die Tool-Liste wird an das LLM-Objekt „gebunden“. Durch das Binden der Tools wird dem LLM mitgeteilt, dass diese Tools verfügbar sind, und es erhält Informationen dazu, wie sie verwendet werden (z.B. die Namen der Tools, die Parameter, die sie akzeptieren, und was sie tun).

Wir verwenden LangGraph, um die Orchestrierung zu implementieren.

👉 Fügen Sie den folgenden Code am Ende von ein.

aidemy.py:

def prep_class(prep_needs):

builder = StateGraph(MessagesState)

builder.add_node("determine_tool", determine_tool)

builder.add_node("tools", ToolNode(tools))

builder.add_edge(START, "determine_tool")

builder.add_conditional_edges("determine_tool",tools_condition)

builder.add_edge("tools", "determine_tool")

memory = MemorySaver()

graph = builder.compile(checkpointer=memory)

config = {"configurable": {"thread_id": "1"}}

messages = graph.invoke({"messages": prep_needs},config)

print(messages)

for m in messages['messages']:

m.pretty_print()

teaching_plan_result = messages["messages"][-1].content

return teaching_plan_result

if __name__ == "__main__":

prep_class("I'm doing a course for year 5 on subject Mathematics in Geometry, , get school curriculum, and come up with few books recommendation plus search latest resources on the internet base on the curriculum outcome. And come up with a 3 week teaching plan")

Erklärung:

StateGraph(MessagesState):Erstellt einStateGraph-Objekt. EinStateGraphist ein Kernkonzept in LangGraph. Er stellt den Workflow Ihres Agents als Diagramm dar, wobei jeder Knoten im Diagramm einen Schritt im Prozess darstellt. Damit wird festgelegt, wie der Agent argumentiert und handelt.- Bedingte Kante:Das Argument

tools_conditionstammt vom Knoten"determine_tool"und ist wahrscheinlich eine Funktion, die anhand der Ausgabe der Funktiondetermine_toolbestimmt, welcher Kante gefolgt werden soll. Mit bedingten Kanten kann der Graph verzweigen, je nachdem, welches Tool das LLM verwendet oder ob es direkt auf den Nutzer antwortet. Hier kommt die „Intelligenz“ des Agenten ins Spiel – er kann sein Verhalten dynamisch an die Situation anpassen. - Schleife:Fügt dem Diagramm eine Kante hinzu, die den Knoten

"tools"mit dem Knoten"determine_tool"verbindet. Dadurch entsteht eine Schleife im Diagramm, sodass der Agent Tools wiederholt verwenden kann, bis er genügend Informationen gesammelt hat, um die Aufgabe zu erledigen und eine zufriedenstellende Antwort zu geben. Dieser Loop ist entscheidend für komplexe Aufgaben, die mehrere Schritte für die Argumentation und das Sammeln von Informationen erfordern.

Sehen wir uns nun an, wie unser Planer-Agent die verschiedenen Tools koordiniert.

Mit diesem Code wird die Funktion „prep_class“ mit einer bestimmten Nutzereingabe ausgeführt. Dabei wird eine Anfrage simuliert, einen Unterrichtsplan für Mathematik in der 5. Klasse im Bereich Geometrie zu erstellen, wobei der Lehrplan, Buchempfehlungen und die neuesten Internetressourcen verwendet werden.

👉 Wenn Sie Ihr Terminal geschlossen haben oder die Umgebungsvariablen nicht mehr festgelegt sind, führen Sie die folgenden Befehle noch einmal aus:

export BOOK_PROVIDER_URL=$(gcloud run services describe book-provider --region=us-central1 --project=$PROJECT_ID --format="value(status.url)")

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

export INSTANCE_NAME="aidemy"

export REGION="us-central1"

export DB_USER="postgres"

export DB_PASS="1234qwer"

export DB_NAME="aidemy-db"

👉 Code ausführen:

cd ~/aidemy-bootstrap/planner/

source env/bin/activate

pip install -r requirements.txt

python aidemy.py

Sehen Sie sich das Log im Terminal an. Sie sollten sehen, dass der Kundenservicemitarbeiter alle drei Tools aufruft (Abrufen des Lehrplans, Abrufen von Buchempfehlungen und Suchen nach den neuesten Ressourcen), bevor er den endgültigen Lehrplan bereitstellt. Das zeigt, dass die LangGraph-Orchestrierung korrekt funktioniert und der Agent alle verfügbaren Tools intelligent nutzt, um die Anfrage des Nutzers zu erfüllen.

================================ Human Message =================================

I'm doing a course for year 5 on subject Mathematics in Geometry, , get school curriculum, and come up with few books recommendation plus search latest resources on the internet base on the curriculum outcome. And come up with a 3 week teaching plan

================================== Ai Message ==================================

Tool Calls:

get_curriculum (xxx)

Call ID: xxx

Args:

year: 5.0

subject: Mathematics

================================= Tool Message =================================

Name: get_curriculum

Introduction to fractions, decimals, and percentages, along with foundational geometry and problem-solving techniques.

================================== Ai Message ==================================

Tool Calls:

search_latest_resource (xxxx)

Call ID: xxxx

Args:

year: 5.0

search_text: Geometry

curriculum: {"content": "Introduction to fractions, decimals, and percentages, along with foundational geometry and problem-solving techniques."}

subject: Mathematics

================================= Tool Message =================================

Name: search_latest_resource

candidates=[Candidate(content=Content(parts=[Part(.....) automatic_function_calling_history=[] parsed=None

================================== Ai Message ==================================

Tool Calls:

recommend_book (93b48189-4d69-4c09-a3bd-4e60cdc5f1c6)

Call ID: 93b48189-4d69-4c09-a3bd-4e60cdc5f1c6

Args:

query: Mathematics Geometry Year 5

================================= Tool Message =================================

Name: recommend_book

[{.....}]

================================== Ai Message ==================================

Based on the curriculum outcome, here is a 3-week teaching plan for year 5 Mathematics Geometry:

**Week 1: Introduction to Shapes and Properties**

.........

Beenden Sie das Skript durch Drücken von Ctrl+C, falls es noch ausgeführt wird.

👉 (DIESER SCHRITT IST OPTIONAL): Ersetzen Sie den Testcode durch einen anderen Prompt, für den andere Tools aufgerufen werden müssen.

if __name__ == "__main__":

prep_class("I'm doing a course for year 5 on subject Mathematics in Geometry, search latest resources on the internet base on the subject. And come up with a 3 week teaching plan")

👉 Wenn Sie das Terminal geschlossen haben oder die Umgebungsvariablen nicht mehr festgelegt sind, führen Sie die folgenden Befehle noch einmal aus.

gcloud config set project $(cat ~/project_id.txt)

export BOOK_PROVIDER_URL=$(gcloud run services describe book-provider --region=us-central1 --project=$PROJECT_ID --format="value(status.url)")

export PROJECT_ID=$(gcloud config get project)

export INSTANCE_NAME="aidemy"

export REGION="us-central1"

export DB_USER="postgres"

export DB_PASS="1234qwer"

export DB_NAME="aidemy-db"

👉 (DIESER SCHRITT IST OPTIONAL und muss NUR ausgeführt werden, wenn Sie den vorherigen Schritt ausgeführt haben): Führen Sie den Code noch einmal aus:

cd ~/aidemy-bootstrap/planner/

source env/bin/activate

python aidemy.py

Was ist dir dieses Mal aufgefallen? Welche Tools hat der Kundenservicemitarbeiter aufgerufen? Der Agent ruft dieses Mal nur das Tool „search_latest_resource“ auf. Das liegt daran, dass im Prompt nicht angegeben ist, dass die anderen beiden Tools benötigt werden, und unser LLM intelligent genug ist, die anderen Tools nicht aufzurufen.

================================ Human Message =================================

I'm doing a course for year 5 on subject Mathematics in Geometry, search latest resources on the internet base on the subject. And come up with a 3 week teaching plan

================================== Ai Message ==================================

Tool Calls:

get_curriculum (xxx)

Call ID: xxx

Args:

year: 5.0

subject: Mathematics

================================= Tool Message =================================

Name: get_curriculum

Introduction to fractions, decimals, and percentages, along with foundational geometry and problem-solving techniques.

================================== Ai Message ==================================

Tool Calls:

search_latest_resource (xxx)

Call ID: xxxx

Args:

year: 5.0

subject: Mathematics

curriculum: {"content": "Introduction to fractions, decimals, and percentages, along with foundational geometry and problem-solving techniques."}

search_text: Geometry

================================= Tool Message =================================

Name: search_latest_resource

candidates=[Candidate(content=Content(parts=[Part(.......token_count=40, total_token_count=772) automatic_function_calling_history=[] parsed=None

================================== Ai Message ==================================

Based on the information provided, a 3-week teaching plan for Year 5 Mathematics focusing on Geometry could look like this:

**Week 1: Introducing 2D Shapes**

........

* Use visuals, manipulatives, and real-world examples to make the learning experience engaging and relevant.

Beenden Sie das Skript durch Druck auf Ctrl+C.

👉 (DIESEN SCHRITT NICHT ÜBERSPRINGEN!) Entfernen Sie den Testcode, um die Datei „aidemy.py“ sauber zu halten :

if __name__ == "__main__":

prep_class("I'm doing a course for year 5 on subject Mathematics in Geometry, search latest resources on the internet base on the subject. And come up with a 3 week teaching plan")

Nachdem wir die Agent-Logik definiert haben, starten wir die Flask-Webanwendung. So erhalten Lehrkräfte eine vertraute formularbasierte Oberfläche für die Interaktion mit dem Agenten. Chatbot-Interaktionen sind bei LLMs zwar üblich, wir haben uns jedoch für eine herkömmliche Benutzeroberfläche zur Formularübermittlung entschieden, da sie für viele Lehrkräfte möglicherweise intuitiver ist.

👉 Wenn Sie das Terminal geschlossen haben oder die Umgebungsvariablen nicht mehr festgelegt sind, führen Sie die folgenden Befehle noch einmal aus.

export BOOK_PROVIDER_URL=$(gcloud run services describe book-provider --region=us-central1 --project=$PROJECT_ID --format="value(status.url)")

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

export INSTANCE_NAME="aidemy"

export REGION="us-central1"

export DB_USER="postgres"

export DB_PASS="1234qwer"

export DB_NAME="aidemy-db"

👉 Starten Sie jetzt die Web-UI.

cd ~/aidemy-bootstrap/planner/

source env/bin/activate

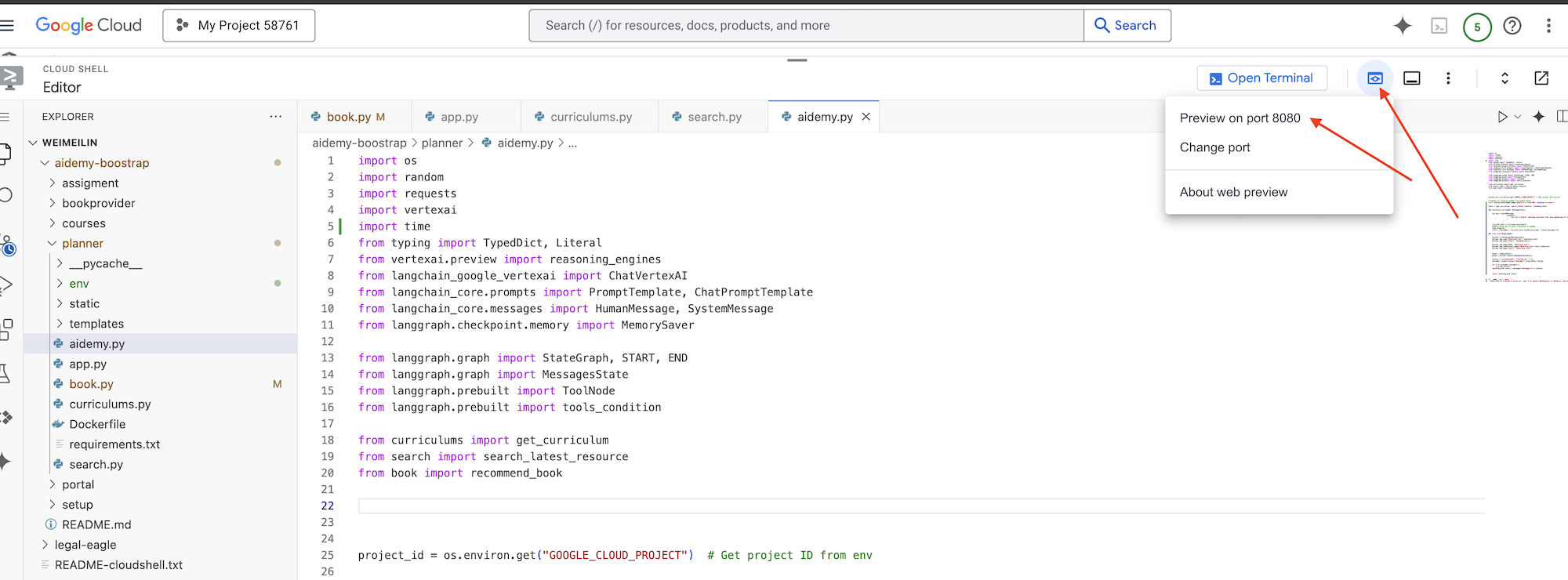

python app.py

Suchen Sie in der Cloud Shell-Terminalausgabe nach Startmeldungen. Flask gibt normalerweise Meldungen aus, die angeben, dass es ausgeführt wird und auf welchem Port.

Running on http://127.0.0.1:8080

Running on http://127.0.0.1:8080

The application needs to keep running to serve requests.

👉 Wählen Sie rechts oben im Menü „Webvorschau“ die Option Vorschau auf Port 8080 aus. In Cloud Shell wird ein neuer Browsertab oder ein neues Browserfenster mit der Webvorschau Ihrer Anwendung geöffnet.

Wählen Sie in der Anwendungsoberfläche 5 für „Year“ (Jahr) aus, wählen Sie das Thema Mathematics aus und geben Sie Geometry in die Add-on-Anfrage ein.

👉 Wenn Sie die Benutzeroberfläche Ihrer Anwendung verlassen haben, kehren Sie zurück. Die generierte Ausgabe sollte dann angezeigt werden.

👉 Beenden Sie das Skript im Terminal durch Drücken von Ctrl+C.

👉 Beenden Sie die virtuelle Umgebung in Ihrem Terminal:

deactivate

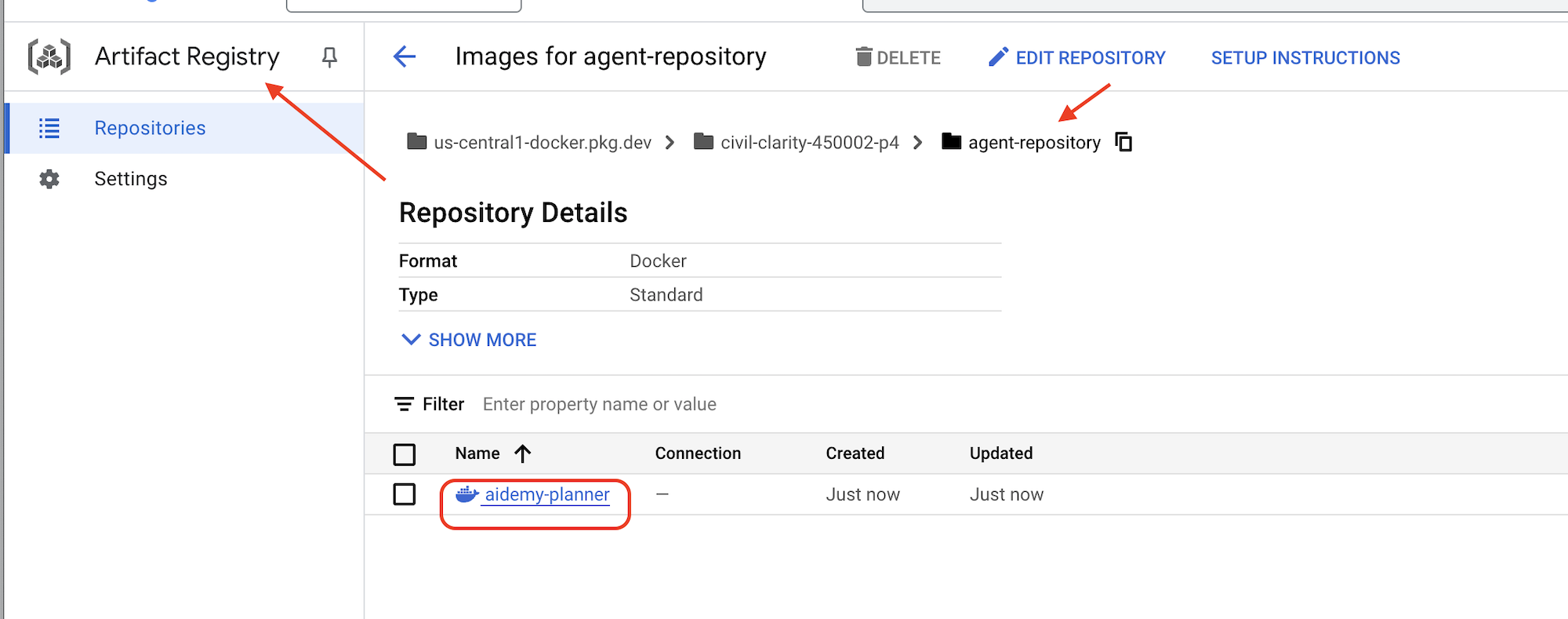

8. Planner-Agent in der Cloud bereitstellen

Image erstellen und per Push in die Registry übertragen

Zeit, das in der Cloud bereitzustellen.

👉 Erstellen Sie im Terminal ein Artifacts-Repository zum Speichern des Docker-Images, das wir erstellen werden.

gcloud artifacts repositories create agent-repository \

--repository-format=docker \

--location=us-central1 \

--description="My agent repository"

Sie sollten die Meldung „Created repository [agent-repository]“ (Repository [agent-repository] wurde erstellt) sehen.

👉 Führen Sie den folgenden Befehl aus, um das Docker-Image zu erstellen.

cd ~/aidemy-bootstrap/planner/

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

docker build -t gcr.io/${PROJECT_ID}/aidemy-planner .

👉 Wir müssen das Image neu taggen, damit es in Artifact Registry anstelle von GCR gehostet wird, und das getaggte Image in Artifact Registry übertragen:

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

docker tag gcr.io/${PROJECT_ID}/aidemy-planner us-central1-docker.pkg.dev/${PROJECT_ID}/agent-repository/aidemy-planner

docker push us-central1-docker.pkg.dev/${PROJECT_ID}/agent-repository/aidemy-planner

Nachdem das Push abgeschlossen ist, können Sie prüfen, ob das Image erfolgreich in Artifact Registry gespeichert wurde.

👉 Rufen Sie in der Google Cloud Console die Artifact Registry auf. Das aidemy-planner-Image sollte sich im Repository agent-repository befinden.

Datenbankanmeldedaten mit Secret Manager schützen

Wir verwenden Google Cloud Secret Manager, um Datenbankanmeldedaten sicher zu verwalten und darauf zuzugreifen. So wird verhindert, dass vertrauliche Informationen in unserem Anwendungscode hartcodiert werden, und die Sicherheit wird erhöht.

Wir erstellen separate Secrets für den Datenbanknutzernamen, das Passwort und den Datenbanknamen. So können wir jede Anmeldedaten unabhängig verwalten.

👉 Führen Sie im Terminal Folgendes aus:

gcloud secrets create db-user

printf "postgres" | gcloud secrets versions add db-user --data-file=-

gcloud secrets create db-pass

printf "1234qwer" | gcloud secrets versions add db-pass --data-file=-

gcloud secrets create db-name

printf "aidemy-db" | gcloud secrets versions add db-name --data-file=-

Die Verwendung von Secret Manager ist ein wichtiger Schritt, um Ihre Anwendung zu schützen und die versehentliche Offenlegung vertraulicher Anmeldedaten zu verhindern. Es werden Best Practices für die Sicherheit von Cloud-Bereitstellungen eingehalten.

In Cloud Run bereitstellen

Cloud Run ist eine vollständig verwaltete, serverlose Plattform, mit der Sie containerisierte Anwendungen schnell und einfach bereitstellen können. Die Infrastrukturverwaltung wird abstrahiert, sodass Sie sich auf das Schreiben und Bereitstellen von Code konzentrieren können. Wir stellen unseren Planer als Cloud Run-Dienst bereit.

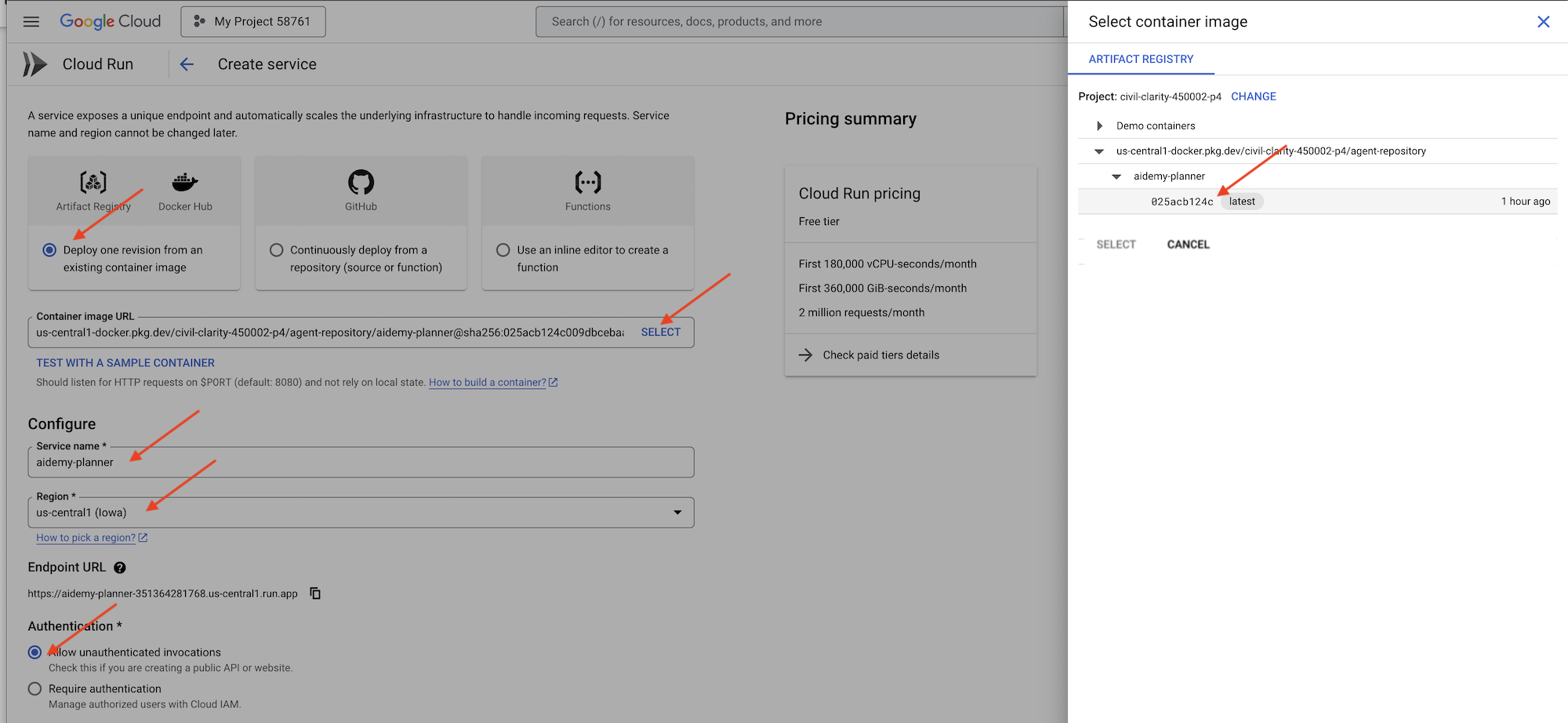

👉 Rufen Sie in der Google Cloud Console Cloud Run auf. Klicken Sie auf CONTAINER BEREITSTELLEN und wählen Sie SERVICE aus. Cloud Run-Dienst konfigurieren:

- Container-Image: Klicken Sie im URL-Feld auf „Auswählen“. Suchen Sie die Bild-URL, die Sie in Artifact Registry hochgeladen haben (z.B. us-central1-docker.pkg.dev/YOUR_PROJECT_ID/agent-repository/aidemy-planner/YOUR_IMG).

- Service name:

aidemy-planner - Region: Wählen Sie die Region

us-central1aus. - Authentifizierung: Für diesen Workshop können Sie „Nicht authentifizierte Aufrufe zulassen“ aktivieren. In der Produktion möchten Sie den Zugriff wahrscheinlich einschränken.

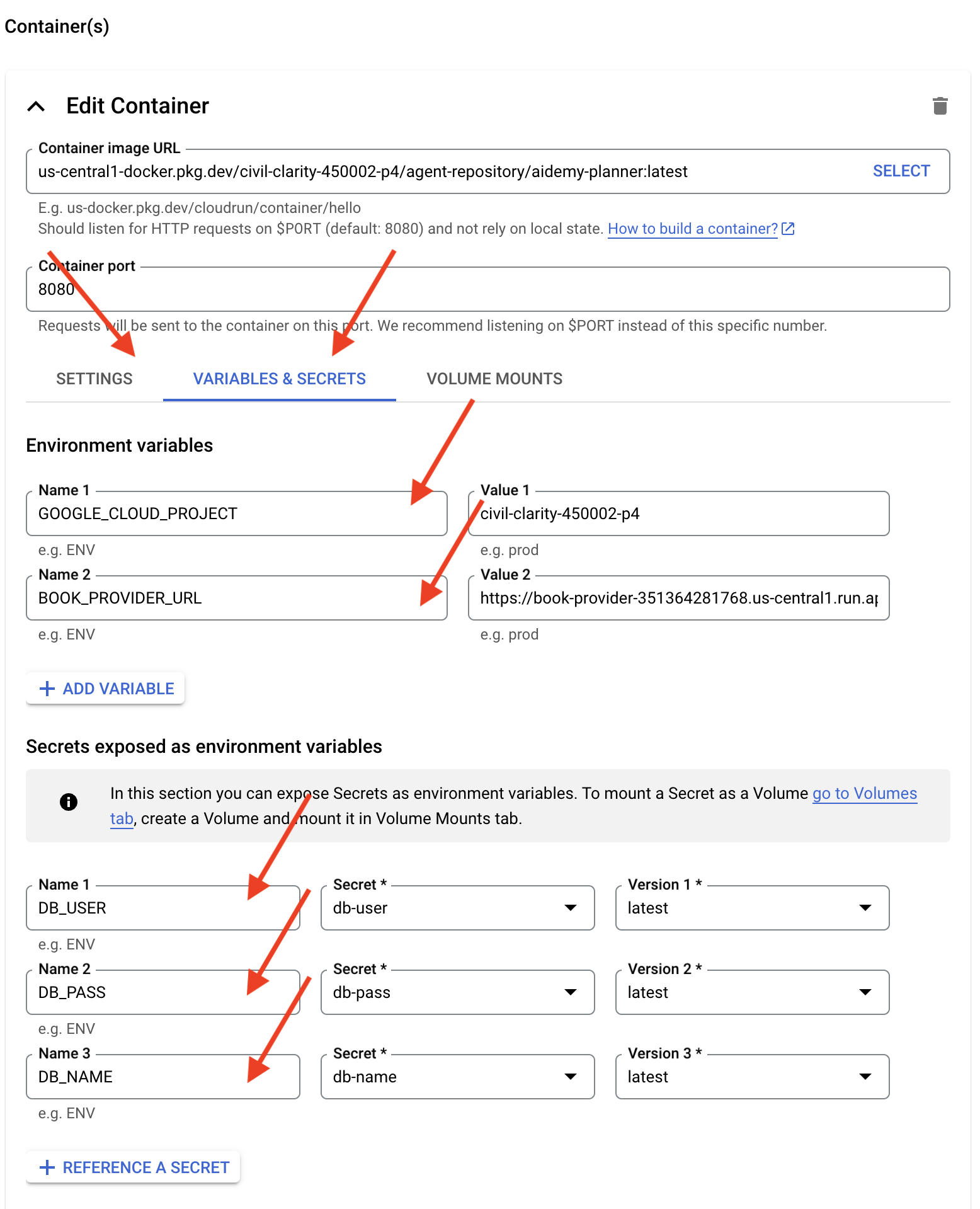

- Maximieren Sie den Bereich „Container, Volumes, Netzwerk, Sicherheit“ und legen Sie auf dem Tab Container Folgendes fest:

- Tab „Einstellungen“:

- Ressourcen

- Arbeitsspeicher : 2 GiB

- Ressourcen

- Tab „Variablen und Secrets“:

- Umgebungsvariablen: Fügen Sie die folgenden Variablen hinzu, indem Sie auf die Schaltfläche + Variable hinzufügen klicken:

- Fügen Sie den Namen

GOOGLE_CLOUD_PROJECTund den Wert <YOUR_PROJECT_ID> hinzu. - Fügen Sie den Namen

BOOK_PROVIDER_URLhinzu und legen Sie den Wert auf die URL Ihrer Buchanbieterfunktion fest. Diese können Sie mit dem folgenden Befehl im Terminal ermitteln:gcloud config set project $(cat ~/project_id.txt) gcloud run services describe book-provider \ --region=us-central1 \ --project=$PROJECT_ID \ --format="value(status.url)"

- Fügen Sie den Namen

- Fügen Sie im Abschnitt Secrets, die als Umgebungsvariablen bereitgestellt werden, die folgenden Secrets hinzu, indem Sie auf die Schaltfläche + Als Secret referenzieren klicken:

- Name hinzufügen:

DB_USER, Secret:db-userauswählen und Version:latest - Name hinzufügen:

DB_PASS, Secret:db-passauswählen und Version:latest - Name hinzufügen:

DB_NAME, Secret:db-nameauswählen und Version:latest

- Name hinzufügen:

- Umgebungsvariablen: Fügen Sie die folgenden Variablen hinzu, indem Sie auf die Schaltfläche + Variable hinzufügen klicken:

- Tab „Einstellungen“:

Übernehmen Sie für die anderen Werte die Standardeinstellung.

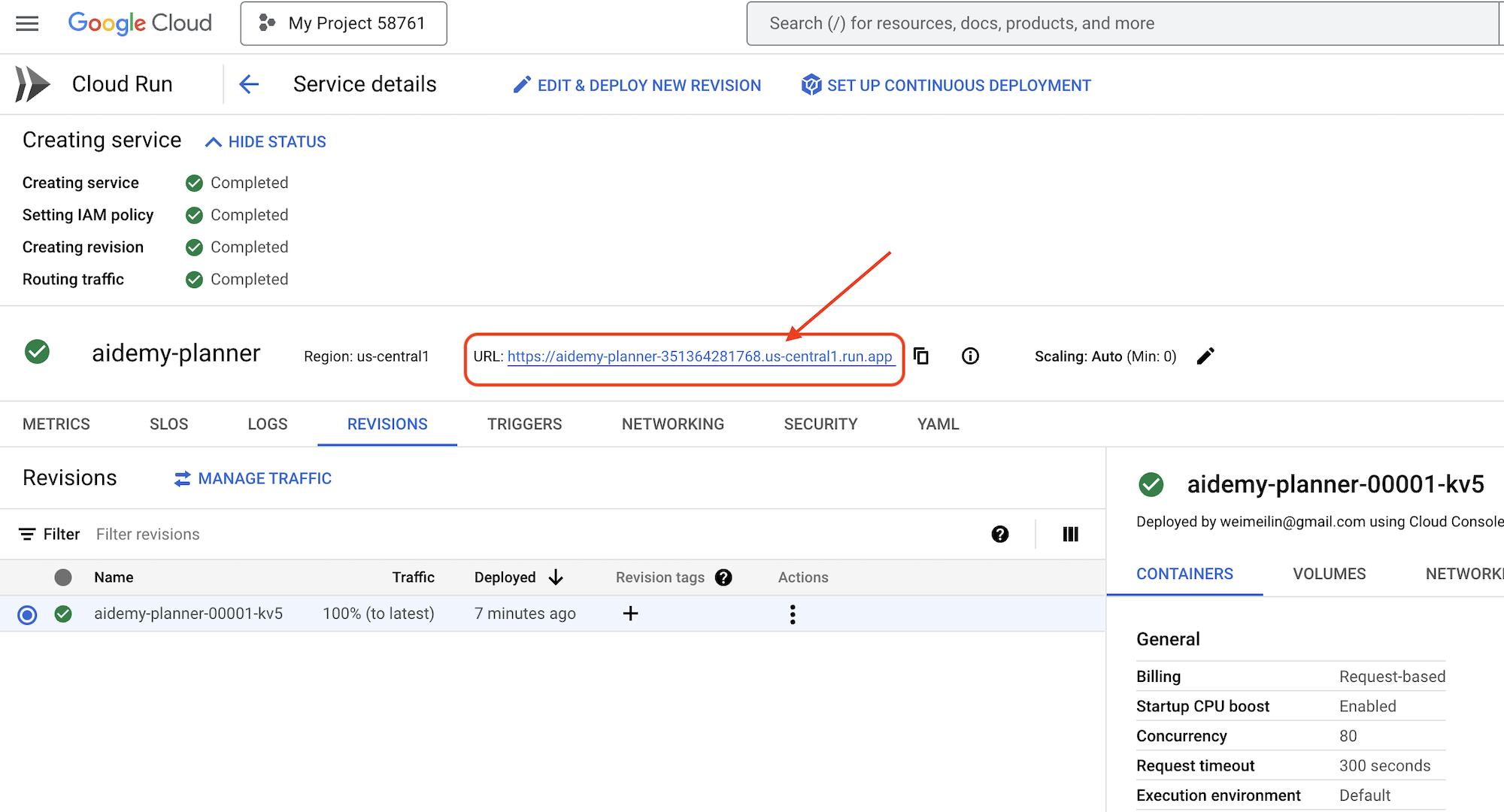

👉 Klicke auf ERSTELLEN.

Cloud Run stellt Ihren Dienst bereit.

Wenn der Dienst bereitgestellt wurde und Sie sich noch nicht auf der Detailseite befinden, klicken Sie auf den Dienstnamen, um die Detailseite aufzurufen. Die bereitgestellte URL finden Sie oben.

👉 Wählen Sie in der Anwendungsoberfläche 7 für das Jahr und Mathematics als Betreff aus und geben Sie Algebra in das Feld „Add-on-Anfrage“ ein.

👉 Klicken Sie auf Plan erstellen. So erhält der KI-Agent den erforderlichen Kontext, um einen maßgeschneiderten Lehrplan zu erstellen.

Glückwunsch! Sie haben mit unserem leistungsstarken KI-Agenten einen Lehrplan erstellt. Das zeigt das Potenzial von KI-Assistenten, die Arbeitsbelastung erheblich zu reduzieren und Aufgaben zu optimieren, was letztendlich die Effizienz steigert und das Leben von Lehrkräften erleichtert.

9. Multi-Agenten-Systeme

Nachdem wir das Tool zum Erstellen von Unterrichtsplänen erfolgreich implementiert haben, konzentrieren wir uns nun auf die Entwicklung des Schülerportals. Über dieses Portal erhalten Schüler und Studenten Zugriff auf Quizze, Audiozusammenfassungen und Aufgaben im Zusammenhang mit ihren Kursen. Angesichts des Umfangs dieser Funktion werden wir die Leistungsfähigkeit von Multi-Agent-Systemen nutzen, um eine modulare und skalierbare Lösung zu schaffen.

Wie bereits erwähnt, können wir die Arbeitslast in einem Multi-Agent-System in kleinere, spezialisierte Aufgaben aufteilen, die jeweils von einem dedizierten Agenten ausgeführt werden, anstatt uns auf einen einzelnen Agenten zu verlassen, der alles erledigt. Dieser Ansatz bietet mehrere wichtige Vorteile:

Modularität und Wartungsfreundlichkeit: Anstatt einen einzelnen Agenten zu erstellen, der alles erledigt, sollten Sie kleinere, spezialisierte Agenten mit klar definierten Verantwortlichkeiten entwickeln. Diese Modularität macht das System leichter verständlich, wartungsfreundlicher und einfacher zu debuggen. Wenn ein Problem auftritt, können Sie es auf einen bestimmten Agent eingrenzen, anstatt eine riesige Codebasis durchsuchen zu müssen.

Skalierbarkeit: Die Skalierung eines einzelnen, komplexen Agents kann einen Engpass darstellen. Mit einem Multi-Agent-System können Sie einzelne Agents entsprechend ihren spezifischen Anforderungen skalieren. Wenn beispielsweise ein Agent eine große Anzahl von Anfragen verarbeitet, können Sie problemlos weitere Instanzen dieses Agents hochfahren, ohne den Rest des Systems zu beeinträchtigen.

Teamspezialisierung: Stellen Sie sich vor, Sie würden einen einzelnen Entwickler bitten, eine komplette Anwendung von Grund auf zu entwickeln. Stattdessen stellen Sie ein Team von Spezialisten zusammen, die jeweils über Fachwissen in einem bestimmten Bereich verfügen. Mit einem Multi-Agent-System können Sie die Stärken verschiedener LLMs und Tools nutzen und sie Agenten zuweisen, die am besten für bestimmte Aufgaben geeignet sind.

Parallele Entwicklung: Verschiedene Teams können gleichzeitig an unterschiedlichen Agents arbeiten, was den Entwicklungsprozess beschleunigt. Da Agents unabhängig sind, wirken sich Änderungen an einem Agent weniger wahrscheinlich auf andere Agents aus.

Ereignisgesteuerte Architektur

Um eine effektive Kommunikation und Koordination zwischen diesen Agenten zu ermöglichen, verwenden wir eine ereignisgesteuerte Architektur. Das bedeutet, dass Agents auf „Ereignisse“ reagieren, die im System stattfinden.

Agents abonnieren bestimmte Ereignistypen (z.B. „Lehrplan erstellt“, „Aufgabe erstellt“). Wenn ein Ereignis eintritt, werden die entsprechenden Kundenservicemitarbeiter benachrichtigt und können entsprechend reagieren. Diese Entkopplung fördert Flexibilität, Skalierbarkeit und Reaktionsfähigkeit in Echtzeit.

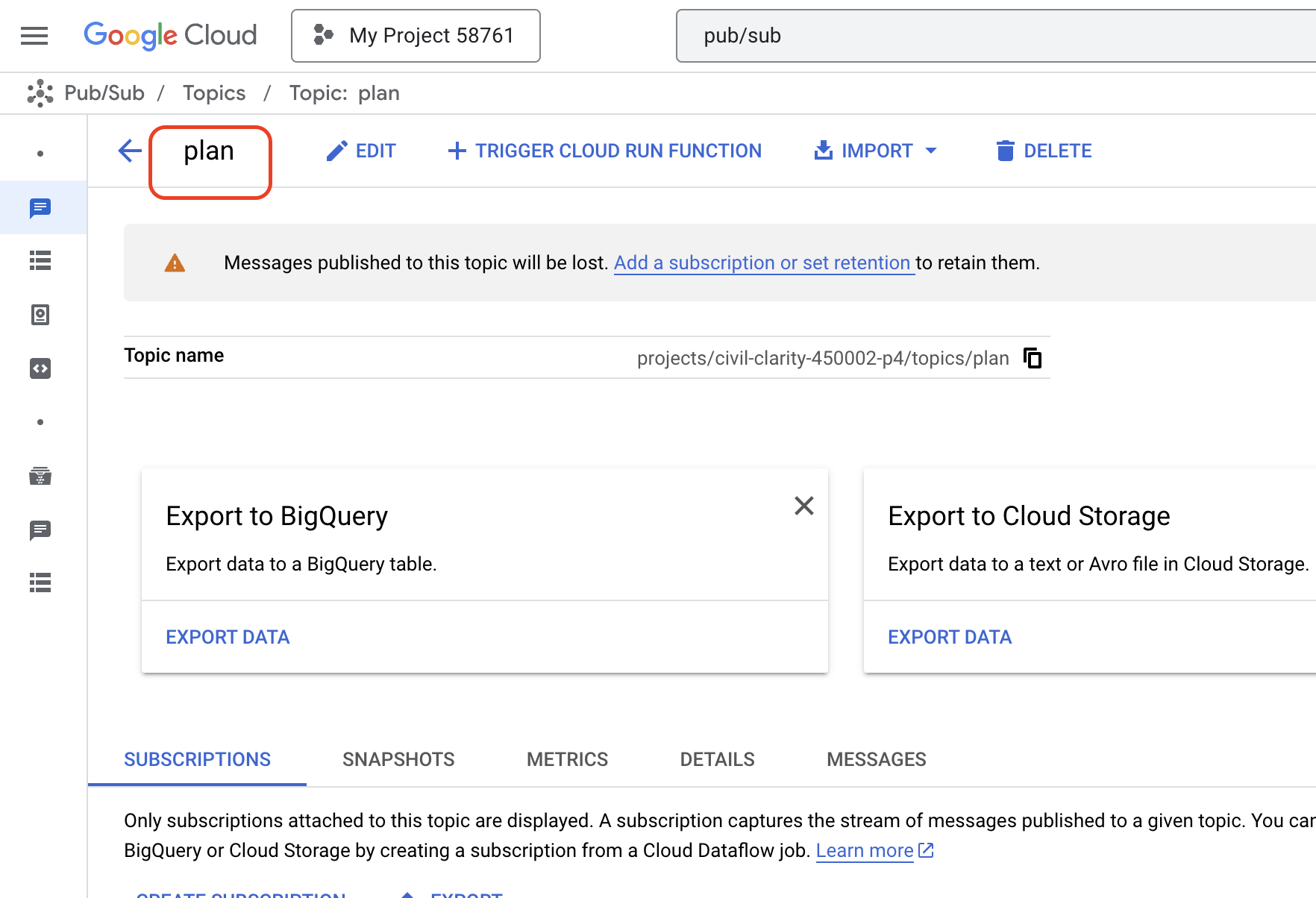

Zuerst brauchen wir eine Möglichkeit, diese Ereignisse zu übertragen. Dazu richten wir ein Pub/Sub-Thema ein. Erstellen wir zuerst ein Thema namens plan.

👉 Zur Google Cloud Console – Pub/Sub

👉 Klicken Sie auf den Button Thema erstellen.

👉 Konfigurieren Sie das Thema mit der ID/dem Namen plan und entfernen Sie das Häkchen bei Add a default subscription. Übernehmen Sie die Standardeinstellungen für die restlichen Felder und klicken Sie auf Erstellen.

Die Pub/Sub-Seite wird aktualisiert und das neu erstellte Thema sollte jetzt in der Tabelle aufgeführt sein.

Jetzt integrieren wir die Funktion zum Veröffentlichen von Pub/Sub-Ereignissen in unseren Planner-Agent. Wir fügen ein neues Tool hinzu, das ein „plan“-Ereignis an das gerade erstellte Pub/Sub-Thema sendet. Dieses Ereignis signalisiert anderen Agents im System (z. B. im Lernendenportal), dass ein neuer Lehrplan verfügbar ist.

👉 Kehren Sie zum Cloud Code-Editor zurück und öffnen Sie die Datei app.py im Ordner planner. Wir werden eine Funktion hinzufügen, mit der das Event veröffentlicht wird. Ersetzen:

##ADD SEND PLAN EVENT FUNCTION HERE

mit dem folgenden Code

def send_plan_event(teaching_plan:str):

"""

Send the teaching event to the topic called plan

Args:

teaching_plan: teaching plan

"""

publisher = pubsub_v1.PublisherClient()

print(f"-------------> Sending event to topic plan: {teaching_plan}")

topic_path = publisher.topic_path(PROJECT_ID, "plan")

message_data = {"teaching_plan": teaching_plan}

data = json.dumps(message_data).encode("utf-8")

future = publisher.publish(topic_path, data)

return f"Published message ID: {future.result()}"

- send_plan_event: Diese Funktion verwendet den generierten Lehrplan als Eingabe, erstellt einen Pub/Sub-Publisher-Client, erstellt den Themapfad, konvertiert den Lehrplan in einen JSON-String und veröffentlicht die Nachricht im Thema.

In derselben app.py-Datei

👉 Aktualisieren Sie den Prompt, damit der Agent das Ereignis für den Lehrplan nach der Generierung des Lehrplans an das Pub/Sub-Thema sendet. *Ersetzen

### ADD send_plan_event CALL

mit Folgendem:

send_plan_event(teaching_plan)

Durch Hinzufügen des Tools „send_plan_event“ und Ändern des Prompts haben wir unserem Planner-Agent ermöglicht, Ereignisse in Pub/Sub zu veröffentlichen, sodass andere Komponenten unseres Systems auf die Erstellung neuer Lehrpläne reagieren können. In den folgenden Abschnitten haben wir nun ein funktionales Multi-Agent-System.

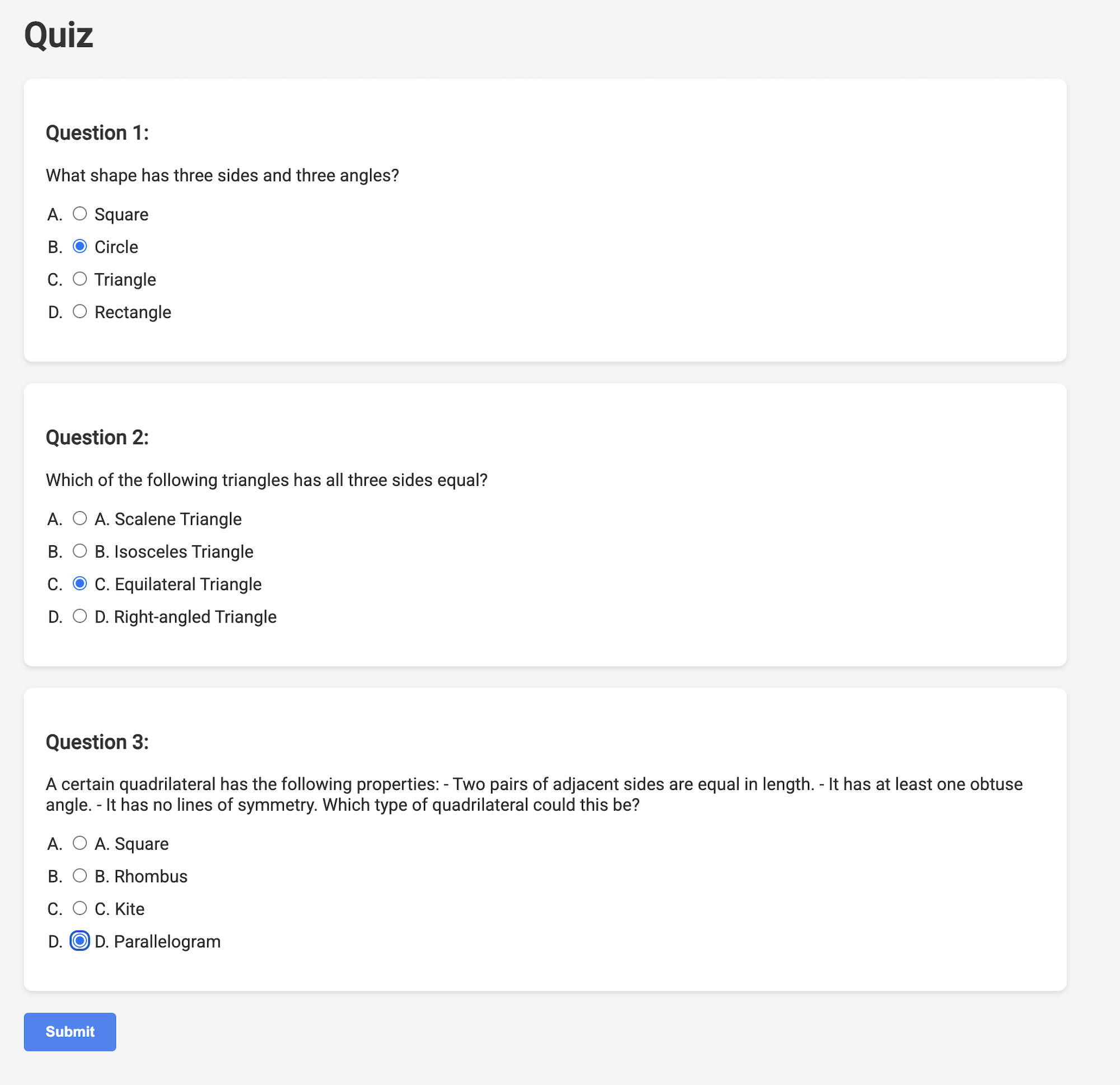

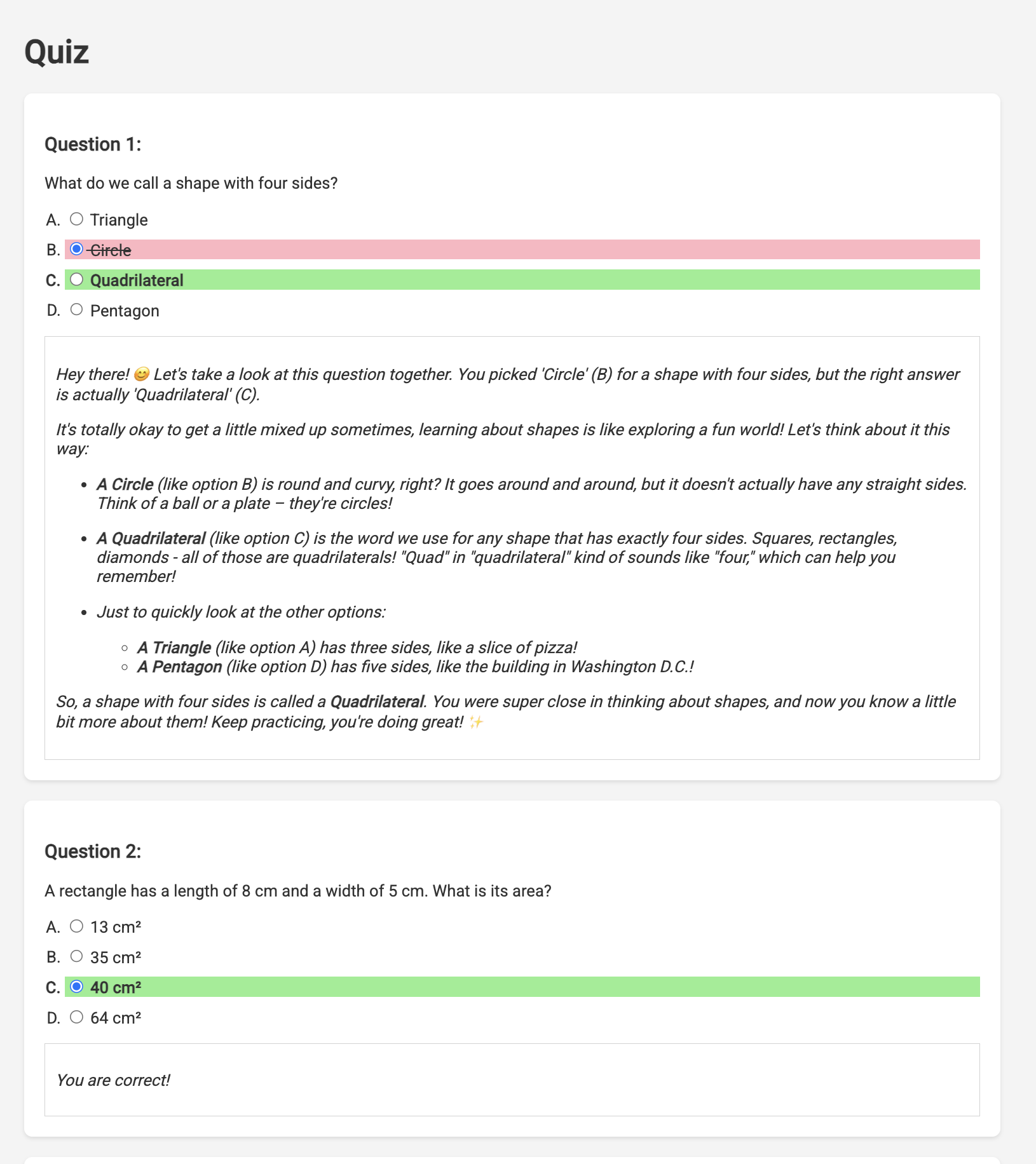

10. Lernende mit On-Demand-Quizzen motivieren

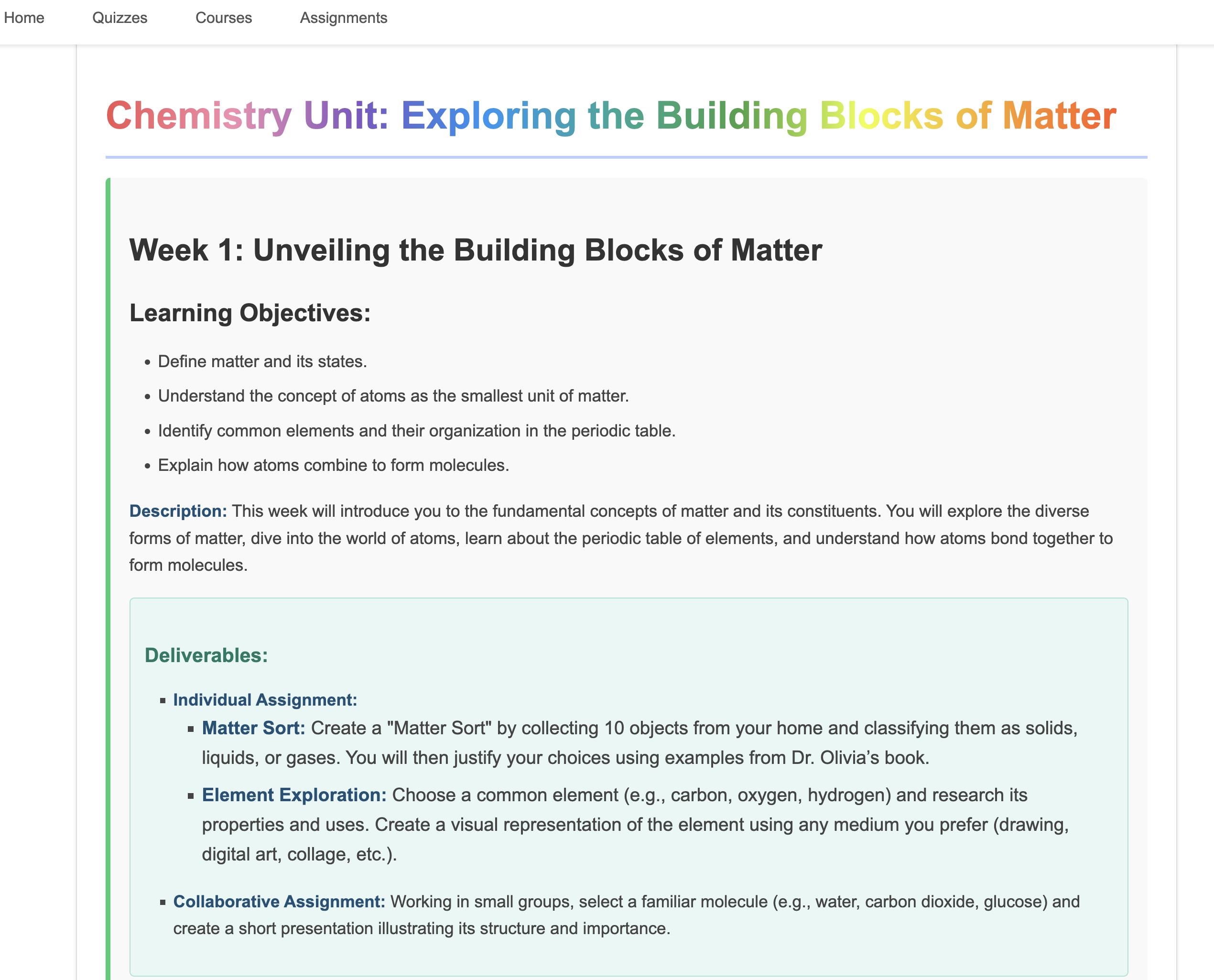

Stellen Sie sich eine Lernumgebung vor, in der Schüler und Studenten Zugriff auf eine unendliche Anzahl von Quizfragen haben, die auf ihre spezifischen Lernpläne zugeschnitten sind. Diese Quizfragen bieten sofortiges Feedback, einschließlich Antworten und Erklärungen, und fördern so ein tieferes Verständnis des Materials. Das ist das Potenzial, das wir mit unserem KI-basierten Quizportal erschließen möchten.

Um diese Vision zu verwirklichen, entwickeln wir eine Komponente zur Quizgenerierung, mit der Multiple-Choice-Fragen auf Grundlage des Inhalts des Lehrplans erstellt werden können.

👉 Rufen Sie im Explorer-Bereich des Cloud Code-Editors den Ordner portal auf. Öffnen Sie die Datei quiz.py und fügen Sie den folgenden Code am Ende der Datei ein.

def generate_quiz_question(file_name: str, difficulty: str, region:str ):

"""Generates a single multiple-choice quiz question using the LLM.

```json

{

"question": "The question itself",

"options": ["Option A", "Option B", "Option C", "Option D"],

"answer": "The correct answer letter (A, B, C, or D)"

}

```

"""

print(f"region: {region}")

# Connect to resourse needed from Google Cloud

llm = VertexAI(model_name="gemini-2.5-flash-preview-04-17", location=region)

plan=None

#load the file using file_name and read content into string call plan

with open(file_name, 'r') as f:

plan = f.read()

parser = JsonOutputParser(pydantic_object=QuizQuestion)

instruction = f"You'll provide one question with difficulty level of {difficulty}, 4 options as multiple choices and provide the anwsers, the quiz needs to be related to the teaching plan {plan}"

prompt = PromptTemplate(

template="Generates a single multiple-choice quiz question\n {format_instructions}\n {instruction}\n",

input_variables=["instruction"],

partial_variables={"format_instructions": parser.get_format_instructions()},

)

chain = prompt | llm | parser

response = chain.invoke({"instruction": instruction})

print(f"{response}")

return response

Im Agent wird ein JSON-Ausgabe-Parser erstellt, der speziell darauf ausgelegt ist, die Ausgabe des LLM zu verstehen und zu strukturieren. Dabei wird das zuvor definierte Modell QuizQuestion verwendet, um sicherzustellen, dass die geparste Ausgabe dem richtigen Format entspricht (Frage, Optionen und Antwort).

👉 Führen Sie im Terminal die folgenden Befehle aus, um eine virtuelle Umgebung einzurichten, Abhängigkeiten zu installieren und den Agent zu starten:

gcloud config set project $(cat ~/project_id.txt)

cd ~/aidemy-bootstrap/portal/

python -m venv env

source env/bin/activate

pip install -r requirements.txt

python app.py

👉 Wählen Sie rechts oben im Menü „Webvorschau“ die Option Vorschau auf Port 8080 aus. In Cloud Shell wird ein neuer Browsertab oder ein neues Browserfenster mit der Webvorschau Ihrer Anwendung geöffnet.

👉 Klicken Sie in der Webanwendung entweder in der oberen Navigationsleiste oder auf der Karte auf der Indexseite auf den Link Quizze. Dem Schüler sollten drei zufällig generierte Quizze angezeigt werden. Diese Quizze basieren auf dem Lehrplan und zeigen die Leistungsfähigkeit unseres KI-basierten Quizgenerierungssystems.

👉 Drücken Sie im Terminal Ctrl+C, um den lokal ausgeführten Prozess zu beenden.

Gemini 2 Thinking for Explanations

Okay, wir haben also Quizze. Das ist schon mal ein guter Anfang. Was passiert, wenn Schüler oder Studenten etwas falsch machen? Das ist doch der Ort, an dem wirklich gelernt wird, oder? Wenn wir erklären können, warum ihre Antwort falsch war und wie sie zur richtigen Antwort gelangen, ist es viel wahrscheinlicher, dass sie sich daran erinnern. Außerdem können Sie so Unklarheiten beseitigen und das Vertrauen der Kunden stärken.

Deshalb werden wir das „Thinking“-Modell von Gemini 2 einsetzen. So geben Sie der KI etwas mehr Zeit, um über die Antwort nachzudenken, bevor sie sie erklärt. So kann es detaillierteres und besseres Feedback geben.

Wir möchten herausfinden, ob es Schülern helfen kann, indem es sie unterstützt, Fragen beantwortet und Dinge detailliert erklärt. Um das zu testen, beginnen wir mit einem notorisch schwierigen Thema: der Analysis.

👉 Rufen Sie zuerst den Cloud Code-Editor in answer.py im Ordner portal auf. Funktionscode ersetzen

def answer_thinking(question, options, user_response, answer, region):

return ""

mit dem folgenden Code-Snippet:

def answer_thinking(question, options, user_response, answer, region):

try:

llm = VertexAI(model_name="gemini-2.0-flash-001",location=region)

input_msg = HumanMessage(content=[f"Here the question{question}, here are the available options {options}, this student's answer {user_response}, whereas the correct answer is {answer}"])

prompt_template = ChatPromptTemplate.from_messages(

[

SystemMessage(

content=(

"You are a helpful teacher trying to teach the student on question, you were given the question and a set of multiple choices "

"what's the correct answer. use friendly tone"

)

),

input_msg,

]

)

prompt = prompt_template.format()

response = llm.invoke(prompt)

print(f"response: {response}")

return response

except Exception as e:

print(f"Error sending message to chatbot: {e}") # Log this error too!

return f"Unable to process your request at this time. Due to the following reason: {str(e)}"

if __name__ == "__main__":

question = "Evaluate the limit: lim (x→0) [(sin(5x) - 5x) / x^3]"

options = ["A) -125/6", "B) -5/3 ", "C) -25/3", "D) -5/6"]

user_response = "B"

answer = "A"

region = "us-central1"

result = answer_thinking(question, options, user_response, answer, region)

Dies ist eine sehr einfache Langchain-App, in der das Gemini 2 Flash-Modell initialisiert wird. Wir weisen es an, als hilfreicher Lehrer zu fungieren und Erklärungen zu liefern.

👉 Führen Sie im Terminal den folgenden Befehl aus:

gcloud config set project $(cat ~/project_id.txt)

cd ~/aidemy-bootstrap/portal/

source env/bin/activate

python answer.py

Die Ausgabe sollte in etwa wie im Beispiel in der ursprünglichen Anleitung aussehen. Das aktuelle Modell liefert möglicherweise keine so ausführliche Erklärung.

Okay, I see the question and the choices. The question is to evaluate the limit:

lim (x→0) [(sin(5x) - 5x) / x^3]

You chose option B, which is -5/3, but the correct answer is A, which is -125/6.

It looks like you might have missed a step or made a small error in your calculations. This type of limit often involves using L'Hôpital's Rule or Taylor series expansion. Since we have the form 0/0, L'Hôpital's Rule is a good way to go! You need to apply it multiple times. Alternatively, you can use the Taylor series expansion of sin(x) which is:

sin(x) = x - x^3/3! + x^5/5! - ...

So, sin(5x) = 5x - (5x)^3/3! + (5x)^5/5! - ...

Then, (sin(5x) - 5x) = - (5x)^3/3! + (5x)^5/5! - ...

Finally, (sin(5x) - 5x) / x^3 = - 5^3/3! + (5^5 * x^2)/5! - ...

Taking the limit as x approaches 0, we get -125/6.

Keep practicing, you'll get there!

👉 Ersetzen Sie in der Datei answer.py

model_name von gemini-2.0-flash-001 zu gemini-2.0-flash-thinking-exp-01-21 in der Funktion answer_thinking geändert.

Dadurch wird das LLM in ein anderes geändert, das besser für das Reasoning geeignet ist. So kann das Modell bessere Erklärungen generieren.

👉 Führen Sie das answer.py-Skript noch einmal aus, um das neue Thinking-Modell zu testen:

gcloud config set project $(cat ~/project_id.txt)

cd ~/aidemy-bootstrap/portal/

source env/bin/activate

python answer.py

Hier ist ein Beispiel für die Antwort des Denkmodells, die viel gründlicher und detaillierter ist und eine Schritt-für-Schritt-Anleitung zur Lösung des Analysisproblems enthält. Dies unterstreicht die Leistungsfähigkeit von „Denkmodellen“ bei der Generierung hochwertiger Erklärungen. Die Ausgabe sollte in etwa so aussehen:

Hey there! Let's take a look at this limit problem together. You were asked to evaluate:

lim (x→0) [(sin(5x) - 5x) / x^3]

and you picked option B, -5/3, but the correct answer is actually A, -125/6. Let's figure out why!

It's a tricky one because if we directly substitute x=0, we get (sin(0) - 0) / 0^3 = (0 - 0) / 0 = 0/0, which is an indeterminate form. This tells us we need to use a more advanced technique like L'Hopital's Rule or Taylor series expansion.

Let's use the Taylor series expansion for sin(y) around y=0. Do you remember it? It looks like this:

sin(y) = y - y^3/3! + y^5/5! - ...

where 3! (3 factorial) is 3 × 2 × 1 = 6, 5! is 5 × 4 × 3 × 2 × 1 = 120, and so on.

In our problem, we have sin(5x), so we can substitute y = 5x into the Taylor series:

sin(5x) = (5x) - (5x)^3/3! + (5x)^5/5! - ...

sin(5x) = 5x - (125x^3)/6 + (3125x^5)/120 - ...

Now let's plug this back into our limit expression:

[(sin(5x) - 5x) / x^3] = [ (5x - (125x^3)/6 + (3125x^5)/120 - ...) - 5x ] / x^3

Notice that the '5x' and '-5x' cancel out! So we are left with:

= [ - (125x^3)/6 + (3125x^5)/120 - ... ] / x^3

Now, we can divide every term in the numerator by x^3:

= -125/6 + (3125x^2)/120 - ...

Finally, let's take the limit as x approaches 0. As x gets closer and closer to zero, terms with x^2 and higher powers will become very, very small and approach zero. So, we are left with:

lim (x→0) [ -125/6 + (3125x^2)/120 - ... ] = -125/6

Therefore, the correct answer is indeed **A) -125/6**.

It seems like your answer B, -5/3, might have come from perhaps missing a factor somewhere during calculation or maybe using an incorrect simplification. Double-check your steps when you were trying to solve it!

Don't worry, these limit problems can be a bit tricky sometimes! Keep practicing and you'll get the hang of it. Let me know if you want to go through another similar example or if you have any more questions! 😊

Now that we have confirmed it works, let's use the portal.

👉ENTFERNEN Sie den folgenden Testcode aus answer.py:

if __name__ == "__main__":

question = "Evaluate the limit: lim (x→0) [(sin(5x) - 5x) / x^3]"

options = ["A) -125/6", "B) -5/3 ", "C) -25/3", "D) -5/6"]

user_response = "B"

answer = "A"

region = "us-central1"

result = answer_thinking(question, options, user_response, answer, region)

👉 Führen Sie die folgenden Befehle im Terminal aus, um eine virtuelle Umgebung einzurichten, Abhängigkeiten zu installieren und den Agent zu starten:

gcloud config set project $(cat ~/project_id.txt)

cd ~/aidemy-bootstrap/portal/

source env/bin/activate

python app.py

👉 Wählen Sie rechts oben im Menü „Webvorschau“ die Option Vorschau auf Port 8080 aus. In Cloud Shell wird ein neuer Browsertab oder ein neues Browserfenster mit der Webvorschau Ihrer Anwendung geöffnet.

👉 Klicken Sie in der Webanwendung entweder in der oberen Navigationsleiste oder auf der Karte auf der Indexseite auf den Link Quizze.

👉 Beantworte alle Quizfragen und sorge dafür, dass mindestens eine Antwort falsch ist. Klicke dann auf Senden.

Anstatt nur auf die Antwort zu warten, können Sie zum Terminal des Cloud-Editors wechseln. Sie können den Fortschritt und alle Ausgaben oder Fehlermeldungen, die von Ihrer Funktion generiert werden, im Terminal des Emulators beobachten. 😁

👉 Beenden Sie den lokal ausgeführten Prozess in Ihrem Terminal, indem Sie Ctrl+C drücken.

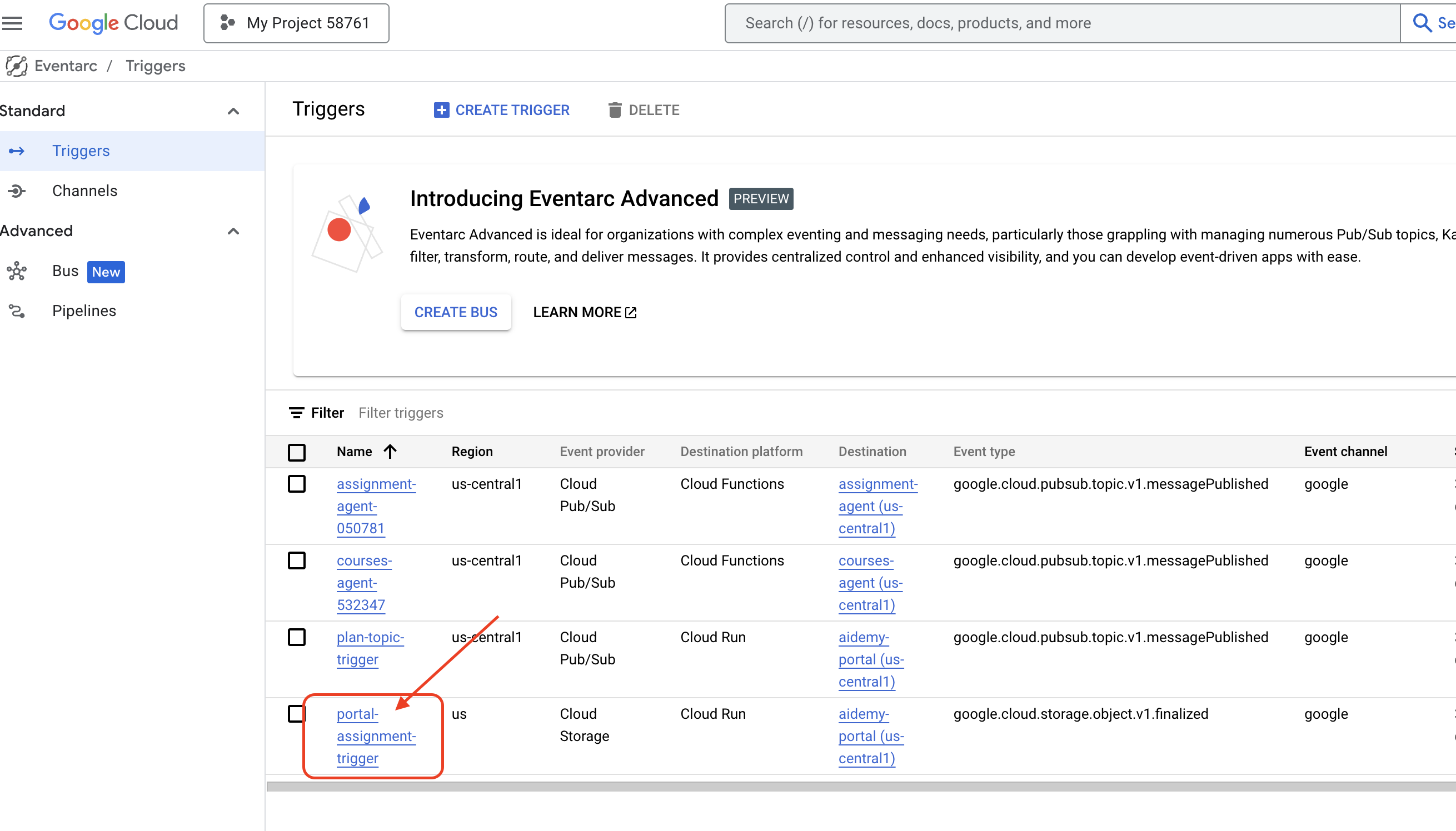

11. OPTIONAL: Agents mit Eventarc orchestrieren

Bisher wurden im Schülerportal Quizze auf Grundlage einer Standardgruppe von Lehrplänen erstellt. Das ist zwar hilfreich, aber es bedeutet, dass unser Planungs- und unser Quiz-Agent im Portal nicht wirklich miteinander kommunizieren. Erinnern Sie sich, wie wir die Funktion hinzugefügt haben, mit der der Planner-Agent seine neu generierten Unterrichtspläne in einem Pub/Sub-Thema veröffentlicht? Jetzt ist es an der Zeit, die Verbindung zu unserem Portal-Agent herzustellen.

Wir möchten, dass die Quizinhalte des Portals automatisch aktualisiert werden, wenn ein neuer Lehrplan generiert wird. Dazu erstellen wir im Portal einen Endpunkt, der diese neuen Pläne empfangen kann.

👉 Gehen Sie im Explorer-Bereich des Cloud Code-Editors zum Ordner portal.

👉 Öffnen Sie die Datei app.py zur Bearbeitung. ERSETZEN Sie die Zeile ## REPLACE ME! NEW TEACHING PLAN durch den folgenden Code:

@app.route('/new_teaching_plan', methods=['POST'])

def new_teaching_plan():

try:

# Get data from Pub/Sub message delivered via Eventarc

envelope = request.get_json()

if not envelope:

return jsonify({'error': 'No Pub/Sub message received'}), 400

if not isinstance(envelope, dict) or 'message' not in envelope:

return jsonify({'error': 'Invalid Pub/Sub message format'}), 400

pubsub_message = envelope['message']

print(f"data: {pubsub_message['data']}")

data = pubsub_message['data']

data_str = base64.b64decode(data).decode('utf-8')

data = json.loads(data_str)

teaching_plan = data['teaching_plan']

print(f"File content: {teaching_plan}")

with open("teaching_plan.txt", "w") as f:

f.write(teaching_plan)

print(f"Teaching plan saved to local file: teaching_plan.txt")

return jsonify({'message': 'File processed successfully'})

except Exception as e:

print(f"Error processing file: {e}")

return jsonify({'error': 'Error processing file'}), 500

Neu erstellen und in Cloud Run bereitstellen

Sie müssen sowohl den Planner- als auch den Portal-Agent aktualisieren und in Cloud Run neu bereitstellen. So wird dafür gesorgt, dass sie den neuesten Code haben und für die Kommunikation über Ereignisse konfiguriert sind.

👉 Zuerst erstellen wir das Agent-Image planner neu und übertragen es per Push. Führen Sie dazu im Terminal Folgendes aus:

cd ~/aidemy-bootstrap/planner/

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

docker build -t gcr.io/${PROJECT_ID}/aidemy-planner .

export PROJECT_ID=$(gcloud config get project)

docker tag gcr.io/${PROJECT_ID}/aidemy-planner us-central1-docker.pkg.dev/${PROJECT_ID}/agent-repository/aidemy-planner

docker push us-central1-docker.pkg.dev/${PROJECT_ID}/agent-repository/aidemy-planner

👉 Wir erstellen und übertragen das Agent-Image portal auf dieselbe Weise:

cd ~/aidemy-bootstrap/portal/

gcloud config set project $(cat ~/project_id.txt)

export PROJECT_ID=$(gcloud config get project)

docker build -t gcr.io/${PROJECT_ID}/aidemy-portal .

export PROJECT_ID=$(gcloud config get project)

docker tag gcr.io/${PROJECT_ID}/aidemy-portal us-central1-docker.pkg.dev/${PROJECT_ID}/agent-repository/aidemy-portal